关键字: [Amazon Web Services re:Invent 2023, Redis, Large Language Models, Retrieval Augmented Generation, Semantic Caching, Redis, Bedrock]

本文字数: 900, 阅读完需: 4 分钟

视频

如视频不能正常播放,请前往bilibili观看本视频。>> https://www.bilibili.com/video/BV1s64y157XV

导读

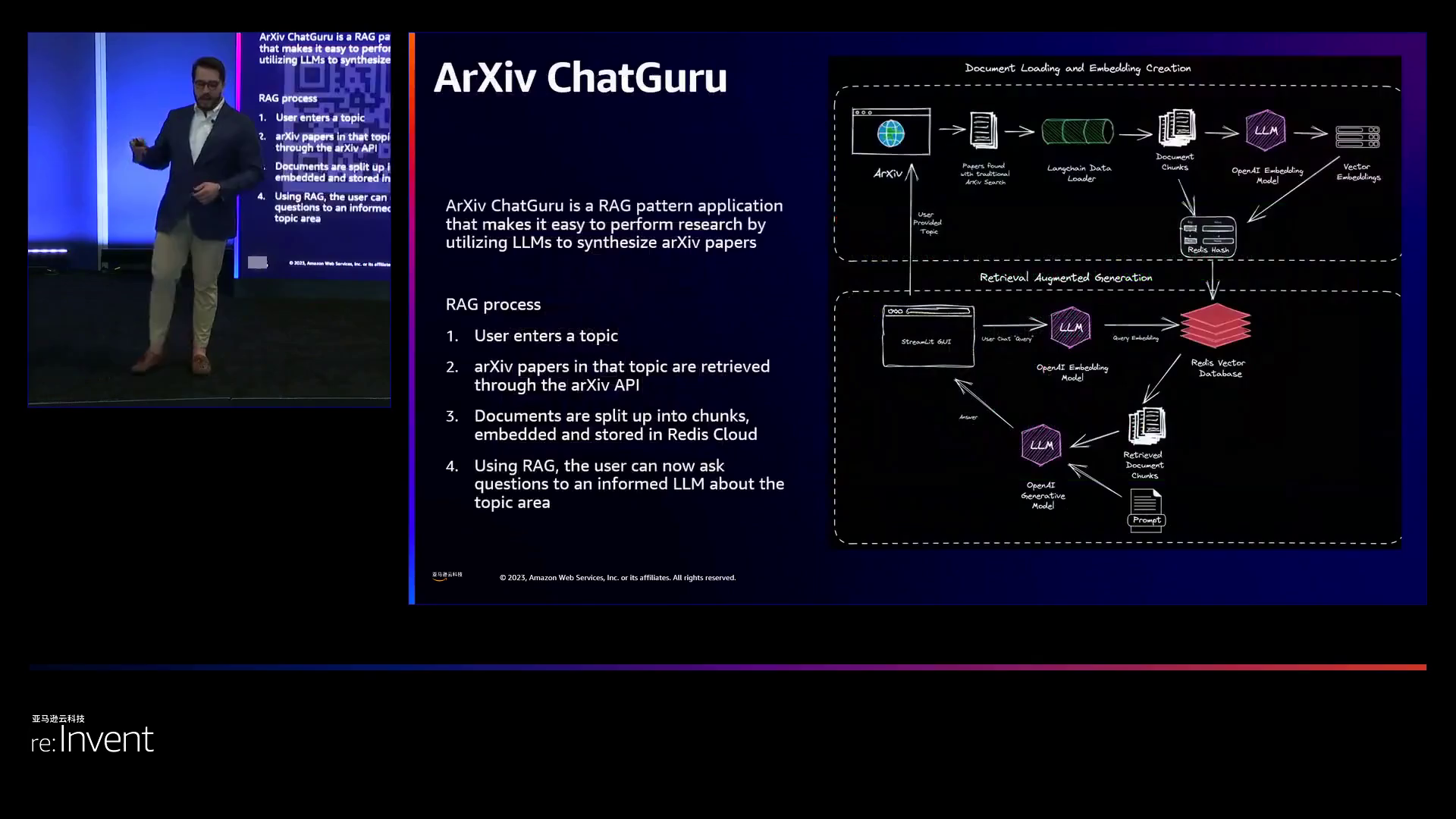

大型语言模型(LLM),比如 GPT-4,利用向量嵌入和数据库的力量来解决数据不断变化带来的挑战。这些嵌入向量,当与向量数据库或搜索算法结合使用时,为 LLM 提供了一种访问最新且不断扩展的知识库的方式。这确保了 LLM 即使面对不断变化的信息,也能够生成准确且情境适当的输出。这种方法有时被称为检索增强生成(RAG)。在这个闪电演讲中,了解 RAG 以及将 Redis Enterprise 作为向量数据库与 Amazon Bedrock 一起使用的好处。本次演示由 Redis 提供,Redis 是 亚马逊云科技 的合作伙伴。

演讲精华

以下是小编为您整理的本次演讲的精华,共600字,阅读时间大约是3分钟。如果您想进一步了解演讲内容或者观看演讲全文,请观看演讲完整视频或者下面的演讲原文。

在演讲开始时,演讲者评估了观众对大型语言模型(LLM)和检索增强生成技术了解的程度,发现大约有一半人有一定的相关经验。他承诺将介绍基本概念和更先进的技术,从为各种客户构建超过100个检索增强生成(RAG)系统所面临的挑战概述开始。

谈到这些挑战,首先他指出的是基础设施和托管成本问题。在自己的硬件上部署模型并不容易获得专用的GPU,如Nvidia A100。即使使用云服务,虽然价格具有竞争力,但费用仍然会迅速累积。例如,当应用程序需要高吞吐量时,如遇到突然的病毒式增长,亚马逊云科技 Lambda的费用会增加得很快。全面优化成本结构需要进行大量的实验和分析。

通过一个实际案例来说明,他描述了一个企业客户需要频繁更新PDF和PowerPoint知识库,以支持内部的问答系统。每天重新训练LLM处理不断变化的文件将是极其昂贵的。

第二个主要障碍在于模型质量问题,尤其是可能导致系统信任度下降的幻觉现象。许多组织最初选择在内部部署RAG,而不是在彻底测试之前直接将不完美输出展示给顾客。例如,一个金融领域的客户计划使用RAG来回答投资者的问题,但在确保质量之前,他们会犹豫是否提供外部访问。演讲者表示,在这些内部应用之外,性能可以显著提高。

第三个问题是,当一个单一模型同时服务于外部和内部使用场景时,会出现安全问题。调整复制使模型能够分段权限,但可能会对外部泄露敏感的内部信息。演讲者提供了一个制造公司需要工厂车间实时传感器数据,同时也提供公开的产品摘要,这就需要分割的例子。

在面对这些挑战时,演讲者主张重新审视数据策略,而非仅仅依赖一个大语言模型来解决所有问题。他建议采用如Redis之类的向量数据库来存储结构化数据,这样可以让语言模型快速获得提示,而无需尝试在所有必要信息上进行训练。

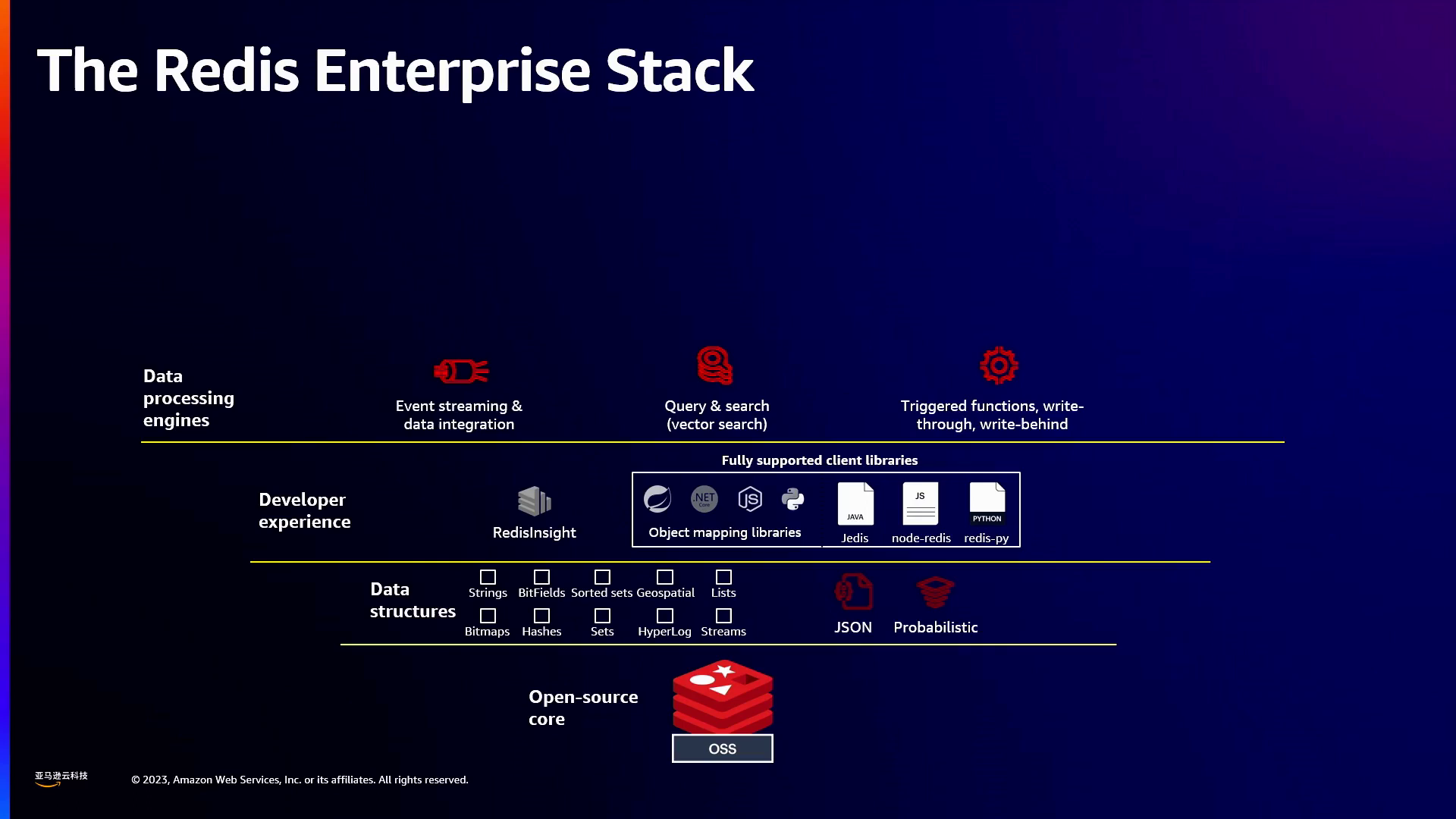

在提供背景信息时,他指出Redis具有诸如JSON文档存储、向量相似性搜索、完整的数据库操作(CRUD)功能、毫秒级事务处理、冗余以及其他有益特性。与人们通常的误解不同,最近引入的向量搜索功能仅适用于企业版,而非开源版本。

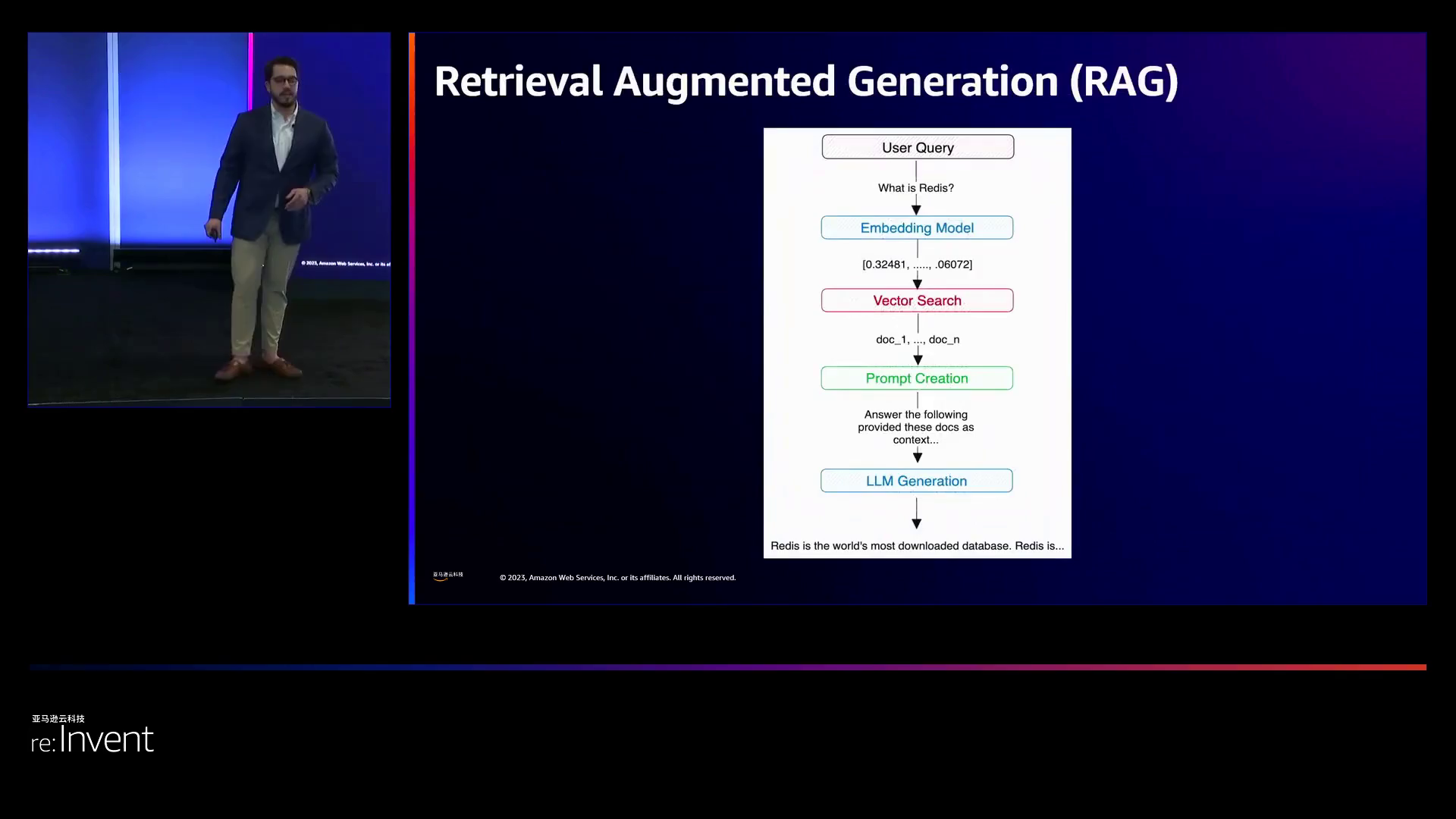

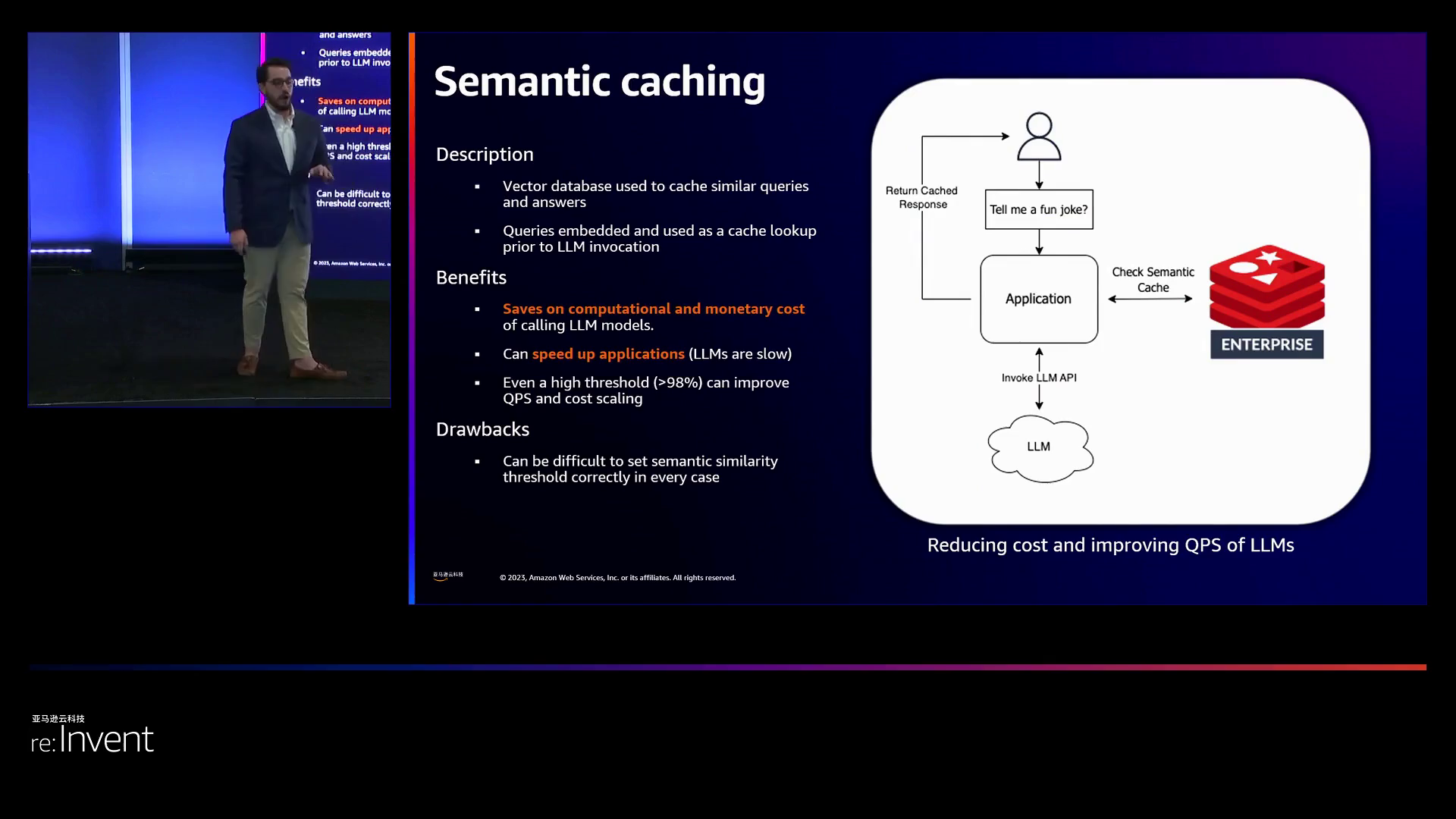

他列出了三种主要应用场景,展示出向量搜索如何提高语言模型的性能。首先,检索增强生成可以使用用户问题的嵌入来查询数据库,从而识别相关信息,为语言模型提供提示,避免每小时进行昂贵的反复微调。其次,对话记忆可以在聊天界面中缓存之前的消息和响应,为对话提供上下文。例如,客户服务聊天机器人可以为每个用户检索早期消息,以提供连贯性。最后,语义缓存会存储先前的语言模型输出,当超过相似度阈值时重新显示这些输出,而无需重新调用模型,从而大大降低成本。例如,使用AI进行销售预测的客户可以缓存相似的先前查询,避免重复调用语言模型。

总的来说,演讲者强调了语言模型常见的挑战,倡导使用向量搜索解决方案以更快速、经济地构建实时检索增强生成平台。他通过实例和对Redis功能的概述,传达了解决各种客户应用的高性能且负担得起的检索增强生成架构的理念和技巧。

下面是一些演讲现场的精彩瞬间:

领导者探讨了亚马逊云科技所研发的创新功能,包括检索和增强型生成等技术。

在演讲中,演讲者详细解释了Redis企业版所采用的新型向量搜索功能,这种功能能够实现对JSON数据的快速查询。

据演讲者介绍,增强型生成的核心在于利用向量搜索查找相关信息,并将这些信息与大型语言模型相结合以生成回应。

此外,领导者还阐述了如何使用Symantec缓存技术存储语义相似的输入,从而避免冗余和不必要的昂贵计算,例如通过缓存加速网站加载速度。

这一技术有助于节省用户因重复处理相似输入而产生的费用。

演讲者还介绍了名为red vl的全新库,它将Redis作为向量数据库使用,以实现语义缓存并降低AI成本。

总结

本演讲探讨了如何通过运用Redis和Amazon Bedrock技术,实现在大型语言模型(LLM)方面的实时检索,从而提高其效果。演讲者详细阐述了LLM目前所面临的挑战,包括高昂的成本和缓慢的微调过程。为了解决这些问题,他们提出了一种利用类似于Redis等向量数据库的技术,以便快速更新和检索与LLM相关的信息,从而提高速度并降低成本。此外,Redis中的语义缓存功能还可以缓存相似的查询,从而进一步优化成本和性能。演讲者还展示了一个基于Redis和LangChain构建的研究助手实例,该助手能够对Arxiv上的科学论文进行摘要处理。最后,演讲者介绍了一种简单的将Redis和构建RAG应用程序部署到亚马逊云科技平台的方法。核心观点是,诸如Redis和Bedrock等技术可以通过加速外部知识的更新和检索能力,从而显著提升LLM的效率和价值。

演讲原文

https://blog.csdn.net/just2gooo/article/details/134874385

想了解更多精彩完整内容吗?立即访问re:Invent 官网中文网站!

2023亚马逊云科技re:Invent全球大会 - 官方网站

点击此处,一键获取亚马逊云科技全球最新产品/服务资讯!

点击此处,一键获取亚马逊云科技中国区最新产品/服务资讯!

即刻注册亚马逊云科技账户,开启云端之旅!

【免费】亚马逊云科技中国区“40 余种核心云服务产品免费试用”

亚马逊云科技是谁?

亚马逊云科技(Amazon Web Services)是全球云计算的开创者和引领者,自 2006 年以来一直以不断创新、技术领先、服务丰富、应用广泛而享誉业界。亚马逊云科技可以支持几乎云上任意工作负载。亚马逊云科技目前提供超过 200 项全功能的服务,涵盖计算、存储、网络、数据库、数据分析、机器人、机器学习与人工智能、物联网、移动、安全、混合云、虚拟现实与增强现实、媒体,以及应用开发、部署与管理等方面;基础设施遍及 31 个地理区域的 99 个可用区,并计划新建 4 个区域和 12 个可用区。全球数百万客户,从初创公司、中小企业,到大型企业和政府机构都信赖亚马逊云科技,通过亚马逊云科技的服务强化其基础设施,提高敏捷性,降低成本,加快创新,提升竞争力,实现业务成长和成功。