该版本安装时间是2025-01-10,因为不同版本可能安装上会有所不同,下面也会讲到。

先说下问题——按照官方文档找不到执行命令llama-cli或./llama-cli

先附上llama.cpp的github地址:https://github.com/ggerganov/llama.cpp,build地址:https://github.com/ggerganov/llama.cpp/blob/master/docs/build.md。不知道你有没有出现这种情况,按照官方文档安装之后,发现根本找不到执行命令llama-cli或./llama-cli,如果没有可以跳过,如果有请按照我的以下流程安装一遍。

下载llama.cpp

我这里使用的是git命令下载:

git clone https://github.com/ggerganov/llama.cpp

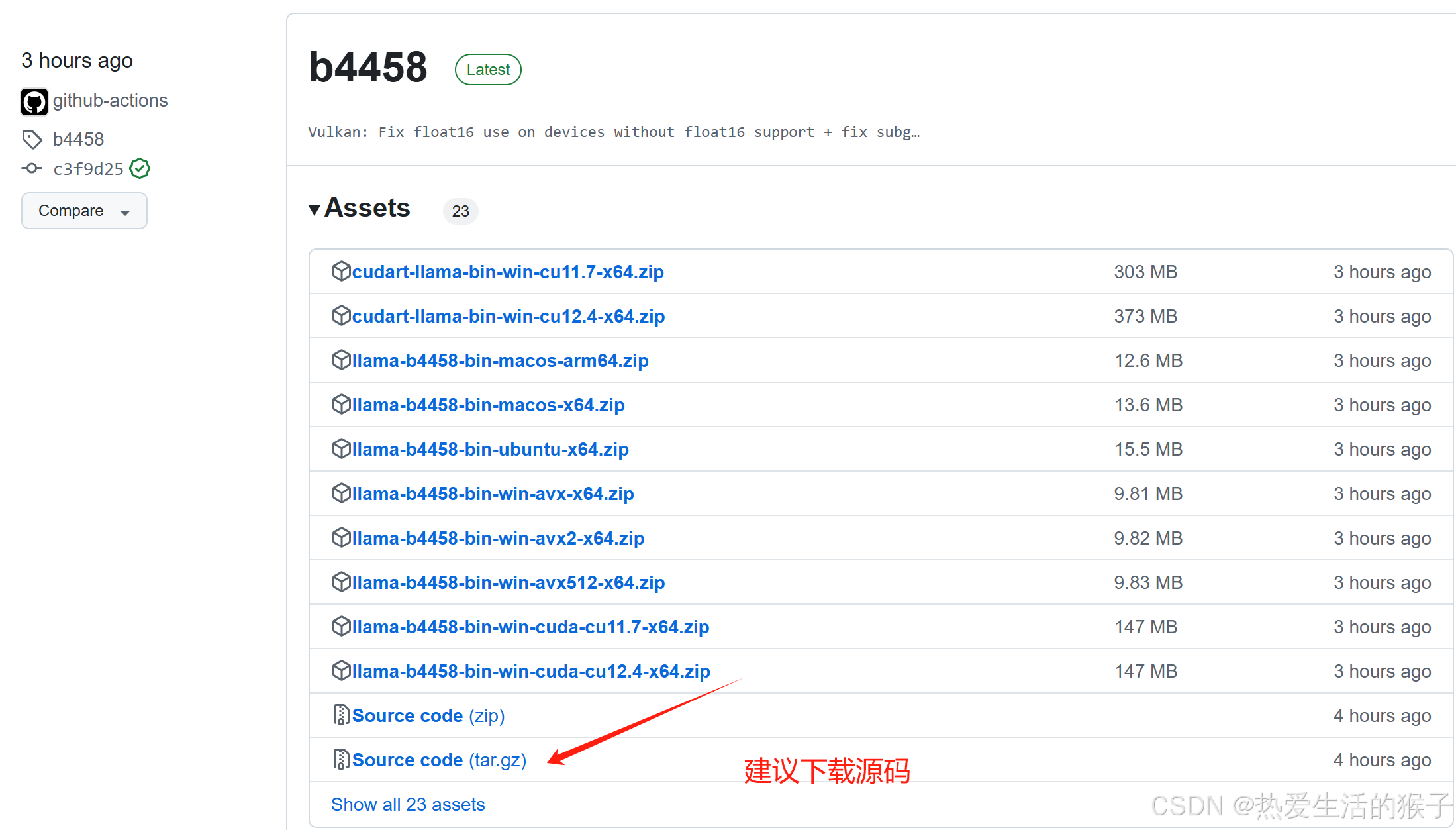

如果需要在内网服务器中安装,可以下载llama.cpp的源码文件或二进制文件,下载地址:https://github.com/ggerganov/llama.cpp/releases

编译

下面进入编译阶段,服务器使用的是nvidia-A10的gpu,编译使用的cuda编译版本。

如果是内网安装,需要先将安装包拷贝进来,然后解压:tar -xzvf ****.tar.gz

cd llama.cpp

cmake -B build -DGGML_CUDA=ON # 启动cuda加速

cmake --build build --config Release

启动模型

其实到这里llama.cpp已经编译安装好了,但是你如果看官方文档,你会发现你找不到执行命令llama-cli或./llama-cli,其实如果你想直接使用llama-cli命令,你需要配置环境变量,如果你想使用./llama-cli,你需要进入build/bin目录执行。

cd llama.cpp/build/bin

启动模型

./llama-cli -m /mnt/workspace/models/qwen2.5-7b-instruct-q4_k_m.gguf -co -cnv -p "你是一个好的助手" -fa -ngl 80 -n 512