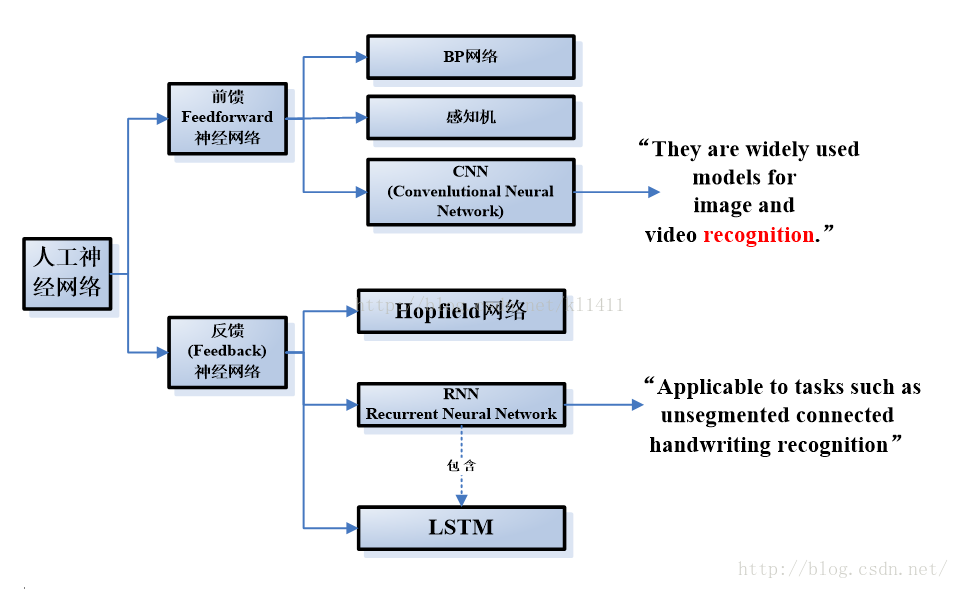

CNN vs RNN

RNN

回归型网络,用于序列数据,并且有了一定的记忆效应,辅之以

lstm

。

CNN应该侧重空间映射,图像数据尤为贴合此场景。

RNN

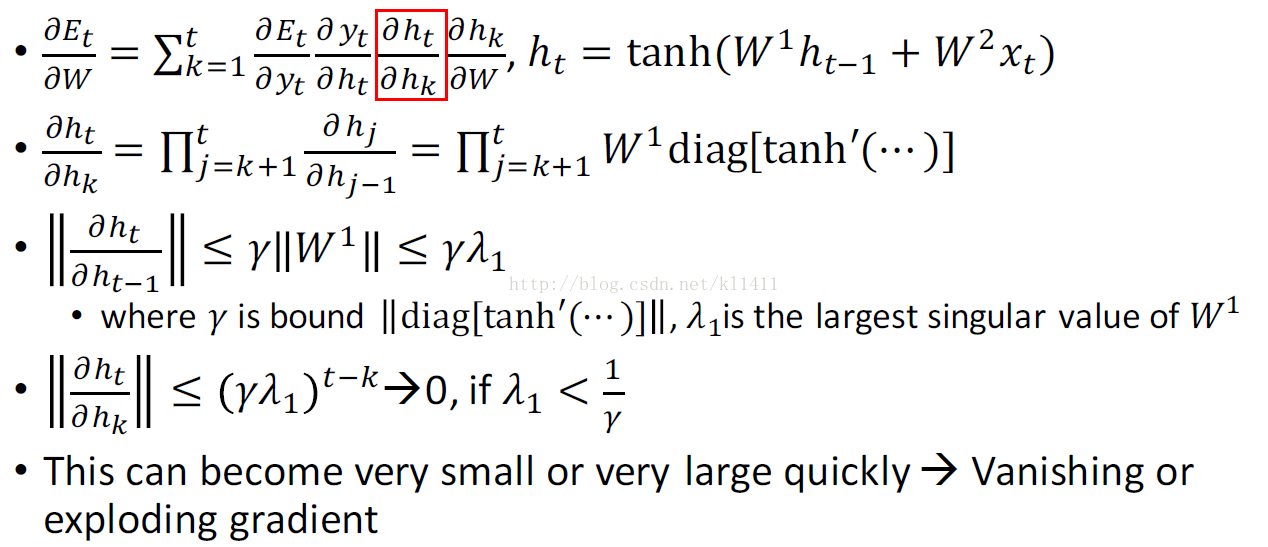

理论的和经验的证据表明很难学习并长期保存信息。

为了解决这个问题,一个增大网络存储的想法随之产生。采用了特殊隐式单元的

LSTM

(

long short-termmemory networks

)被首先提出,其自然行为便是长期的保存输入。

LSTM是RNN的一个优秀的变种模型,继承了大部分RNN模型的特性,同时解决了梯度反传过程由于逐步缩减而产生的Vanishing Gradient问题。

传统RNN很容易产生梯度消失、爆炸(膨胀)的问题。