NVIDIA Jetson Orin Nano 开发套件获得“超级”提升

生成式 AI 领域正在快速发展,新的大型语言模型 (LLM)、视觉语言模型 (VLM) 和视觉语言动作 (VLA) 模型每天都在涌现。为了站在这个变革时代的最前沿,开发人员需要一个足够强大的平台,能够使用 CUDA 优化推理和开放 ML 框架,将最新模型从云端无缝部署到边缘。

为了支持机器人和多模态代理中生成式 AI 工作负载的新兴应用,NVIDIA 通过软件更新刷新了 NVIDIA Jetson Orin Nano 开发套件,性能空前提升高达 1.7 倍,新价格令人惊叹,仅为 249 美元。为了表彰高级 AI 在性能和可访问性方面的卓越提升,Jetson Orin Nano 开发套件更名为 NVIDIA Jetson Orin Nano 超级开发套件。

只需进行软件更新,Jetson Orin Nano 开发套件即可升级为 Jetson Orin Nano 超级开发套件。

在这篇文章中,了解开发工具包的新功能以及如何无缝利用提升的性能。

NVIDIA 开发者计划

想要了解有关 NIM 的更多信息?加入 NVIDIA 开发者计划,即可免费访问任何基础设施云、数据中心或个人工作站上最多 16 个 GPU 上的自托管 NVIDIA NIM 和微服务。

加入免费的 NVIDIA 开发者计划后,您可以随时通过 NVIDIA API 目录访问 NIM。要获得企业级安全性、支持和 API 稳定性,请选择通过我们的免费 90 天 NVIDIA AI Enterprise 试用版使用企业电子邮件地址访问 NIM 的选项。

全新 Jetson Orin Nano 超级开发套件

Jetson Orin Nano 超级开发套件现在提供以下改进:

- 生成式 AI 模型性能提升 1.7 倍。

- 67 个稀疏 TOP,较之前的 40 个稀疏 TOP 有显著提升

- 102 GB/s 内存带宽,较之前的 65 GB/s 内存带宽有显著提升。

- 1.7 GHz CPU 时钟速度,高于 1.5 GHz。

- 新降价至 249 美元,低于 499 美元。

在相同的硬件架构下,这种性能提升通过新的电源模式实现,该模式可提高 GPU、内存和 CPU 时钟频率。所有之前的 Jetson Orin Nano 开发套件都可以通过升级到最新版本的 JetPack 来使用新的电源模式。

借助这种性能提升,Jetson Orin Nano 超级开发套件可提供高达 70% 的生成 AI 性能,使您能够运行新兴的一类基于 Transformer 的新型模型。这款紧凑而强大的系统可以轻松处理各种 LLM、VLM 和 Vision Transformers (ViT),从较小的模型到具有多达 8B 个参数的模型,例如 Llama-3.1-8B 模型。

Jetson 支持与其他平台相同的 ML 框架和优化的推理基础架构,例如 HuggingFace Transformers、Ollama、llama.cpp、vLLM、MLC、NVIDIA TensorRT-LLM 等。这使其成为您在云、边缘和 PC 之间快速适应和部署可扩展解决方案的理想选择。

| NVIDIA Jetson Orin Nano Developer Kit (original) | NVIDIA Jetson Orin Nano Super Developer Kit | |

| GPU | NVIDIA Ampere architecture 1,024 CUDA Cores 32 Tensor Cores 635 MHz | NVIDIA Ampere architecture 1,024 CUDA Cores 32 Tensor Cores 1,020 MHz |

| AI PERF | 40 INT8 TOPS (Sparse) 20 INT8 TOPS (Dense) 10 FP16 TFLOPs | 67 TOPS (Sparse) 33 TOPS (Dense) 17 FP16 TFLOPs |

| CPU | 6-core Arm Cortex-A78AE v8.2 64-bit CPU 1.5 GHz | 6-core Arm Cortex-A78AE v8.2 64-bit CPU 1.7 GHz |

| Memory | 8GB 128-bit LPDDR5 68 GB/s | 8GB 128-bit LPDDR5 102 GB/s |

| MODULE POWER | 7W | 15W | 7W | 15W | 25W |

运行各种 LLM、VLM 和 ViT

如果您想将生成式 AI 功能引入嵌入式应用程序或在经济实惠的计算机中体验尖端的生成式 AI 模型,NVIDIA Jetson Orin Nano 超级开发套件提供的性能将改变游戏规则。

LLM、VLM 和 vision transformers (ViT) 是推动跨领域创新的变革性 AI 架构。基础 LLM 擅长通用语言处理和生成类似人类的文本,与流式语音识别和合成管道(如 NVIDIA Riva)结合使用时可实现自然的人机界面。

通过修剪和提炼等技术,小型语言模型 (SLM) 迅速发展到可以与大型模型竞争,针对边缘用例进行了优化,通常被称为 <7B 参数大小。

如今,开放式 LLM 和 SLM 通常会接受代理工具使用和结构化 I/O 函数调用的训练,从而将 LLM 解析和推理与现实世界系统联系起来。

许多 ML 框架(包括 NVIDIA NeMo)也改进了对 LLM 微调和内存高效的 LoRA 的支持,从而为特定应用领域的 SLM 的对齐和专业化提供了易于理解的方案。

ViT 通过将像素块标记为嵌入,利用 Transformers 的视觉功能。它们在基本任务中实现了最先进的性能:

- 特征提取

- 分类

- 检测

- 分割

- 姿势估计

它们还通过 NVIDIA Cosmos Tokenizers 扩展到更高维度的模态,例如 3D 点云和视频。ViT 促使创造性的新混合模型将定制的视觉功能与开放词汇语言支持和针对各种主题和对象类别的动态运行时查询相结合,而无需额外的微调。

VILA 等 VLM 在视觉和文本模态中融合了 ViT 和 LLM,使模型能够理解和生成详细的场景描述,检测感兴趣的对象并使用 OCR 提取文本。它们可以应用多模态推理来响应用户对图像或视频序列的查询。

VLM 经历了与 SLM 类似的缩小化努力,在应用于具有灵活事件警报和摘要的摄像头流远程监控时,VLM 对边缘应用越来越有用,例如 Jetson Platform Services 中的参考 VLM 工作流。

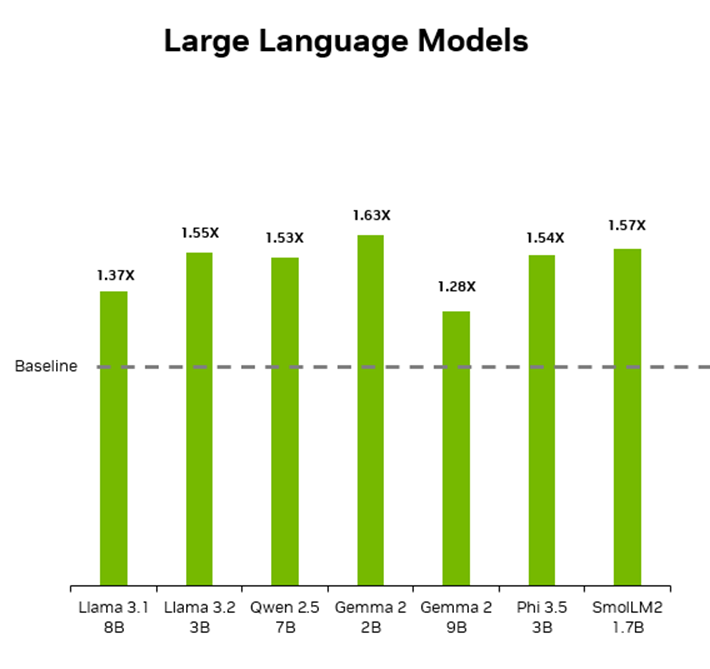

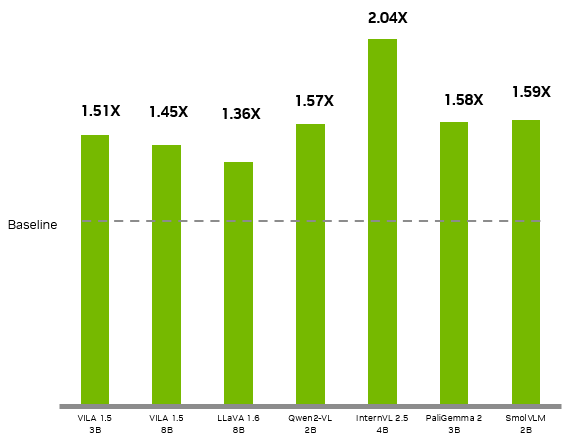

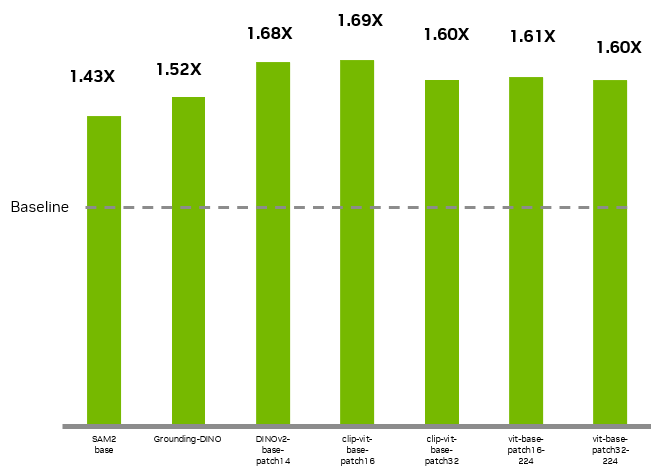

这些技术共同支撑了生成式 AI 和多模态系统以及现实世界应用的进步。新款 NVIDIA Jetson Orin Nano Super 在各种 LLM、SLM、ViT 和 VLM 上实现了显着的性能提升,并显著降低了获得最新 Transformer 模型作为物理 AI 门户的实践经验的门槛。我们对以下一些流行的 LLM、VLM 和 ViT 进行了基准测试,并展示了 Jetson Orin Nano Super 开发套件相对于前代产品的速度提升。

| Model | Jetson Orin Nano (original) | Jetson Orin Nano Super | Perf Gain (X) |

| Llama 3.1 8B | 14 | 19.14 | 1.37 |

| Llama 3.2 3B | 27.7 | 43.07 | 1.55 |

| Qwen2.5 7B | 14.2 | 21.75 | 1.53 |

| Gemma 2 2B | 21.5 | 34.97 | 1.63 |

| Gemma 2 9B | 7.2 | 9.21 | 1.28 |

| Phi 3.5 3B | 24.7 | 38.1 | 1.54 |

| SmolLM2 | 41 | 64.5 | 1.57 |

* LLM generation performance (tokens per second) with INT4 quantization using MLC API.

| Model | Jetson Orin Nano (original) | Jetson Orin Nano Super | Perf Gain (X) |

| VILA 1.5 3B | 0.7 | 1.06 | 1.51 |

| VILA 1.5 8B | 0.574 | 0.83 | 1.45 |

| LLAVA 1.6 7B | 0.412 | 0.57 | 1.38 |

| Qwen2 VL 2B | 2.8 | 4.4 | 1.57 |

| InternVL2.5 4B | 2.5 | 5.1 | 2.04 |

| PaliGemma2 3B | 13.7 | 21.6 | 1.58 |

| SmolVLM 2B | 8.1 | 12.9 | 1.59 |

*All VILA and LLAVA models were run with INT4 precision using MLC while the rest of the models were run in FP4 precision with Hugging Face Transformers.

| Model | Jetson Orin Nano (original) | Jetson Orin Nano Super | Perf Gain (X) |

| clip-vit-base-patch32 | 196 | 314 | 1.60 |

| clip-vit-base-patch16 | 95 | 161 | 1.69 |

| DINOv2-base-patch14 | 75 | 126 | 1.68 |

| SAM2 base | 4.42 | 6.34 | 1.43 |

| Grounding DINO | 4.11 | 6.23 | 1.52 |

| vit-base-patch16-224 | 98 | 158 | 1.61 |

| vit-base-patch32-224 | 171 | 273 | 1.60 |

*All ViT models were run with FP16 precision using NVIDIA TensorRT (measurements are in FPS).

开始使用 Jetson Orin Nano 超级开发套件

要享受增强的性能,请从 JetPack SDK 页面下载 SD 卡映像并按照入门指南操作。

NVIDIA 发布了基于 JetPack 6.1 的 SD 卡映像,支持增强的性能。您还可以使用 SDK 管理器为 Jetson Orin Nano 开发套件安装具有增强性能的 JetPack 6.1。确保您已更新 SDK 管理器并在安装时选择 JetPack 6.1 (rev. 1)。

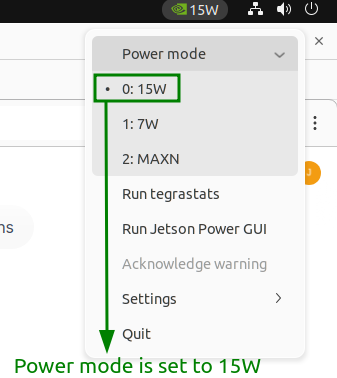

当您启动并运行 JetPack 时,使用以下命令更改电源模式以解锁超级性能。模式 2 是 MAXN 模式,可带来超级性能。

sudo nvpmodel -m 2

您还可以使用 Ubuntu 桌面顶部栏右侧的电源模式选择器更改电源模式。

在 Jetson Orin Nano 超级开发者套件上体验生成式 AI

NVIDIA 在 Jetson AI Lab 中提供了一系列教程和预构建容器,用于在 Jetson Orin Nano 开发者套件上探索生成式 AI。如果您对机器人感兴趣,请务必探索 LeRobot 教程。对于那些希望创建生成式 AI 聊天机器人的人,有一个专门的教程来构建一个。

Hugging Face LeRobot

NVIDIA 已与 Hugging Face 合作,以加速 LeRobot 开放 AI 平台上的机器人研究。您可以在 Jetson Orin Nano 超级开发者套件上运行 HuggingFace LeRobot,该套件运行生成式 AI 模型,用于根据视觉输入和先前的轨迹预测特定任务的操作。

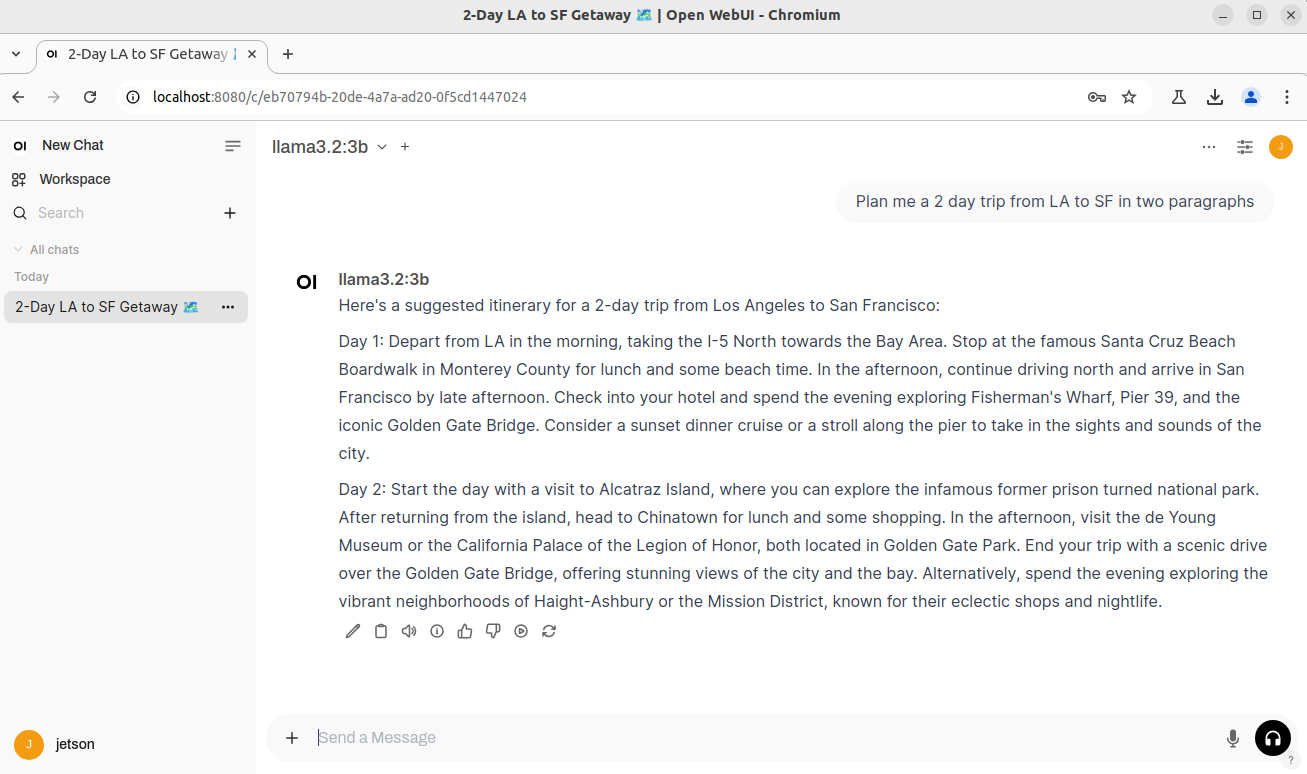

使用 Ollama 生成 AI 驱动的聊天机器人

在 Jetson Orin Nano 超级开发套件上运行生成 AI 聊天机器人。此聊天机器人采用 Ollama 和 Open WebUI,这是一种广泛使用的开源聊天机器人服务器界面,可连接到本地运行的 LLM。它使用检索增强生成 (RAG) 来进一步增强用户体验和功能。

利用 Jetson AI Lab 推进生成式 AI

Jetson AI Lab 是发现和试验针对边缘设备优化的最新生成式 AI 技术的中心。

通过培育开放协作和社区驱动的环境,NVIDIA 与开发人员和合作伙伴一起推进开源边缘 AI 和机器人学习。借助我们对流行机器学习框架的全面支持以及 Jetson 设备上优化的推理微服务,您可以在 Jetson 计算机上快速构建和部署最新的研究创新和模型,以跟上快速的创新步伐。

下图显示了 NanoOWL 开放词汇实时对象检测 ViT 的示例。

Jetson AI Lab 提供近 50 个简单易懂的教程和预构建容器,让任何经验水平的开发人员都能快速开始使用设备上的 LLM、SLM 和多模态 VLM,以及 VLA、扩散策略和语音模型的变体。它们都使用与云中使用的相同的优化推理基础架构在本地部署。

Jetson AI Lab 的协作、社区驱动的教程和资源大大降低了将高级生成式 AI 部署到边缘的门槛。

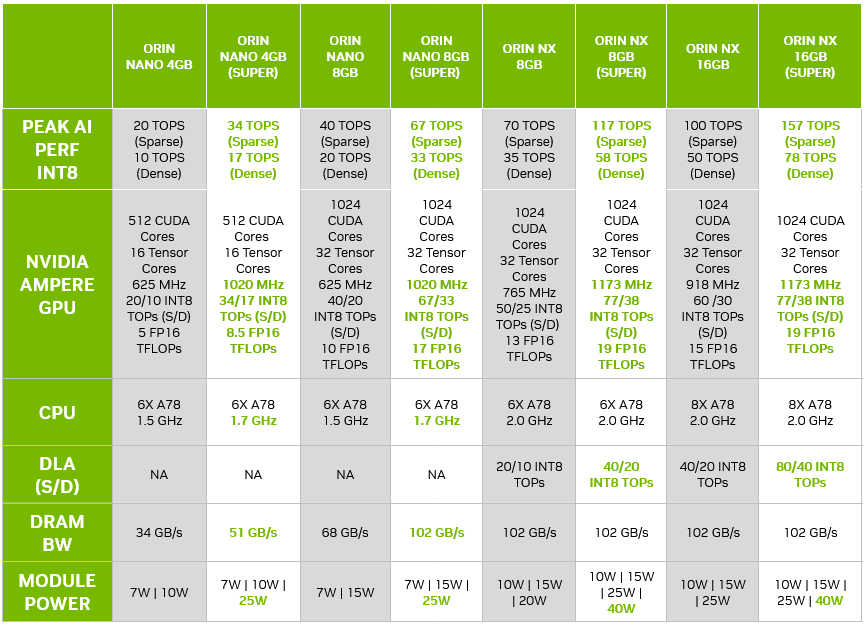

所有 Jetson Orin Nano 系列和 Jetson Orin NX 系列模块都获得了超级性能提升

NVIDIA 还在刷新 Jetson Orin Nano 系列和 Jetson Orin NX 系列的性能。从小型 AI 摄像头到大型自主机器,每个边缘设备都需要计算能力来运行生成式 AI 模型。

使用相同的模块硬件,您可以利用不同模块之间高达 1.7 倍的性能提升。

- Orin Nano 系列:改进了 GPU、CPU 和内存的频率和性能。

- Orin NX 系列:改进了 GPU 和 DLA。

Jetson Orin Nano 和 Orin NX 生产模块的增强性能支持和文档将于 1 月上半月随 JetPack 6.1.1 发布。

由于客户对 Orin 的需求不断增长,NVIDIA 最近还宣布将 Jetson Orin 的产品生命周期延长至 2032 年。凭借这一超级性能提升,Orin Nano 系列和 Orin NX 系列是当前和未来型号的理想平台。