1、环境部署

合理的上网工具

安装GIT

安装NVIDIA 图形化驱动 522.25版本,如果电脑本身是更高版本则不用更新

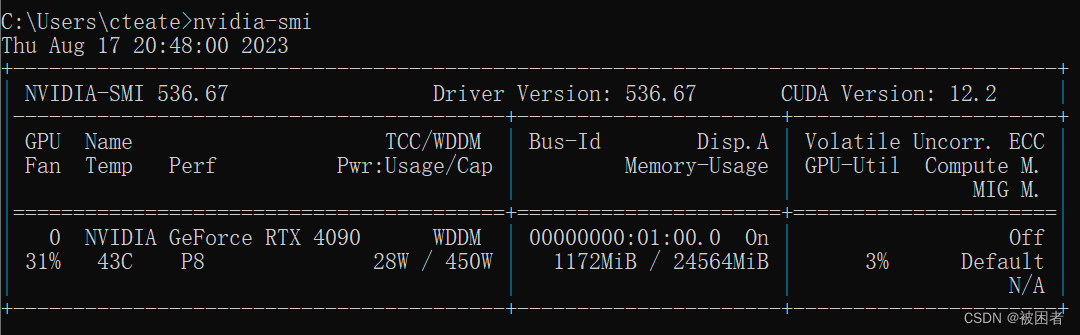

1.1、检查CUDA

运行cmd或者Anaconda,运行以下命令,如果显示的版本不是11.8也不用着急,可能是系统自带的CUDA版本

nvidia-smiCUDA Version是版本信息,Dricer Version是图形化驱动版本

安装 python-3.8

安装Pytorch,用Anaconda,运行以下命令

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu1181.2、检查Pytorch

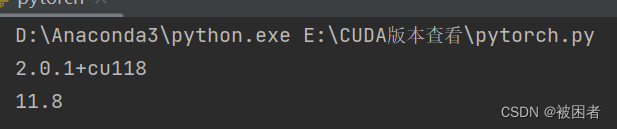

新建文件pytorch.py

import torch

print(torch.__version__)

print(torch.version.cuda)运行效果如下,cu118对应CUDA11.8版本

2、ChatGLM2下载

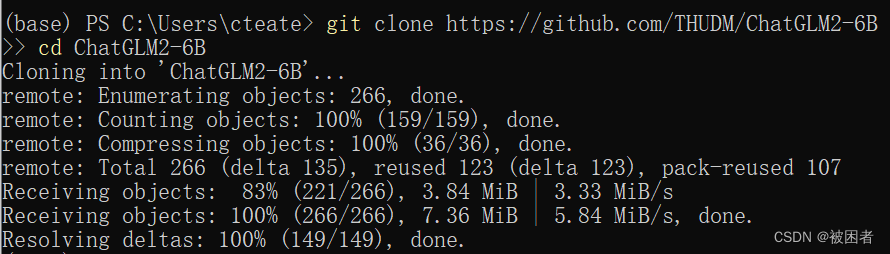

用Anaconda,运行以下命令,如果想要下载指定文件夹,用cd切换

git clone https://github.com/THUDM/ChatGLM2-6B

cd ChatGLM2-6B 以下是执行效果,下载到C:\Users\cteate\ChatGLM2-6B

安装依赖,用Anaconda,运行以下命令,记得cd切换到ChatGLM2-6B文件夹

pip3 install -r requirements.txt3、手动下载模型到本地(不用梯子)

访问清华云盘:清华大学云盘 (tsinghua.edu.cn)进行下载

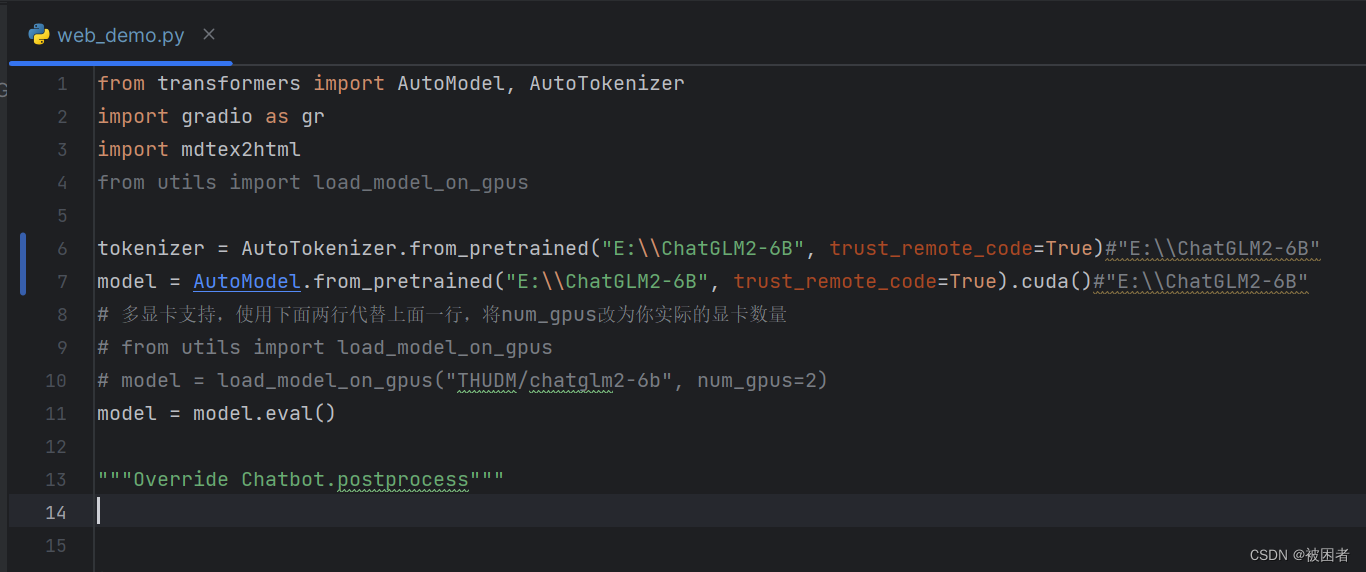

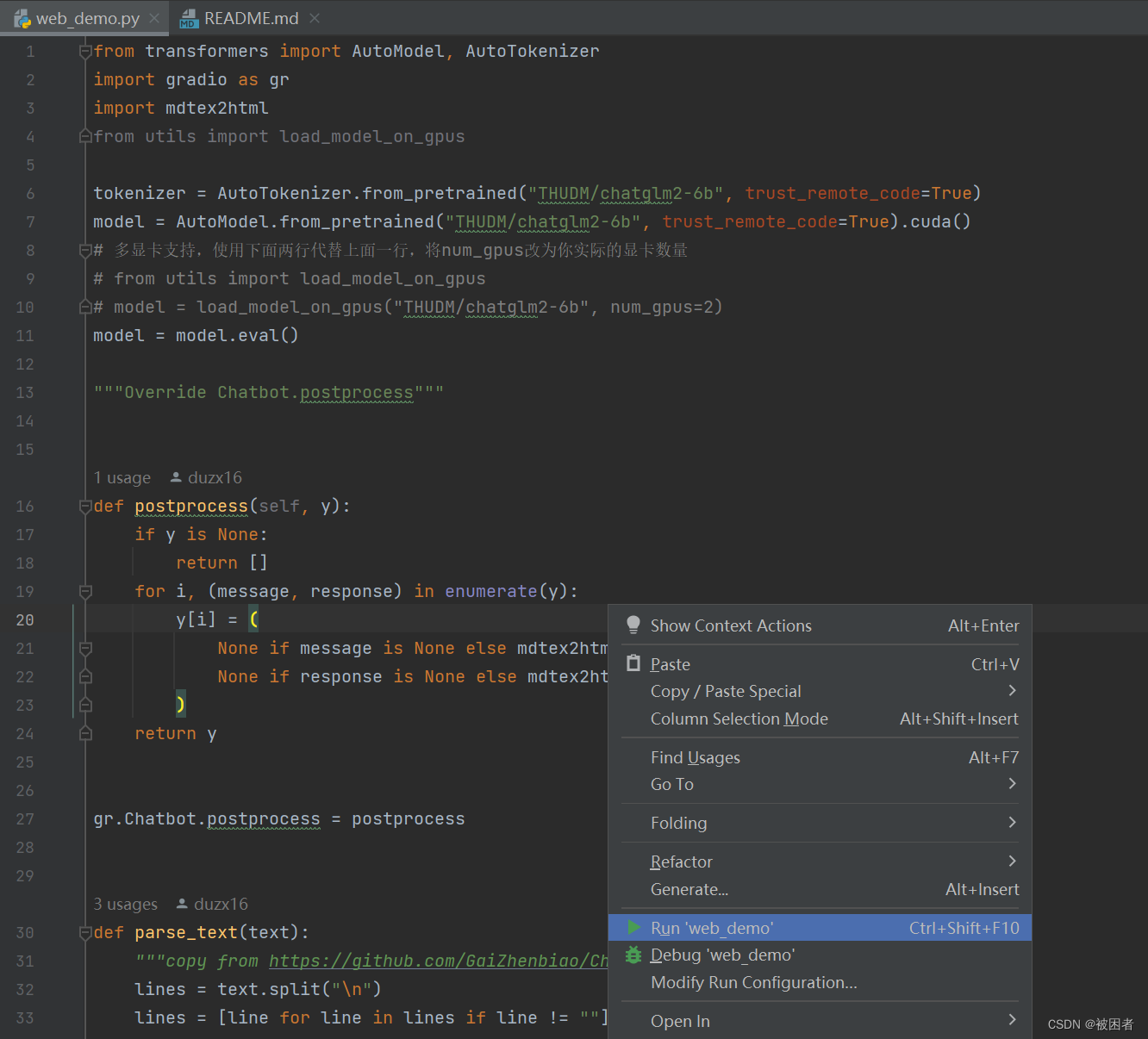

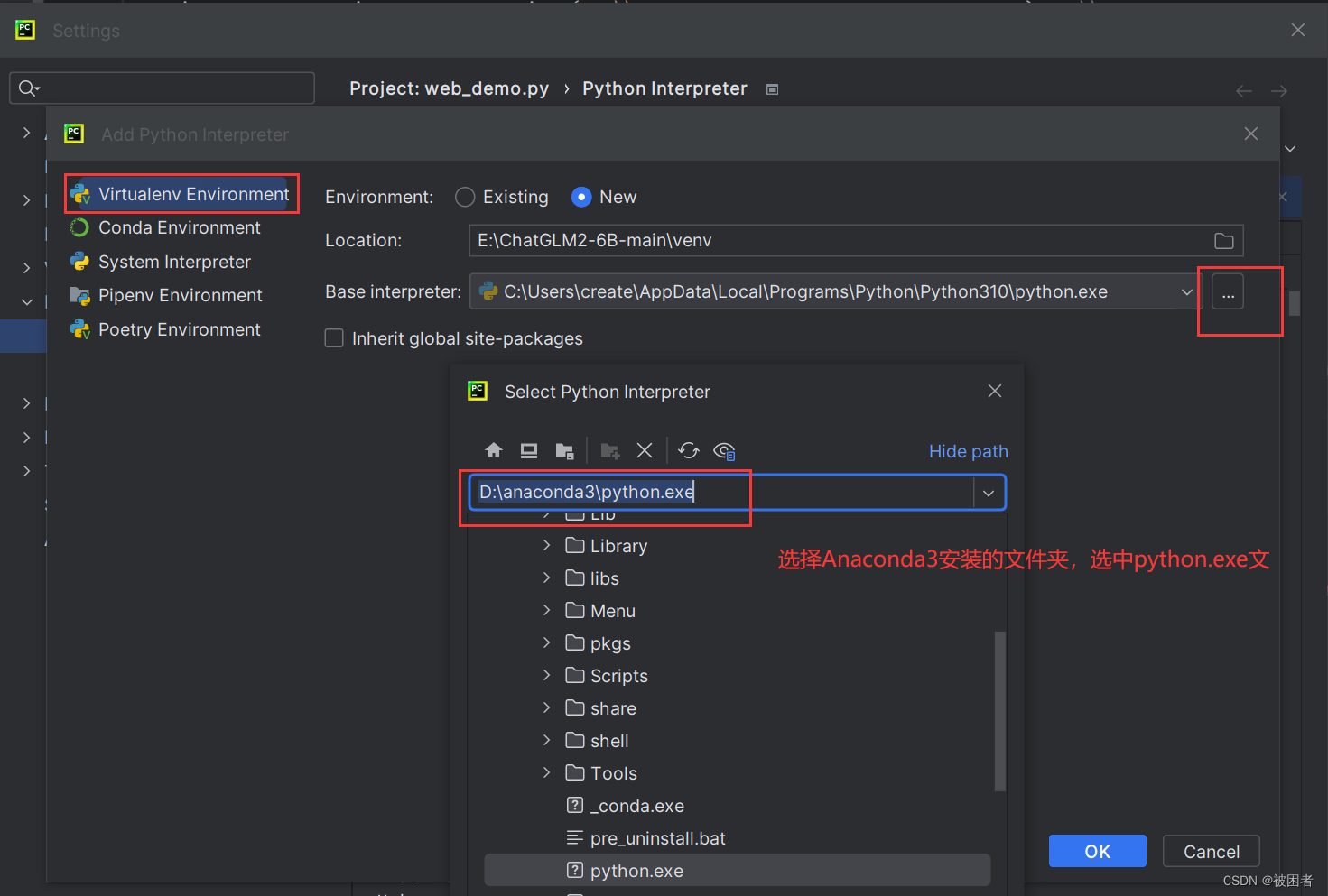

保存模型至文件夹,我这里保存到E:\ChatGLM2-6B,运行时修改模型路径,如下图:

4、运行ChatGLM2

4.1运行web示例

运行web_demo.py(如果没有下载模型到本地,不用修改,执行自动下载模型)

模型地址:C:\Users\用户名\.cache\huggingface\hub\models--THUDM--chatglm2-6b\snapshots\

第一次执行会下载模型文件,下载到C:\Users\用户名\.cache\huggingface\hub下

PS:如果运行下载中断,可以多运行几次

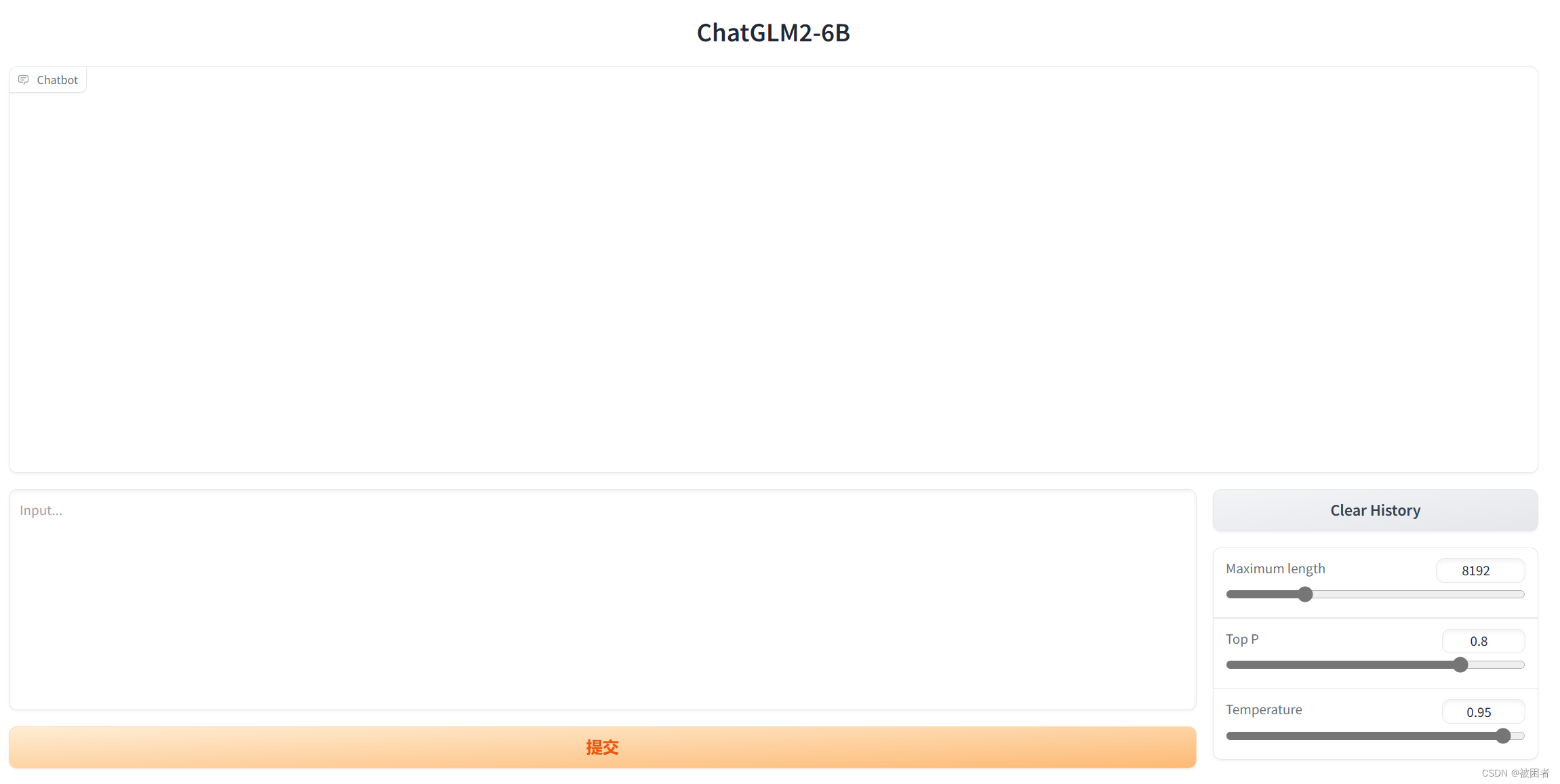

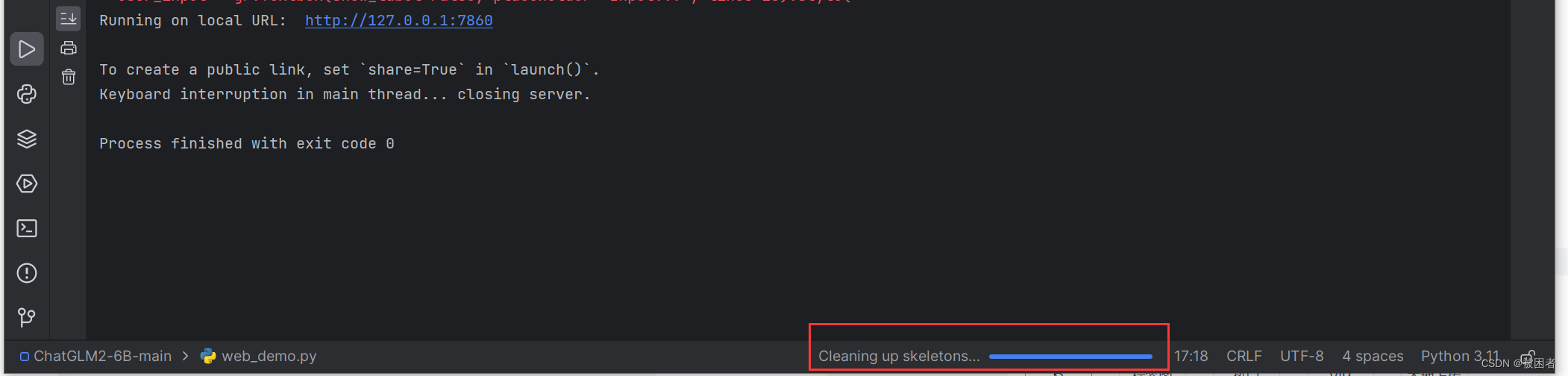

运行成功后,界面:

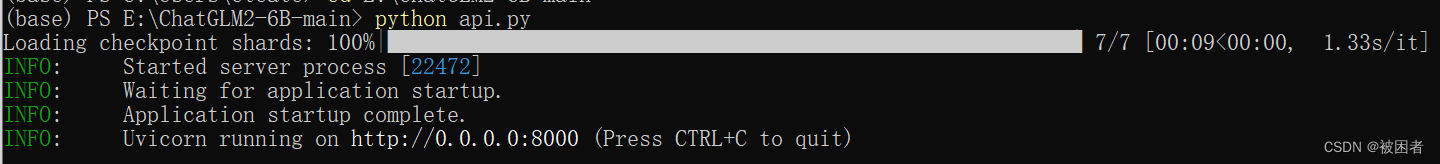

4.2运行API

安装依赖,cd 转到ChatGLM文件夹(如:cd E:\ChatGLM2-6B-main),再用Anaconda,运行以下命令

pip install fastapi uvicorn再运行以下命令:

python api.py启动后效果:

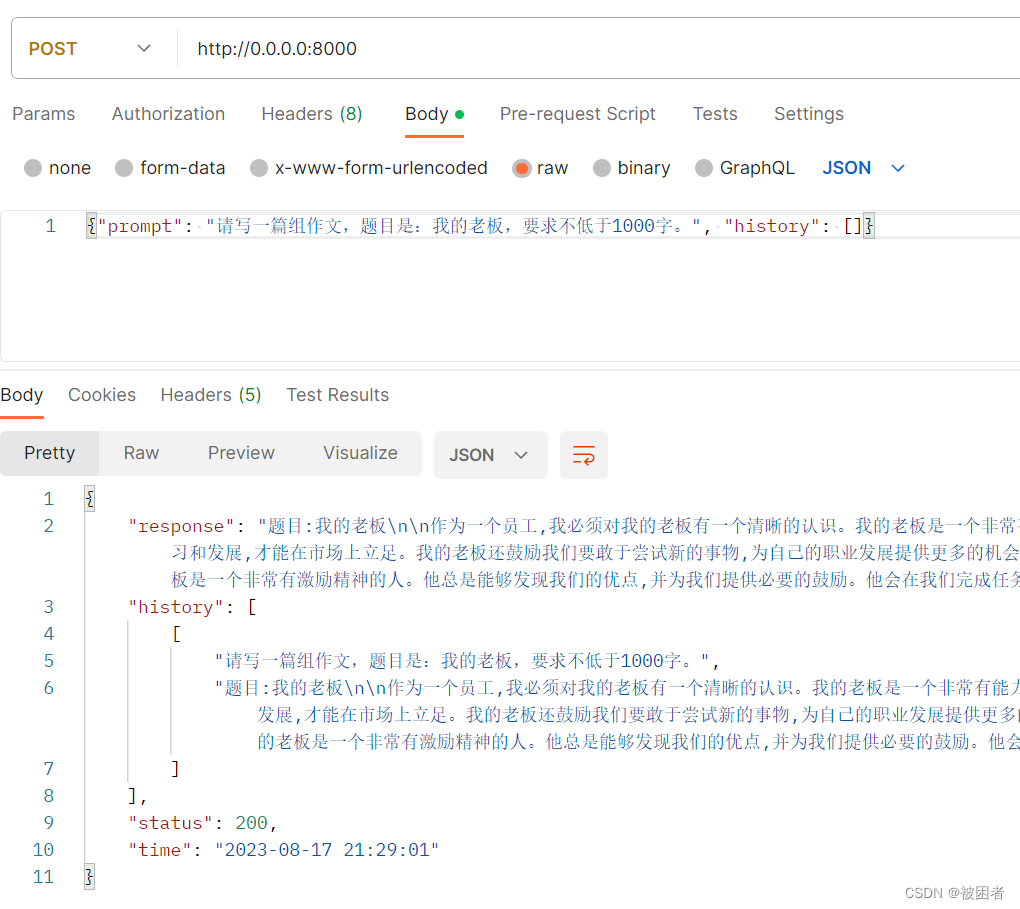

用PostMan测试

5、注意事项

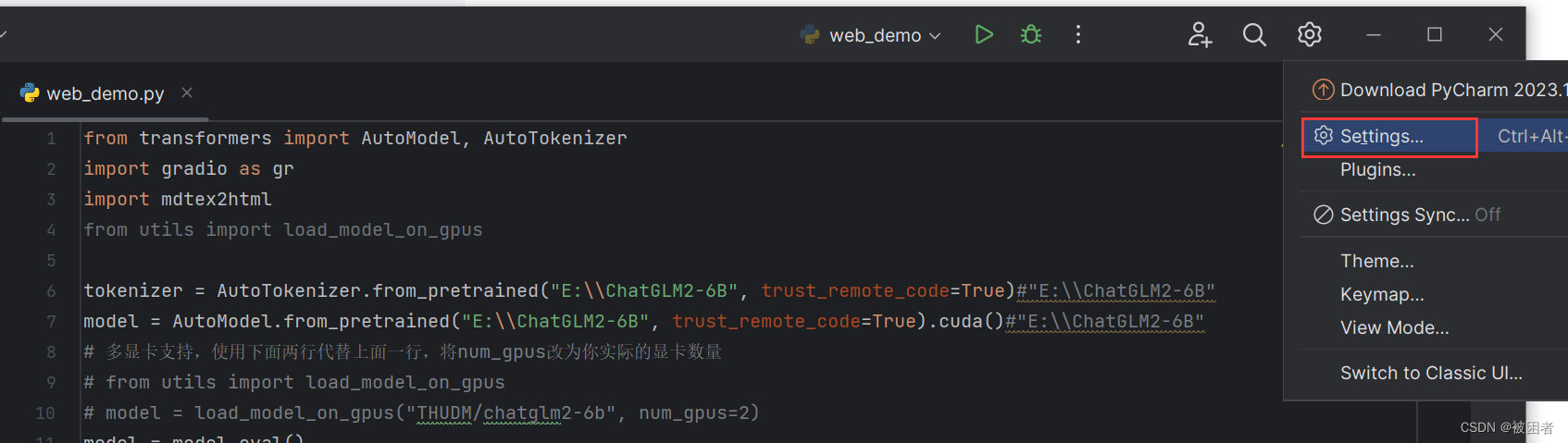

5.1第一次运行切换python版本(使用pycharm开发工具)

切换的时候等右下角加载完,代码错误提示就没有了

6、错误合集

6.1运行web_demo2.py,提示streamlit不是内置函数

用Anaconda,运行以下命令

pip install streamlit添加环境变量-环境变量-系统变量-Path-编辑,点击新建,然后添加包含 streamlit.exe 可执行文件的目录路径。 路径参考:C:\Users\用户名\AppData\Roaming\Python\Python311\Scripts