最近这一两周看到不少互联网公司都已经开始秋招提前批了。不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少,岗位要求还更高了。

最近,我们又陆续整理了很多大厂的面试题,帮助一些球友解惑答疑,分享技术面试中的那些弯弯绕绕。

《AIGC 面试宝典》圈粉无数!

《大模型面试宝典》(2024版) 发布!

喜欢本文记得收藏、关注、点赞。更多实战和面试交流,欢迎交流

大家好,今天继续分享几个开源项目!

一、MiniCPM-V 2.6

8 月 6 日,MiniCPM-V 开源项目重磅更新了「小钢炮」 MiniCPM-V 2.6。

仅 8B 参数,单图、多图、视频理解全面超越GPT-4V,稳坐端侧最强多模态铁王座。

8B 参数的模型很有意义,这种小模型可以在手机端侧落地。

MiniCPM-V 2.6 的能力,让外国网友们眼前一亮,火出圈了!

1、在线测试

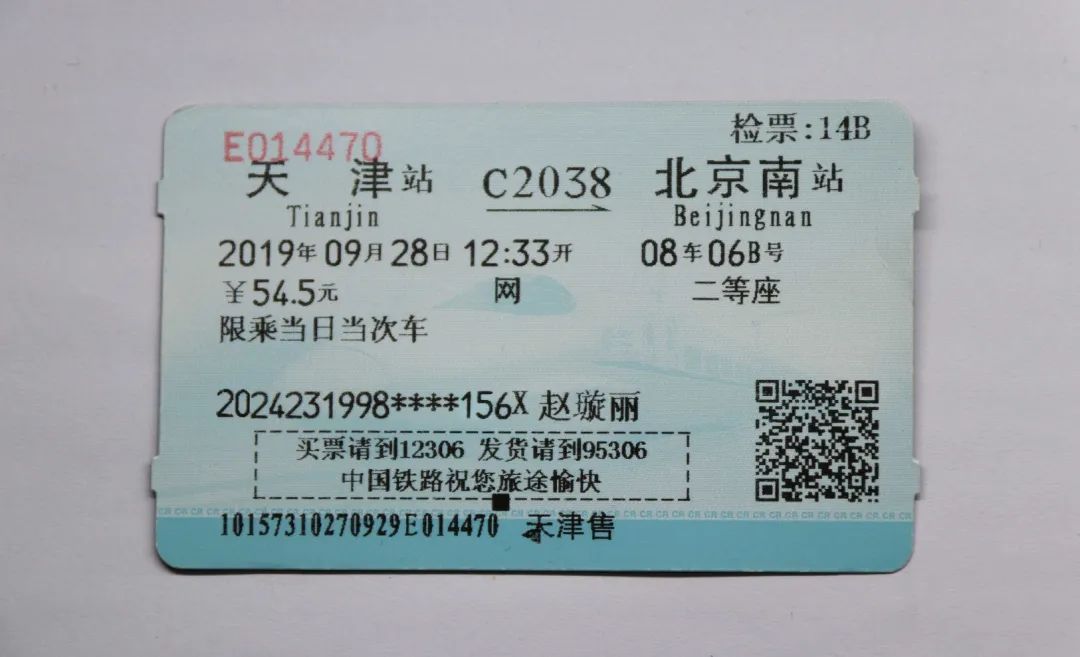

我找来了一张火车票测试一下:

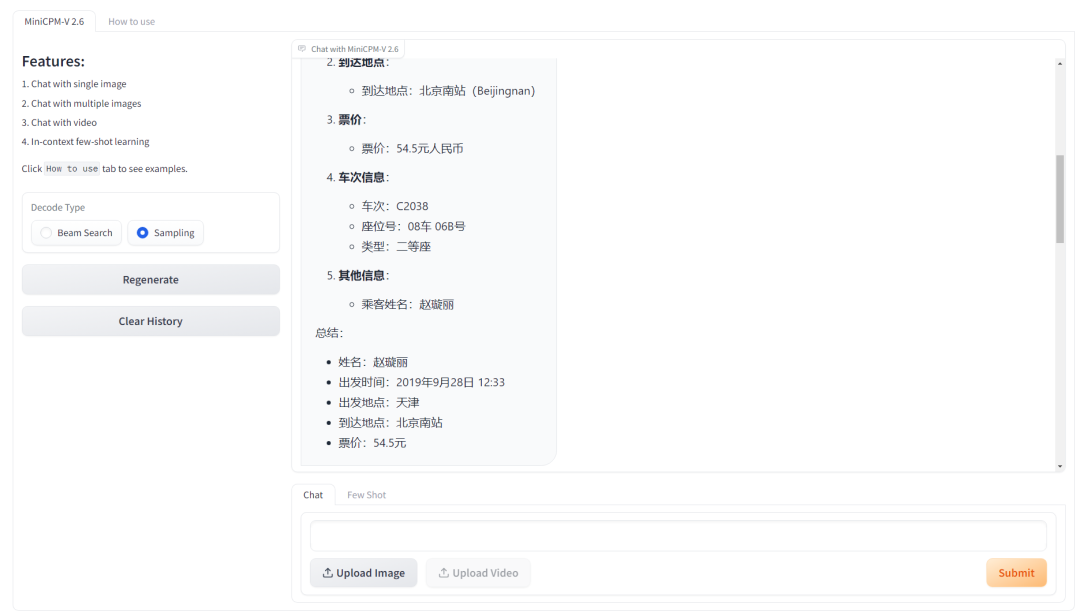

输入一张图片,外加问题:请逐步详细分析,谁(姓名)几点出发,从哪儿到哪儿,并且花了多少钱?

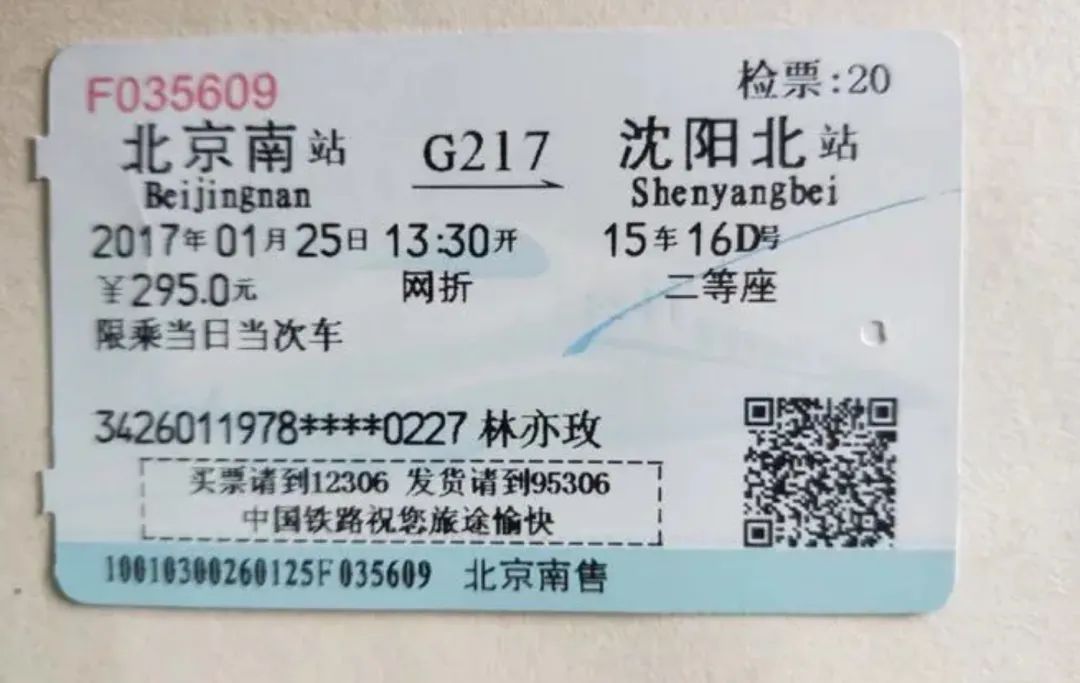

回答完全正确。我又找了稍微模糊一点的图片又测试了下:

然后又提问:两张车票,加起来多少钱?

54.5元 + 295.0元 = 349.5元,这种上下文多次输入的,也能算对。

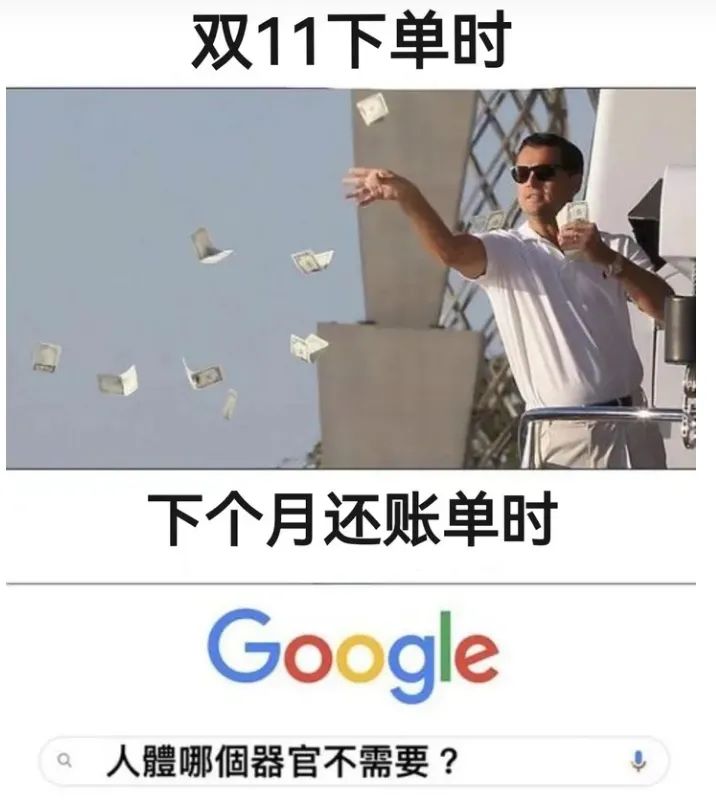

我又测试了它对于梗图的解读:

MiniCPM-V 2.6 的回答,这波你打几分?

再张抽象一点的:

MiniCPM-V 2.6 的回答:

2、官方 Demo

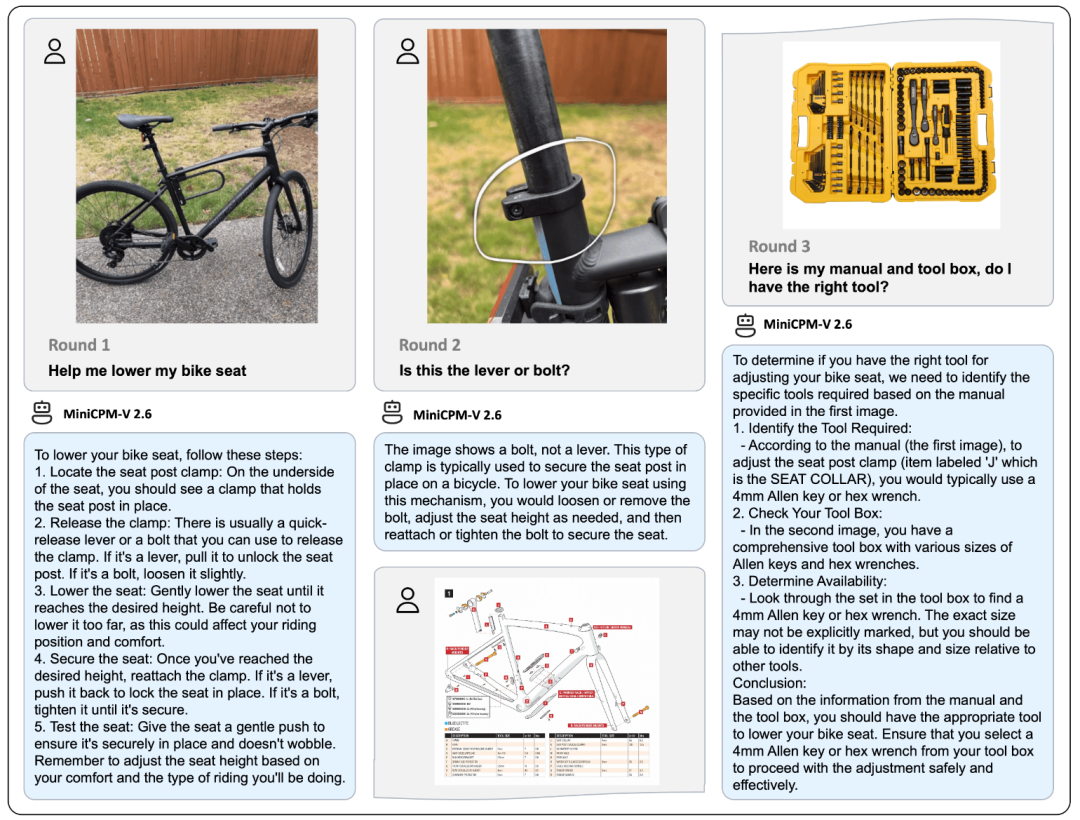

MiniCPM-V 2.6 刷新了端侧多模态复杂推理能力。

比如这道 GPT-4V 官方演示经典命题:调整自行车车座。这个对人很简单的问题对模型却非常困难,它非常考验多模态模型的复杂推理能力和对物理常识的掌握能力。

仅 8B 的 MiniCPM-V 2.6 展现出顺利完成这项挑战的潜力,通过和模型进行多图多轮对话,它清晰地告知完成调低自行车车座的每一个详细步骤,还能根据说明书和工具箱帮你找到合适的工具。

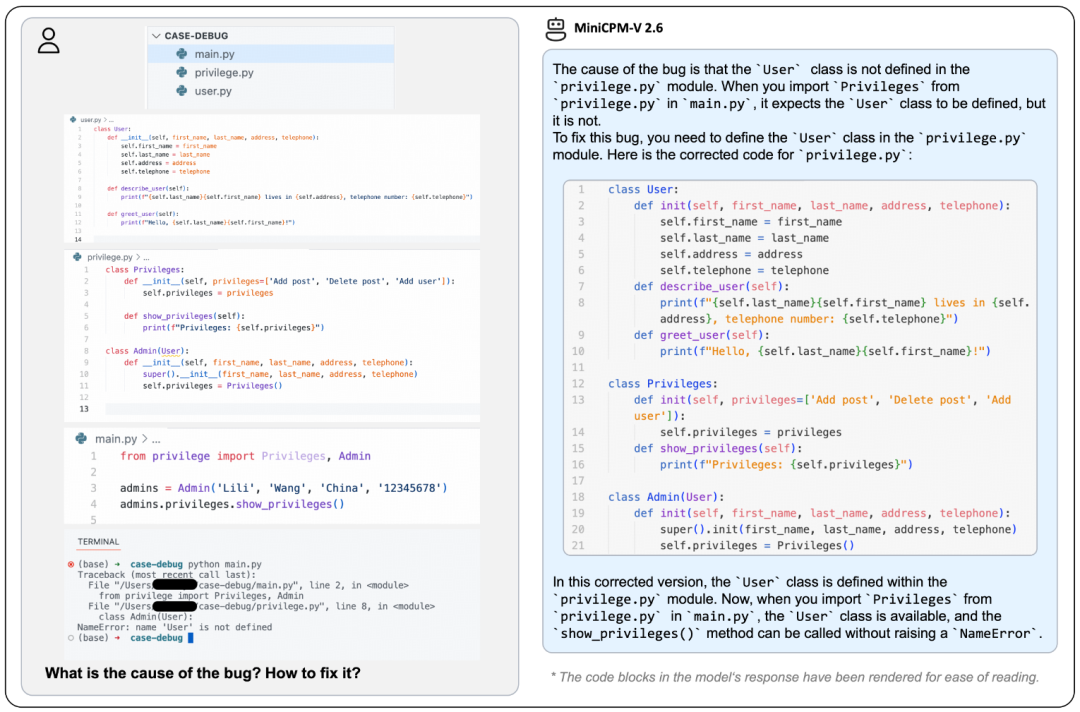

甚至还能根据截图的报错信息,帮你改 bug:

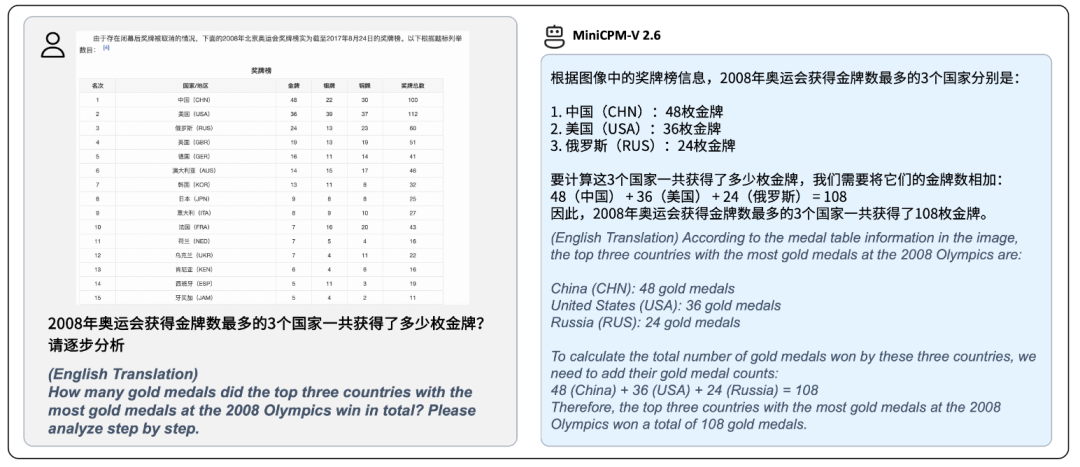

根据表格的截图信息,做数据分析、统计:

3、MiniCPM-V 2.6 细节

MiniCPM-V 2.6 是基于 SigLip-400M 和 Qwen2-7B 构建,共 8B 参数。

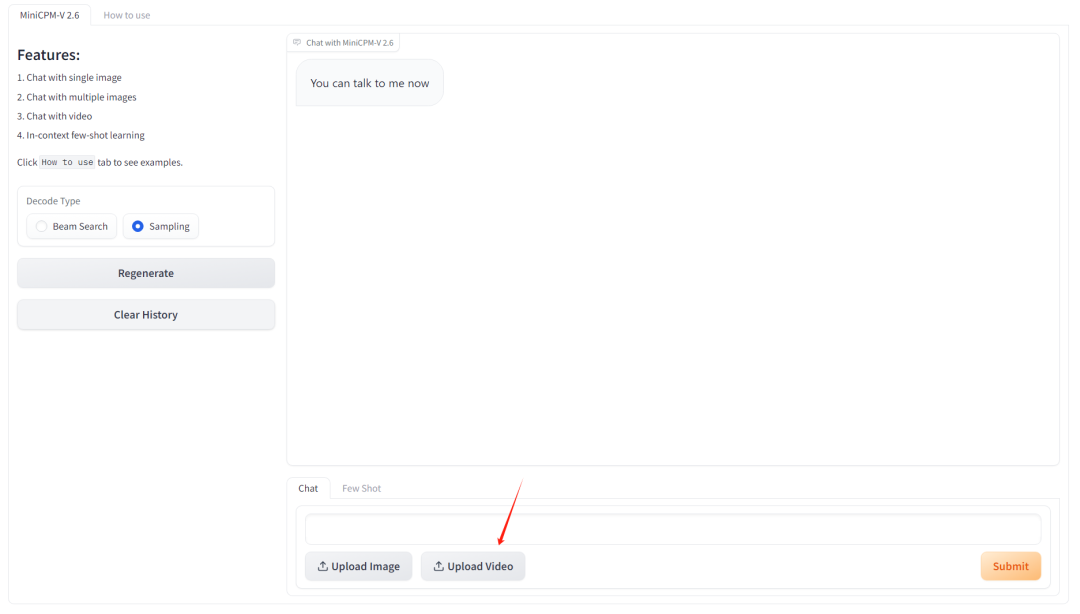

支持图片和视频的理解,官方提供的在线 demo 也提供了接口,不仅能处理图文、还是处理视频。

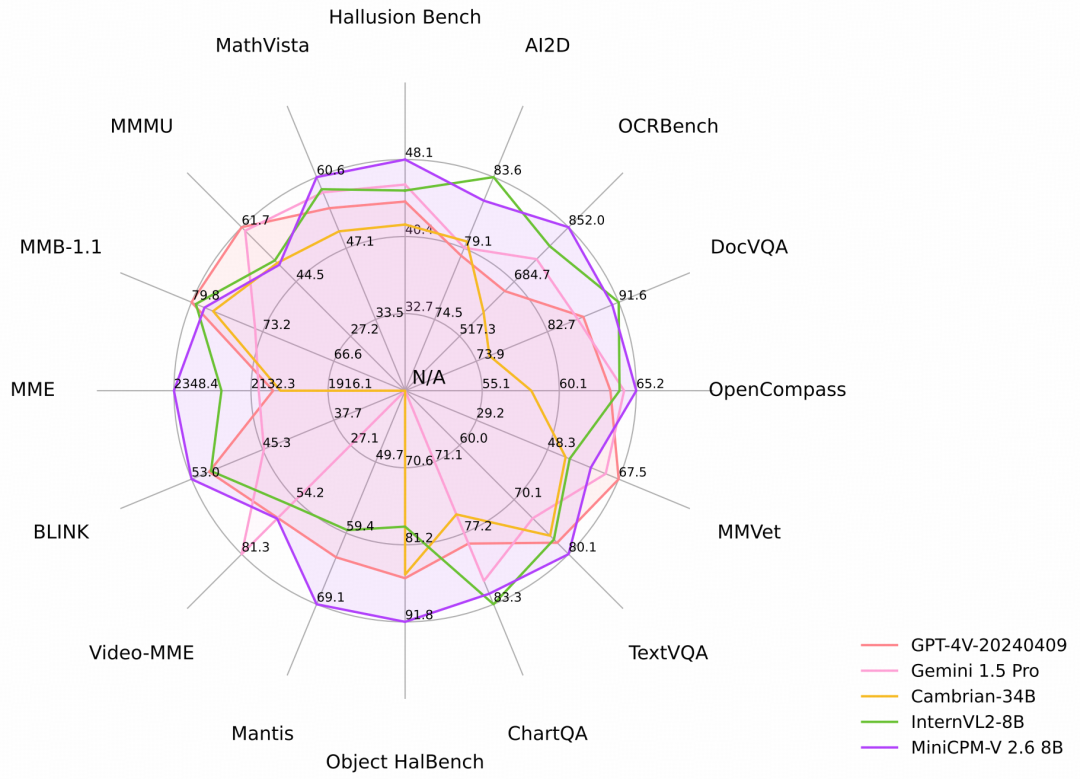

MiniCPM-V 2.6 在最新版本 OpenCompass 榜单上(综合 8 个主流多模态评测基准)平均得分 65.2,以 8B 量级的大小在单图理解方面超越了 GPT-4o mini、GPT-4V、Gemini 1.5 Pro 和 Claude 3.5 Sonnet 等主流商用闭源多模态大模型。

端侧非常友好,量化后端侧内存仅占 6 GB;端侧推理速度高达 18 tokens/s,相比上代模型快 33%。并且发布即支持 llama.cpp、ollama、vllm 推理;且支持多种语言。

对于多模态大模型感兴趣的小伙伴,一定要尝试一下。

项目地址:

https://github.com/OpenBMB/MiniCPM-V

在线体验地址(需梯子):

https://huggingface.co/spaces/openbmb/MiniCPM-V-2_6

模型保存地址(需梯子):

https://huggingface.co/openbmb/MiniCPM-V-2_6

二、SimpleTuner

fintune 虽然不需要从头训练大模型,但也有着不小的工作量。

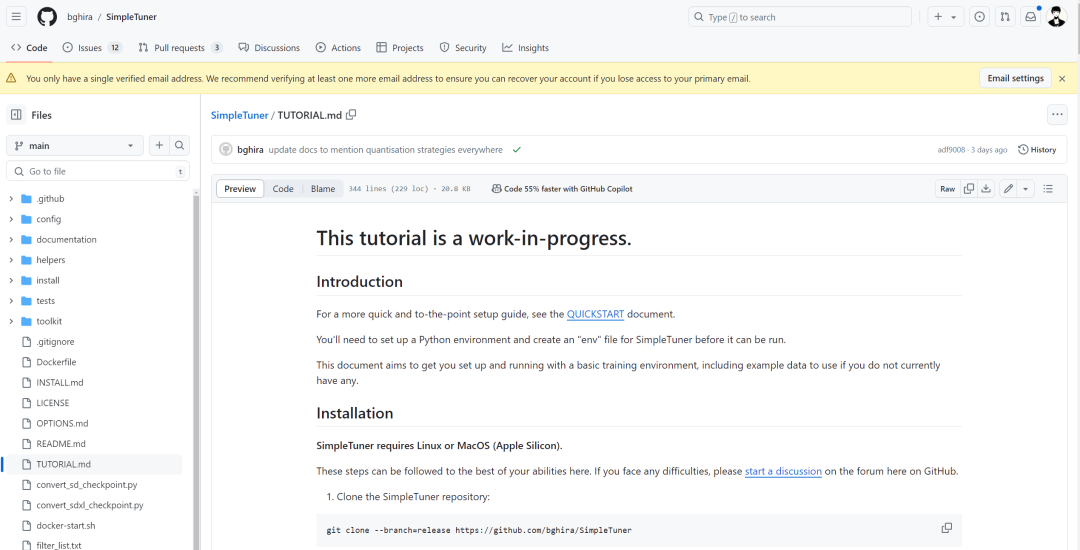

SimpleTuner,顾名思义,简单地微调,它是一个针对 Stable Diffusion 2.1、Stable Diffusion 3、DeepFloyd 和 SDXL 的微调训练项目。

能够帮助开发者快速微调这些模型,支持全部 finetune,也支持 LoRA 训练。

支持 N 卡,A 卡,苹果 M3 CPU 上的训练,N 卡 3090 以上的就行,AMD 相对于 N 卡会占用更多的内存,M3 芯片上训练 LoRA 需要 128G 以上的内存。

官方提供了详细的训练指南:

有微调大模型需求的小伙伴,可以关注。

项目地址:

https://github.com/bghira/SimpleTuner

好了,本期的内容就是这么多.