目录

绪论

一、信息论的基本概念

1.1 信息的定义

根据香农的定义,信息是事物运动状态或存在方式的不确定性的描述。换句话说,信息是用来消除不确定性的。在日常生活中,我们通过消息、信号、数据等形式传递信息。

1.2 信息的三个层次

信息可以分为三个基本层次:

- 语法信息:关注事物运动的状态和变化方式,香农信息论主要研究的是这一层次。

- 语义信息:关注事物运动状态或变化方式的内在含义。

- 语用信息:关注事物运动状态或变化方式的效用和价值。

二、香农信息论的研究内容

2.1 信源与信源编码

信源是信息的来源,它可以分为离散信源、连续信源和波形信源。信源编码的主要任务是将信源输出的消息转换为符号,以提高传输的有效性。

2.2 信道与信道编码

信道是信息从编码器传输到译码器的媒介。信道编码的主要任务是通过增加冗余来提高传输的可靠性。常见的信道编码技术包括汉明码、卷积码和Turbo码。

2.3 保密通信与密码学

保密通信是信息论的一个重要应用领域,它通过加密技术确保信息在传输过程中不被窃取或篡改。

离散信源(一)

一、自信息

1.1 定义

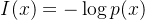

自信息(Self-Information)是衡量单个事件发生时所提供的信息量的指标。对于一个事件 x,其自信息定义为:

其中:

- p(x) 是事件 x 发生的概率。

- 对数的底通常为 2,单位为比特(bit)。

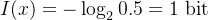

例子,假设一个事件 x 发生的概率为 p(x)=0.5,则其自信息为:

二、离散信源

2.1 定义

离散信源是指输出符号为离散值的信源。

例如,抛硬币的结果(正面或反面)就是一个典型的离散信源。离散信源的输出可以用符号集合表示,每个符号的出现概率可以通过概率分布描述。

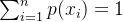

2.2 符号表示

设离散信源的符号集合为 X={x1,x2,…,xn},每个符号 xi 出现的概率为 p(xi),满足:

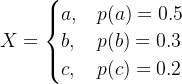

例子,假设一个离散信源的符号集合为 X={a,b,c},其概率分布为:

- p(a)=0.5

- p(b)=0.3

- p(c)=0.2

则该信源的数学模型为:

三、信息熵

3.1 信息熵的定义

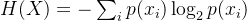

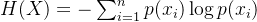

信息熵(Entropy)是衡量信源不确定性的指标。对于一个离散信源X,其信息熵定义为:

其中,

是符号

的出现概率,对数通常以 2 为底,单位为比特(bit)。

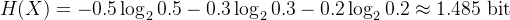

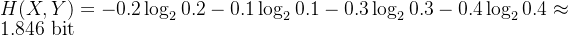

例子,假设一个离散信源输出符号集合为 {a, b, c},其概率分布为 P(a) = 0.5, P(b) = 0.3, P(c) = 0.2。对于上述信源,其信息熵为:

四、联合熵

4.1 联合熵

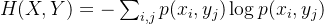

联合熵用于衡量两个或多个信源联合输出的不确定性。对于两个离散信源 X 和 Y,其联合熵定义为:

例子:假设信源 X 和 Y 的联合概率分布如下:

| X \ Y | y1 | y2 |

|---|---|---|

| x1 | 0.2 | 0.1 |

| x2 | 0.3 | 0.4 |

则联合熵为:

思考题

给定一个离散无记忆信源 X,其符号集合为 X={0,1,2},对应的概率分布为:

p(0)=0.2,p(1)=0.4,p(2)=0.4

信源发出的消息为 0012010210。需要解决以下问题:

- 上述消息所携带的信息量是多少?

- 上述消息平均每个符号所携带的信息量是多少?

- 该信源平均每个符号所携带的信息量是多少?

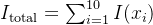

消息 0012010210 的长度为 10 个符号。每个符号的信息量可以通过自信息公式计算。得到消息的总信息量,消息长度为 10 个符号。可计算平均每个符号所携带的信息量。信源平均每个符号所携带的信息量即为信源的信息熵 H(X)。

消息所携带的信息量:

消息平均每个符号所携带的信息量:

信源平均每个符号所携带的信息量: