CV - 计算机视觉 | ML - 机器学习 | RL - 强化学习 | NLP 自然语言处理

Subjects: cs.CV

1.Towards In-context Scene Understanding

标题:迈向情境场景理解

作者:Ivana Balažević, David Steiner, Nikhil Parthasarathy, Relja Arandjelović, Olivier J. Hénaff

文章链接:https://arxiv.org/abs/2306.01667

摘要:

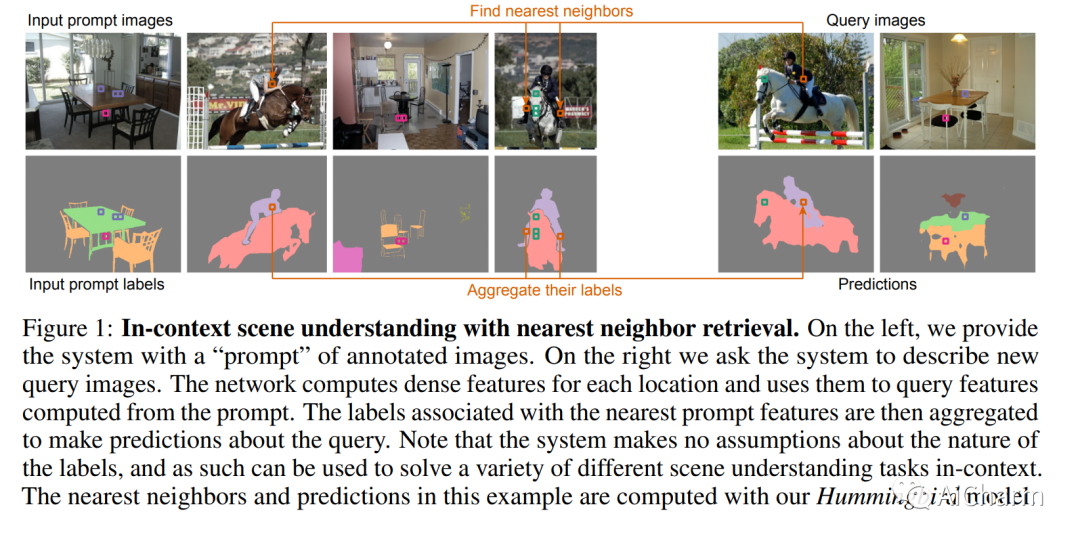

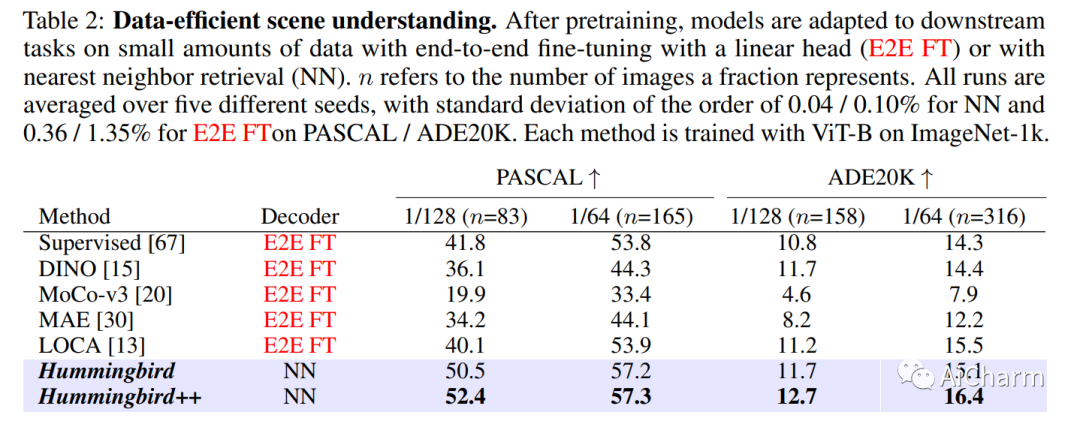

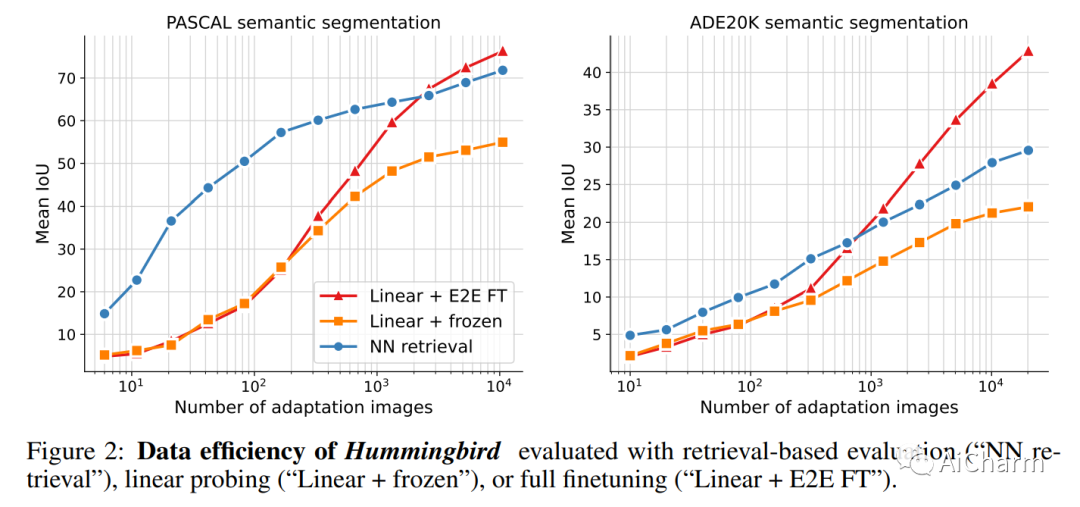

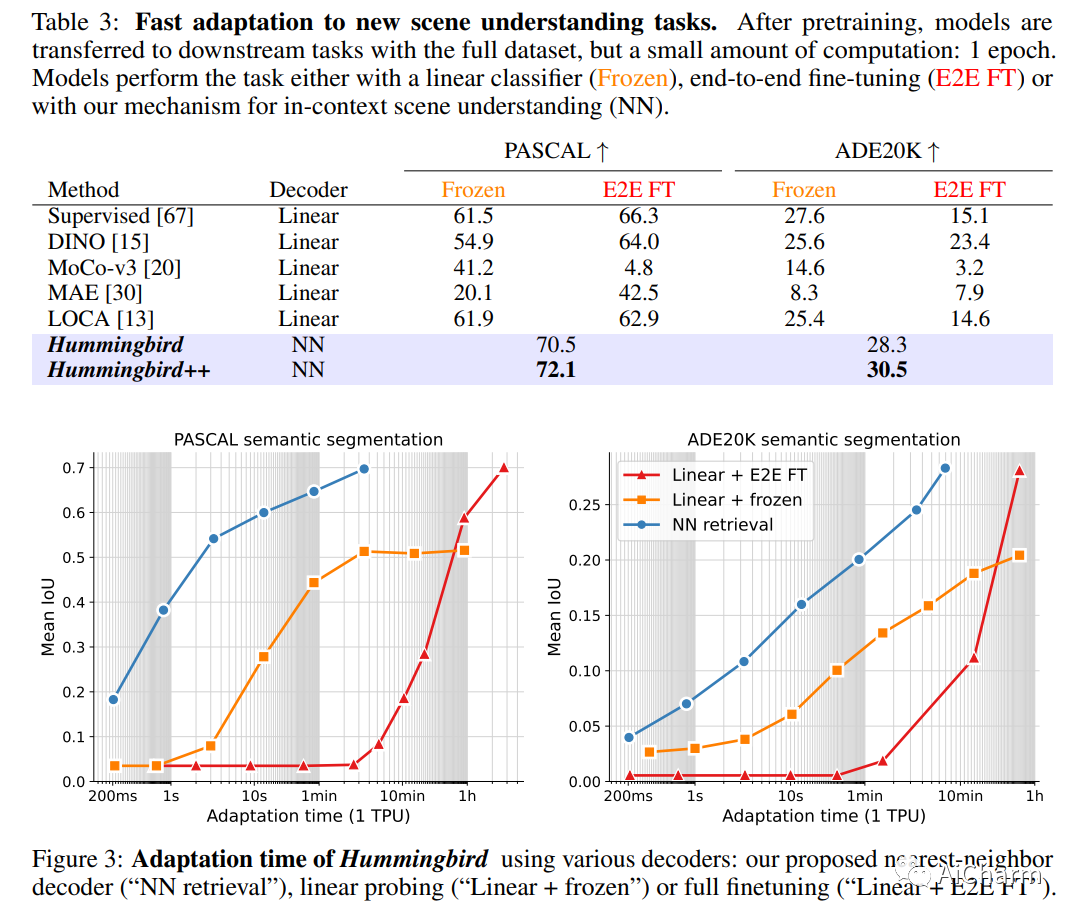

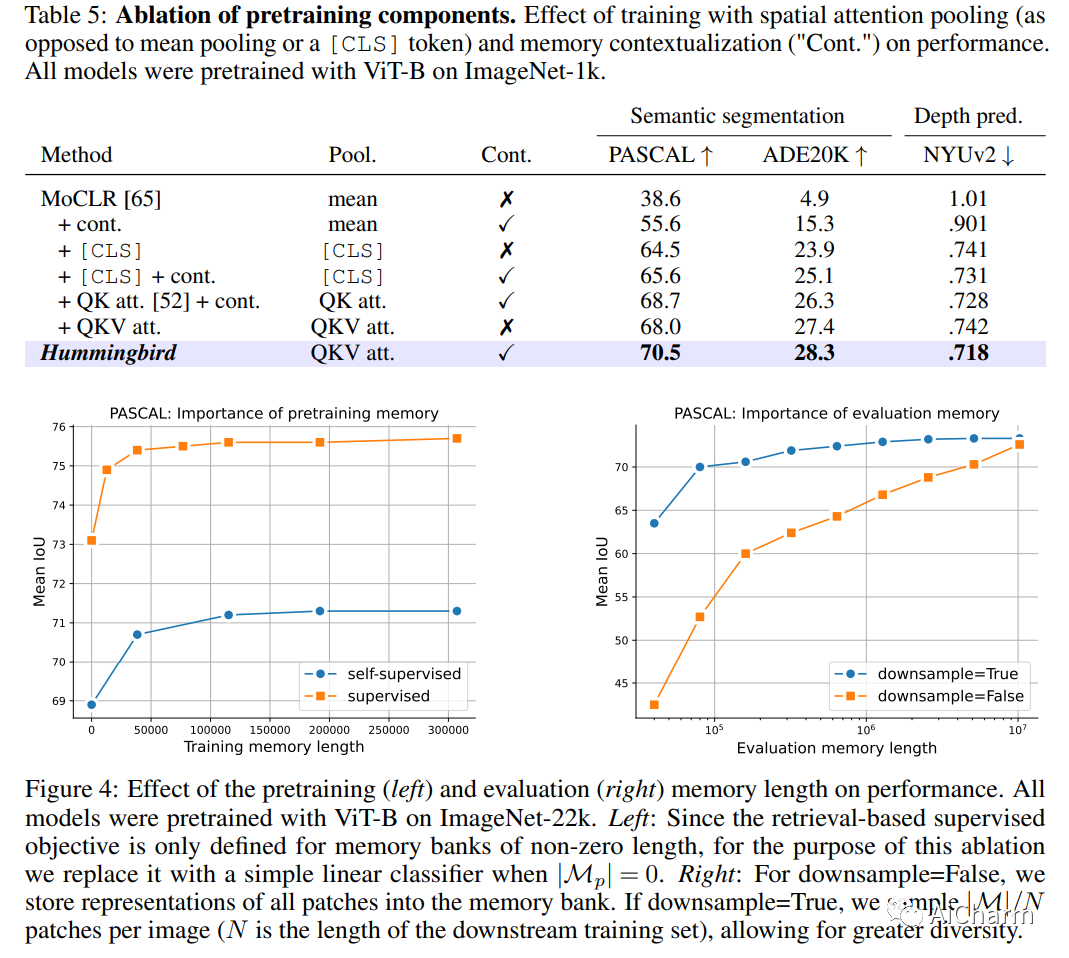

上下文学习 – 使用不同提示配置模型行为的能力 – 已经彻底改变了自然语言处理领域,减轻了对特定任务模型的需求,并为能够协助任何查询的通才模型铺平了道路.相比之下,计算机视觉在很大程度上停留在前一种状态:通常需要专门的解码器和微调协议来执行语义分割和深度估计等密集任务。在这项工作中,我们探索了一种用于在上下文中学习此类场景理解任务的简单机制:从注释特征的提示中检索最近邻。我们提出了一种新的预训练协议 – 利用图像内和图像之间的注意力 – ,它产生的表示在这种情况下特别有用。由此产生的蜂鸟模型,在适当的提示下,无需修改即可执行各种场景理解任务,同时接近针对每项任务进行微调的专家的表现。此外,Hummingbird 可以配置为比微调模型更有效地执行新任务,从而提高了在交互式助手机制中理解场景的可能性。

2.BOOT: Data-free Distillation of Denoising Diffusion Models with Bootstrapping

标题:BOOT:使用 Bootstrapping 的去噪扩散模型的无数据蒸馏

作者:Jiatao Gu, Shuangfei Zhai, Yizhe Zhang, Lingjie Liu, Josh Susskind

文章链接:https://arxiv.org/abs/2306.05544

项目代码:https://github.com/princeton-nlp/TransformerPrograms

摘要:

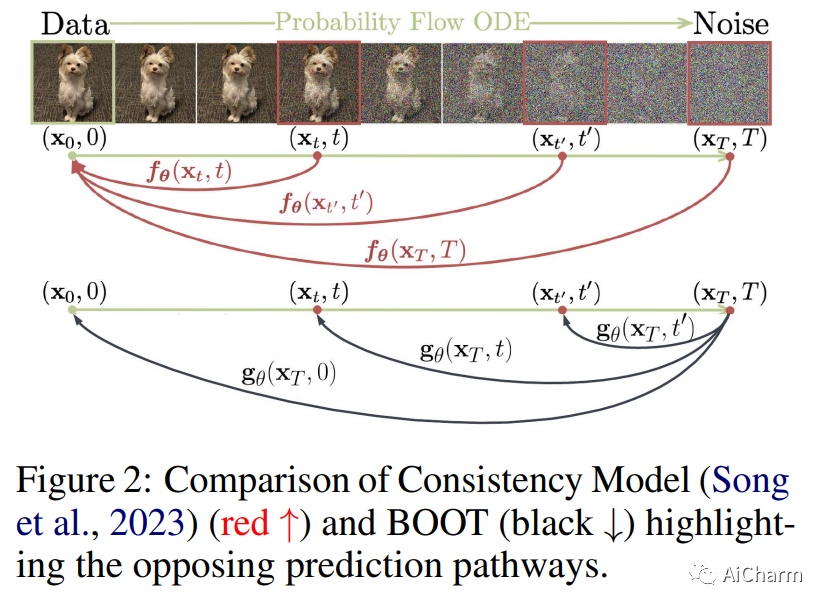

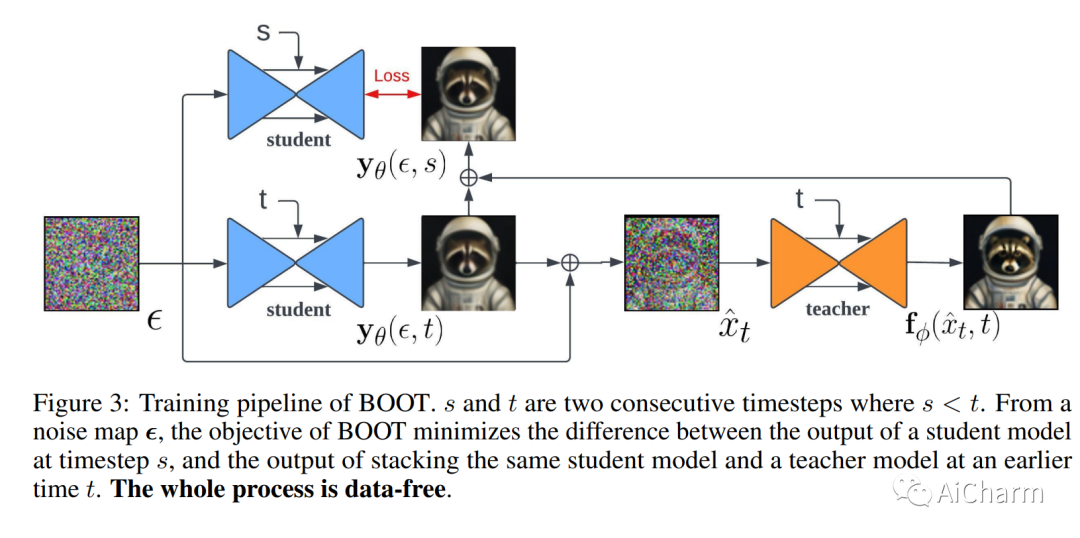

扩散模型已经证明了生成不同图像的巨大潜力。然而,由于迭代去噪,它们的性能通常会受到缓慢生成的影响。最近提出了知识蒸馏作为一种补救措施,可以将推理步骤的数量减少到一个或几个,而不会显着降低质量。然而,现有的蒸馏方法要么需要大量的离线计算来从教师模型生成合成训练数据,要么需要在真实数据的帮助下进行昂贵的在线学习。在这项工作中,我们提出了一种称为 BOOT 的新技术,它通过一种有效的无数据蒸馏算法克服了这些限制。核心思想是学习一个时间条件模型,该模型预测给定任何时间步长的预训练扩散模型教师的输出。可以基于来自两个连续采样步骤的自举来有效地训练这样的模型。此外,我们的方法可以很容易地适应大规模的文本到图像扩散模型,鉴于训练集通常很大且难以访问,这对传统方法来说具有挑战性。我们在 DDIM 设置中展示了我们的方法在几个基准数据集上的有效性,实现了可比的生成质量,同时比扩散教师快几个数量级。文本到图像的结果表明,所提出的方法能够处理高度复杂的分布,揭示了更有效的生成建模。

3.Learning Transformer Programs

标题:学习变压器程序

作者:Dan Friedman, Alexander Wettig, Danqi Chen

文章链接:https://arxiv.org/abs/2306.01128

摘要:

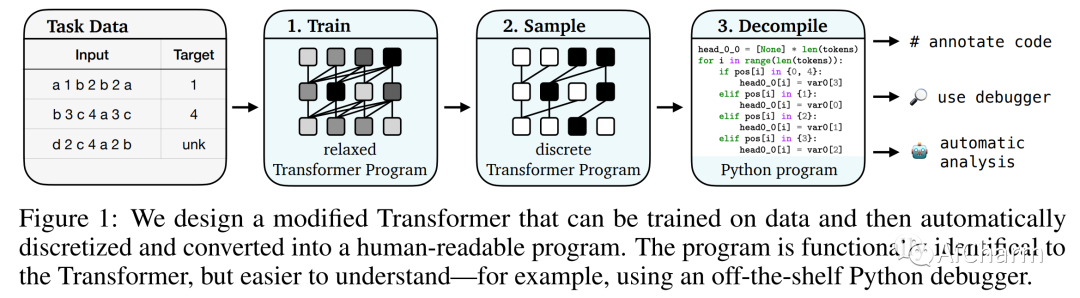

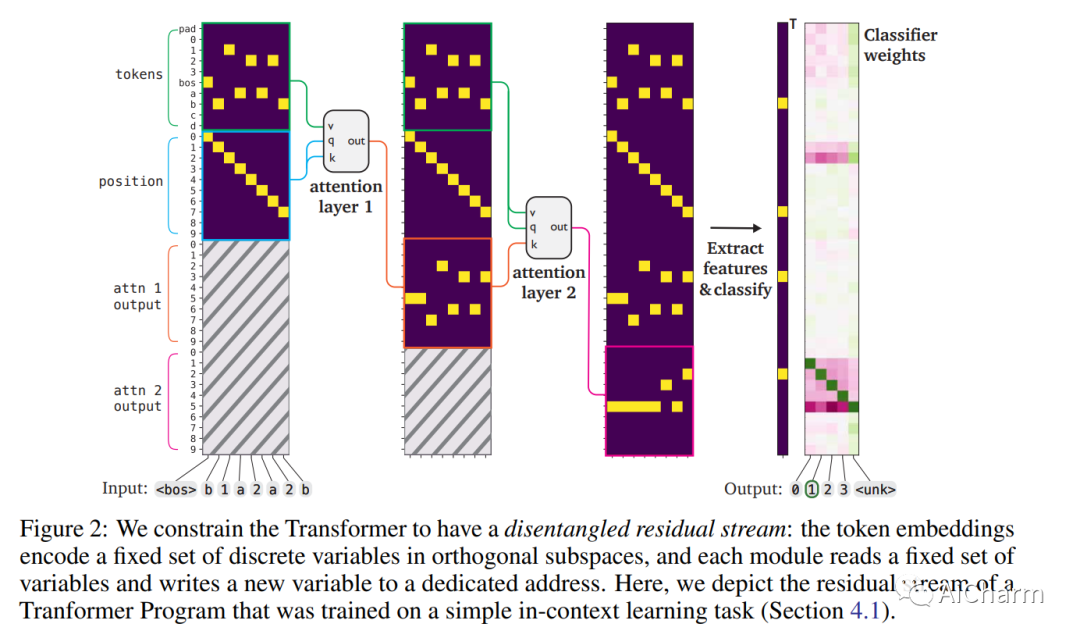

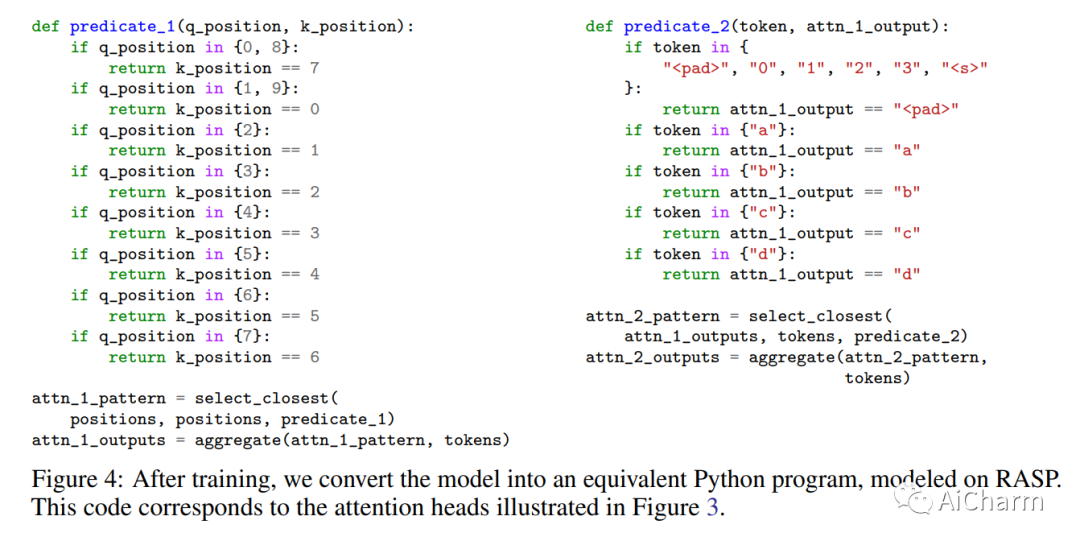

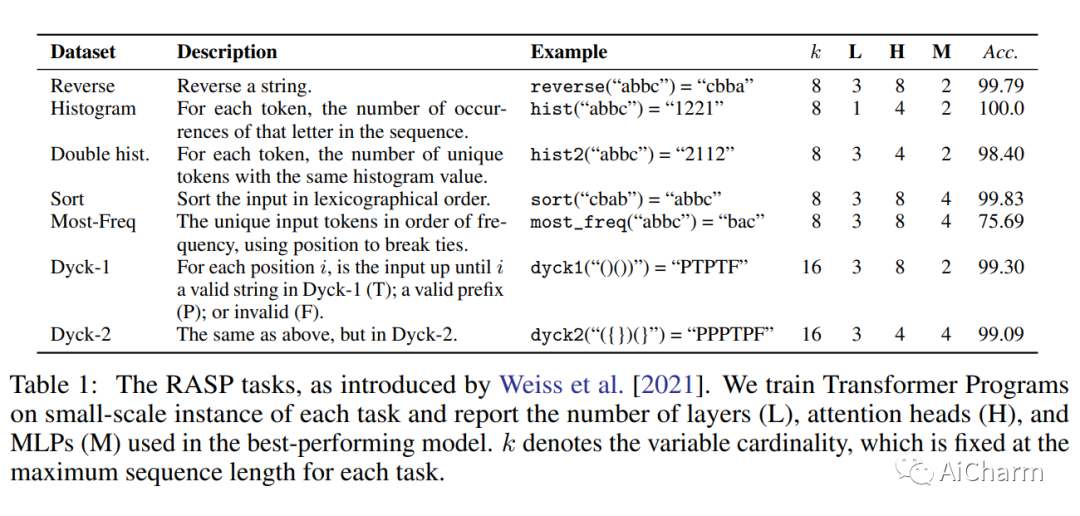

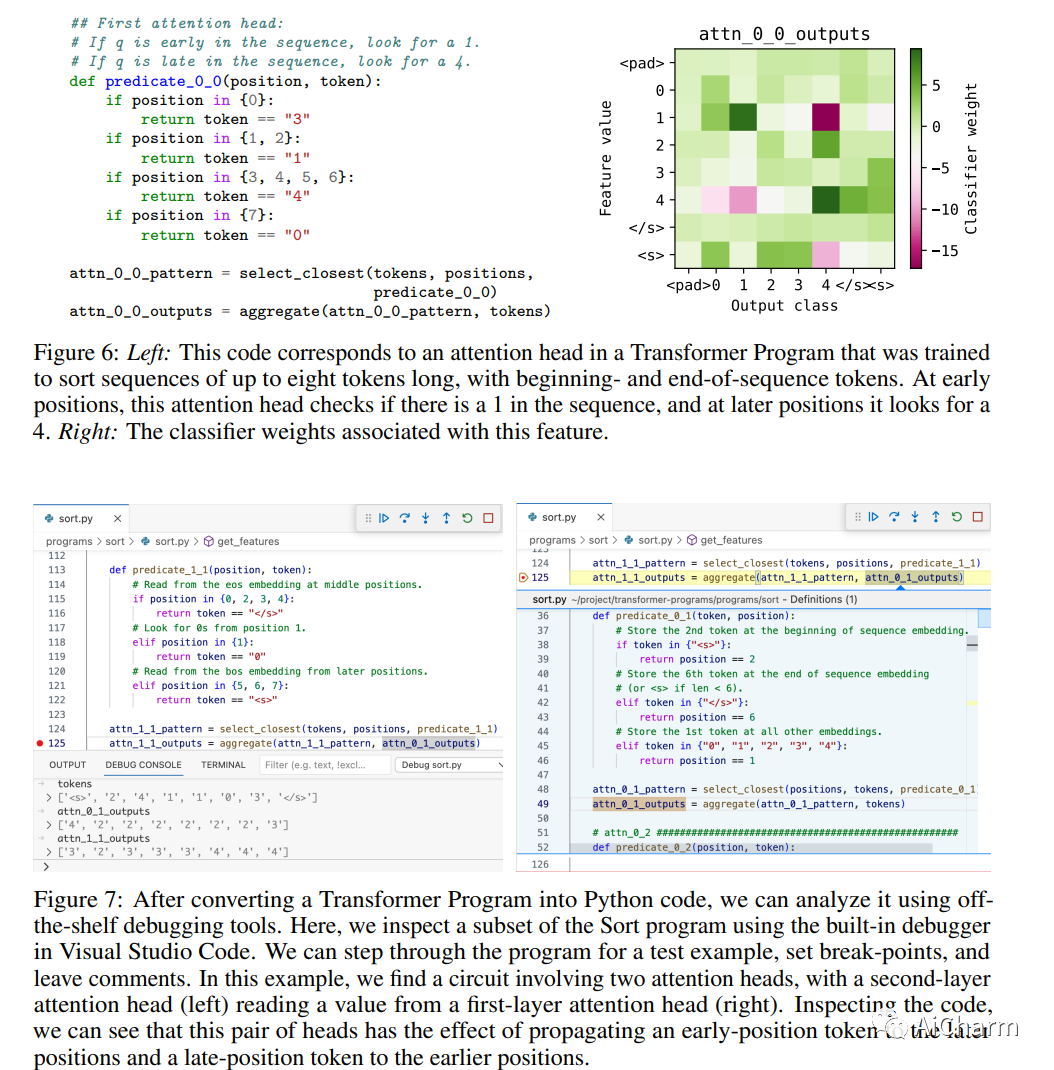

最近关于机械可解释性的研究试图通过仔细检查网络权重和激活来对 Transformer 模型进行逆向工程。然而,这些方法需要大量的人工工作,并且仍然无法提供对底层算法的完整、忠实的描述。在这项工作中,我们介绍了一种训练 Transformer 的程序,该程序可通过设计进行机械解释。我们以 RASP [Weiss et al., 2021] 为基础,这是一种可以编译成 Transformer 权重的编程语言。我们设计了一个改进的 Transformer,而不是将人类编写的程序编译成 Transformers,它可以使用基于梯度的优化进行训练,然后自动转换为离散的、人类可读的程序。我们将这些模型称为 Transformer Programs。为了验证我们的方法,我们针对各种问题学习了 Transformer Programs,包括上下文学习任务、一套算法问题(例如排序、识别 Dyck 语言)以及包括命名实体识别和文本分类在内的 NLP 任务。Transformer Programs 可以自动找到合理的解决方案,性能与可比大小的标准 Transformer 相当;更重要的是,它们易于解读。为了展示这些优势,我们将 Transformers 转换为 Python 程序,并使用现成的代码分析工具来调试模型错误并识别用于解决不同子问题的“电路”。我们希望 Transformer Programs 开辟一条通往本质可解释机器学习目标的新道路。

更多Ai资讯:公主号AiCharm