一、环境准备

准备三台虚拟机:

192.168.44.128

192.168.44.129

192.168.44.130

设置三台主机域名映射

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.44.128 spark1

192.168.44.129 spark2

192.168.44.130 spark3

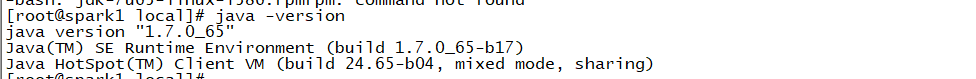

二、安装JDK

将三台虚拟机上分别安装JDK

1、通过winscp将jdk-7u65-linux-i586.rpm上传至/usr/local/目录

2、安装jdk : rpm -ivh jdk-7u65-linux-i586.rpm

3、配置JDK环境变量

vi /etc/profile

export JAVA_HOME=/usr/java/latest

export PATH=

P

A

T

H

:

PATH:

PATH:JAVA_HOME/bin

环境变量生效: source /etc/profile

4、测试是否安装成功:java -version

三、配置集群ssh免密码登录

1、首先在三台机器上配置对本机的ssh免密码登录

生成本机的公钥,过程中不断敲回车即可,ssh-keygen命令默认会将公钥放在/root/.ssh目录下

ssh-keygen -t rsa

将公钥复制为authorized_keys文件,此时使用ssh连接本机就不需要输入密码了

cd /root/.ssh

cp id_rsa.pub authorized_keys

2、接着配置三台机器互相之间的ssh免密码登录

使用ssh-copy-id -i ip命令将本机的公钥拷贝到指定机器的authorized_keys文件中

四、搭建hadoop集群

安装hadoop

1、将hadoop-2.4.1.tar.gz,使用WinSCP上传到/usr/local目录下

2、将hadoop解压:tar -zxvf hadoop-2.4.1.tar.gz

3、对Hadoop目录进行重命名: mv hadoop-2.4.1.tar.gz hadoop

4、配置hadoop环境变量

vi /etc/profile

export HADOOP_HOME=/usr/local/hadoop

export PATH=

H

A

D

O

O

P

H

O

M

E

/

b

i

n

:

HADOOP_HOME/bin:

HADOOPHOME/bin:HADOOP_HOME/sbin

source /etc/profile

修改hadoop配置文件

1、修改core-site.xml

<property>

<name>fs.default.name</name>

<value>hdfs://spark1:9000</value>

</property>

2、修改hdfs-site.xml

<!--配置namenode目录-->

<property>

<name>dfs.name.dir</name>

<value>/usr/local/data/namenode</value>

</property>

<!--配置datanode目录-->

<property>

<name>dfs.data.dir</name>

<value>/usr/local/data/datanode</value>

</property>

<!--配置临时文件目录-->

<property>

<name>dfs.tmp.dir</name>

<value>/usr/local/data/tmp</value>

</property>

<!--设置hdfs副本数量-->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

3、修改yarn-site.xml

<property>

<name>yarn.resourcemanager.hostname</name>

<value>spark1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

4、修改slaves文件

spark1

spark2

spark3

在另外两台机器上安装hadoop

1、使用如上配置在另外两台机器上搭建hadoop,可以使用scp命令将spark1上面的hadoop安装包和/etc/profile配置文件都拷贝过去。

2、要记得对/etc/profile文件进行source,以让它生效。

3、记得在spark2和spark3的/usr/local目录下创建data目录。

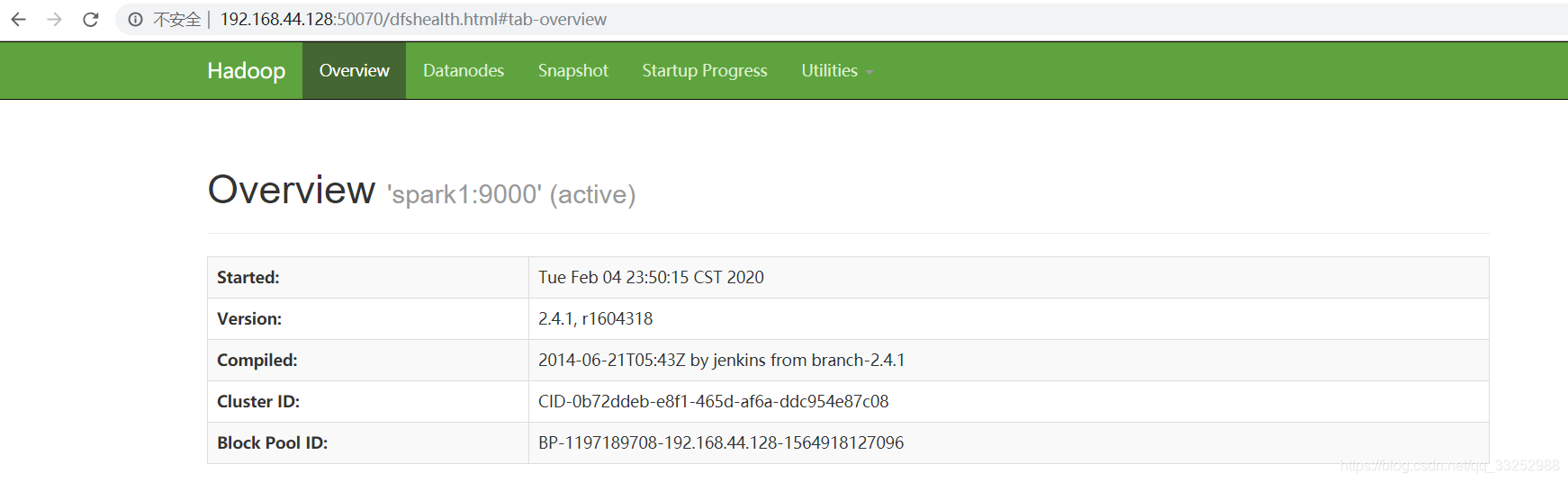

启动hdfs集群

1、格式化namenode:在spark1上执行以下命令,hdfs namenode -format

2、启动hdfs集群:start-dfs.sh

3、验证启动是否成功:jps、50070端口

spark1:namenode、datanode、secondarynamenode

spark2:datanode

spark3:datanode

启动yarn集群

1、启动yarn集群:start-yarn.sh

2、验证启动是否成功:jps、8088端口

spark1:resourcemanager、nodemanager

spark2:nodemanager

spark3:nodemanager