GitHub:

前言

上节我们爬完了所有索引页,这节我们开始爬取公众号文章。

要知道,我们之前爬的是 weixin.sogou.com ,而现在爬取的是 mp.weixin.qq.com ,这是两个完全不同的网站。

关于 mp.weixin.qq.com 的反爬,并不是很严厉,我们只需需要构造新的请求头。

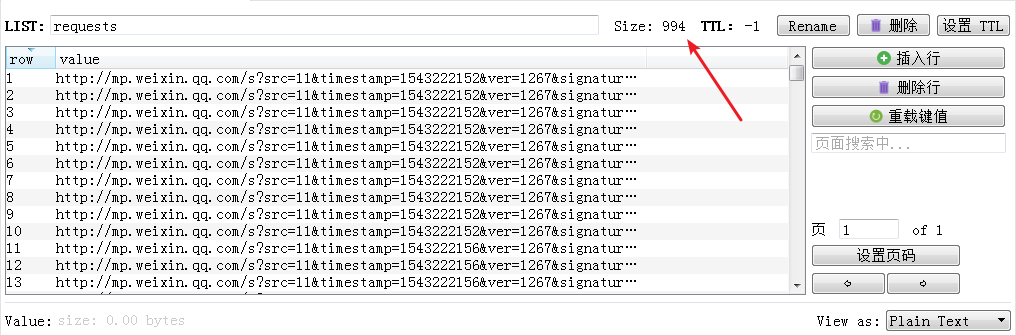

硬说有的话,那就是:首先,我们爬取的 requests 队列里的 URL 链接有时效性,争取在 12 小时内使用。

其次,注意到上面的链接,都是 http 开头,而正式请求时的链接都是 https 开头。这时我们要打开我们 GET 请求的重定向开关。

清洗代理

对,又要清洗代理,不要觉得这步很繁琐,这是提高我们爬虫体验极其关键的一步。

打开我们的代理池文件夹 proxypool ,找到里面的 setting.py ,

把 TEST_URL 改成 “https://mp.weixin.qq.com/”,

把 REDIS_KEY改成 “weixinproxies”。

爬取微信公众号文章

在运行代理池后,我们积累足够多能爬取 mp.weixin.qq.com的健康代理。

在上节提到的 db.py 文件中,加入 weixin_proxy_random() 和 weixin_proxy_decrease() 两个函数。

目的是,便于提取 ”weixinproxies“里的代理。

db.py

import redis

from random import choice

from weixin.error import PoolEmptyError

# Redis数据库地址

REDIS_HOST = 'localhost'

# Redis端口

REDIS_PORT = 6379

# Redis密码,如无填None

REDIS_PASSWORD = None

WEIXIN_PROXY_REDIS_KEY = 'weixinproxies'

#最大评分

MAX_SCORE = 100

MIN_SCORE = 0

class RedisClient(object):

def __init__(self, host=REDIS_HOST, port=REDIS_PORT, password=REDIS_PASSWORD):

"""

初始化

:param host: Redis 地址

:param port: Redis 端口

:param password: Redis密码

"""

self.db = redis.StrictRedis(host=host, port=port, password=password, decode_responses=True)

def weixin_proxy_random(self):

"""

随机获取有效代理,首先尝试获取最高分数代理,如果不存在,按照排名获取,否则异常

:return: 随机代理

"""

result = self.db.zrangebyscore(WEIXIN_PROXY_REDIS_KEY, MAX_SCORE, MAX_SCORE)

if len(result):

return choice(result)

else:

result = self.db.zrevrange(WEIXIN_PROXY_REDIS_KEY, 0, 100)

if len(result):

return choice(result)

else:

raise PoolEmptyError

def weixin_proxy_decrease(</