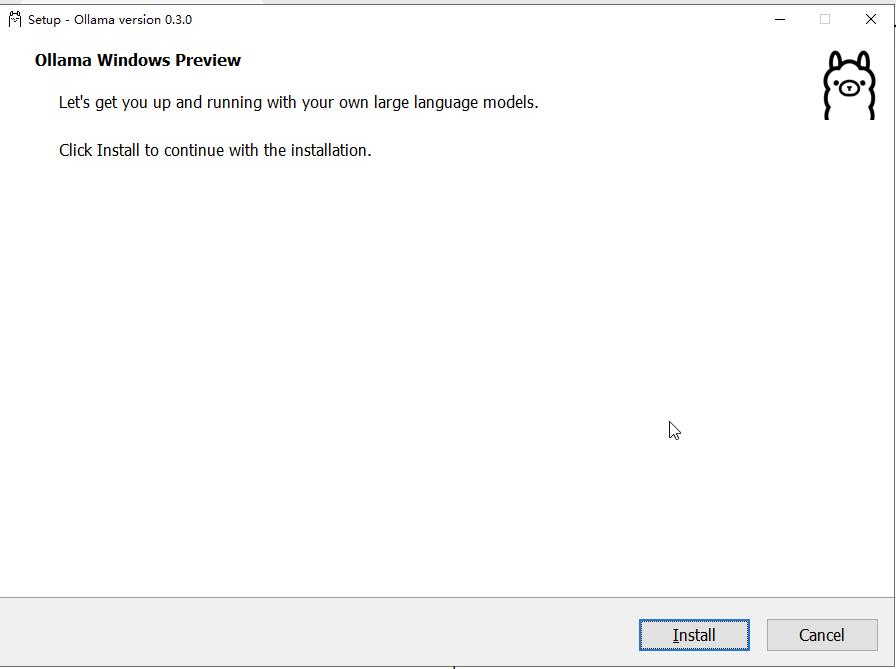

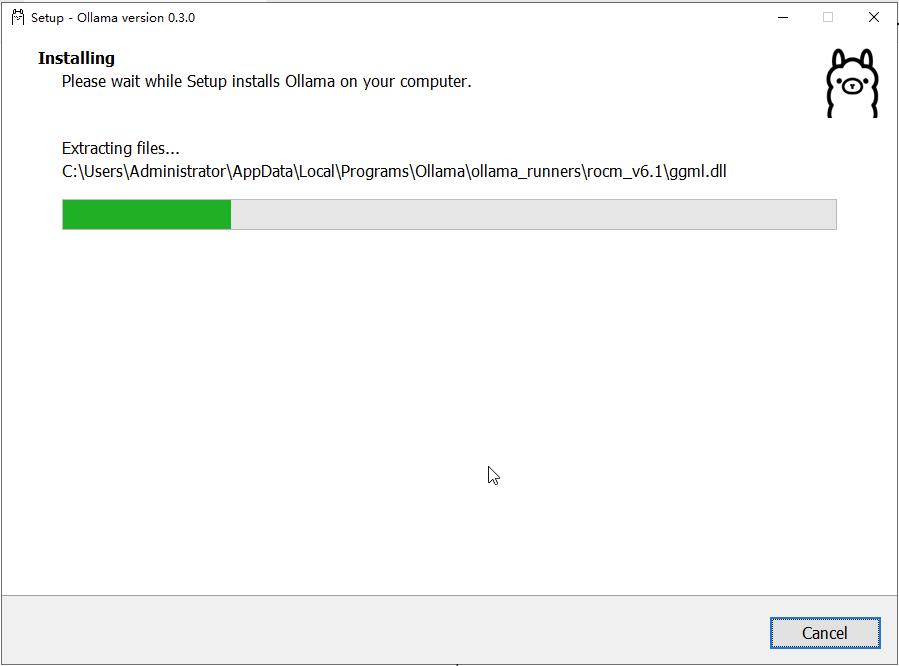

安装 Ollama 客户端

· 如果您有科学上网环境,最好从官方下载地址下载,保证最新版本。 如果没有,您可以从临时下载地址下载。

· 安装完毕会自动运行,右下角可以看到这个图标:

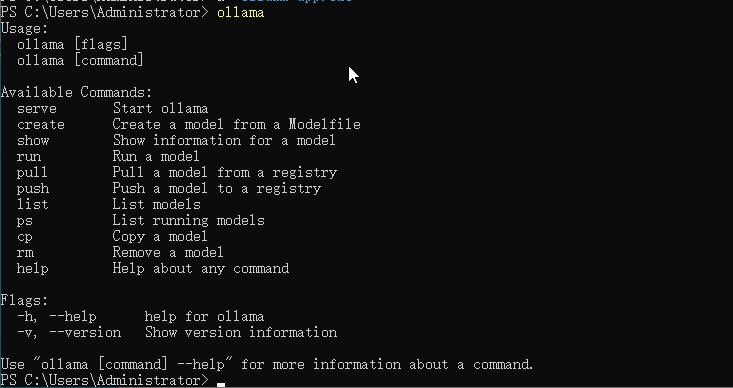

· 打开 windows powershell 或 CMD 命令行终端,输入 ollama 命令,回车,即可显示 ollama 命令的使用帮助

ollama测试:

ollama安装完需要测试是否安装成功(不需要主动去设置环境变量)

ollama --version

ollama -v

1.2.2.出现版本号就是安装ollama成功了

ollama使用:

只介绍几个能在部署过程中可能运用到的命令(ollama)

版本查看

ollama -v

ollama --version

模型查看

ollama list

模型运行

ollama run <模型名称>

模型删除

ollama rm <模型名称>下载模型文件

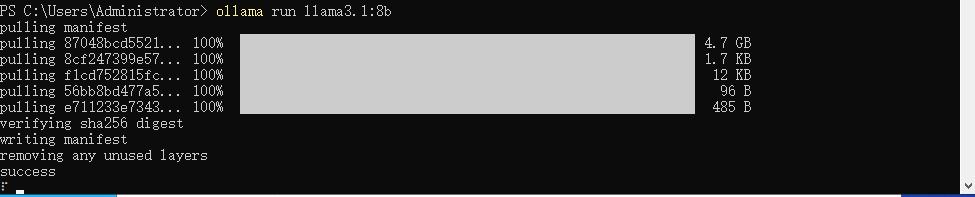

加载模型

· 由于 A10 GPU 只有 24G 显存,因此我们安装 8b 模型版本,如果您的显存 80G 以上,那么推荐安装 70b 模型版本。

在命令行中输入如下命令,即可在线拉取模型。

ollama run llama3.1:8b

如果您的显卡非常好,其他两个模型的拉取命令如下 :

ollama run llama3.1:70b

ollama run llama3.1:405b

· 出现success提示时,说明模型加载完成,可以愉快地跟大模型交流了。

更多模型支持

当然 ollama 不仅支持运行 llama3.1,实际上他支持更多的开源模型,详细教程见官方文档:模型库

目前最火的模型 Deekseep

安装deekseep模型

1.在线安装deekseep模型

1.下载 deekseep 模型:

deekseep提供了许多中类型的模型,有大有小,具体的选择需要根据你的硬件的性能,其中1.5b模型最小,70b模型最大

# 选择其中一条命名运行就行

ollama run deepseek-r1:1.5b

ollama run deepseek-r1:7b

ollama run deepseek-r1:8b

ollama run deepseek-r1:14b

ollama run deepseek-r1:32b

ollama run deepseek-r1:70b手动导入模型

如果您的网络情况不太好,在线下载模型进度缓存,官方也支持从其他渠道下载好的模型导入。

详细参考导入模型,这里不做赘述。

模型应用

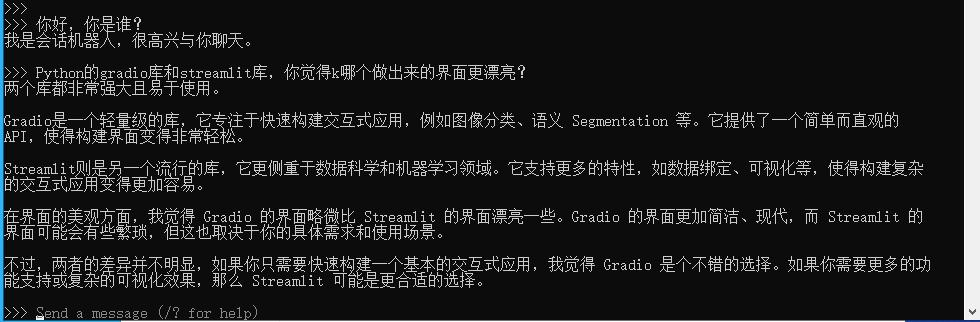

直接在控制台中对话

模型加载完成之后,出现如下提示,就可以直接跟大模型对话了。

配置远程访问

Ollama 启动的默认地址为http://127.0.0.1:11434,我们通过设置环境变量 OLLAMA_HOST来修改默认监听地址和端口,这往往对我们需要远程调用API时非常有用。同时,如果要在open-webui等UI面板中调用 API ,需要为 Ollama 进行跨域配置后方可正常使用。

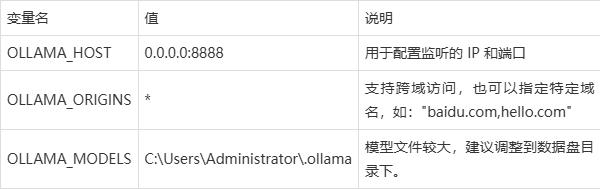

需要了解如下三个变量的用途

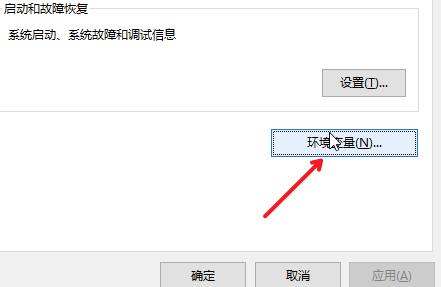

windows 修改环境变量如下:

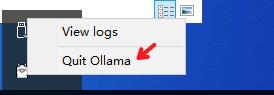

1. 停止 ollama 服务

右下角这个图标,右键选择退出 。

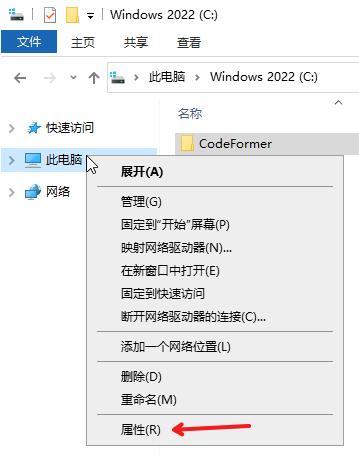

1. 设置环境变量

右键"此电脑 > 属性 > 高级系统设置 > 环境变量 > Administrator 的用户变量 > 新建用户变量"。

设置环境变量,表示监听在0.0.0.0:8888上,其他变量设置依次添加。

1. 设置完毕环境变量,打开新的 powershell 或者 CMD 命令行终端, 重新启动 ollama 服务并加载模型。

ollama run llama3.1:8b

API 调用

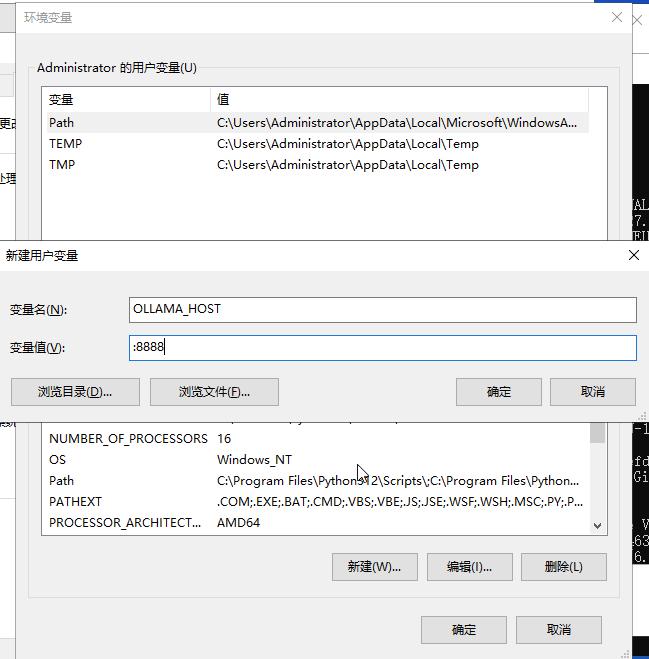

开启远程连接之后,您就可以远程调用 API 了,示例如下:

curl http://106.12.151.249:8888/api/generate -d '{

"model": "llama3.1:8b",

"prompt": "你好啊"

}'

流式输出:

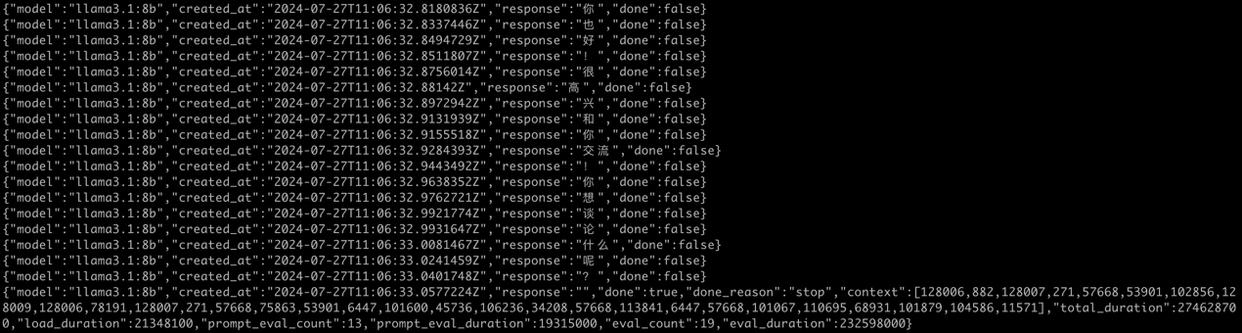

Web UI

上面的对话测试,我们都是通过命令行来进行交互的,当然肯定有可视化的 UI 界面,而且很多,这里介绍两个。

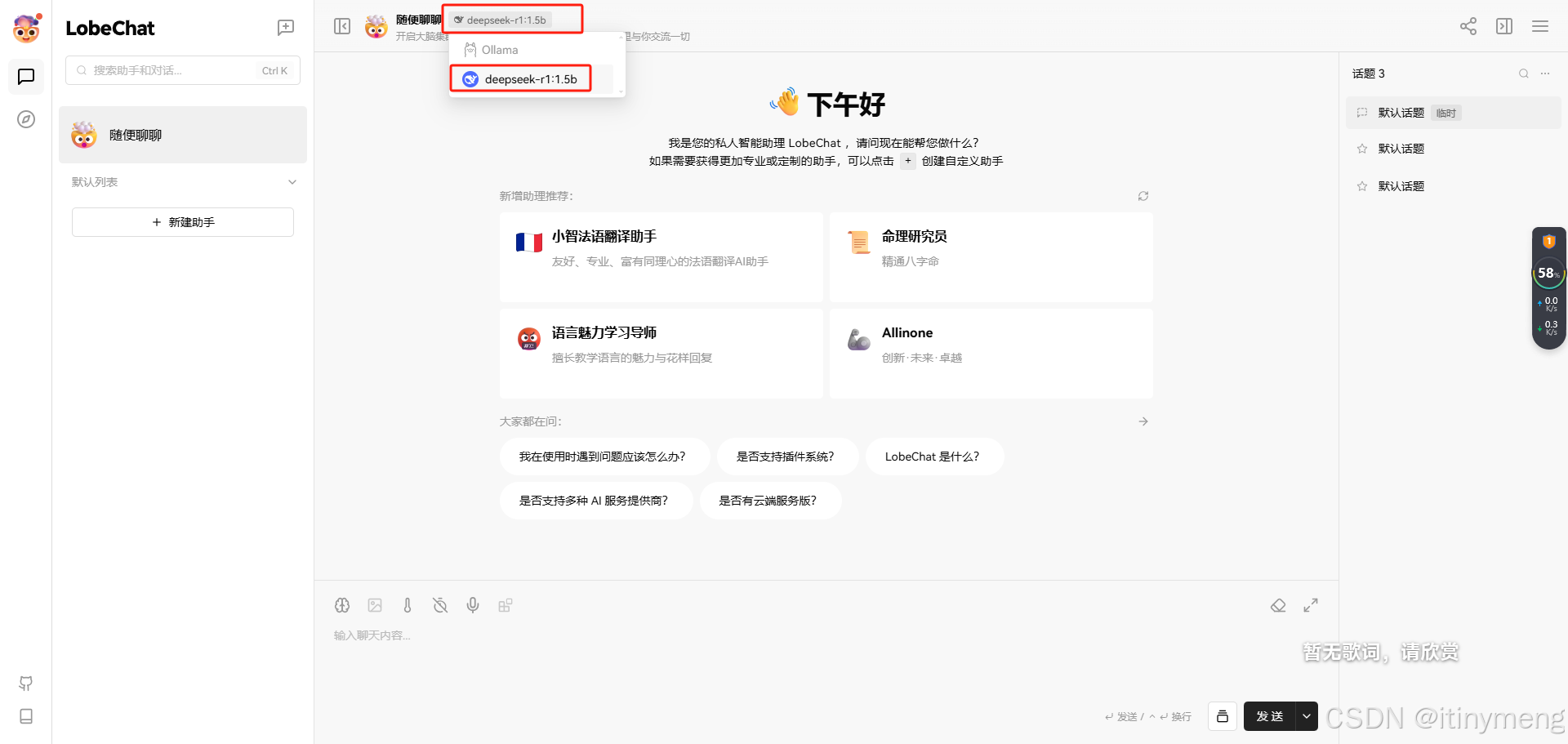

LobeChat: Personal LLM Productivity ... · LobeChat

这样就配置好了