前言

提示:本文是YOLOv12训练自己数据集的记录教程,需要大家在本地已配置好CUDA,cuDNN等环境,没配置的小伙伴可以查看我的往期博客:在Windows10上配置CUDA环境教程

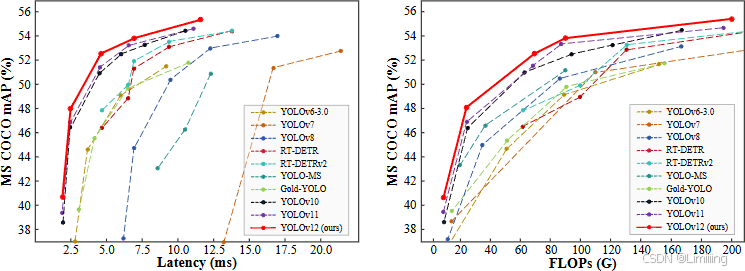

YOLOv12是YOLO系列最新发布的计算机视觉模型。

论文: https://arxiv.org/pdf/2502.12524

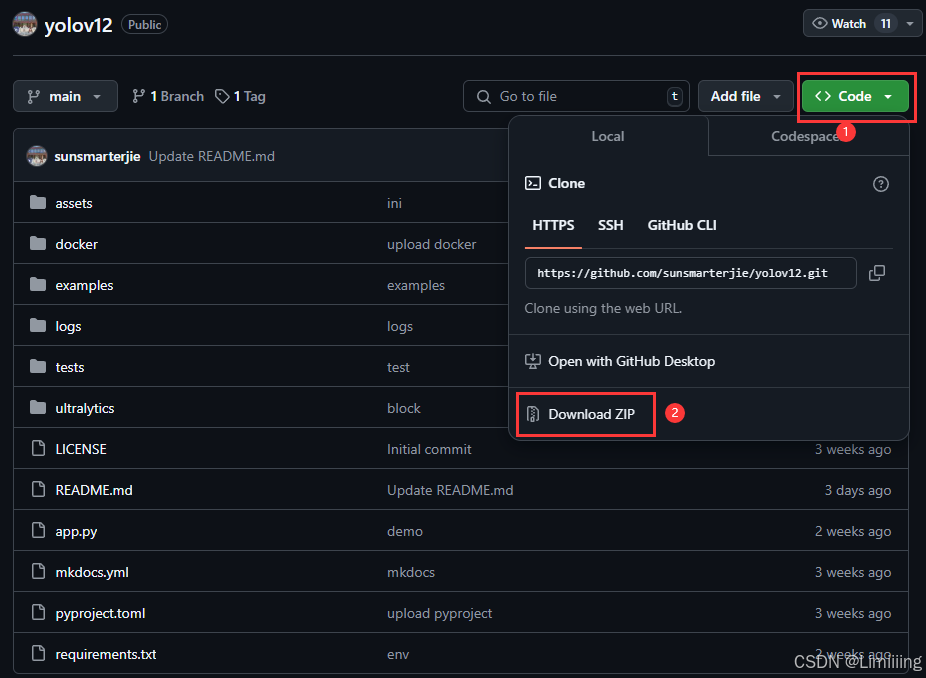

源码: https://github.com/sunsmarterjie/yolov12

一、YOLOv12模型结构图

二、环境搭建

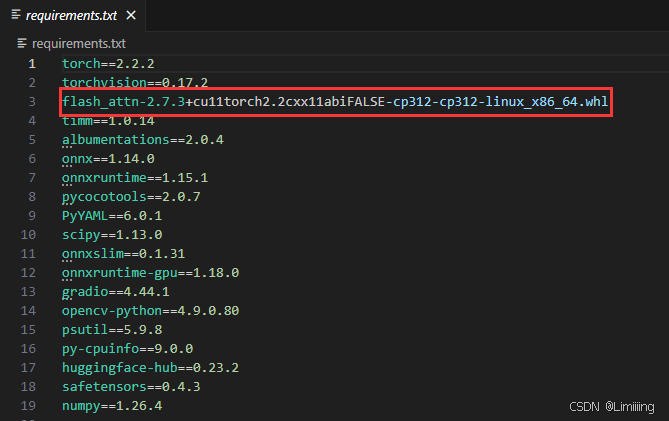

在配置好CUDA环境,并且获取到YOLOv12源码后,建议新建一个虚拟环境专门用于YOLOv12模型的训练。将YOLOv12加载到环境后,安装剩余的包。项目中的requirements.txt中包含了运行所需的包和版本,利用以下命令批量安装:

pip install -r requirements.txt

其中flash-attn包的安装请查看连接: https://blog.csdn.net/qq_42591591/article/details/145930647

三、构建数据集

YOLOv12模型的训练需要原图像及对应的YOLO格式标签,还未制作标签的可以参考我这篇文章:LabelImg安装与使用教程。

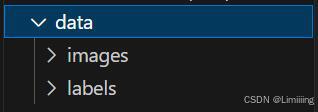

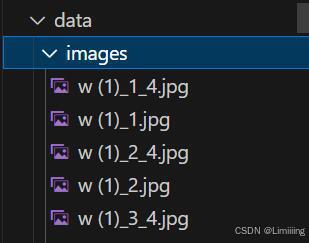

我的原始数据存放在根目录的data文件夹(新建的)下,里面包含图像和标签。

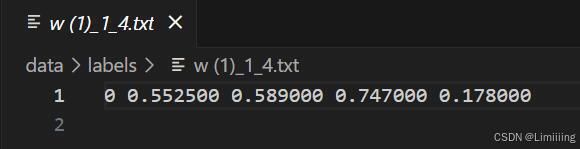

标签内的格式如下:

具体格式为 class_id x y w h,分别代表物体类别,标记框中心点的横纵坐标(x, y),标记框宽高的大小(w, h),且都是归一化后的值,图片左上角为坐标原点。

将原本数据集按照8:1:1的比例划分成训练集、验证集和测试集三类,划分代码如下。

# 将图片和标注数据按比例切分为 训练集和测试集

import shutil

import random

import os

# 原始路径

image_original_path = "data/images/"

label_original_path = "data/labels/"

cur_path = os.getcwd()

# 训练集路径

train_image_path = os.path.join(cur_path, "datasets/images/train/")

train_label_path = os.path.join(cur_path, "datasets/labels/train/")

# 验证集路径

val_image_path = os.path.join(cur_path, "datasets/images/val/")

val_label_path = os.path.join(cur_path, "datasets/labels/val/")

# 测试集路径

test_image_path = os.path.join(cur_path, "datasets/images/test/")

test_label_path = os.path.join(cur_path, "datasets/labels/test/")

# 训练集目录

list_train = os.path.join(cur_path, "datasets/train.txt")

list_val = os.path.join(cur_path, "datasets/val.txt")

list_test = os.path.join(cur_path, "datasets/test.txt")

train_percent = 0.8

val_percent = 0.1

test_percent = 0.1

def del_file(path):

for i in os.listdir(path):

file_data = path + "\\" + i

os.remove(file_data)

def mkdir():

if not os.path.exists(train_image_path):

os.makedirs(train_image_path)

else:

del_file(train_image_path)

if not os.path.exists(train_label_path):

os.makedirs(train_label_path)

else:

del_file(train_label_path)

if not os.path.exists(val_image_path):

os.makedirs(val_image_path)

else:

del_file(val_image_path)

if not os.path.exists(val_label_path):

os.makedirs(val_label_path)

else:

del_file(val_label_path)

if not os.path.exists(test_image_path):

os.makedirs(test_image_path)

else:

del_file(test_image_path)

if not os.path.exists(test_label_path):

os.makedirs(test_label_path)

else:

del_file(test_label_path)

def clearfile():

if os.path.exists(list_train):

os.remove(list_train)

if os.path.exists(list_val):

os.remove(list_val)

if os.path.exists(list_test):

os.remove(list_test)

def main():

mkdir()

clearfile()

file_train = open(list_train, 'w')

file_val = open(list_val, 'w')

file_test = open(list_test, 'w')

total_txt = os.listdir(label_original_path)

num_txt = len(total_txt)

list_all_txt = range(num_txt)

num_train = int(num_txt * train_percent)

num_val = int(num_txt * val_percent)

num_test = num_txt - num_train - num_val

train = random.sample(list_all_txt, num_train)

# train从list_all_txt取出num_train个元素

# 所以list_all_txt列表只剩下了这些元素

val_test = [i for i in list_all_txt if not i in train]

# 再从val_test取出num_val个元素,val_test剩下的元素就是test

val = random.sample(val_test, num_val)

print("训练集数目:{}, 验证集数目:{}, 测试集数目:{}".format(len(train), len(val), len(val_test) - len(val)))

for i in list_all_txt:

name = total_txt[i][:-4]

srcImage = image_original_path + name + '.jpg'

srcLabel = label_original_path + name + ".txt"

if i in train:

dst_train_Image = train_image_path + name + '.jpg'

dst_train_Label = train_label_path + name + '.txt'

shutil.copyfile(srcImage, dst_train_Image)

shutil.copyfile(srcLabel, dst_train_Label)

file_train.write(dst_train_Image + '\n')

elif i in val:

dst_val_Image = val_image_path + name + '.jpg'

dst_val_Label = val_label_path + name + '.txt'

shutil.copyfile(srcImage, dst_val_Image)

shutil.copyfile(srcLabel, dst_val_Label)

file_val.write(dst_val_Image + '\n')

else:

dst_test_Image = test_image_path + name + '.jpg'

dst_test_Label = test_label_path + name + '.txt'

shutil.copyfile(srcImage, dst_test_Image)

shutil.copyfile(srcLabel, dst_test_Label)

file_test.write(dst_test_Image + '\n')

file_train.close()

file_val.close()

file_test.close()

if __name__ == "__main__":

main()

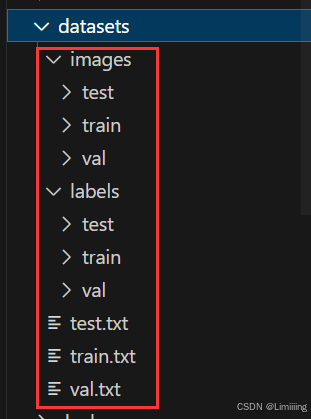

划分完成后将会在datasets文件夹下生成划分好的文件,其中images为划分后的图像文件,里面包含用于train、val、test的图像,已经划分完成;labels文件夹中包含划分后的标签文件,已经划分完成,里面包含用于train、val、test的标签;train.tet、val.txt、test.txt中记录了各自的图像路径。

在训练过程中,也是主要使用这三个txt文件进行数据的索引。

四、修改配置文件

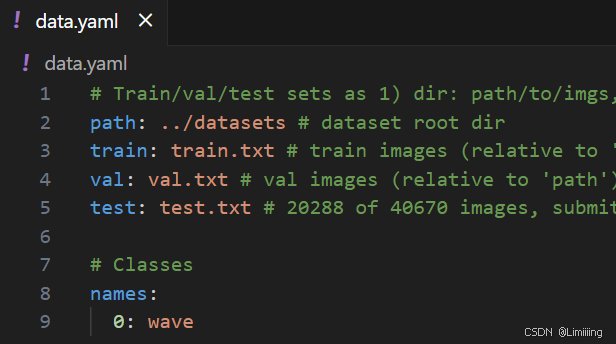

①数据集文件配置

数据集划分完成后,在根目录文件夹下新建data.yaml文件。用于指明数据集路径和类别,我这边只有一个类别,只留了一个,多类别的在name内加上类别名即可。data.yaml中的内容为:

path: ../datasets # 数据集所在路径 也可使用绝对路径

train: train.txt # 数据集路径下的train.txt

val: val.txt # 数据集路径下的val.txt

test: test.txt # 数据集路径下的test.txt

# Classes

names:

0: wave

直接将路径定位到datasets/images下的train、val、test文件夹也是可以的。 例如:

path: ../datasets/images # 数据集所在路径

train: train # 数据集路径下的train.txt

val: val # 数据集路径下的val.txt

test: test # 数据集路径下的test.txt

# Classes

names:

0: wave

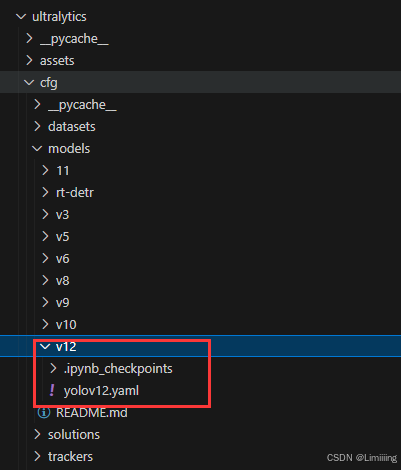

②模型文件配置

在ultralytics/cfg/models/v12文件夹下存放的是YOLOv12的各个版本的模型配置文件。初次训练的只需要将模型路径定位到此处即可,具体可继续查看后续配置

# YOLOv12 🚀, AGPL-3.0 license

# YOLOv12 object detection model with P3-P5 outputs. For Usage examples see https://docs.ultralytics.com/tasks/detect

# Parameters

nc: 80 # number of classes

scales: # model compound scaling constants, i.e. 'model=yolov12n.yaml' will call yolov12.yaml with scale 'n'

# [depth, width, max_channels]

n: [0.50, 0.25, 1024] # summary: 465 layers, 2,603,056 parameters, 2,603,040 gradients, 6.7 GFLOPs

s: [0.50, 0.50, 1024] # summary: 465 layers, 9,285,632 parameters, 9,285,616 gradients, 21.7 GFLOPs

m: [0.50, 1.00, 512] # summary: 501 layers, 20,201,216 parameters, 20,201,200 gradients, 68.1 GFLOPs

l: [1.00, 1.00, 512] # summary: 831 layers, 26,454,880 parameters, 26,454,864 gradients, 89.7 GFLOPs

x: [1.00, 1.50, 512] # summary: 831 layers, 59,216,928 parameters, 59,216,912 gradients, 200.3 GFLOPs

# YOLO12n backbone

backbone:

# [from, repeats, module, args]

- [-1, 1, Conv, [64, 3, 2]] # 0-P1/2

- [-1, 1, Conv, [128, 3, 2]] # 1-P2/4

- [-1, 2, C3k2, [256, False, 0.25]]

- [-1, 1, Conv, [256, 3, 2]] # 3-P3/8

- [-1, 2, C3k2, [512, False, 0.25]]

- [-1, 1, Conv, [512, 3, 2]] # 5-P4/16

- [-1, 4, A2C2f, [512, True, 4]]

- [-1, 1, Conv, [1024, 3, 2]] # 7-P5/32

- [-1, 4, A2C2f, [1024, True, 1]] # 8

# YOLO12n head

head:

- [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- [[-1, 6], 1, Concat, [1]] # cat backbone P4

- [-1, 2, A2C2f, [512, False, -1]] # 11

- [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- [[-1, 4], 1, Concat, [1]] # cat backbone P3

- [-1, 2, A2C2f, [256, False, -1]] # 14

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 11], 1, Concat, [1]] # cat head P4

- [-1, 2, A2C2f, [512, False, -1]] # 17

- [-1, 1, Conv, [512, 3, 2]]

- [[-1, 8], 1, Concat, [1]] # cat head P5

- [-1, 2, C3k2, [1024, True]] # 20 (P5/32-large)

- [[14, 17, 20], 1, Detect, [nc]] # Detect(P3, P4, P5)

③训练文件配置

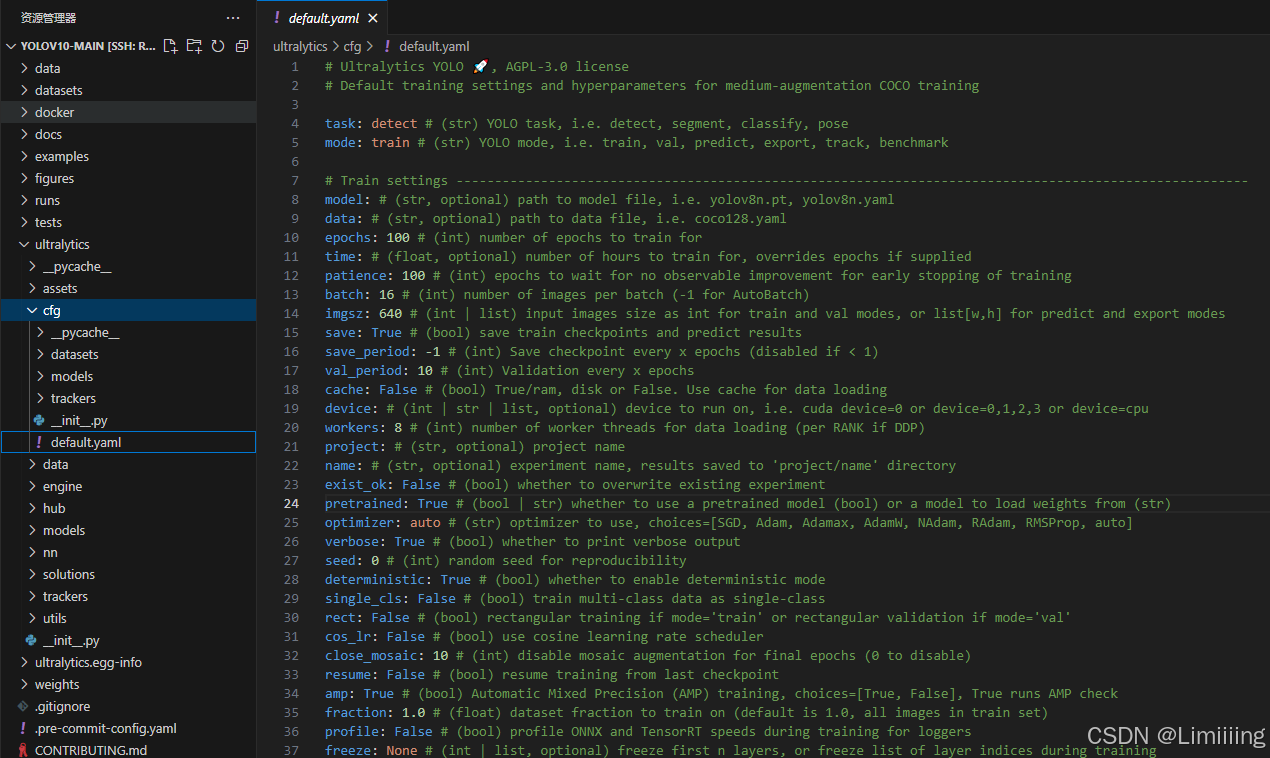

YOLOv12的超参数配置在ultralytics/cfg文件夹下的default.yaml文件中

在模型训练中,比较重要的参数是model、data、epochs、batch、imgsz、device以及workers。

-

model表示训练的模型结构。 -

data是配置数据集文件的路径,用于指定自己的数据集yaml文件。 -

epochs指训练的轮次,默认是100次,只要模型能收敛即可。 -

batch是表示一次性将多少张图片放在一起训练,越大训练的越快,如果设置的太大会报OOM错误,我这边在default中设置16,表示一次训练16张图像。设置的大小为2的幂次,1为2的0次,16为2的4次。 -

imgsz表示送入训练的图像大小,会统一进行缩放。要求是32的整数倍,尽量和图像本身大小一致。 -

device指训练运行的设备。该参数指定了模型训练所使用的设备,例如使用 GPU 运行可以指定为device=0,或者使用多个 GPU 运行可以指定为 device=0,1,2,3,如果没有可用的 GPU,可以指定为 device=cpu 使用 CPU 进行训练。 -

workers是指数据装载时cpu所使用的线程数,默认为8,过高时会报错:[WinError 1455] 页面文件太小,无法完成操作,此时就只能将workers调成0了。

模型训练的相关基本参数就是这些啦,其余的参数可以等到后期训练完成进行调参时再详细了解。

④ 预训练权重下载

在此链接中:https://github.com/sunsmarterjie/yolov12/releases/tag/v1.0下载相应的权重文件。完成后放到项目的根目录中。

五、模型训练和测试

YOLOv12在训练和测试过程中,具体的参数信息可在ultralytics/yolo/cfg/default.yaml路径下找到。

模型训练

在根目录新建train.py,输入以下代码:

from ultralytics import YOLO

if __name__ == '__main__':

model = YOLO(r'ultralytics/cfg/models/v12/yolov12.yaml') # 默认以n训练,命名yolov12m即可定位到m模型

# model.load('yolov12n.pt') # 是否加载预训练权重

model.train(data=r'data.yaml', # 数据集路径

imgsz=640, # 输入图像大小

epochs=100, # 训练次数

single_cls=True, # 多类别设置False

batch=16,

workers=10,

device='0',

)

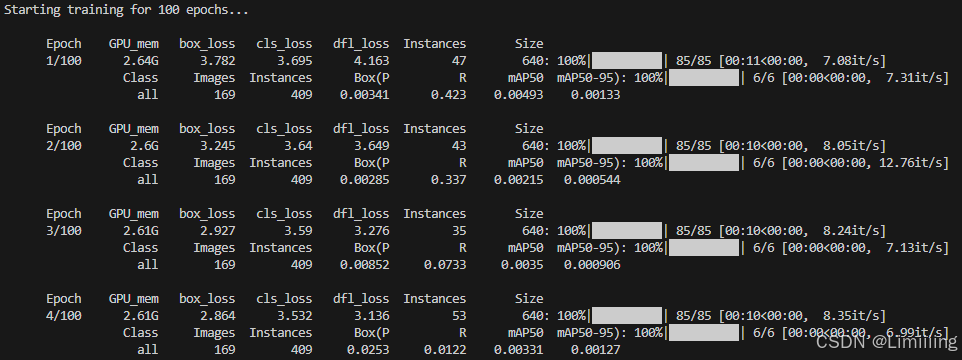

训练情况:

from n params module arguments

0 -1 1 464 ultralytics.nn.modules.conv.Conv [3, 16, 3, 2]

1 -1 1 4672 ultralytics.nn.modules.conv.Conv [16, 32, 3, 2]

2 -1 1 6640 ultralytics.nn.modules.block.C3k2 [32, 64, 1, False, 0.25]

3 -1 1 36992 ultralytics.nn.modules.conv.Conv [64, 64, 3, 2]

4 -1 1 26080 ultralytics.nn.modules.block.C3k2 [64, 128, 1, False, 0.25]

5 -1 1 147712 ultralytics.nn.modules.conv.Conv [128, 128, 3, 2]

6 -1 2 181120 ultralytics.nn.modules.block.A2C2f [128, 128, 2, True, 4]

7 -1 1 295424 ultralytics.nn.modules.conv.Conv [128, 256, 3, 2]

8 -1 2 689920 ultralytics.nn.modules.block.A2C2f [256, 256, 2, True, 1]

9 -1 1 0 torch.nn.modules.upsampling.Upsample [None, 2, 'nearest']

10 [-1, 6] 1 0 ultralytics.nn.modules.conv.Concat [1]

11 -1 1 86912 ultralytics.nn.modules.block.A2C2f [384, 128, 1, False, -1]

12 -1 1 0 torch.nn.modules.upsampling.Upsample [None, 2, 'nearest']

13 [-1, 4] 1 0 ultralytics.nn.modules.conv.Concat [1]

14 -1 1 24000 ultralytics.nn.modules.block.A2C2f [256, 64, 1, False, -1]

15 -1 1 36992 ultralytics.nn.modules.conv.Conv [64, 64, 3, 2]

16 [-1, 11] 1 0 ultralytics.nn.modules.conv.Concat [1]

17 -1 1 74624 ultralytics.nn.modules.block.A2C2f [192, 128, 1, False, -1]

18 -1 1 147712 ultralytics.nn.modules.conv.Conv [128, 128, 3, 2]

19 [-1, 8] 1 0 ultralytics.nn.modules.conv.Concat [1]

20 -1 1 378880 ultralytics.nn.modules.block.C3k2 [384, 256, 1, True]

21 [14, 17, 20] 1 430867 ultralytics.nn.modules.head.Detect [1, [64, 128, 256]]

YOLOv12 summary: 465 layers, 2,569,011 parameters, 2,568,995 gradients, 6.5 GFLOPs

模型验证

在根目录新建val.py,输入以下代码:

import warnings

warnings.filterwarnings('ignore')

from ultralytics import YOLO

if __name__ == '__main__':

model = YOLO('runs/train/exp/weights/best.pt')

model.val(data='data.yaml',

imgsz=640,

batch=16,

split='test',

workers=10,

device='0',

)

在验证阶段,mode模式为验证,mode=val,模型使用训练完成的权重文件:runs/train/exp/weights/best.pt,best.pt就是训练完成后的最佳权重。

模型推理

在根目录新建detect.py,输入以下代码:

import warnings

warnings.filterwarnings('ignore')

from ultralytics import YOLO

if __name__ == '__main__':

model = YOLO('runs/train/exp/weights/best.pt')

model.predict(source='images',

imgsz=640,

device='0',

)

在推理阶段,mode模式为预测,mode= predict,模型使用训练完成的权重文件:runs/train/exp/weights/best.pt,source表示需要预测的图像文件路径,images中存放了准备预测的图像。

总结

以上就是YOLOv12训练自己数据集的全部过程啦,欢迎大家在评论区交流~