目录

部分内容有拓展,部分内容有删除,与原文会有差异,建议结合原文、参考及视频整体阅读。

英文标题:Deepseek-R1 Review : Open Source AI Revolution Crushing GPT-4 and Claude 3.5

原文链接:https://www.geeky-gadgets.com/deepseek-r1-review/

创作者:Julian Horsey

发布时间:2025.1.28

视频来源:《Deepseek-R1 (Tested): BEST LLM EVER That’s Opensource? AGI IS HERE! (Beats O1 & 3.5 Sonnet)》(YouTube,链接不挂了,自行搜索WorldofAI)

参考文献包括但不限于:

- DeepSeek-AI, “DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning,” 2025.

- deepseek-r1的1.5b、7b、8b、14b、32b、70b和671b有啥区别?

- 全世界最强的算法平台codeforces究竟有什么魅力?

- David Rein, B., et al, “GPQA: A Graduate-Level Google-Proof Q&A Benchmark,” 2023. Hunter Lightman, V., et al, “Let’s Verify Step by Step,” 2023.

- https://paperswithcode.com/dataset/mmlu

- Carlos E. Jimenez, J., et al, “SWE-bench: Can Language Models Resolve Real-World GitHub Issues?,” 2024.

一、DeepSeek-R1 势不可挡

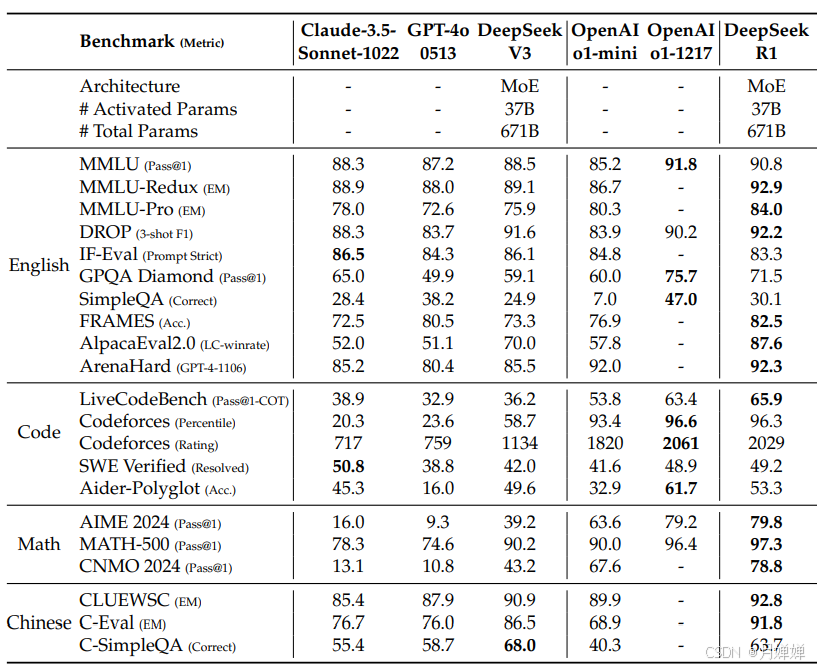

新的AI大模型 Deepseek-R1 正在席卷全球,为开源大型语言模型(LLMs)树立了新的基准。该模型在多个任务上与 OpenAI O1、GPT-4 Omni 和 Claude 3.5 Sonnet 等有与之相当甚至更为优秀的表现。基于MIT 许可证(更宽松的软件许可)、经济实惠性和先进的功能,Deepseek-R1 正在改变 AI 技术的可访问性和实际应用。在World of AI 的这篇深入评测视频中,可以从更专业角度了解这个新开源的 AI 模型。

Deepseek-R1 在编程、数学和多语言任务等关键领域超越行业巨头 OpenAI 的 O1 和 GPT-4 Omni,证明了开源创新(open source innovation)可以与专有解决方案(proprietary solutions)相媲美,甚至超越它们。

问:

如何衡量大模型在各个任务上的性能?测试数据库如何构建?上面的条形图中横坐标都是针对什么领域的测试数据集?

答:

- 性能评估:让模型尝试解决这些问题,记录正确性或得分,如果是程序,则验证是否可以正确运行并解决问题。

- 数据库构建:收集问题👉问题预处理(格式化、清洗、标注正确答案)👉数据库更新;

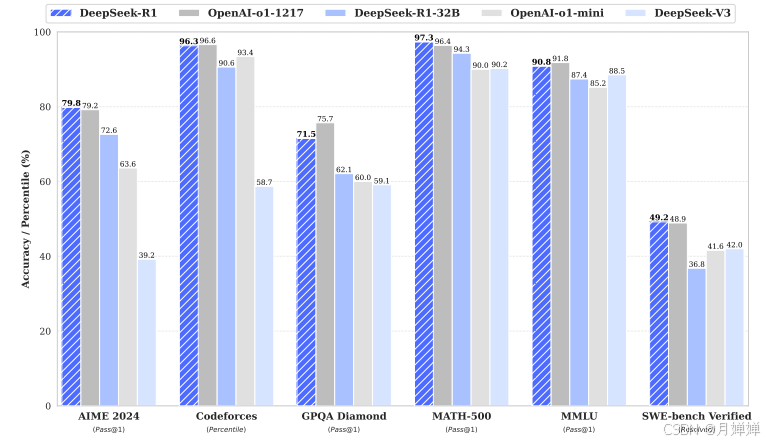

- 条图横坐标:Pass@1表示第一次尝试就正确解决问题的比例;Percentile表示百分比。

3.1 AIME 2024 (American Invitational Mathematics Examination 2024):美国人邀请赛数学竞赛。该竞赛由美国数学协会(MAA)管理。AIME是通往美国数学奥林匹克竞赛(USAMO)或美国初级数学奥林匹克竞赛(USAJMO)的第二阶段考试,这些竞赛是选拔参加国际数学奥林匹克(IMO)队伍的系列考试的一部分。AIME包括15个问题,考试时间为3小时,每个答案都是一个介于0到999之间的整数。旨在挑战学生的数学问题解决能力,涵盖算术、代数、计数、几何、数论和概率等中学数学主题。通常,考试中的问题需要创造性地使用中学课程知识,或者理解不同数学领域如何结合在一起来调查和解决问题。错误答案不会扣分,但正确答案会获得一分,因此最高分是15分。

3.2 Codeforces :国外著名编程竞赛平台,评估大模型的算法和编程能力。2小时竞赛,每周一两次,代码和程序均公开(很有意思的网站),题目兼容并蓄,思维陷阱较多。

3.3 GPOA Diamond :由198个问题组成的高质量问答数据集,仅包括专家正确答案和大多数非专家的问题。与主集GPQA(由生物学,物理和化学专家撰写的448个多项选择问题)类似,还包括第二个专家验证者犯有可证明的错误的问题。但是,Diamond的要求更加严格,要求第一个专家验证者必须正确回答,然后第二个专家验证者错误回答,但他们清楚地描述了对问题作者的解释的错误或理解。

3.4 Math 500:OpenAI在其Let‘s Verify Step by Step论文中的作为数学基准的评估子集,包含500个问题。

3.5 MMLU(Massive Multitask Language Understanding):大规模多任务语言理解,基准涵盖了跨STEM,人文,社会科学等57个主题。它的难度从基础级别到高级专业水平,并且可以测试世界知识和解决问题的能力。paperwithcode上的leaderboard还没更新。

3.6 SWE-bench:涉及软件工程(SWE)相关的基准测试,"Resolved"表示模型成功解决的问题比例。该框架由2,294个软件工程问题组成,包含来自12个流行的Python存储库中的GitHub问题,这些存储库报告了错误或请求新功能,并提取对存储库进行更改以解决这些问题的请求。

但真正让 Deepseek-R1 独树一帜的不仅仅是它的性能,还有它的可访问性和经济实惠性。上周末,DeepSeek App下载量在 Android 和 Apple 应用商店中均位居第一,受欢迎程度足以体现。无论是寻找成本效益高的工具的独立开发者,还是寻求可扩展 AI 解决方案的组织,Deepseek-R1 都提供了一个让先进AI技术触手可及的未来。

二、DeepSeek-R1 卓越之处

- Deepseek-R1 作为新的开源 AI 大模型,在多个任务上与 OpenAI O1、GPT-4 Omni 和 Claude 3.5 Sonnet 等有与之相当甚至更为优秀的表现。

- 该模型使用 MIT 许可证,比 OpenAI O1 等专有模型便宜 30 倍,比 ChatGPT 成本效益高 96.4%。

- 该模型支持高达 128k 的令牌数用于处理大规模数据集,并通过 API、LM Studio 和本地工具(如 Ollama)提供部署灵活性(最大生成长度为32768个tokens )

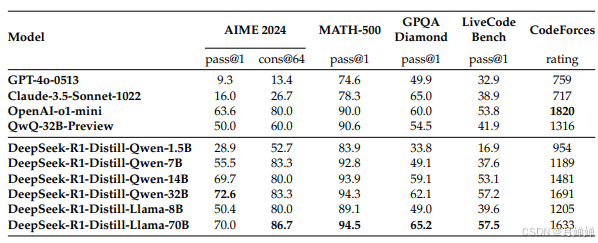

- 提供基于OWEN的蒸馏版本,开放适用于要求响应速度快、硬件资源有限的1.5B-7B版本、适用于对模型性能有要求但无超高配置的8B-14B版本、以及适用于专业问答系统、中规模创作平台的32B-70B版本,满足多样化用户需求。

- 其先进功能涵盖编码、数学、多语言处理、设计和总结,使其成为开发者、研究人员和跨行业组织的多功能工具。

蒸馏版本模型性能对比

没有人比我的MateBook2018D性能还要差的电脑吧,我测试了下本地部署,7B运转很慢,1.5B速度与网页访问答题一样。最大的优点是不会因为服务器繁忙而卡住,还可以创建私人管家,当然回答的准确性比不上671B模型。

三、DeepSeek-R1 创新设计

DeepSeek-R1 的卓越表现植根于其创新架构和先进的训练方法。

(这一段作者笔误或者错误描述了训练阶段,故删除并重新整理)

该模型的核心创新体现在群体相对策略优化(GRPO)和强化学习的多阶段训练方法上,其训练分为四个阶段:

- 冷启动:构建并收集了少量的长COT数据,通过监督微调(SFT)作为初始RL Actor,提升基础模型的可读性;

- 面向推理的增强学习:着重于增强模型的推理能力,尤其是在诸如编码,数学,科学和逻辑推理等推理密集型任务中,这些任务涉及清晰解决方案的明确问题。为减轻语言混合问题,引入语言一致性奖励;

- 拒绝抽样和监督微调:利用所得检查点收集SFT(有监督的微调)数据,以进行后续回合。与主要侧重于推理的初始冷启动数据不同,此阶段包含了来自其他域的数据,以增强模型在书写,角色扮演和其他通用任务中的功能;

- 所有情况加强学习:再次结合基于规则和结果的奖励模型,使用GRPO进行优化,以在复杂和细微的方案中捕获人类的偏好。为了结果有帮助,专注于最终摘要,确保评估强调对用户响应的效用和相关性,同时最大程度地减少对基本推理过程的干扰。对于无害性,评估了模型的全部响应,包括推理过程和摘要,以识别和减轻在生成过程中可能出现的任何潜在风险,偏见或有害内容。

DeepSeek-R1正式确诊为“为人民服务”!

Deepseek-R1 最吸引人的地方之一是其可访问性。它在 MIT 许可证下发布,可供个人、开发者和组织免费使用,这种开源精神与通常伴随高成本和限制性使用条款的专有模型形成了鲜明对比 :)

四、DeepSeek-R1 进化之路

翻译原文无此部分,为论文阅读+个人理解

论文里描述了DeepSeek-R1-Zero和DeepSeek-R1的设计框架和任务性能。前者表现出强大而有趣的推理性能,但是也遇到了挑战,包括可读性差和语言混合;为了解决这些问题并进一步提高性能,DeepSeek-R1诞生,在强化学习之前结合了多阶段训练和冷启动数据。

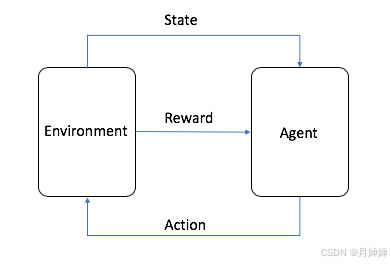

1. 强化学习RL代替监督微调学习SFL

- Agent:ML 算法(或自治系统)

- Environment:具有变量、边界值、规则和有效操作等属性的自适应问题空间

- Action:Agent在Environment中导航时采取的步骤

- State:给定时间点的环境

- Reward:执行Action的正值、负值或零值,即奖励或惩罚

DeepSeek-R1使用的强化学习框架为GRPO(Group Relative Policy Optimization)(Shao et al., 2024),探讨了LLM在没有任何监督数据的情况下发展推理能力的潜力,着重于模型自身的进化。在奖励方面,DeepSeek-R1-Zero采用了基于规则的奖励系统,由准确性奖励和格式奖励共同构成。准确性奖励评估响应是否正确,格式奖励则强调使用在< think > < /think >描述思维过程。这种结构的好处是避免了特定于内容的偏见,例如强制反思性推理或促进特定的问题解决策略,并能够准确观察模型的自然发展(开了上帝视角去理解生物为什么、怎么样进化)。为了避免大规模黑客攻击和降低重训练成本,不采用过程奖励或者回答奖励。

< think >< /think >,我理解即将Chain-of-Thought(COT)思维链显示地提供给用户,KIMI的k1.5 loong thinking也支持,相较于DP比较口语化,速度快,能够自行折叠,产品体验上比DP好,但是编程性能次之)。

强制反思性推理,指在生成回答前,检查问题逻辑、选择回答策略、定制回答风格等等,可能需要更多的算力支撑,减少了错误和偏见,但是对于一味求快求解的用户来说并不好用。

特定于内容的偏见,偏向于某一种特定的问题解决方法,例如:教导学生只用节点法做电路题目,在绘制等效电路图、分析串并联时比较容易,但对于实物连接,就没有必要甚至会带来困惑。

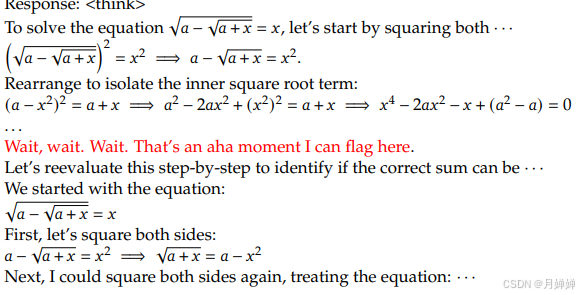

2. Aha Moment “啊哈”时刻

在训练的中间阶段,DeepSeek-R1-Zero学会通过重新评估其初始方法来分配更多的思维时间来解决问题,适用拟人化音调重新考虑(Like人类在滔滔不绝中突然说:“等等,我想到了另一点”,而非按照旧的思路说到底,这一点实在非常可爱)。

3. 蒸馏版本仅采用SFT

蒸馏版本如前面的1.5B、70B,是直接用R1的800K样本微调开源的Qwen和Llama两个较小规模的LLM,且仅应用SFT,不包含RL阶段。其中,1.5B版本在数学基准评估上能过胜过GPT-4o和Claude 3.5 Sonnet(本地部署的孩子,数学作业有救了)。作者表示主要是展示有效性,并希望专业研究进一步探索RL阶段。通过对比大模型蒸馏后与不蒸馏使用大规模RL训练的小模型,发现后者的性能并不如前者,尽管蒸馏策略经济有效,但想要突破上限需要更大的基础模型及大规模RL。

4. 未来研究计划

- 基于COT高效增强在函数调用、多轮问答(multi-turn)、复杂角色扮演以及JSON程序输出等任务上的处理效果;

- 突破除了中文和英文外,其他语言混合问题的限制;

- 提示敏感问题(改变Prompt的措辞、结构、内容会导致生成的回答截然不同),只让模型进行一次尝试(one-shot)时,生成的答案容易出错;而多次尝试(multi-shot)并尝试后验证并调整,生成的答案更加准确。作者建议直接描述问题,采用zero-shot(直接告诉任务,不提供任何示例),让模型只依赖于预训练结果。

- 软件工程任务验证时间较长,影响RL效率。未来会使用拒绝采样、异步评估来提升效率。