首先我们从YGC触发时机开始:如果在创建对象时申请不到内存,那么就会进行一次YGC。

那么我们就从创建对象分配内存空间开始看起:

// Allocation

// IRT_ENTRY是运行解释器的宏,这里就相当于定义了new关键字的方法,使用new关键字的时候就会调用到这个方法

IRT_ENTRY(void, InterpreterRuntime::_new(JavaThread* thread, ConstantPool* pool, int index))

// 从运行时常量池中获取KlassOop

Klass* k_oop = pool->klass_at(index, CHECK);

//然后将其包装成klass包装类,就是instanceKlassHandle句柄

instanceKlassHandle klass (THREAD, k_oop);

// 做了一些验证和初始化操作确保我们没有实例化一个抽象的klass

// Make sure we are not instantiating an abstract klass

klass->check_valid_for_instantiation(true, CHECK);

// 确保klass被初始化

// Make sure klass is initialized

klass->initialize(CHECK);

// At this point the class may not be fully initialized

// because of recursive initialization. If it is fully

// initialized & has_finalized is not set, we rewrite

// it into its fast version (Note: no locking is needed

// here since this is an atomic byte write and can be

// done more than once).

//

// Note: In case of classes with has_finalized we don't

// rewrite since that saves us an extra check in

// the fast version which then would call the

// slow version anyway (and do a call back into

// Java).

// If we have a breakpoint, then we don't rewrite

// because the _breakpoint bytecode would be lost.

// 调用申请内存分配进行实例化的方法,这里返回instanceOop是java class实例的指针

oop obj = klass->allocate_instance(CHECK);

// 将结果返回

thread->set_vm_result(obj);

IRT_END

其中通过klass->check_valid_for_instantiation(true, CHECK);确保了我们没有在实例化一个抽象的k或者是已经加载过的klass:

// 确保我们没有在实例化一个抽象的k或者是已经加载过的klass

void InstanceKlass::check_valid_for_instantiation(bool throwError, TRAPS) {

// 判断是否是接口或者抽象类,如果是就给出相应的异常错误信息

if (is_interface() || is_abstract()) {

ResourceMark rm(THREAD);

THROW_MSG(throwError ? vmSymbols::java_lang_InstantiationError()

: vmSymbols::java_lang_InstantiationException(), external_name());

}

// SystemDictionary 是用来帮助保存 ClassLoader 加载过的类信息的,

// 只是一个拥有很多静态方法的工具类而已

// 如果当前是已经加载过的就给出相应的异常信息

if (this == SystemDictionary::Class_klass()) {

ResourceMark rm(THREAD);

THROW_MSG(throwError ? vmSymbols::java_lang_IllegalAccessError()

: vmSymbols::java_lang_IllegalAccessException(), external_name());

}

}

我们继续从oop obj = klass->allocate_instance(CHECK);进入,查看是如何进行内存分配实例化的:

// InstanceKlass 是Klass子类,是类的元数据

// 通过此方法实例化Klass并给instanceKlass分配一个instanceOop

instanceOop InstanceKlass::allocate_instance(TRAPS) {

// 判断是否定义了finalizer方法

bool has_finalizer_flag = has_finalizer(); // Query before possible GC

// 获得需要分配空间也就是实例的大小

int size = size_helper(); // Query before forming handle.

// 封装成KlassHandle句柄,简单理解 : Klass的封装类

KlassHandle h_k(THREAD, this);

instanceOop i;

// 进行内存分配,成功就初始化对象

i = (instanceOop)CollectedHeap::obj_allocate(h_k, size, CHECK_NULL);

// 如果定义了finalizer方法但是还没有注册的话,就进行注册

if (has_finalizer_flag && !RegisterFinalizersAtInit) {

i = register_finalizer(i, CHECK_NULL);

}

return i;

}

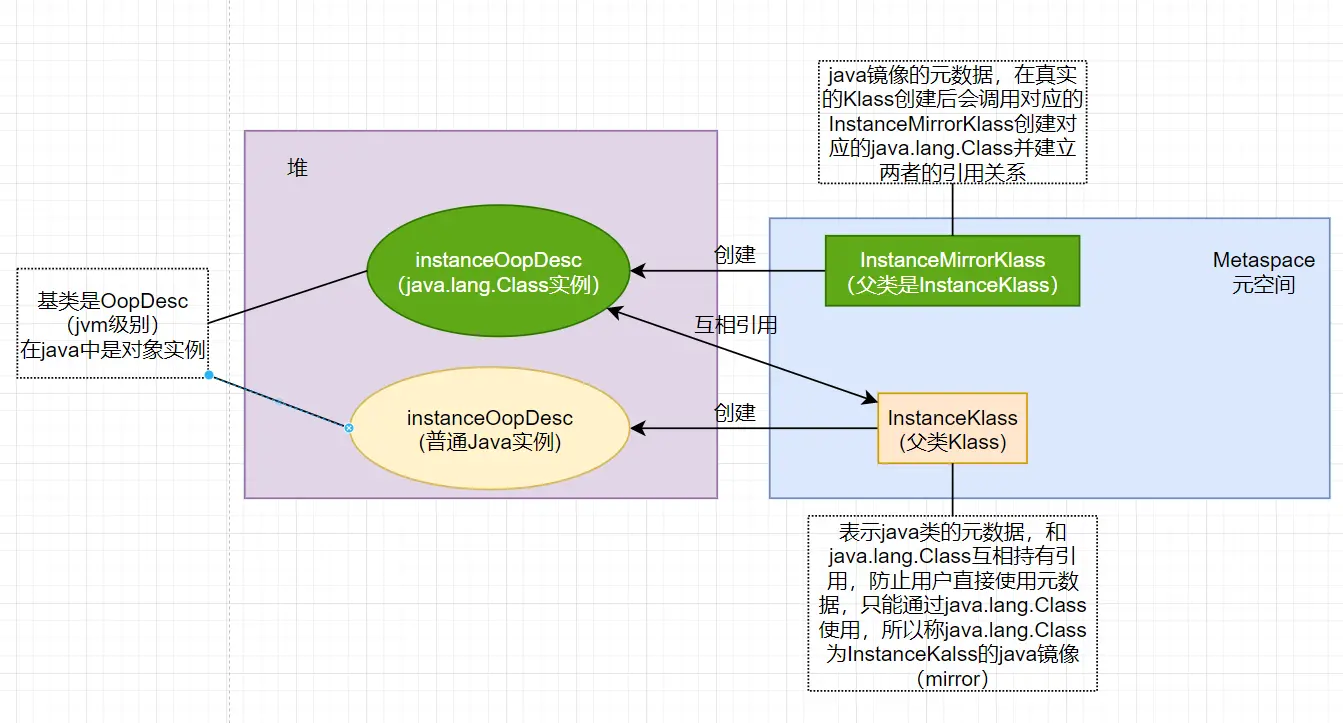

这个方法返回的instanceOop是instanceOopDesc指针的别名,instanceOopDesc是oopDesc的子类,表示java class的实例,InstanceKlass是Klass子类,是类的元数据

instanceOopDesc和InstanceKlass

这个地方涉及到jvm的oop-klass模型:

结合例子来看:

public class Test{

public static void main(String[] args) {

Person person = new Person();

}

}

- 编译并运行

.class文件,随后被加载到JVM的元空间 - JVM找到

Test的主函数入口(main),为main函数创建栈帧,开始执行main函数 - main函数的第一条语句是

Person person = new Person(),就是让JVM创建一个Person对象。但是这个时候元空间中没有Person类的信息,所以JVM开始加载Person类:在元空间中创建instanceKlass对象,把Person类信息放到元空间中;同时,使用元空间中创建的instanceKlass类对应的子类instanceMirrorKlass在堆上会自动构造镜像的Class实例提供反射访问(它和instanceKlass持有着双向引用)。 - 加载完

Person类之后,JVM 会为一个新的Person实例分配内存, 然后调用构造函数初始化Person实例,即在堆上创建一个instanceOopDesc实例,并返回该实例的指针OOP到栈空间对应线程。

继续从(instanceOop)CollectedHeap::obj_allocate(h_k, size, CHECK_NULL);往下看:

// 进行内存分配

oop CollectedHeap::obj_allocate(KlassHandle klass, int size, TRAPS) {

debug_only(check_for_valid_allocation_state());

// gc 的时候不可以进行分配

assert(!Universe::heap()->is_gc_active(), "Allocation during gc not allowed");

assert(size >= 0, "int won't convert to size_t");

// 申请内存并初始化对象

HeapWord* obj = common_mem_allocate_init(klass, size, CHECK_NULL);

// 对堆上的oop对象进行初始化

post_allocation_setup_obj(klass, obj, size);

NOT_PRODUCT(Universe::heap()->check_for_bad_heap_word_value(obj, size));

return (oop)obj;

}

// 申请内存并初始化对象

HeapWord* CollectedHeap::common_mem_allocate_init(KlassHandle klass, size_t size, TRAPS) {

// 先申请内存

HeapWord* obj = common_mem_allocate_noinit(klass, size, CHECK_NULL);

// 完成对对象内存空间的对齐和填充

init_obj(obj, size);

return obj;

}

最后通过common_mem_allocate_noinit(klass, size, CHECK_NULL);进入到内存申请方法中,此方法不包括初始化对象:

// 申请内存不包含对象初始化

HeapWord* CollectedHeap::common_mem_allocate_noinit(KlassHandle klass, size_t size, TRAPS) {

// Clear unhandled oops for memory allocation. Memory allocation might

// not take out a lock if from tlab, so clear here.

CHECK_UNHANDLED_OOPS_ONLY(THREAD->clear_unhandled_oops();)

if (HAS_PENDING_EXCEPTION) {

NOT_PRODUCT(guarantee(false, "Should not allocate with exception pending"));

return NULL; // caller does a CHECK_0 too

}

// 堆中的内存地址都需要通过 HeapWord* 指针进行表示

// 例如申请内存起始地址的函数一般返回的都是HeapWord*, 大小也是 HeapWordSize 的整数倍,

// 因为 Java 堆是按照一定内存大小对齐的

HeapWord* result = NULL;

// 是否使用TLAB

if (UseTLAB) {

// 使用TLAB分配空间,优先进行快速分配

result = allocate_from_tlab(klass, THREAD, size);

if (result != NULL) {

assert(!HAS_PENDING_EXCEPTION,

"Unexpected exception, will result in uninitialized storage");

return result;

}

}

bool gc_overhead_limit_was_exceeded = false;

// 堆中申请内存,这个方法返回的是当前jvm使用的堆类,所以这里返回的是g1CollectedHeap.cpp

// 进入慢分配

result = Universe::heap()->mem_allocate(size,

&gc_overhead_limit_was_exceeded);

// ...

}

判断是否开启了TLAB分配空间,如果开启了则优先采用TLAB进行空间分配,以下开始介绍G1中的TLAB。

TLAB

在使用TLAB分配对象之前,会优先进行栈上分配,我们这里考虑的是无法栈上分配需要共享的对象,这里对栈上分配就不作描述了。

G1提供了两种对象的分配策略:基于线程本地分配缓冲区(TLAB,Thread Local Allocation Buffer)的快速分配和慢速分配。

无论是快速分配还是慢速分配,都应该在STW之外调用,都应该避免使用全局锁。因此优先进行无锁分配,再进行加锁,从而尽可能地满足并行化分配。

目前大多数应用内存分配是多线程的,都从主内存中分配,但是CAS 更新重试过于频繁导致效率低下。目前的应用,一般根据不同业务区分了不同的线程池,在这种情况下,一般每个线程分配内存的特性是比较稳定的。这里的比较稳定指的是,每次分配对象的大小,每轮 GC 分配区间内的分配对象的个数以及总大小。所以,我们可以考虑每个线程分配内存后,就将这块内存保留起来,用于下次分配,这样就不用每次从主内存中分配了。

快速分配

TLAB的目的就是为了进行内存的快速分配,因此TLAB试图通过为每一个线程分配一个缓冲区来避免和减少使用锁。分配线程对象的时候,**从JVM堆中分配一个固定大小的内存区域并将其作为线程的私有缓冲区,这个缓冲区就被称为TLAB。**有了TLAB之后,只有为每个线程分配TLAB缓冲区的时候才需要锁定整个JVM堆。不同的线程不共享TLAB,我们尝试分配一个对象的时候优先从当前线程的TLAB中分配对象,不需要锁,所以达到了快速分配的目的。

TLAB区是Eden区域中的一块内存,不同线程的TLAB都位于Eden区,所有的TLAB内存堆所有的线程都是可见的。每个线程都有一个TLAB的数据结构,但是仅仅只是保存待内存区间的起始地址(start)和结束地址(end)。在分配的时候也只在这个区间内做分配,从而达到无锁分配。

G1中使用CAS来分配TLAB空间,一个TLAB空间分区中可能存在多个TLAB块,但是一个TLAB是不能跨分区的。

快速TLAB对象分配存在两步:

- 从线程的TLAB分配空间,如果成功就返回

- 如果不能分配,就先尝试分配一个新的TLAB,再尝试分配对象

从TLAB已分配的缓冲区直接分配对象,采用的方式为指针碰撞:TLAB会保存top指针(用于标记当前对象分配的位置),如果剩余空间大小大于待分配对象的空间大小,直接分配并更新top指针(top=top+objSize),如果分配失败则进入allocate_from_tlab_slow(TLAB慢速分配)中。

此时就需要对TLAB的空间大小进行判断斟酌:

- 如果TLAB设置的过小,可能需要不断重新分配新的TLAB

- 如果TLAB设置的过大,可能会在GC的时候花费更长的时间,还可能会导致内存碎片问题

JVM提供了TLABSize来控制TLAB的大小,默认值是0,如果为默认值那么JVM会推断这个值多大更合适,采用的参数为TLABWasteTargetPercent,用于设置TLAB可以占用的Eden空间的百分比,默认是1%。如果是由JVM自行推断的,那么推断方式为:

T L A B S i z e = E d e n ∗ T L A B W a s t e T a r g e t P e r c e n t ∗ 2 线 程 个 数 TLABSize = \frac{Eden * TLABWasteTargetPercent*2 }{线程个数} TLABSize=线程个数Eden∗TLABWasteTargetPercent∗2

乘2是因为假设内存使用服从均匀发分布,这里采用的启发式推断仅仅是一个近似值,实际上线程在使用内存分配对象时并不会完全服从正太分布,不同的线程类型对内存的使用也不同,一些线程几乎不会分配新的对象。

如果之前分配失败则说明空间不足,或者是TLAB满了。应对这种情况无需额外操作,只需要保留这部分空间,然后重新在Eden区中分配一块空间给TLAB,然后再在TLAB中分配具体对象。

JVM内部维护**refill_waste**值,当请求对象大于**refill_waste**时,会选择在堆中分配;小于该值,则会废弃当前TLAB,新建TLAB来分配对象。

这个阈值可以使用TLABRefillWasteFraction(它表示TLAB中允许这种浪费的比例,默认为64,表示使用约1/64的TLAB空间来作为refill_waste)来调整。

JVM还提供了一个参数TLABWasteIncrement(默认值为4个字)用于动态增加这个refill_waste的值,默认情况下,TLAB大小和refill_waste都会在运行时不断调整,使系统的运行状态达到最优。动态调整也不能无限变更,所以JVM提供提供了MinTLABSize(默认为2k)用于控制最小值。也可以通过-XX:-ResizeTLAB禁用自动调整TLAB大小。

从源码上继续从result = allocate_from_tlab(klass, THREAD, size);进入,查看TLAB快速分配流程:

// TLAB 快速分配

HeapWord* CollectedHeap::allocate_from_tlab(KlassHandle klass, Thread* thread, size_t size) {

assert(UseTLAB, "should use UseTLAB");

// 分配size大小的空间

// TLAB中使用指针碰撞法分配对象:TLAB保存top指针用于标记当前对象分配的位置,

// 如果剩余空间大小大于待分配对象的空间大小,直接分配并更新top指针(top=top+objSize)

HeapWord* obj = thread->tlab().allocate(size);

if (obj != NULL) {

return obj;

}

// Otherwise...

// 没有分配到则进入分配一个新的TLAB流程

return allocate_from_tlab_slow(klass, thread, size);

}

其中从tlab().allocate(size);进入查看tlab分配空间:

// 分配空间

inline HeapWord* ThreadLocalAllocBuffer::allocate(size_t size) {

// 校验指针是否在start 和 end 的范围内

invariants();

// 获得_top指针位置

HeapWord* obj = top();

// 如果当前剩余空间大于等于需要分配的空间大小

if (pointer_delta(end(), obj) >= size) {

// successful thread-local allocation

#ifdef ASSERT

// Skip mangling the space corresponding to the object header to

// ensure that the returned space is not considered parsable by

// any concurrent GC thread.

size_t hdr_size = oopDesc::header_size();

Copy::fill_to_words(obj + hdr_size, size - hdr_size, badHeapWordVal);

#endif // ASSERT

// This addition is safe because we know that top is

// at least size below end, so the add can't wrap.

// 设置top指针位置为 原top + 需要分配的大小

set_top(obj + size);

// 对设置后的top指针进行校验查看指针是否在start 和 end 的范围内

invariants();

// 返回_top

return obj;

}

// 如果剩余的空间不够则直接返回NULL

return NULL;

}

其中的invariants();的作用是校验指针是否在start 和 end 的范围内:

void invariants() const { assert(top() >= start() && top() <= end(), "invalid tlab"); }

如果剩余空间不够需要分配的空间,那么就进入collectedHeap.inline.hpp中的allocate_from_tlab_slow(klass, thread, size);方法进入到TLAB慢速分配流程分配一个新的TLAB。

TLAB慢速分配

如果TLAB快速分配没有分配成功就会尝试进行TLAB慢速分配,具体有以下两种情况:

- 如果TLAB的剩余空间过小,那么就对老TLAB进行填充一个

dummy对象,然后去申请一个新的TLAB - 如果TLAB的剩余空间并不小,那么就更新

refill_waste的值,然后不使用TLAB进行分配,直接返回

当我们重新分配一个TLAB时,为什么要对老的TLAB做清理操作?

这里的清理操作指的是:向老的TLAB中的尚未分配的空间中分配一个dummy对象(哑元对象),这个对象通常是int[],为了供栈解析的时候使用。

栈解析:

G1在进行某些需要线性扫描堆中对象的操作的时候,如果这个区域是对象,那么就可以直接跳过这个对象大小的位置。但是如果是空白的空间,那么就无法跳过,只能一个字节一个字节的进行扫描,所以速度会很慢。所以为了提高栈解析的速度,我们向老的TLAB中的空白空间中分配一个对象,使得解析的时候可以跳过这些空间。

我们进入allocate_from_tlab_slow(klass, thread, size);方法查看其操作流程:

// TLAB慢速分配流程 分配一个新的TLAB

HeapWord* CollectedHeap::allocate_from_tlab_slow(KlassHandle klass, Thread* thread, size_t size) {

// Retain tlab and allocate object in shared space if

// the amount free in the tlab is too large to discard.

// 判断TLAB的剩余空间是否可以丢弃,如果剩余空间大于设定的阈值 (refill_waste_limit)就保留

// free() 计算 top 到 end 之间的大小,也就是剩余大小

// refill_waste_limit() 返回 _refill_waste_limit 值

// 运行到这里的情况为:要分配的对象的大小大于TLAB的剩余空间,该TLAB不够分配。

// 并且该TLAB的大小仍然大于_refill_waste_limit的值,无法新分配一个TLAB

if (thread->tlab().free() > thread->tlab().refill_waste_limit()) {

// 无法丢弃,就通过TLAWasteIncrement更新refill_waste的阈值

thread->tlab().record_slow_allocation(size);

// 返回NULL,使得后续对象直接分配在堆中非TLAB的Eden区域中

return NULL;

}

// Discard tlab and allocate a new one.

// To minimize fragmentation, the last TLAB may be smaller than the rest.

// 为了避免内存碎片化,新分配的TLAB会比之前分配的更小,compute_size就是计算待分配的TLAB的大小,如果返回0说明Eden区内存不足

size_t new_tlab_size = thread->tlab().compute_size(size);

// 分配前先清理老的TLAB,为了让堆保parsable可解析

thread->tlab().clear_before_allocation();

// 计算待分配的TLAB的大小为0的话说明Eden区堆内存不足了,返回NULL(可能会触发Eden区的垃圾回收)

if (new_tlab_size == 0) {

return NULL;

}

// Allocate a new TLAB...

// 分配一个新的TLAB,G1实现在g1CollectedHeap.cpp中,有可能分配失败

HeapWord* obj = Universe::heap()->allocate_new_tlab(new_tlab_size);

if (obj == NULL) {

return NULL;

}

// 如果启用了 ZeroTLAB 这个 JVM 参数,则将对象所有字段置零值

if (ZeroTLAB) {

// ..and clear it.

Copy::zero_to_words(obj, new_tlab_size);

} else {

// ...and zap just allocated object.

#ifdef ASSERT

// Skip mangling the space corresponding to the object header to

// ensure that the returned space is not considered parsable by

// any concurrent GC thread.

size_t hdr_size = oopDesc::header_size();

Copy::fill_to_words(obj + hdr_size, new_tlab_size - hdr_size, badHeapWordVal);

#endif // ASSERT

}

// 新分配的TLAB的属性初始化

thread->tlab().fill(obj, obj + size, new_tlab_size);

return obj;

}

可以看到一开始判断了TLAB中的剩余空间是否大于了refill_waste的阈值,如果大于则更新refill_waste的值,然后不使用TLAB进行分配,直接返回;如果剩余空间小于等于refill_waste的阈值,就对老TLAB进行填充一个dummy对象,然后去申请一个新的TLAB。

其中通过tlab().record_slow_allocation(size);该方法查看如何更新refill_waste的阈值:

// 通过TLAWasteIncrement更新refill_waste的阈值

void ThreadLocalAllocBuffer::record_slow_allocation(size_t obj_size) {

// Raise size required to bypass TLAB next time. Why? Else there's

// a risk that a thread that repeatedly allocates objects of one

// size will get stuck on this slow path.

// 修改方式为:(TLABWasteIncrement + _refill_waste_limit)

// 避免某个线程一直请求大于当前free空间的内存,但是因为free空间一直小于refill_waste_limit而一直走慢速分配的情形

set_refill_waste_limit(refill_waste_limit() + refill_waste_limit_increment());

// 增加走慢速分配的次数

_slow_allocations++;

if (PrintTLAB && Verbose) {

Thread* thrd = myThread();

gclog_or_tty->print("TLAB: %s thread: " INTPTR_FORMAT " [id: %2d]"

" obj: " SIZE_FORMAT

" free: " SIZE_FORMAT

" waste: " SIZE_FORMAT "\n",

"slow", p2i(thrd), thrd->osthread()->thread_id(),

obj_size, free(), refill_waste_limit());

}

}

** **回到allocate_from_tlab_slow()方法继续往下阅读,可以看到通过tlab().compute_size(size)重新计算了新的TLAB大小,其计算方式为:

// 计算TLAB的大小

inline size_t ThreadLocalAllocBuffer::compute_size(size_t obj_size) {

// 将传入大小按照8字节向上取整,返回字宽大小

const size_t aligned_obj_size = align_object_size(obj_size);

// Compute the size for the new TLAB.

// The "last" tlab may be smaller to reduce fragmentation.

// unsafe_max_tlab_alloc is just a hint.

// 给新的TLAB计算大小,新的TLAB有可能为了减少内存碎片而变得更小

const size_t available_size = Universe::heap()->unsafe_max_tlab_alloc(myThread()) /

HeapWordSize;

// 新的TLAB大小为 两者最小值

size_t new_tlab_size = MIN2(available_size, desired_size() + aligned_obj_size);

// Make sure there's enough room for object and filler int[].

// alignment_reserve() 方法返回TLAB中必须保留的内存大小,是 dummy object 填充的对象头大小

// obj_plus_filler_size 表示待分配内存的最低值

const size_t obj_plus_filler_size = aligned_obj_size + alignment_reserve();

if (new_tlab_size < obj_plus_filler_size) {

// 空间不足,分配失败

// If there isn't enough room for the allocation, return failure.

if (PrintTLAB && Verbose) {

gclog_or_tty->print_cr("ThreadLocalAllocBuffer::compute_size(" SIZE_FORMAT ")"

" returns failure",

obj_size);

}

return 0;

}

// 分配成功,返回计算的大小

if (PrintTLAB && Verbose) {

gclog_or_tty->print_cr("ThreadLocalAllocBuffer::compute_size(" SIZE_FORMAT ")"

" returns " SIZE_FORMAT,

obj_size, new_tlab_size);

}

return new_tlab_size;

}

首先通过align_object_size(obj_size);方法获得了需要分配对象的字宽,例如传入大小是14字节,取整后就是16字节,所以返回2。具体计算方式为:

**(((size) + ((alignment) - 1)) & ~((alignment) - 1))**

然后再通过unsafe_max_tlab_alloc()方法计算出可用空间大小,计算过程为:

size_t G1CollectedHeap::unsafe_max_tlab_alloc(Thread* ignored) const {

// Return the remaining space in the cur alloc region, but not less than

// the min TLAB size.

// Also, this value can be at most the humongous object threshold,

// since we can't allow tlabs to grow big enough to accommodate

// humongous objects.

// 当前用户线程/java线程尝试从剩余给TLAB的空间中分配了一个分区,但是不一定有足够的空间

HeapRegion* hr = _allocator->mutator_alloc_region(AllocationContext::current())->get();

// 获取当前TLAB可以设置的最大值,也就是Region大小的一半

size_t max_tlab = max_tlab_size() * wordSize;

// 如果没有分配到,那么就返回最大大小

if (hr == NULL) {

return max_tlab;

} else {

// 如果分配到了,并且大小在TLAB的大小范围之内就返回该大小

return MIN2(MAX2(hr->free(), (size_t) MinTLABSize), max_tlab);

}

}

于是我们获得了从堆剩余给 TLAB 可分配的空间中分配的一个分区,最终新TLAB应该分配的大小为堆剩余给 TLAB 可分配的空间中分配的一个分区大小和desired_size() + aligned_obj_size(TLAB期望大小 + 这次需要分配对象的大小)的最小值。

通过将这次需要分配的对象的大小加上TLAB中必须保留的内存大小得到了obj_plus_filler_size的值,这意味着待分配内存的最小值。如果最终新TLAB的大小比待分配空间的最小值还要小就说明空间不足,分配失败返回0,在外层返回NULL,不使用TLAB进行分配。反之,则返回新TLAB应该分配的大小。

TLAB 期望大小

size_t desired_size() const { return _desired_size; }

期望大小其实是在TLAB初始化的时候进行设置的:

// TLAB 初始化逻辑

void ThreadLocalAllocBuffer::initialize() {

// 设置初始指针,由于还没有从 Eden 分配内存,所以这里都设置为 NULL

initialize(NULL, // start

NULL, // top

NULL); // end

// 设置期望大小值

set_desired_size(initial_desired_size());

// Following check is needed because at startup the main

// thread is initialized before the heap is. The initialization for

// this thread is redone in startup_initialization below.

if (Universe::heap() != NULL) {

// 所有 TLAB 总大小,不同的 GC 实现有不同的 TLAB 容量, 一般是 Eden 区大小

size_t capacity = Universe::heap()->tlab_capacity(myThread()) / HeapWordSize;

// Keep alloc_frac as float and not double to avoid the double to float conversion

// 计算这个线程的 TLAB 期望占用所有 TLAB 总体大小比例

// TLAB 期望占用大小也就是这个 TLAB 大小 乘以 期望 refill 的次数

float alloc_frac = desired_size() * target_refills() / (float) capacity;

// 记录下来,用于计算 EMA

// sample() 就是根据传入值去计算出一个新的权重值

_allocation_fraction.sample(alloc_frac);

}

#if INCLUDE_ALL_GCS

if (UsePerTenantTLAB) {

_my_thread = Thread::current();

}

#endif

// 计算初始 refill 最大浪费空间,并设置

// 初始大小就是 TLAB 的大小(_desired_size) / TLABRefillWasteFraction

set_refill_waste_limit(initial_refill_waste_limit());

// 重置统计

initialize_statistics();

}

进入initial_desired_size()方法查看其设置_desired_size的具体逻辑:

// 初始化设置TLAB期望大小

size_t ThreadLocalAllocBuffer::initial_desired_size() {

size_t init_sz = 0;

// 如果通过 -XX:TLABSize 设置了 TLAB 大小,则用这个值作为初始期望大小

if (TLABSize > 0) {

// 表示堆内存占用大小都需要用占用几个 HeapWord 表示,所以用TLABSize / HeapWordSize

init_sz = TLABSize / HeapWordSize;

} else if (global_stats() != NULL) {

// Initial size is a function of the average number of allocating threads.

// 获取当前epoch内线程数量期望,这个如之前所述通过 EMA 预测

unsigned nof_threads = global_stats()->allocating_threads_avg();

// 不同的 GC 实现有不同的 TLAB 容量,Universe::heap()->tlab_capacity(thread()) 一般是 Eden 区大小

// target_refills已经在 JVM 初始化所有 TLAB 全局配置的时候初始化好了

// 期望大小 等于 Eden区大小/(当前 epcoh 内会分配对象期望线程个数 * 每个 epoch 内每个线程 refill 次数配置)

init_sz = (Universe::heap()->tlab_capacity(myThread()) / HeapWordSize) /

(nof_threads * target_refills());

// 考虑对象对齐,得出最后的大小

init_sz = align_object_size(init_sz);

}

// 保持大小在 min_size() 还有 max_size() 之间

init_sz = MIN2(MAX2(init_sz, min_size()), max_size());

// 返回大小

return init_sz;

}

可以看出:

- 如果设置了使用TLAB,并且设置了

TLABSize,那么这个期望大小就是你所设置的TLAB的大小 - 如果你没有设置的话,这个期望大小则为将 (Eden空间大小 / 期望所使用的TLAB的个数 )的值按照8字节向上取整后的值

最后得出的值,确保是在TLAB的最小大小和最大大小范围之内的。

EMA

EMA(Exponential Moving Average 指数平均数)算法,也就是每次输入采样值,根据历史采样值得出最新的期望值。最小权重越大,变化得越快,受历史数据影响越小。根据应用设置合适的最小权重,可以让期望更加理想。在这里不详细介绍,感兴趣的同学可以去查看gcUtil.hpp中的AdaptiveWeightedAverage自行了解。

我们回到allocate_from_tlab_slow中继续流程:清理老的TLAB,从tlab().clear_before_allocation();进入查看具体清理操作:

void ThreadLocalAllocBuffer::clear_before_allocation() {

// 增加慢分配下refill浪费的内存空间值

_slow_refill_waste += (unsigned)remaining();

// 使得TLAB可以支持parsable,同时丢弃这个TLAB

make_parsable(true); // also retire the TLAB

}

** **具体操作在make_parsable();中:

void ThreadLocalAllocBuffer::make_parsable(bool retire) {

if (end() != NULL) {

// 校验 top 是处于start 和 end 位置之间的

invariants();

// (这里的是否丢弃值为 true)

if (retire) {

// 增加当前线程已分配的内存数,used_bytes方法返回TLAB中使用掉的内存(top - start)

myThread()->incr_allocated_bytes(used_bytes());

}

// 将TLAB中top位置后面的空间全部填充

CollectedHeap::fill_with_object(top(), hard_end(), retire);

// 如果设置了ZeroTLAB,那么就将属性全部置空,该TLAB就不能用来分配对象

if (retire || ZeroTLAB) { // "Reset" the TLAB

set_start(NULL);

set_top(NULL);

set_pf_top(NULL);

set_end(NULL);

}

}

assert(!(retire || ZeroTLAB) ||

(start() == NULL && end() == NULL && top() == NULL),

"TLAB must be reset");

}

其中incr_allocated_bytes(used_bytes())就是将当前线程已经分配的大小_allocated_bytes加上已经使用的内存,具体的填充老TLAB的操作在fill_with_object()中,最终会调用到collectedHeap.cpp中的fill_with_object_impl()方法:

void

CollectedHeap::fill_with_object_impl(HeapWord* start, size_t words, bool zap)

{

// 校验待填充的内存是否大于数组的最大大小

assert(words <= filler_array_max_size(), "too big for a single object");

// 如果要填充的空间大小大于等于数组填充的最小值

if (words >= filler_array_min_size()) {

// 那么就使用int数组进行填充

fill_with_array(start, words, zap);

} else if (words > 0) {

assert(words == min_fill_size(), "unaligned size");

// 如果比数组填充的最小值还要小,那么就使用Object对象填充

post_allocation_setup_common(SystemDictionary::Object_klass(), start);

}

}

我们可以在fill_with_array()中看到这里使用的数组是int数组:

// 使用int数组进行填充

void

CollectedHeap::fill_with_array(HeapWord* start, size_t words, bool zap)

{

assert(words >= filler_array_min_size(), "too small for an array");

assert(words <= filler_array_max_size(), "too big for a single object");

// 计算待填充大小

const size_t payload_size = words - filler_array_hdr_size();

// 通过待填充大小计算出int数组应该要多长

const size_t len = payload_size * HeapWordSize / sizeof(jint);

assert((int)len >= 0, err_msg("size too large " SIZE_FORMAT " becomes %d", words, (int)len));

// Set the length first for concurrent GC.

((arrayOop)start)->set_length((int)len);

// int数组填充

post_allocation_setup_common(Universe::intArrayKlassObj(), start);

DEBUG_ONLY(zap_filler_array(start, words, zap);)

}

最终两者都调用了post_allocation_setup_common();这个方法来进行填充,这边就不继续深入了,感兴趣的同学可以自行深入。** **

继续回到原流程allocate_from_tlab_slow中去,如果计算出来的新TLAB大小不为0,就说明空间仍够使用,那么就会进入到allocate_new_tlab(new_tlab_size);方法中分配一个新的TLAB。

// 分配一个新的TLAB

HeapWord* G1CollectedHeap::allocate_new_tlab(size_t word_size) {

assert_heap_not_locked_and_not_at_safepoint();

assert(!isHumongous(word_size), "we do not allow humongous TLABs");

uint dummy_gc_count_before;

uint dummy_gclocker_retry_count = 0;

// 主要执行逻辑

return attempt_allocation(word_size, &dummy_gc_count_before, &dummy_gclocker_retry_count);

}

其主要执行逻辑处于attempt_allocation方法中,步骤也可以分为两个部分:快速无锁分配和慢速分配。

inline HeapWord* G1CollectedHeap::attempt_allocation(size_t word_size,

uint* gc_count_before_ret,

uint* gclocker_retry_count_ret) {

assert_heap_not_locked_and_not_at_safepoint();

// 根据大小判断是否是大对象

assert(!isHumongous(word_size), "attempt_allocation() should not "

"be called for humongous allocation requests");

// 首先尝试分配TLAB空间的快速无锁分配

AllocationContext_t context = AllocationContext::current();

HeapWord* result = _allocator->mutator_alloc_region(context)->attempt_allocation(word_size,

false /* bot_updates */);

if (result == NULL) {

// 分配TLAB快速分配未成功,则正式进入TLAB慢速分配

result = attempt_allocation_slow(word_size,

context,

gc_count_before_ret,

gclocker_retry_count_ret);

}

assert_heap_not_locked();

if (result != NULL) {

dirty_young_block(result, word_size);

}

return result;

}

**快速无锁分配:**在当前可以分配的堆分区中使用CAS来获取一块内存,如果成功就可以作为TLAB的空间。因为CAS有可能失败,如果失败则进行TLAB慢速分配。

快速分配执行逻辑为:

inline HeapWord* G1OffsetTableContigSpace::par_allocate_impl(size_t size,

HeapWord* const end_value) {

do {

HeapWord* obj = top();

if (pointer_delta(end_value, obj) >= size) {

HeapWord* new_top = obj + size;

HeapWord* result = (HeapWord*)Atomic::cmpxchg_ptr(new_top, top_addr(), obj);

if (result == obj) {

assert(is_aligned(obj) && is_aligned(new_top), "checking alignment");

return obj;

}

} else {

return NULL;

}

} while (true);

}

**TLAB慢速分配:**需要尝试对堆进行加锁,扩展新生代区域或者垃圾回收等处理之后再进行分配。

// TLAB 慢速分配

HeapWord* G1CollectedHeap::attempt_allocation_slow(size_t word_size,

AllocationContext_t context,

uint* gc_count_before_ret,

uint* gclocker_retry_count_ret) {

// Make sure you read the note in attempt_allocation_humongous().

assert_heap_not_locked_and_not_at_safepoint();

// 根据大小校验是否是大对象,本方法不适用于大对象的分配

assert(!isHumongous(word_size), "attempt_allocation_slow() should not "

"be called for humongous allocation requests");

// We should only get here after the first-level allocation attempt

// (attempt_allocation()) failed to allocate.

// We will loop until a) we manage to successfully perform the

// allocation or b) we successfully schedule a collection which

// fails to perform the allocation. b) is the only case when we'll

// return NULL.

HeapWord* result = NULL;

for (int try_count = 1; /* we'll return */; try_count += 1) {

bool should_try_gc;

uint gc_count_before;

{

// 加锁分配

MutexLockerEx x(Heap_lock);

// 还是先去申请内存这个方法申请内存失败会将_mutator_alloc_region中的活跃区域进行retire并填充

// retire即将现在活跃的eden区region填充后加入到增量cset(即将要被回收的集合)中

// 之后再去申请一块新的region代替当前活跃区域

// 如果申请新的region失败才会继续下面操作进行GC

result = _allocator->mutator_alloc_region(context)->attempt_allocation_locked(word_size,

false /* bot_updates */);

if (result != NULL) {

return result;

}

// If we reach here, attempt_allocation_locked() above failed to

// allocate a new region. So the mutator alloc region should be NULL.

assert(_allocator->mutator_alloc_region(context)->get() == NULL, "only way to get here");

// 当 _needs_gc 和 (jni活跃实例数) _jni_lock_count > 0 同时满足时为true

// 程序中如果使用了jni开发,就可能会为true

if (GC_locker::is_active_and_needs_gc()) {

// 判断是否可以对新生代分区进行扩展(young_list_length < max_young_list_length)

if (g1_policy()->can_expand_young_list()) {

// No need for an ergo verbose message here,

// can_expand_young_list() does this when it returns true.

// 再申请一次

result = _allocator->mutator_alloc_region(context)->attempt_allocation_force(word_size,

false /* bot_updates */);

if (result != NULL) {

return result;

}

}

should_try_gc = false;

} else {

// The GCLocker may not be active but the GCLocker initiated

// GC may not yet have been performed (GCLocker::needs_gc()

// returns true). In this case we do not try this GC and

// wait until the GCLocker initiated GC is performed, and

// then retry the allocation.

// 判断GC_locker是不是需要gc,如果为true则说明有线程进入了临界区GC被丢弃,会在执行结束后再次触发gc并将本值置为false

if (GC_locker::needs_gc()) {

// 在这里我们会等待再次触发gc后,进行重新分配,所以并不需要我们这里尝试GC,因此之里应该置为false

should_try_gc = false;

} else {

// Read the GC count while still holding the Heap_lock.

// 在保持Heap_lock的时候拿到此时发生gc的次数

gc_count_before = total_collections();

// 此时说明没有GC被丢弃过,这里我们可以尝试进行GC,因此将should_try_gc置true

should_try_gc = true;

}

}

}

// 前流程分配失败,判断是否需要我们尝试GC

if (should_try_gc) {

// GCLocker 只有需要GC的时候才会进入这里,意味着GCLocker没有进入临界区,可以进行垃圾回收

// 简单来说,java代码可以和本地代码交互,在访问JNI代码时,JNI可能会进入临界区,所以此时会阻止GC垃圾回收操作

bool succeeded;

// 执行GC,再分配一个TLAB空间返回

result = do_collection_pause(word_size, gc_count_before, &succeeded,

GCCause::_g1_inc_collection_pause);

if (result != NULL) {

assert(succeeded, "only way to get back a non-NULL result");

return result;

}

if (succeeded) {

// If we get here we successfully scheduled a collection which

// failed to allocate. No point in trying to allocate

// further. We'll just return NULL.

// 如果我们到达这里,我们成功地安排了一个分配失败的集合。试图进一步分配没有意义。我们只返回NULL。

MutexLockerEx x(Heap_lock);

// total_collections:发生gc的次数

*gc_count_before_ret = total_collections();

return NULL;

}

} else {

// 不需要尝试GC

// 判断是否达到分配阈值

if (*gclocker_retry_count_ret > GCLockerRetryAllocationCount) {

// 如果大于则直接返回NULL

MutexLockerEx x(Heap_lock);

*gc_count_before_ret = total_collections();

return NULL;

}

// The GCLocker is either active or the GCLocker initiated

// GC has not yet been performed. Stall until it is and

// then retry the allocation.

// GCLocker处于活动状态,或者尚未执行GCLocker启动的GC。

// 运行到这里会循环wait,直到GCLocker中的_needs_gc被重新置为false,然后重试分配。

GC_locker::stall_until_clear();

// 每执行一次就将分配次数加1

(*gclocker_retry_count_ret) += 1;

}

// We can reach here if we were unsuccessful in scheduling a

// collection (because another thread beat us to it) or if we were

// stalled due to the GC locker. In either can we should retry the

// allocation attempt in case another thread successfully

// performed a collection and reclaimed enough space. We do the

// first attempt (without holding the Heap_lock) here and the

// follow-on attempt will be at the start of the next loop

// iteration (after taking the Heap_lock).

// 有可能其他线程正在分配或者GCLocker正被竞争使用,再尝试一次TLAB无锁快速分配

// 再次执行一次流程,每执行一次尝试分配次数都会增加直到到达阈值返回NULL

result = _allocator->mutator_alloc_region(context)->attempt_allocation(word_size,

false /* bot_updates */);

if (result != NULL) {

return result;

}

// Give a warning if we seem to be looping forever.

if ((QueuedAllocationWarningCount > 0) &&

(try_count % QueuedAllocationWarningCount == 0)) {

warning("G1CollectedHeap::attempt_allocation_slow() "

"retries %d times", try_count);

}

}

ShouldNotReachHere();

return NULL;

}

具体流程如下:

- 首先尝试对堆分区进行加锁分配,成功则返回,在

attempt_allocation_locked完成。 - 不成功,则判定是否可以对新生代分区进行扩展,如果可以扩展则扩展后再分配TLAB,成功则返回,在

attempt_allocation_force完成。 - 不成功,判定是否可以进行垃圾回收,如果可以进行垃圾回收后再分配,成功则返回,在

do_collection_pause完成。 - 不成功,如果尝试分配次数达到阈值(默认值是2次)则返回失败。

- 如果还可以继续尝试,再次判定是否进行快速分配,如果成功则返回。

- 不成功则通过for循环重新再尝试一次流程,直到成功或者达到阈值失败。

其中使用到了GC_locker::needs_gc()这一方法,会返回_needs_gc的值。具体的含义为:

使用本地方法JNI函数访问JVM中的字符串或数组数据(代码在临界区执行),为了防止gc移动字符串或者数组数据导致指针失效,需要利用GC_locker加锁,保证临界区代码的正确执行。如果在此时需要发生GC,那么此次GC就会被丢弃,并将其中的_needs_gc置为true,在临界区代码执行完毕后,再次触发GC操作,之后将_needs_gc重新复位为false。

所以TLAB慢速分配要么成功分配,要么尝试次数达到阈值后结束并返回NULL。

继续回到common_mem_allocate_noinit方法中,如果TLAB分配全部失败,就会进入到mem_allocate方法中,在其中会继续尝试分配。如果在这里分配仍然失败,那么就会触发YGC流程:

HeapWord*

G1CollectedHeap::mem_allocate(size_t word_size,

bool* gc_overhead_limit_was_exceeded) {

assert_heap_not_locked_and_not_at_safepoint();

// Loop until the allocation is satisfied, or unsatisfied after GC.

for (uint try_count = 1, gclocker_retry_count = 0; /* we'll return */; try_count += 1) {

uint gc_count_before;

HeapWord* result = NULL;

// 根据是否是大对象再次尝试分配

if (!isHumongous(word_size)) {

result = attempt_allocation(word_size, &gc_count_before, &gclocker_retry_count);

} else {

result = attempt_allocation_humongous(word_size, &gc_count_before, &gclocker_retry_count);

}

// 成功则返回

if (result != NULL) {

return result;

}

// 创建垃圾回收操作,gc操作任务类

// Create the garbage collection operation...

VM_G1CollectForAllocation op(gc_count_before, word_size);

op.set_allocation_context(AllocationContext::current());

// ...and get the VM thread to execute it.

// 使用VMThread去执行gc操作

VMThread::execute(&op);

// ...

// Give a warning if we seem to be looping forever.

if ((QueuedAllocationWarningCount > 0) &&

(try_count % QueuedAllocationWarningCount == 0)) {

warning("G1CollectedHeap::mem_allocate retries %d times", try_count);

}

}

ShouldNotReachHere();

return NULL;

}

这一部分和之前的do_collection_pause方法尝试GC操作类似:

HeapWord* G1CollectedHeap::do_collection_pause(size_t word_size,

uint gc_count_before,

bool* succeeded,

GCCause::Cause gc_cause) {

assert_heap_not_locked_and_not_at_safepoint();

// 记录gc停顿

g1_policy()->record_stop_world_start();

// gc操作任务类,第三个参数表示本次gc是不是老年代并发gc

VM_G1IncCollectionPause op(gc_count_before,

word_size,

false, /* should_initiate_conc_mark */

g1_policy()->max_pause_time_ms(),

gc_cause);

op.set_allocation_context(AllocationContext::current());

// 真正的停顿方法,使用VMThread执行操作任务

VMThread::execute(&op);

HeapWord* result = op.result();

bool ret_succeeded = op.prologue_succeeded() && op.pause_succeeded();

assert(result == NULL || ret_succeeded,

"the result should be NULL if the VM did not succeed");

*succeeded = ret_succeeded;

assert_heap_not_locked();

return result;

}

真正执行的方法都为VMThread::execute(&op);,其逻辑为:

// VMThread执行操作

void VMThread::execute(VM_Operation* op) {

Thread* t = Thread::current();

// 判断当前线程是否是vm线程,这里t->is_VM_thread()返回true

if (!t->is_VM_thread()) {

// 不是虚拟机线程情况下的处理逻辑不看

// ...

} else {

// 如果是虚拟机线程

// invoked by VM thread; usually nested VM operation

assert(t->is_VM_thread(), "must be a VM thread");

// 获取当前的虚拟机任务操作

VM_Operation* prev_vm_operation = vm_operation();

if (prev_vm_operation != NULL) {

// Check the VM operation allows nested VM operation. This normally not the case, e.g., the compiler

// does not allow nested scavenges or compiles.

// 检查该VM操作是否允许嵌套VM操作

if (!prev_vm_operation->allow_nested_vm_operations()) {

fatal(err_msg("Nested VM operation %s requested by operation %s",

op->name(), vm_operation()->name()));

}

// 如果允许嵌套VM操作,就设置该vm操作的优先级

op->set_calling_thread(prev_vm_operation->calling_thread(), prev_vm_operation->priority());

}

EventMark em("Executing %s VM operation: %s", prev_vm_operation ? "nested" : "", op->name());

// Release all internal handles after operation is evaluated

HandleMark hm(t);

_cur_vm_operation = op;

// 判断任务是否需要在安全点执行且当前是否在安全点

if (op->evaluate_at_safepoint() && !SafepointSynchronize::is_at_safepoint()) {

// 如果不是安全点,则等待所有线程进入安全点,然后把线程暂时挂起

SafepointSynchronize::begin();

// 开始任务, op是刚刚传入的VM_G1IncCollectionPause操作任务类

// evaluate()方法最后会调用gc操作任务类的doit()方法

op->evaluate();

// 安全点结束

SafepointSynchronize::end();

} else {

// 是安全点则直接执行

op->evaluate();

}

// Free memory if needed

if (op->is_cheap_allocated()) delete op;

// 执行完当前操作,重新复位原操作任务

_cur_vm_operation = prev_vm_operation;

}

}

SafepointSynchronize::begin();方法中包含了准备进入安全点直到所有的线程全部进入安全点并挂起的过程,因此在此时YGC的全局停顿开始了。所以有的时候因为发生全局停顿,导致程序出现不能提供服务的时候不能只盲目的区查fullGC日志,实际上通过源码我们可以看到G1的YGC过程也会产生全局停顿。

继续进入evaluate();方法查看任务执行逻辑:

// 开始任务

void VM_Operation::evaluate() {

ResourceMark rm;

if (TraceVMOperation) {

tty->print("[");

NOT_PRODUCT(print();)

}

// 先开始执行准备操作

doit();

if (TraceVMOperation) {

tty->print_cr("]");

}

}

其中进入doit()方法中继续查看从准备工作开始的逻辑:

// G1 YGC 准备工作

void VM_G1IncCollectionPause::doit() {

G1CollectedHeap* g1h = G1CollectedHeap::heap();

assert(!_should_initiate_conc_mark || g1h->should_do_concurrent_full_gc(_gc_cause),

"only a GC locker, a System.gc(), stats update, whitebox, or a hum allocation induced GC should start a cycle");

if (_word_size > 0) {

AllocationContextMark acm(this->allocation_context());

// An allocation has been requested. So, try to do that first.

// 继续尝试分配

_result = g1h->attempt_allocation_at_safepoint(_word_size, allocation_context(),

false /* expect_null_cur_alloc_region */);

if (_result != NULL) {

// If we can successfully allocate before we actually do the

// pause then we will consider this pause successful.

_pause_succeeded = true;

return;

}

}

GCCauseSetter x(g1h, _gc_cause);

G1ContextCauseSetter set_ctxt(g1h, this->allocation_context());

// youngGC这里是之前创建VM_G1IncCollectionPause的第三个参数:false

// 表示此次youngGC不属于老年代并发gc的周期,这里直接跳过

if (_should_initiate_conc_mark) {

// ...

}

// 执行的gc方法

_pause_succeeded =

g1h->do_collection_pause_at_safepoint(_target_pause_time_ms);

// gc 成功

if (_pause_succeeded && _word_size > 0) {

AllocationContextMark acm(this->allocation_context());

// An allocation had been requested.

// 再去申请内存

_result = g1h->attempt_allocation_at_safepoint(_word_size, allocation_context(),

true /* expect_null_cur_alloc_region */);

} else {

assert(_result == NULL, "invariant");

if (!_pause_succeeded) {

// Another possible reason reason for the pause to not be successful

// is that, again, the GC locker is active (and has become active

// since the prologue was executed). In this case we should retry

// the pause after waiting for the GC locker to become inactive.

_should_retry_gc = true;

}

}

}

进入do_collection_pause_at_safepoint方法:

// 我们忽略掉一些记日志和统计数据的方法,看关键的几个方法

bool

G1CollectedHeap::do_collection_pause_at_safepoint(double target_pause_time_ms) {

assert_at_safepoint(true /* should_be_vm_thread */);

guarantee(!is_gc_active(), "collection is not reentrant");

// 判断是否有线程再临界区,如果有则舍弃本次gc,并把need_gc参数设置为true

// 这里是我们刚刚提到的gc_locker

if (GC_locker::check_active_before_gc()) {

return false;

}

// 打印一些heap日志和统计数据

_gc_timer_stw->register_gc_start();

_gc_tracer_stw->report_gc_start(gc_cause(), _gc_timer_stw->gc_start());

SvcGCMarker sgcm(SvcGCMarker::MINOR);

ResourceMark rm;

print_heap_before_gc();

trace_heap_before_gc(_gc_tracer_stw);

verify_region_sets_optional();

verify_dirty_young_regions();

// 这个方法将会判断此次youngGC是不是一次初次标记

// (即老年代并发垃圾回收时,会伴随一次youngGC,此时会返回true)

// 纯youngGC阶段这里会返回false

g1_policy()->decide_on_conc_mark_initiation();

// We do not allow initial-mark to be piggy-backed on a mixed GC.

assert(!g1_policy()->during_initial_mark_pause() ||

g1_policy()->gcs_are_young(), "sanity");

// We also do not allow mixed GCs during marking.

assert(!mark_in_progress() || g1_policy()->gcs_are_young(), "sanity");

// 是否处于初始标记停顿阶段(youngGC这里返回的是false)

bool should_start_conc_mark = g1_policy()->during_initial_mark_pause();

// Inner scope for scope based logging, timers, and stats collection

{

EvacuationInfo evacuation_info;

// youngGC这里是false我们直接跳过

if (g1_policy()->during_initial_mark_pause()) {

// We are about to start a marking cycle, so we increment the

// full collection counter.

increment_old_marking_cycles_started();

register_concurrent_cycle_start(_gc_timer_stw->gc_start());

}

// 打印GC开始日志和活跃线程数

_gc_tracer_stw->report_yc_type(yc_type());

// ...

// 将二级空闲region列表合并到主空闲列表中

// 二级空闲region列表包括之前释放的region

if (!G1StressConcRegionFreeing) {

append_secondary_free_list_if_not_empty_with_lock();

}

// ...

{ // Call to jvmpi::post_class_unload_events must occur outside of active GC

IsGCActiveMark x;

if (G1ElasticHeap) {

elastic_heap()->prepare_in_gc_start();

}

// 填充tlab,扫描所有java线程的tlab并用空对象填充,之后再重置

gc_prologue(false);

increment_total_collections(false /* full gc */);

// ...

// 启动在全局停顿时期的软引用发现执行器

ref_processor_stw()->enable_discovery(true /*verify_disabled*/,

true /*verify_no_refs*/);

{

// 关闭并发扫描阶段的软引用发现执行器

NoRefDiscovery no_cm_discovery(ref_processor_cm());

// 重置_mutator_alloc_region即主动将其中的活跃区域retire但是这次不会填充还没使用的区域

// 因为马上要gc了,之后将活跃的region并将其加入到_inc_cset_head中(增量cset)

// _mutator_alloc_region前面我们提到过是申请伊甸区内存的类

// 此时增量cset中将包含所有的eden区region

_allocator->release_mutator_alloc_region();

_hr_printer.start_gc(false /* full */, (size_t) total_collections());

double sample_start_time_sec = os::elapsedTime();

#if YOUNG_LIST_VERBOSE

gclog_or_tty->print_cr("\nBefore recording pause start.\nYoung_list:");

_young_list->print();

g1_policy()->print_collection_set(g1_policy()->inc_cset_head(), gclog_or_tty);

#endif // YOUNG_LIST_VERBOSE

g1_policy()->record_collection_pause_start(sample_start_time_sec, *_gc_tracer_stw);

double scan_wait_start = os::elapsedTime();

bool waited = _cm->root_regions()->wait_until_scan_finished();

double wait_time_ms = 0.0;

if (waited) {

double scan_wait_end = os::elapsedTime();

wait_time_ms = (scan_wait_end - scan_wait_start) * 1000.0;

}

g1_policy()->phase_times()->record_root_region_scan_wait_time(wait_time_ms);

#if YOUNG_LIST_VERBOSE

gclog_or_tty->print_cr("\nAfter recording pause start.\nYoung_list:");

_young_list->print();

#endif // YOUNG_LIST_VERBOSE

if (g1_policy()->during_initial_mark_pause()) {

concurrent_mark()->checkpointRootsInitialPre();

}

// ...

// 这里会筛选cset,这个方法会将增量cset设置成cset ,YGC时cset中将包含所有的eden区

// 同时在其中判断是否存在大对象分区的引用,

// 并将youngRegion中的survivor区全部设置成单纯的young区

// 因为gc之后老的survivor区将变成新的eden区

g1_policy()->finalize_cset(target_pause_time_ms, evacuation_info);

// ...

// 设置存放活跃对象的大小

setup_surviving_young_words();

// Initialize the GC alloc regions.

// 初始化GC要申请的region,包括要用的新的survivor区域和old区域

// 标记要GC的分区

_allocator->init_gc_alloc_regions(evacuation_info);

// Actually do the work...

// 并行处理Cset中的引用,释放内存

evacuate_collection_set(evacuation_info);

// 后面是gc的收尾工作,后面在看

// ...

return true;

}

在进入关键方法evacuate_collection_set之前,需要先讲一下接下来会涉及的知识点:

RSet 记忆集相关概念(RSet&卡表、DCQ&DCQS、Refine线程)

为了记录对象在不同代际之间的引用关系,目的是在垃圾回收的时候快速地找到活跃对象,不用遍历整个堆空间。G1中引入了新的Refine线程用于处理这种引用关系。

1.记忆集和卡表

**RSet(Remember Set,简称RSet)。**因为标记阶段需要标记所有的存活对象,而在分代垃圾收集下,新生代和老年代处于不同的收集阶段,没有必要去标记所有的存活对象。因此使用了一个RSet记录从非收集部分指向收集部分的指针的集合,描述了对象的引用关系。RSet是针对于Region的。

通常有两种方法记录引用关系:

Point Out,在RSet中记录引用对象的地址,操作简单,但是标记扫描时需要扫描所有的RSet。Point In,在RSet中记录被引用对象的地址,操作复杂,标记扫描时可以直接找到有用和无用的对象,因为RSet中的对象可以认为是根对象。

Region之间的引用关系可以划分为:

- Region内部有引用关系,垃圾回收的时候是针对分区,回收时会遍历整个分区,无需记录这种关系。

- 新生代到新生代Region,无需记录,因为三种回收算法都会全量处理新生代分区,它们会被遍历。

- 新生代到老年代Region,对于YGC来说,会针对新生代分区所以无需记录,对于混合GC来说,G1会使用新生代分区作为根,遍历新生代分区的时候自然会找到老年代分区,因此无需记录,对于Full GC来说,所有的分区都会被处理,更无需记录。

- 老年代到新生代Region,需要被记录,YGC的时候需要知道哪些对象是被老年代分区所引用的,YGC的时候有两种根,一个就是栈空间/全局空间变量的引用,另一个就是老年代分区到新生代分区的引用。

- 老年代到老年代Region,需要被记录,在混合GC的时候可能只有部分分区被回收,所以必须记录引用关系,快速找到哪些对象是活跃的。

G1中使用了Point In的方法,算法可以简化为找到需要收集的分区Region集合,所以YGC只需要扫描Root Set和RSet即可,如果对象的引用发生了变化(通常就是赋值操作),必须要通知RSet,更改其中的记录。对于一个分区来说,里面的对象可能被很多分区引用,这就要求这个分区记录所有引用者的信息,所以G1垃圾收集器使用了一种新的数据结构:PRT (Per Region Table)来记录这种变化。

那么有了RSet之后怎么来表示引用关系呢?

**卡表(card table)**全局只有一个可以理解为是一个bitmap,并且其中每个元素即是卡页(card)与堆中的512字节内存相互映射,当这512个字节中的引用发生修改时,写屏障就会把这个卡页标记为脏卡(dirty_card)。

其实在很多博客中,都提到了卡表使用的是堆空间。然而这是不正确的!

由于card_table在heap之后才会申请创建,也就是说是堆内存确认之后才会开始进行卡表的内存申请,且是随机映射,而heap是根据对应地址去映射,所以card_table并不是使用的heap空间。

我们再来看RSet:

每个HeapRegion都包含了一个HeapRegionRemSet,每个HeapRegionRemSet都包含了一个OtherRegionsTable,引用数据就保存在这个OtherRegionsTable中。

class OtherRegionsTable VALUE_OBJ_CLASS_SPEC {

BitMap _coarse_map;//粗粒度位图

PerRegionTable** _fine_grain_regions;//细粒度PRT

SparsePRT _sparse_table;//稀疏哈希表

// ...

}

OtherRegionsTable使用了三种不同的粒度来描述引用,因为G1采用了Point In,它的缺点是一个对象可能被引用多次,次数不固定,为了提高效率,使用了动态化数据结构存储,三种粒度对应RSet中的三种数据类型:

稀疏PRT:通过哈希表方式来存储。表中每个entry默认存放card index的数组长度为4。细粒度PRT:通过PRT指针的指针,所以可以简单地理解为PRT指针的数组。其数组长度可以指定也可以自动计算得到。粗粒度PRT:通过位图来指示,每一位表示对应的分区有引用到该分区数据结构。

稀疏PRT:

通过SparsePRT类中的RSHashTable进行存储,哈希表中的entry为SparsePRTEntry:

class SparsePRTEntry: public CHeapObj<mtGC> {

private:

RegionIdx_t _region_ind; // 存放被引用对象所在Region的index

int _next_index;

CardIdx_t _cards[1]; // 存放被引用对象所在的相应的卡表index

// ...

}

向稀疏PRT中entry中添加引用关系:

// 向稀疏哈希表entry中添加引用

bool RSHashTable::add_card(RegionIdx_t region_ind, CardIdx_t card_index) {

// 根据region index获取 稀疏哈希表Entry

SparsePRTEntry* e = entry_for_region_ind_create(region_ind);

assert(e != NULL && e->r_ind() == region_ind,

"Postcondition of call above.");

// 添加卡表索引到稀疏哈希表Entry

SparsePRTEntry::AddCardResult res = e->add_card(card_index);

// 如果添加卡表索引结果为added ,则将持有的卡页数量加1

if (res == SparsePRTEntry::added) _occupied_cards++;

#if SPARSE_PRT_VERBOSE

gclog_or_tty->print_cr(" after add_card[%d]: valid-cards = %d.",

pointer_delta(e, _entries, SparsePRTEntry::size()),

e->num_valid_cards());

#endif

assert(e->num_valid_cards() > 0, "Postcondition");

// 最后返回添加结果是不是overflow

return res != SparsePRTEntry::overflow;

}

继续进入其add_card方法:

// 定义好的结果状态

enum AddCardResult {

overflow,

found,

added

};

// 定义 UNROLL_CARD_LOOPS 为 1

#define UNROLL_CARD_LOOPS 1

// 添加card index

SparsePRTEntry::AddCardResult SparsePRTEntry::add_card(CardIdx_t card_index) {

// 定义好了该值为1

#if UNROLL_CARD_LOOPS

assert((cards_num() & (UnrollFactor - 1)) == 0, "Invalid number of cards in the entry");

CardIdx_t c;

// 进入循环:UnrollFactor = 4

for (int i = 0; i < cards_num(); i += UnrollFactor) {

// 如果已经存在,则返回found状态,否则就设置为该位置的值,返回added状态

c = _cards[i];

if (c == card_index) return found;

if (c == NullEntry) { _cards[i] = card_index; return added; }

c = _cards[i + 1];

if (c == card_index) return found;

if (c == NullEntry) { _cards[i + 1] = card_index; return added; }

c = _cards[i + 2];

if (c == card_index) return found;

if (c == NullEntry) { _cards[i + 2] = card_index; return added; }

c = _cards[i + 3];

if (c == card_index) return found;

if (c == NullEntry) { _cards[i + 3] = card_index; return added; }

}

#else

for (int i = 0; i < cards_num(); i++) {

CardIdx_t c = _cards[i];

if (c == card_index) return found;

if (c == NullEntry) { _cards[i] = card_index; return added; }

}

#endif

// Otherwise, we're full.

// 否则就返回 overflow状态

return overflow;

}

其中的cards_num()值为:

// Returns the size of the card array.

static int cards_num() {

// The number of cards should be a multiple of 4, because that's our current

// unrolling factor.

static const int s = MAX2<int>(G1RSetSparseRegionEntries & ~(UnrollFactor - 1), UnrollFactor);

return s;

}

G1RSetSparseRegionEntries为全局flag,值为0。所以前面G1RSetSparseRegionEntries & ~(UnrollFactor - 1)的值为0。UnrollFactor为public常量,值为4。所以这里返回的值为4。(~ 为翻位操作)

每个entry中的cards数组的长度都应该为4的倍数,因为4是我们现在使用的扩展因子。

SparsePRTEntry初始化操作,会将entry中的cards数组初始化为-1,步骤和上述相似,就不赘述了:

// 稀疏PRT初始化

void SparsePRTEntry::init(RegionIdx_t region_ind) {

_region_ind = region_ind;

// NullEntry为public常量,值为-1

_next_index = NullEntry;

#if UNROLL_CARD_LOOPS

assert((cards_num() & (UnrollFactor - 1)) == 0, "Invalid number of cards in the entry");

for (int i = 0; i < cards_num(); i += UnrollFactor) {

_cards[i] = NullEntry;

_cards[i + 1] = NullEntry;

_cards[i + 2] = NullEntry;

_cards[i + 3] = NullEntry;

}

#else

for (int i = 0; i < cards_num(); i++)

_cards[i] = NullEntry;

#endif

}

细粒度PRT

当引用逐渐增多,RSet占用的内存空间就太大了。所以会将这种引用关系记录的详细程度往下降,描述不再那么详细进而存储更多的引用关系。当稀疏表中的某一个entry中的cards数组长度为4之后,就会将该entry中的所有记录转到细粒度PRT中。

class PerRegionTable: public CHeapObj<mtGC> {

friend class OtherRegionsTable;

friend class HeapRegionRemSetIterator;

HeapRegion* _hr; // Heap Region指针

BitMap _bm; // 位图,每一位映射Region中一个card

jint _occupied; // 引用数量

// next pointer for free/allocated 'all' list

PerRegionTable* _next;

// prev pointer for the allocated 'all' list

PerRegionTable* _prev;

// next pointer in collision list

PerRegionTable * _collision_list_next;

// Global free list of PRTs

static PerRegionTable* _free_list;

}

总体结构为:是一个双向链表且一个Region一个节点,每个节点中存放了一个key是card index的位图。向细粒度PRT中添加引用为:

// 细粒度PRT添加引用关系

void add_card_work(CardIdx_t from_card, bool par) {

// 如果不在细粒度PRT的位图中,就进行添加

if (!_bm.at(from_card)) {

// par 参数代表此时是不是并行添加

if (par) {

// 并行采用CAS添加

if (_bm.par_at_put(from_card, 1)) {

// 并行,使用原子自增引用数量 + 1

Atomic::inc(&_occupied);

}

} else {

_bm.at_put(from_card, 1);

// 引用数量 + 1

_occupied++;

}

}

}

粗粒度PRT:

对于被引用很多很多的对象来说,细粒度PRT的记录数同样也会不断飙升,所以在达到了G1设定的阈值之后,会转为使用粗粒度PRT:一个Region的粗粒度表就是一个位图。位图的0和1代表Region级别的引用关系。

具体结构其实就是OtherRegionsTable中的BitMap _coarse_map:

class OtherRegionsTable VALUE_OBJ_CLASS_SPEC {

BitMap _coarse_map;//粗粒度位图

// ...

}

至于细粒度PRT什么情况下会转为粗粒度PRT以及粗粒度PRT是如何添加引用关系的,我们会在接下来的向RSet中添加引用关系的逻辑操作中看到:

我们来看OtherRegionsTable中的add_reference向RSet中添加引用相关逻辑操作:

// 向RSet中的OtherRegionsTable中添加引用关系

void OtherRegionsTable::add_reference(OopOrNarrowOopStar from, int tid) {

// 获得当前region的index序列

uint cur_hrm_ind = hr()->hrm_index();

if (G1TraceHeapRegionRememberedSet) {

gclog_or_tty->print_cr("ORT::add_reference_work(" PTR_FORMAT "->" PTR_FORMAT ").",

from,

UseCompressedOops

? (void *)oopDesc::load_decode_heap_oop((narrowOop*)from)

: (void *)oopDesc::load_decode_heap_oop((oop*)from));

}

// 计算引用者所在的卡表位置

int from_card = (int)(uintptr_t(from) >> CardTableModRefBS::card_shift);

if (G1TraceHeapRegionRememberedSet) {

gclog_or_tty->print_cr("Table for [" PTR_FORMAT "...): card %d (cache = " INT32_FORMAT ")",

hr()->bottom(), from_card,

FromCardCache::at((uint)tid, cur_hrm_ind));

}

// 卡表缓存如果存在就直接返回

if (FromCardCache::contains_or_replace((uint)tid, cur_hrm_ind, from_card)) {

if (G1TraceHeapRegionRememberedSet) {

gclog_or_tty->print_cr(" from-card cache hit.");

}

assert(contains_reference(from), err_msg("We just found " PTR_FORMAT " in the FromCardCache", from));

return;

}

// Note that this may be a continued H region.

// 获取引用者card所在的region和index

HeapRegion* from_hr = _g1h->heap_region_containing_raw(from);

RegionIdx_t from_hrm_ind = (RegionIdx_t) from_hr->hrm_index();

// If the region is already coarsened, return.

// 如果RSet已经变成了粗粒度的关系,

// 也就是说其中记录的是引用者对象所在的分区而不是对象对应的卡表地址,则可以直接返回

// 这里的_coarse_map 是一个位图也就是粗粒度存储

// 如果在粗粒度位图中,直接返回

// 这个粗粒度位图的key是region_index

if (_coarse_map.at(from_hrm_ind)) {

// G1TraceHeapRegionRememberedSet 全局bool flags

// 代表HeapRegionRSet是否启用打印debug日志

if (G1TraceHeapRegionRememberedSet) {

gclog_or_tty->print_cr(" coarse map hit.");

}

assert(contains_reference(from), err_msg("We just found " PTR_FORMAT " in the Coarse table", from));

return;

}

// RSet 不是粗粒度关系,找到细粒度RPT引用关系添加到RSet中

// Otherwise find a per-region table to add it to.

// region index根据细粒度PerRegionTable的最大容量取模

size_t ind = from_hrm_ind & _mod_max_fine_entries_mask;

// 找到对应Region的细粒度PRT:通过PRT指针的指针,所以可以简单地理解为PRT指针的数组。其数组长度可以指定也可以自动计算得到

PerRegionTable* prt = find_region_table(ind, from_hr);

if (prt == NULL) {

// 如果细粒度PRT不存在

// 多线程访问,加锁。再次确认有没有细粒度PRT、针对并发情况

// 防止万一有其它线程这个时候将RSet数据结构进行转换

MutexLockerEx x(_m, Mutex::_no_safepoint_check_flag);

// Confirm that it's really not there...

prt = find_region_table(ind, from_hr);

if (prt == NULL) {

// 双重check,确保细粒度prt真的不存在

// 使用稀疏表存储

uintptr_t from_hr_bot_card_index =

uintptr_t(from_hr->bottom())

>> CardTableModRefBS::card_shift;

// 获取card_index

CardIdx_t card_index = from_card - from_hr_bot_card_index;

assert(0 <= card_index && (size_t)card_index < HeapRegion::CardsPerRegion,

"Must be in range.");

if (G1HRRSUseSparseTable &&

// 直接加入稀疏表,如果成功则返回,失败则继续执行

_sparse_table.add_card(from_hrm_ind, card_index)) {

if (G1RecordHRRSOops) {

HeapRegionRemSet::record(hr(), from);

if (G1TraceHeapRegionRememberedSet) {

gclog_or_tty->print(" Added card " PTR_FORMAT " to region "

"[" PTR_FORMAT "...) for ref " PTR_FORMAT ".\n",

align_size_down(uintptr_t(from),

CardTableModRefBS::card_size),

hr()->bottom(), from);

}

}

if (G1TraceHeapRegionRememberedSet) {

gclog_or_tty->print_cr(" added card to sparse table.");

}

assert(contains_reference_locked(from), err_msg("We just added " PTR_FORMAT " to the Sparse table", from));

return;

} else {

// 加入失败,打印稀疏表overflow状态的日志

if (G1TraceHeapRegionRememberedSet) {

gclog_or_tty->print_cr(" [tid %d] sparse table entry "

"overflow(f: %d, t: %u)",

tid, from_hrm_ind, cur_hrm_ind);

}

}

// 判断细粒度PerRegionTable是否满了

if (_n_fine_entries == _max_fine_entries) {

// 如果满了则删除当前表非空且引用数量最多的PRT

prt = delete_region_table();

// There is no need to clear the links to the 'all' list here:

// prt will be reused immediately, i.e. remain in the 'all' list.

// 再将返回的节点重新初始化

prt->init(from_hr, false /* clear_links_to_all_list */);

} else {

// 如果没满,则证明没有这个细粒度PerRegionTable

// 申请并与所有细粒度PerRegionTable关联

prt = PerRegionTable::alloc(from_hr);

// 连接到表头

link_to_all(prt);

}

// 将新申请的或者初始化的细粒度PerRegionTable加入细粒度PerRegionTable表集合中

PerRegionTable* first_prt = _fine_grain_regions[ind];

prt->set_collision_list_next(first_prt);

// The assignment into _fine_grain_regions allows the prt to

// start being used concurrently. In addition to

// collision_list_next which must be visible (else concurrent

// parsing of the list, if any, may fail to see other entries),

// the content of the prt must be visible (else for instance

// some mark bits may not yet seem cleared or a 'later' update

// performed by a concurrent thread could be undone when the

// zeroing becomes visible). This requires store ordering.

OrderAccess::release_store_ptr((volatile PerRegionTable*)&_fine_grain_regions[ind], prt);

_n_fine_entries++;

if (G1HRRSUseSparseTable) {

// Transfer from sparse to fine-grain.

// 程序走到这说明该Region在稀疏表中对应的SparsePRTEntry的cards数组都已经被使用了

// 并且我们已经申请了一个细粒度PRT

// 那我们要将稀疏表引用信息添迁移到细粒度PRT

// 1、获取稀疏哈希表

SparsePRTEntry *sprt_entry = _sparse_table.get_entry(from_hrm_ind);

assert(sprt_entry != NULL, "There should have been an entry");

// 2、遍历稀疏哈希表,将引用信息添加到细粒度PRT中

for (int i = 0; i < SparsePRTEntry::cards_num(); i++) {

CardIdx_t c = sprt_entry->card(i);

if (c != SparsePRTEntry::NullEntry) {

prt->add_card(c);

}

}

// Now we can delete the sparse entry.

// 稀疏表没用了,可以干掉了

bool res = _sparse_table.delete_entry(from_hrm_ind);

assert(res, "It should have been there.");

}

}

assert(prt != NULL && prt->hr() == from_hr, "consequence");

}

// Note that we can't assert "prt->hr() == from_hr", because of the

// possibility of concurrent reuse. But see head comment of

// OtherRegionsTable for why this is OK.

assert(prt != NULL, "Inv");

// 以上,数据结构转换完毕,将本次新增引用记录添加到细粒度PRT

// 加入PerRegionTable的位图中,这个位图key是card index

prt->add_reference(from);

if (G1RecordHRRSOops) {

HeapRegionRemSet::record(hr(), from);

if (G1TraceHeapRegionRememberedSet) {

gclog_or_tty->print("Added card " PTR_FORMAT " to region "

"[" PTR_FORMAT "...) for ref " PTR_FORMAT ".\n",

align_size_down(uintptr_t(from),

CardTableModRefBS::card_size),

hr()->bottom(), from);

}

}

assert(contains_reference(from), err_msg("We just added " PTR_FORMAT " to the PRT", from));

}

总体流程其实并不繁琐,现在对于之前保留的两个问题进行解答。细粒度在什么条件下会转换为粗粒度呢,我们可以看到在_n_fine_entries == _max_fine_entries这里的判断条件。在判断细粒度PerRegionTable是否满了的地方,也就是判断细粒度PRT是否达到了JVM给细粒度设定的阈值。如果没有达到,那么就会分配内存存值,并且会连接到细粒度PRT双向链表的表头。反之,如果没有达到,就会进入delete_region_table()方法。

关于转换的相关逻辑细节就需要进入delete_region_table()方法进行查看:

// 细粒度PRT转粗粒度PRT,并删除当前细粒度PRT

PerRegionTable* OtherRegionsTable::delete_region_table() {

assert(_m->owned_by_self(), "Precondition");

assert(_n_fine_entries == _max_fine_entries, "Precondition");

PerRegionTable* max = NULL;

jint max_occ = 0;

PerRegionTable** max_prev = NULL;

size_t max_ind;

size_t i = _fine_eviction_start;

// _fine_eviction_sample_size 细粒度PRT中已存个数

for (size_t k = 0; k < _fine_eviction_sample_size; k++) {

size_t ii = i;

// Make sure we get a non-NULL sample.

// 从细粒度PRT中_fine_eviction_start位置开始,找到第一个不为null的位置

while (_fine_grain_regions[ii] == NULL) {

ii++;

if (ii == _max_fine_entries) ii = 0;

guarantee(ii != i, "We must find one.");

}

// 将当前cur指针指向刚刚寻找到的位置

PerRegionTable** prev = &_fine_grain_regions[ii];

PerRegionTable* cur = *prev;

while (cur != NULL) {

// 获取当前Region index的key下的引用数量

jint cur_occ = cur->occupied();

if (max == NULL || cur_occ > max_occ) {

// 如果max还没有赋值或者引用数量大于max引用数量

// 使用max 保存当前相关数据

max = cur;

max_prev = prev;

max_ind = i;

max_occ = cur_occ;

}

// 获取下一个

prev = cur->collision_list_next_addr();

cur = cur->collision_list_next();

}

i = i + _fine_eviction_stride;

if (i >= _n_fine_entries) i = i - _n_fine_entries;

}

_fine_eviction_start++;

if (_fine_eviction_start >= _n_fine_entries) {

_fine_eviction_start -= _n_fine_entries;

}

guarantee(max != NULL, "Since _n_fine_entries > 0");

guarantee(max_prev != NULL, "Since max != NULL.");

// Set the corresponding coarse bit.

// 转换为粗粒度PRT位图

// 获取region index,这里的max实际上应该细粒度PRT中引用个数最多的那个

size_t max_hrm_index = (size_t) max->hr()->hrm_index();

// 如果粗粒度位图中没有这个region index

if (!_coarse_map.at(max_hrm_index)) {

// 就在位图塞入 key - region index,value - true

_coarse_map.at_put(max_hrm_index, true);

// 将 entry 数量 + 1

_n_coarse_entries++;

// 这里还是判断是否开启日志

if (G1TraceHeapRegionRememberedSet) {

gclog_or_tty->print("Coarsened entry in region [" PTR_FORMAT "...] "

"for region [" PTR_FORMAT "...] (%d coarse entries).\n",

hr()->bottom(),

max->hr()->bottom(),

_n_coarse_entries);

}

}

// Unsplice.

*max_prev = max->collision_list_next();

// 是否已经进行粗化, 原子自增1

Atomic::inc(&_n_coarsenings);

// 细粒度PRT中entry个数减一

_n_fine_entries--;

return max;

}

总体上来看其实就是,找到细粒度PRT中不为空并且引用数量最多的那个节点,将这个节点从细粒度双向链表中去除,并且存入在粗粒度PRT中的位图中。返回此节点重新进行初始化,之后再接回细粒度PRT中供再次使用。

OK,到这里关于引用关系存储结构这块就结束了。那么就会得到下一个问题:

有了RSet这样的动态存储引用关系的数据结构之后,我们应该通过什么样的方式来管理这样的引用数据?以及通过什么样的方式来提高处理这些引用关系的能力呢?

想要知道这两个问题的答案,就需要了解下一个相关的知识点。

2.Refine线程、DCQ&DCQS

Refine线程是G1新引入的并发线程,线程默认个数为G1ConcRefinementThreads + 1,如果没有设置则为ParallelGCThreads个 , 功能为:

- 处理新生代分区的抽样,并且在满足响应时间的这个指标下,更新YHR的个数,通常有一个线程来处理。我们把用于此功能的线程称为抽样线程。

- 主要功能:管理RSet,RSet的更新并不是同步完成的,G1会把所有的引用关系都先放入到一个队列中,称为

dirty card queue(DCQ),然后使用线程来消费这个队列以完成更新。正常来说有G1ConcRefinementThreads个线程处理;实际上除了Refine线程更新RSet之外,GC线程或者Mutator也可能会更新RSet;DCQ通过Dirty Card Queue Set(DCQS)来管理;为了能够并发地处理,每个Refine线程只负责DCQS中的某几个DCQ。

下面我们来详细介绍一下这些功能:

抽样处理新生代分区

Refine线程池中的最后一个线程就是抽样线程,主要作用是设置新生代分区的个数,使得G1满足垃圾回收的预测停顿时间。G1是一个响应时间优先的GC算法,用户可以设定整个GC过程的期望停顿时间,可以通过参数MaxGCPauseMillis控制,默认值为200ms。但是这个值只是期望值,表示G1会尽可能的在这个时间范围内完成垃圾回收的工作,但是并不能保证一定可以完成垃圾回收工作。

那么为什么满足垃圾回收预测停顿时间需要设置新生代分区个数呢?

对于Young GC来说,会逐渐减少Eden区个数,减少Eden空间那么Young GC的处理时间就会相应减少,因此会无法满足垃圾回收预测停顿时间。并且减少Eden的总空间时,就会更加频繁的触发Young GC,也就是会加快Mixed GC的执行频率,因为Mixed GC是由Young GC触发的,或者说借机同时执行的。频繁GC会对应用的吞吐量造成影响,每次Mixed GC回收时间太短,回收的垃圾量太少,可能最后GC的垃圾清理速度赶不上应用产生的速度,可能会造成串行的Full GC,这是要极力避免的。

同时为了满足用户的期望,G1还使用了停顿预测模型。G1根据这个模型统计计算出来的历史数据来预测本次收集需要的堆分区数量,也就是选择收集哪些内存空间。最简单的方法就是使用算术的平均值建立一个线性关系来进行预测。比如:过去10次一共收集了10GB的内存,花费了1s。那么在200ms的时间下,最多可以收集2GB的内存空间。而G1的预测逻辑是基于衰减平均值和衰减标准差来确定的。

衰减平均: 用来计算一个数列的平均值,核心是给近期的数据更高的权重,强调近期数据对结果的印象。

G1还可以自适应扩展内存空间的。参数-XX:GCTimeRatio表示了GC和应用的耗时比,默认为9。也就是说如果GC时间和应用时间占比不超过10%的话就不需要动态扩展。有一个参数G1ExpandByPercentOfAvailable(默认值为20)为一次扩展的比例。每次都至少从未提交的内存中申请20%大小的空间。当然也存在下限要求最少不能少于1MB,最大也不能超过当前已分配内存的一倍。

Refine优化线程的执行逻辑都存在于ConcurrentG1RefineThread::run()方法中,在这里就先介绍其中抽样线程的执行部分:

// 设置YHR - 新生代分区的个数,使G1满足GC的预测停顿时间-XX:MaxGCPauseMillis

void ConcurrentG1RefineThread::run_young_rs_sampling() {

// 获取DCQS - 线程共享

DirtyCardQueueSet& dcqs = JavaThread::dirty_card_queue_set();

_vtime_start = os::elapsedVTime();

// while 循环采样

while(!_should_terminate) {

// 采样方法

sample_young_list_rs_lengths();

if (os::supports_vtime()) {

_vtime_accum = (os::elapsedVTime() - _vtime_start);

} else {

_vtime_accum = 0.0;

}

// 加锁 - 线程共享、并发

MutexLockerEx x(_monitor, Mutex::_no_safepoint_check_flag);

if (_should_terminate) {

break;

}

// 每次采样间隔时间G1ConcRefinementServiceIntervalMillis

// 使用参数G1ConcRefinementServiceIntervalMillis控制抽样线程运行的频度,如果发现采样不足可以减少该时间,如果系统运行稳定满足预测时间,可以增大该值减少采样

_monitor->wait(Mutex::_no_safepoint_check_flag, G1ConcRefinementServiceIntervalMillis);

}

}

具体的抽样逻辑存在于方法sample_young_list_rs_lengths();中:

// Refine 线程采样方法,在 GC 停顿之间循环执行,迭代统计 CSet 中Reigon的 RSet 长度。

void ConcurrentG1RefineThread::sample_young_list_rs_lengths() {

SuspendibleThreadSetJoiner sts;

// 获取G1管理的堆空间

G1CollectedHeap* g1h = G1CollectedHeap::heap();

// G1收集器的当前策略对象

G1CollectorPolicy* g1p = g1h->g1_policy();

// 判断是否开启自适应策略

// 默认开启自适应策略,但是有两种情况会关闭:

// 设置了 NewRatio(但是未设置 NewSize 和 MaxNewSize)设置了 NewRatio(但是未设置 NewSize 和 MaxNewSize)

// 设置了 NewSize 和 MaxNewSize,并且数值一致(也就是设置 Xmn)

if (g1p->adaptive_young_list_length()) {

int regions_visited = 0;

// 初始化新生代分区链表的采样长度和位置

g1h->young_list()->rs_length_sampling_init();

// 循环将抽样分区加入到新生代分区集合

// young_list是所有新生代分区形成的一个链表

// rs_length_sampling_more判断当前分区指针是否为null,也就是判断当前操作是否可以继续执行下去

while (g1h->young_list()->rs_length_sampling_more()) {

// rs_length_sampling_next 处理一个分区,并将分区指针指向新生代分区链表中下一个分区

// 总体操作为:对新生代分区链表中的每个Region都判断是否在新生代回收集合CSet中,如果在,则将这个Region的RSet大小也就是它的PRT的分区个数加入到新生代回收需要处理的分区数目中

g1h->young_list()->rs_length_sampling_next();

// 当前线程处理分区个数加一

++regions_visited;

// 每次处理10个分区、主动让出cpu

// we try to yield every time we visit 10 regions

if (regions_visited == 10) {

if (sts.should_yield()) {

sts.yield();

// we just abandon the iteration

break;

}

regions_visited = 0;

}

}

// 用上面抽样数据更新YHR数目

// 使用停顿预测模型更新新生代分区数目

g1p->revise_young_list_target_length_if_necessary();

}

}

真正修正数目的操作则是在revise_young_list_target_length_if_necessary();中:

// 更新YHR数据方法 (修正新生代分区数目)

void G1CollectorPolicy::revise_young_list_target_length_if_necessary() {

guarantee( adaptive_young_list_length(), "should not call this otherwise" );

// 获取上面采样数目,每次采样所采样的RSet中被引用Region的个数大小

size_t rs_lengths = _g1->young_list()->sampled_rs_lengths();

// 判断大小是否超过了预测的大小

if (rs_lengths > _rs_lengths_prediction) {

// 将预测大小增加10%

// add 10% to avoid having to recalculate often

size_t rs_lengths_prediction = rs_lengths * 1100 / 1000;

// 更新数目,参数为采样得到的分区数目,使用方法为停顿预测模型

update_young_list_target_length(rs_lengths_prediction);

}

}

如果大小超过了预测的大小,就将预测的大小增加10%,并在update_young_list_target_length方法中通过停顿预测模型计算出分区个数之后进行更新。这里读者就不进行过多赘述了,想深入了解G1的停顿预测模型的同学可以继续从这里深入进行了解。

上面的源码中还提到了一下DCQS,虽然并没有涉及到使用,但是会在下一个功能点中大量涉及同时也是为了让读者更好地理解逻辑,所以我会在下一个功能点中进行相关介绍。

管理Remeber Set

G1中使用Refine线程异步维护和管理RSet的引用关系,因为是异步所以必须要有一个数据结构来维护这些需要引用的对象。JVM声明了一个全局的静态变量DirtyCardQueueSet(DCQS),每个DCQS中存放的是DirtyCardQueue(DCQ),为了性能,所有处理引用关系的线程共享DCQS,每个用户线程Mutator线程在初始化的时候都会关联DCQS。

每个用户线程都有一个私有的DCQ,每个队列的最大长度由G1UpdateBufferSize(默认256)确定,即最多存放256个引用关系对象。每次的引用修改都会执行写后屏障方法(简单理解类似切面),而写后屏障方法会把对应位置的卡页标记为脏卡,并加入DCQ中,这样所有的有效引用关关系都会在DCQ中,只要我们处理DCQ,就可以从中过滤出所有跨代引用。当满256个时,就把这个队列加入到DCQS中,因为DCQS被所有线程共享,所以放入时需要加锁,当然也可以手动提交当前线程的队列,但是当队列还没有满的时候,提交时需要指明有多少个引用关系,DCQ也是通过Refine线程来进行处理的。

dirty_card_queue_set().initialize(NULL, // Should never be called by the Java code

DirtyCardQ_CBL_mon, // 全局montior锁

DirtyCardQ_FL_lock,

-1, // never trigger processing 不需要处理

-1, // no limit on length 不做长度限制

Shared_DirtyCardQ_lock,

&JavaThread::dirty_card_queue_set() // java线程关联上DCQS,每个JavaTHread都可以通过dirty_card_queue_set()方法拿到DCQS

);

以上是初始化DCQS的方法,这里全局的Monitor的目的为:任意的用户线程都可以通过JavaThread中的静态方法找到DCQS这个静态成员变量,当DCQ满了之后就会把DCQ加入到DCQS中,当DCQ加入成功并且满足一定的条件(DCQS中DCQ的个数大于一个阈值,这个阈值和Green Zone相关),就会获取静态变量Monitor,然后通过这个Monitor发送Notify通知0号Refine线程启动,因为0号Refine线程可能会被任意一个用户线程通知,所以这里的Monitor是一个全局变量。

我们来看将对象加入到DCQ的逻辑:

// 把对象放入DCQ中,实际上DCQ就是一个buffer

void enqueue(void* ptr) {

if (!_active) return;

else

// 判断当前DCQ是否还有空间

enqueue_known_active(ptr);

}

继续下一步enqueue_known_active(ptr);:

// 根据判断当前DCQ是否还有空间来执行相关操作

void PtrQueue::enqueue_known_active(void* ptr) {

assert(0 <= _index && _index <= _sz, "Invariant.");

assert(_index == 0 || _buf != NULL, "invariant");

// _index个人理解为buffer的剩余空间大小 只有初始化和_buf满时_index会为0

while (_index == 0) {

// 处理index为0的情况

handle_zero_index();

}

assert(_index > 0, "postcondition");

// oopSize 在全局常量定义类中定义为一个char指针大小

_index -= oopSize;

_buf[byte_index_to_index((int)_index)] = ptr;

assert(0 <= _index && _index <= _sz, "Invariant.");

}

这里的_buf[]数组其实就是DCQ类中用于存放数据的地方。这里的_index其实是代表的是_buf[]的大小而不是下标。下标是通过byte_index_to_index((int)_index)进行计算所得,_index的值会在初始化的时候被设为0,以及在reset方法中被设为_buf[]大小的值。oopSize的值是被定义在JVM中的全局常量定义类中的,为sizeof(char*)其实就是一个指针大小,指针的大小和指针类型并没有什么关系都是4Byte大小。所以就不难理解为什么_index在加入对象到该DCQ后需要减去oopSize大小的原因了。因为存在_buf[]中的是指针,而_index代表的其实是_buf[]的大小。因此需要扣除存入指针的大小。

我们继续往下看handle_zero_index();这个方法只有在初始化和扩容的时候会进入:

// 对index为0的情况进行处理

// 只有在初始化和扩容的时候会进入

void PtrQueue::handle_zero_index() {

assert(_index == 0, "Precondition.");

// This thread records the full buffer and allocates a new one (while

// holding the lock if there is one).

// 判断是初始化还是扩容为null则为初始化

// true为DCQ已满

if (_buf != NULL) {

// should_enqueue_buffer 这里始终为true

if (!should_enqueue_buffer()) {

assert(_index > 0, "the buffer can only be re-used if it's not full");

return;

}

// 这个锁是和本DCQ关联的,将DCQ加入DCQS必须保证操作唯一

if (_lock) {

assert(_lock->owned_by_self(), "Required.");

// buf 指向原_buf[]内容

void** buf = _buf; // local pointer to completed buffer

// _buf 清除数据置空

_buf = NULL; // clear shared _buf field

// 加锁处理入队

locking_enqueue_completed_buffer(buf); // enqueue completed buffer

// While the current thread was enqueuing the buffer another thread

// may have a allocated a new buffer and inserted it into this pointer

// queue. If that happens then we just return so that the current

// thread doesn't overwrite the buffer allocated by the other thread

// and potentially losing some dirtied cards.

// 因为在加锁处理入队方法中对_lock进行了解锁,加上之前将_buf置空,所以可能有另外一个线程走到了下面的分配内存逻辑,所以这里如果不为null就直接返回

if (_buf != NULL) return;

} else {

// 处理DCQ,根据情况判断是否需要用户线程介入

if (qset()->process_or_enqueue_complete_buffer(_buf)) {

// Recycle the buffer. No allocation.

// 说明用户线程暂停执行应用代码,帮助处理DCQ,所以此时可以重用DCQ

_sz = qset()->buffer_size();

_index = _sz;

return;

}

}

}

// Reallocate the buffer

// 重新为DCQ中的_buf分配内存空间 / 初始化分配内存

_buf = qset()->allocate_buffer();

_sz = qset()->buffer_size();

// index 重新被设置为_buf的大小

_index = _sz;

assert(0 <= _index && _index <= _sz, "Invariant.");

}

把DCQ加入到DCQS的方法是enqueue_complete_buffer,它定义在PtrQueueSet中,PtrQueueSet是DirtyCardQueueSet的父类。process_or_enqueue_complete_buffer(_buf)和locking_enqueue_completed_buffer(buf)都会通过这个方法来实现将DCQ加入到DCQS中。我们继续来看process_or_enqueue_complete_buffer(_buf)这个方法:

// 处理DCQ,根据情况判断是否需要用户线程介入

bool PtrQueueSet::process_or_enqueue_complete_buffer(void** buf) {

// 判断当前线程是否是java线程也就是用户线程

if (Thread::current()->is_Java_thread()) {

// We don't lock. It is fine to be epsilon-precise here.

// 说明需要用户线程介入,没有加锁,允许一定的竞争,原因在于如果条件不满足,最坏的后果就是用户线程处理

// 如果是java线程判断当前refine线程负载也就是DCQS是否达到了红色区域

if (_max_completed_queue == 0 || _max_completed_queue > 0 &&

_n_completed_buffers >= _max_completed_queue + _completed_queue_padding) {

// 用户线程处理buff,实现在dirtyCardQueue.cpp中

bool b = mut_process_buffer(buf);

if (b) {

// True here means that the buffer hasn't been deallocated and the caller may reuse it.

return true;

}

}

}

// The buffer will be enqueued. The caller will have to get a new one.

// 用户线程没有介入,将buffer(DCQ)加入到DCQS中

enqueue_complete_buffer(buf);

return false;

}

在process_or_enqueue_complete_buffer中如果Mutator发现refine线程的负载已经到了红色区域也就是DCQS已经快满了,那么就不继续往DCQS中添加了,这个时候说明引用变更太多了,Refine线程负载太重,这个Mutator就会暂停代码执行,替代Refine线程来更新RSet。

Refine线程忙不过来时,G1会让用户线程帮忙处理引用变更。Refine线程的个数可以由用户设置,但是仍然可能存在因为对象引用修改太多,导致Refine线程太忙,处理不过来。所以让用户线程来处理引用变更,这样不仅可以暂停业务处理,还可以帮助处理引用关系。如果发生这种情况,要么就是修改关系太多,要么就是Refine线程数目设置太少。我们可以通过参数G1SummarizeRSetStats打开RSet处理过程中的日志,可以在其中查看处理线程的信息。

有些同学可能对这里所描述的线程负载和"红色区域"的关系有些模糊,之后的逻辑过程正好也需要使用到这部分的相关概念,因此在这里优先介绍一下这部分知识。

Refinement Zone

JVM为了防止没有足够多的引用变更关系从而导致Refine线程空转的现象,通过wait和notify来控制Refine的冻结和激活,设计思想为:前一个线程发现自己太忙,就会激活后一个线程,后一个线程发现自己太闲,就会主动冻结自己,第0个线程则由java【用户】线程来进行激活。如果用户线程尝试把修改的引用放入到队列的时候,如果0号线程还没有被激活,那么就发送notify信号来激活0号线程,因为0号线程可能被任意的用户线程激活,所以0号线程等待的是一个全局的变量的monitor,剩余之后的线程中的monitor则全部都为局部变量。

我们知道Refine线程的工作情况会根据其负载情况而改变,如果线程负载大则会唤醒后一个Refine线程一起工作,如果DCQS太满,所有的Refine线程负载都很大则会使用用户线程来帮助Refine线程进行处理引用关系。而这里的工作负载就是通过Refinement Zone来进行控制的,G1提供三个值,分别为Green、Yellow、Red,将整个DCQS计划分为四个区:

- 白区:[0,Green) ,此区域内,Refine线程不处理,交给GC线程来处理DCQ

- 绿区:[Green,Yellow),该区中,Refine线程开始启动,根据DCQS的大小启动不同数量的Refine线程来处理DCQ

- 黄区:[Yellow,Red),该区中,所有的Refine线程(除了抽样线程)都会参与DCQ处理

- 红区:[Red,无穷),在黄区处理的基础上还要加上用户线程也会参与处理DCQ

稍微了解了Refinement Zone的相关知识点之后,我们继续来查看如果DCQS已经使用到了红区,用户线程是如何来处理的:

// 用户线程操作buffer

bool DirtyCardQueueSet::mut_process_buffer(void** buf) {

// Used to determine if we had already claimed a par_id

// before entering this method.

bool already_claimed = false;

// We grab the current JavaThread.

// 获取当前java线程

JavaThread* thread = JavaThread::current();

// We get the the number of any par_id that this thread

// might have already claimed.

// 获取线程par_id

uint worker_i = thread->get_claimed_par_id();

// If worker_i is not UINT_MAX then the thread has already claimed

// a par_id. We make note of it using the already_claimed value

// 如果worker_i不为 unint_max 就证明线程已经申请过par_id

if (worker_i != UINT_MAX) {

already_claimed = true;

} else {

// 否则重新获取个par_id

// Otherwise we need to claim a par id

worker_i = _free_ids->claim_par_id();

// 存储par_id

// And store the par_id value in the thread

thread->set_claimed_par_id(worker_i);

}

bool b = false;

if (worker_i != UINT_MAX) {

// 处理脏卡队列的主要逻辑操作

b = DirtyCardQueue::apply_closure_to_buffer(_mut_process_closure, buf, 0,

_sz, true, worker_i);

if (b) Atomic::inc(&_processed_buffers_mut);

// If we had not claimed an id before entering the method

// then we must release the id.

// 如果是本次调用申请的par_id则要归还

if (!already_claimed) {

// 归还par_id

// we release the id

_free_ids->release_par_id(worker_i);

//同时将线程par_id设置为 uint_max

// and set the claimed_id in the thread to UINT_MAX

thread->set_claimed_par_id(UINT_MAX);

}

}

return b;

}

其中调用了关键方法apply_closure_to_buffer来处理脏卡队列。其实这个方法也是refine线程用来处理脏卡时会调用的逻辑方法。具体的refine线程的运行逻辑存在于ConcurrentG1RefineThread::run()中:

// Refine 线程的主要工作逻辑

void ConcurrentG1RefineThread::run() {

// 初始化线程私有信息

initialize_in_thread();

wait_for_universe_init();

// 最后一个线程用于处理YHR的数目 (worker_id 线程id,判断是否是最后一个Refine线程)

if (_worker_id >= cg1r()->worker_thread_num()) {

// 进行抽样预测使得停顿时间可以满足要求并调整YHR的数目

run_young_rs_sampling();

terminate();

return;

}

_vtime_start = os::elapsedVTime();

// 根据当前线程的_should_terminate属性判断是否应该终止

// 如果不是最后一个Refine线程,则没有调用terminate();

// 因此以下逻辑只能用于0 ~(n-1)的真正的Refine线程,处理RSet

while (!_should_terminate) {

DirtyCardQueueSet& dcqs = JavaThread::dirty_card_queue_set();

// Wait for work

// 前一线程通知后一个线程实现,0号线程由Mutator通知

wait_for_completed_buffers();

if (_should_terminate) {

break;

}

_sts.join();

do {

int curr_buffer_num = (int)dcqs.completed_buffers_num();

// If the number of the buffers falls down into the yellow zone,

// that means that the transition period after the evacuation pause has ended.

if (dcqs.completed_queue_padding() > 0 && curr_buffer_num <= cg1r()->yellow_zone()) {

dcqs.set_completed_queue_padding(0);

}

// 根据负载判断是否需要停止当前的Refine线程

if (_worker_id > 0 && curr_buffer_num <= _deactivation_threshold) {

// If the number of the buffer has fallen below our threshold

// we should deactivate. The predecessor will reactivate this

// thread should the number of the buffers cross the threshold again.

deactivate();

break;

}

// 根据负载判断是否需要通知/启动新的Refine线程

// Check if we need to activate the next thread.

if (_next != NULL && !_next->is_active() && curr_buffer_num > _next->_threshold) {

_next->activate();

}

// Refine线程的主要工作就是处理DCQS,其逻辑就在apply_closure_to_completed_buffer中

// _worker_id + _worker_id_offset, 工作线程要处理的开始位置,使得不同的Refine线程处理DCQS中不同的DCQ

// cg1r()->green_zone() ,就是Green Zone的数值,所有的Refine线程在处理的时候都知道要跳过多少至少Green个的DCQ

} while (dcqs.apply_closure_to_completed_buffer(_worker_id + _worker_id_offset, cg1r()->green_zone()));

// We can exit the loop above while being active if there was a yield request.

// 当有yield请求时退出循环,目的是为了进入安全点

if (is_active()) {

deactivate();

}

_sts.leave();

if (os::supports_vtime()) {

_vtime_accum = (os::elapsedVTime() - _vtime_start);

} else {

_vtime_accum = 0.0;

}

}

assert(_should_terminate, "just checking");

terminate();

}

最后一个Refine线程处理YHR的数目,具体逻辑已经在之前给出了。之后调用了DCQS中的方法apply_closure_to_completed_buffer会走到以下逻辑方法:

// refine线程实际run()中while调用本方法

bool DirtyCardQueueSet::apply_closure_to_completed_buffer(CardTableEntryClosure* cl,

uint worker_i,

int stop_at,

bool during_pause) {

assert(!during_pause || stop_at == 0, "Should not leave any completed buffers during a pause");

// 这个方法是获取已经满的buf

// stop_at是之前传入的绿标记,即Refine线程只处理白标记到绿标记之间的

BufferNode* nd = get_completed_buffer(stop_at);

// 进行处理

bool res = apply_closure_to_completed_buffer_helper(cl, worker_i, nd);

if (res) Atomic::inc(&_processed_buffers_rs_thread);

return res;

}

继续查看apply_closure_to_completed_buffer_helper:

bool DirtyCardQueueSet::

apply_closure_to_completed_buffer_helper(CardTableEntryClosure* cl,

uint worker_i,

BufferNode* nd) {

if (nd != NULL) {

void **buf = BufferNode::make_buffer_from_node(nd);

size_t index = nd->index();

// 可以看到还是调用和Mutator同样的方法,更新RSet

bool b =

DirtyCardQueue::apply_closure_to_buffer(cl, buf,

index, _sz,

true, worker_i);

// 更新成功

if (b) {

// 将该空缓冲区返回到空闲列表

deallocate_buffer(buf);

return true; // In normal case, go on to next buffer.

} else {

// 更新失败就继续尝试将本DCQ加入DCQS中

enqueue_complete_buffer(buf, index);

return false;

}

} else {

return false;

}

}

不难看出这里的apply_closure_to_buffer是和之前用户线程所调用的方法一致。于是通过查看此方法逻辑就可以得知G1在Refine线程和用户线程中是如何更新RSet的:

bool DirtyCardQueue::apply_closure_to_buffer(CardTableEntryClosure* cl,

void** buf,

size_t index, size_t sz,

bool consume,

uint worker_i) {

if (cl == NULL) return true;

for (size_t i = index; i < sz; i += oopSize) {

// 获取 index

int ind = byte_index_to_index((int)i);

jbyte* card_ptr = (jbyte*)buf[ind];

if (card_ptr != NULL) {

// Set the entry to null, so we don't do it again (via the test

// above) if we reconsider this buffer.

if (consume) buf[ind] = NULL;

// 实现关键

// 闭包方法do_card_ptr

if (!cl->do_card_ptr(card_ptr, worker_i)) return false;

}

}

return true;

}

其中的do_card_ptr是一个闭包方法是一种带有上下文的函数是能够读取其他函数内部变量的函数,在JVM中可以调用这个闭包方法的类为:RefineCardTableEntryClosure、ClearLoggedCardTableEntryClosure、RedirtyLoggedCardTableEntryClosure、RefineRecordRefsIntoCSCardTableEntryClosure。在本场景中Refine和Mutator线程中都是:RefineCardTableEntryClosure,在之后要继续介绍的YoungGC中则是:RefineRecordRefsIntoCSCardTableEntryClosure。

bool do_card_ptr(jbyte* card_ptr, uint worker_i) {

bool oops_into_cset = G1CollectedHeap::heap()->g1_rem_set()->refine_card(card_ptr, worker_i, false);

// This path is executed by the concurrent refine or mutator threads,