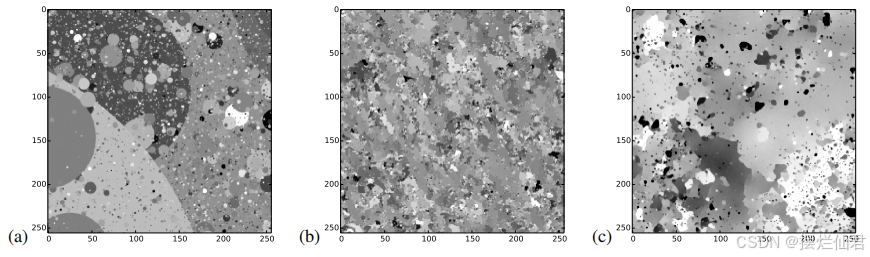

Diffusion models是一种生成模型,其受到非平衡统计物理中的扩散过程启发,特别是Jarzynski等式和Anneaualed Importance Sampling(AIS),通过模拟物理扩散过程来逐步从噪声中恢复出数据分布。这些模型通过模拟一个从数据分布到一个简单分布(通常是高斯分布)的前向扩散过程,然后学习一个逆向过程,将简单分布恢复为原始数据分布。

一、前向扩散过程(Forward Diffusion Process)

前向扩散过程是将结构化的数据分布逐渐转换成一个简单的分布(通常是高斯分布)。这个过程模拟了物理中的扩散现象,其中数据的“结构”被逐步破坏,最终变成一个均匀的噪声分布。在这个过程中,我们向数据中添加高斯噪声,模拟扩散过程。

import torch

def forward_diffusion(data, beta):

"""

模拟前向扩散过程。

data: 原始数据 (Tensor)

beta: 扩散率,控制每一步的噪声水平

"""

noise = torch.randn_like(data) * torch.sqrt(beta)

diffused_data = data + noise

return diffused_data

# 示例数据

data = torch.randn(100, 10) # 100个样本,每个样本10维

beta = 0.1

diffused_data = forward_diffusion(data, beta) 在这段代码中,data是我们的原始数据,beta是控制噪声水平的参数。我们生成与数据形状相同的高斯噪声,并将其添加到原始数据中,得到扩散后的数据。

二、逆向扩散过程(Reverse Diffusion Process)

逆向扩散过程是前向扩散的逆过程,目的是从简单的分布(噪声)中恢复出原始数据。这个过程通常需要一个模型来预测每一步中去除噪声的最佳估计。我们使用一个简单的神经网络模型来预测逆向过程中的均值和方差。

import torch.nn as nn

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.fc = nn.Linear(10, 10)

def forward(self, x):

return self.fc(x)

model = SimpleModel()

diffused_data = torch.randn(100, 10) # 假设的扩散数据

denoised_data = reverse_diffusion(diffused_data, beta, model) 在这里,SimpleModel是一个简单的线性模型,用于预测每一步逆向扩散中的去噪数据。reverse_diffusion函数(需要实现)将使用这个模型来预测数据的去噪版本。

三、训练过程(Training)

训练diffusion models涉及优化模型参数,使得逆向扩散过程能够尽可能地恢复原始数据。这通常通过最大化对数似然的下界来实现。我们定义一个训练循环,通过最小化重建误差来训练模型。

def train_model(model, data, epochs=100, lr=0.001):

"""

训练模型。

model: 要训练的模型

data: 训练数据

epochs: 训练轮数

lr: 学习率

"""

optimizer = torch.optim.Adam(model.parameters(), lr=lr)

criterion = nn.MSELoss()

for epoch in range(epochs):

optimizer.zero_grad()

outputs = model(data)

loss = criterion(outputs, data)

loss.backward()

optimizer.step()

if epoch % 10 == 0:

print(f'Epoch {epoch+1}, Loss: {loss.item()}')

model = SimpleModel()

train_model(model, data, epochs=100, lr=0.001) 在这段代码中,我们使用Adam优化器和均方误差损失函数来训练我们的SimpleModel。每一轮迭代中,我们计算模型输出和真实数据之间的损失,然后反向传播以更新模型参数。

四、模型概率和评估

评估diffusion models的性能通常涉及到计算模型对数据的拟合度,即模型概率。这可以通过计算重建误差或对数似然来实现。我们定义一个评估函数来计算测试数据上的损失。

def evaluate_model(model, test_data):

"""

评估模型。

model: 训练好的模型

test_data: 测试数据

"""

model.eval()

with torch.no_grad():

outputs = model(test_data)

loss = nn.MSELoss()(outputs, test_data)

return loss.item()

test_data = torch.randn(100, 10)

test_loss = evaluate_model(model, test_data)

print(f'Test Loss: {test_loss}')这段代码中,我们使用均方误差损失来评估模型在测试数据上的性能。较低的损失表示模型能够更好地从噪声中恢复出原始数据。

五、分布乘法和后验计算

在某些应用中,如图像修复或去噪,我们可能需要将模型分布与另一个分布(例如,观测数据的分布)相乘以计算后验分布。这允许我们在存在噪声或不完整信息的情况下进行推断。我们定义一个函数来模拟这一过程,通过将模型分布与观测数据的分布相乘来计算后验分布。

def compute_posterior(model, data, noise_level):

"""

计算后验分布。

model: 训练好的模型

data: 观测数据

noise_level: 噪声水平

"""

noise = torch.randn_like(data) * noise_level

noisy_data = data + noise

denoised_data = model(noisy_data)

return denoised_data

posterior_data = compute_posterior(model, test_data, noise_level=0.1)在这段代码中,我们首先向观测数据添加噪声,然后使用训练好的模型来预测去噪数据,这可以被看作是在给定噪声水平下的后验分布。

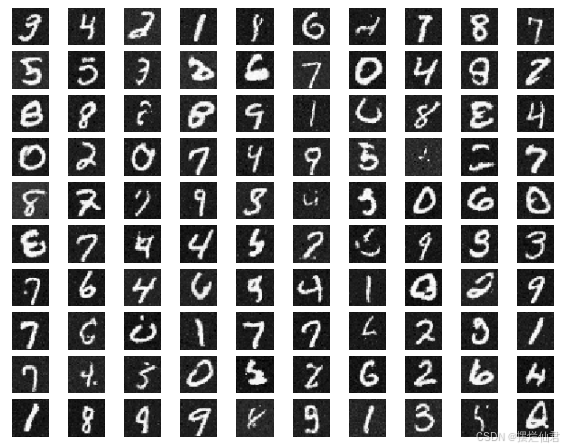

六、手写数字图像生成案例

创建一个完整的diffusion模型涉及到复杂的步骤和深度学习知识,但我可以提供一个简化的示例,以展示diffusion模型的核心概念。这个示例将使用PyTorch来实现一个简单的diffusion模型,该模型能够从噪声中生成手写数字图像,类似于MNIST数据集中的图像。

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# 设备配置

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 数据加载

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))

])

train_dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

test_dataset = datasets.MNIST(root='./data', train=False, download=True, transform=transform)

train_loader = DataLoader(train_dataset, batch_size=64, shuffle=True)

test_loader = DataLoader(test_dataset, batch_size=64, shuffle=False)

# 简单的UNet模型结构

class UNet(nn.Module):

def __init__(self):

super(UNet, self).__init__()

self.encoder = nn.Sequential(

nn.Conv2d(1, 16, kernel_size=3, padding=1),

nn.ReLU(),

nn.Conv2d(16, 16, kernel_size=3, padding=1),

nn.ReLU()

)

self.decoder = nn.Sequential(

nn.ConvTranspose2d(16, 1, kernel_size=3, padding=1),

nn.Sigmoid()

)

def forward(self, x):

encoded = self.encoder(x)

decoded = self.decoder(encoded)

return decoded

# 实例化模型

model = UNet().to(device)

# 损失函数和优化器

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练模型

def train_model(model, train_loader, epochs=10):

model.train()

for epoch in range(epochs):

for data, target in train_loader:

data, target = data.to(device), target.to(device)

optimizer.zero_grad()

# 添加噪声

noise = torch.randn_like(data) * 0.5

noisy_data = data + noise

# 训练模型去噪

output = model(noisy_data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

print(f'Epoch {epoch+1}, Loss: {loss.item()}')

train_model(model, train_loader, epochs=10)

# 测试模型

def test_model(model, test_loader):

model.eval()

test_loss = 0

with torch.no_grad():

for data, target in test_loader:

data, target = data.to(device), target.to(device)

noise = torch.randn_like(data) * 0.5

noisy_data = data + noise

output = model(noisy_data)

test_loss += criterion(output, target).item()

test_loss /= len(test_loader.dataset)

print(f'Test Loss: {test_loss}')

test_model(model, test_loader)- 数据加载:使用

torchvision库加载MNIST数据集,并进行归一化处理。 - 模型定义:定义一个简单的UNet模型,用于编码和解码图像。这个模型包含一个编码器和一个解码器。

- 训练过程:在训练过程中,我们首先向数据中添加噪声,然后训练模型去预测原始的无噪声图像。

- 测试过程:在测试过程中,我们同样向数据中添加噪声,然后使用训练好的模型来预测去噪后的图像,并计算与原始图像的损失。

这个示例是一个非常基础的实现,真正的diffusion model需要更复杂的结构和训练策略,包括多个时间步的逆向扩散过程。这只是一个起点,用于理解diffusion models的基本概念。