环境相关:

开发主机:Win7

开发环境:IDEA

hadoop版本:hadoop-2.6.0-cdh5.7.1

hive版本:hive-1.1.0-cdh5.7.1

1. 开发环境相关说明

依据《Win7 IDEA 开发环境搭建部署》部署Win7系统的idea开发环境,hadoop和hive环境依据《hadoop2.6.0-cdh5.7.1伪分布式编译安装》《hive-1.1.0-cdh5.7.1编译安装部署》进行部署。

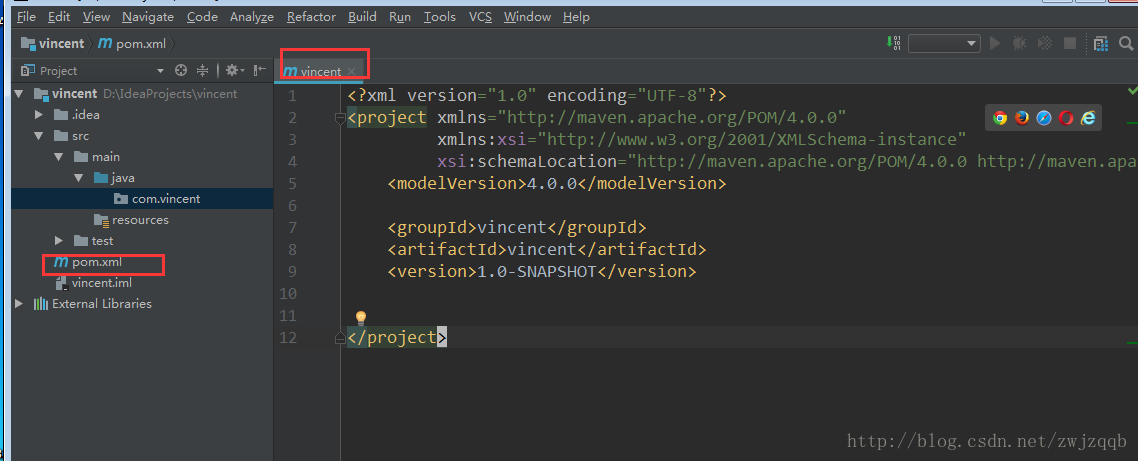

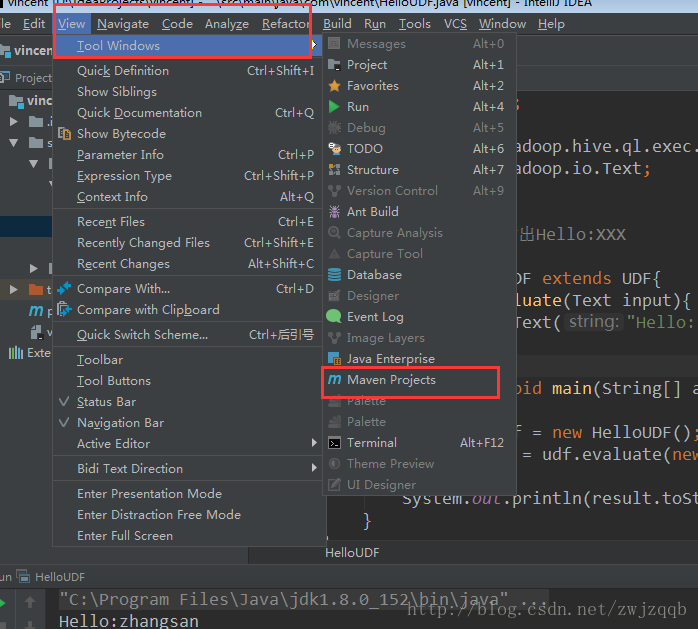

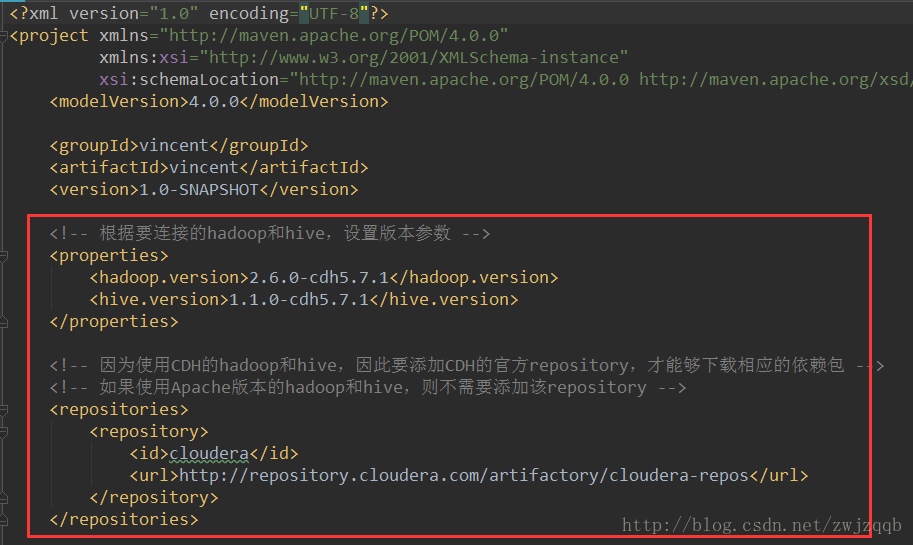

2. Maven的pom文件配置

Maven的pom.xml文件在项目创建后的配置为:

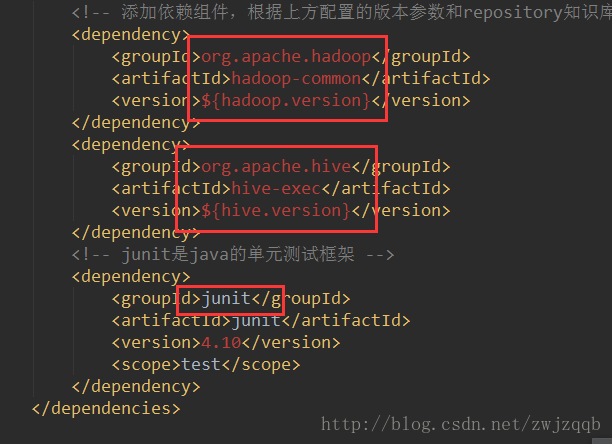

在此基础上添加配置:

添加版本信息参数,添加CDH的包仓库配置

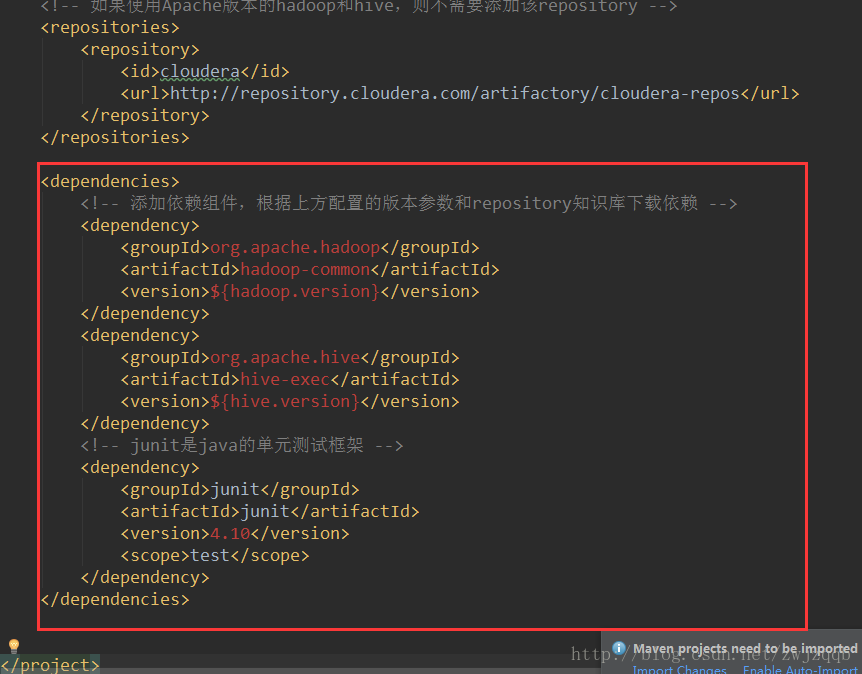

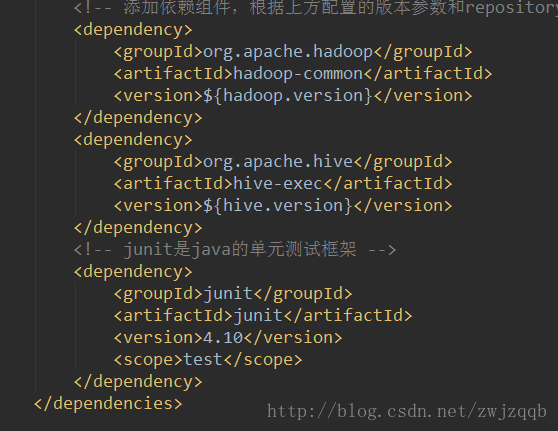

添加hadoop和hive的依赖,此时如果groupID标签中的配置是红色的,代表该包还没有下载,如果是蓝色的则代表本机中已经有对应的jar包,可以直接使用

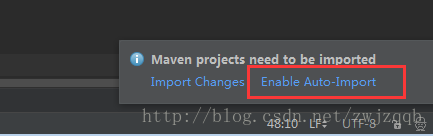

建议使用自动下载,点击后IDEA会通过maven下载对应的包,需要上网,完成时间取决于网络状态。

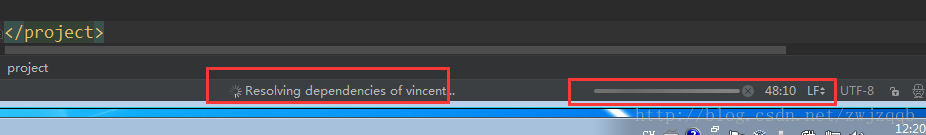

这个地方可以看到下载的进度信息

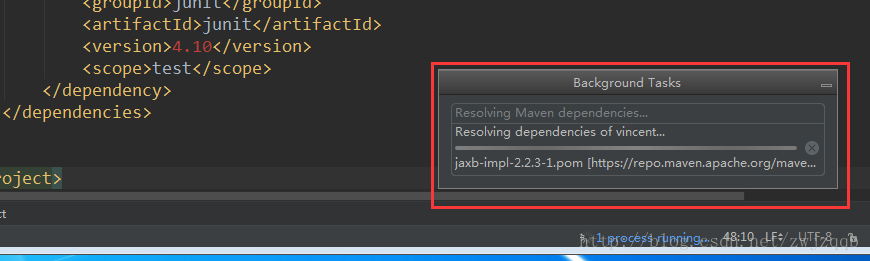

点击进度条,即可查看具体在下载哪个包

全部蓝掉了,可以使用了,可以使用ctrl+鼠标左键点击对应的组件,查看详细信息

# 配置文件如下:

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>vincent</groupId>

<artifactId>vincent</artifactId>

<version>1.0-SNAPSHOT</version>

<!-- 根据要连接的hadoop和hive,设置版本参数 -->

<properties>

<hadoop.version>2.6.0-cdh5.7.1</hadoop.version>

<hive.version>1.1.0-cdh5.7.1</hive.version>

</properties>

<!-- 因为使用CDH的hadoop和hive,因此要添加CDH的官方repository,才能够下载相应的依赖包 -->

<!-- 如果使用Apache版本的hadoop和hive,则不需要添加该repository -->

<repositories>

<repository>

<id>cloudera</id>

<url>http://repository.cloudera.com/artifactory/cloudera-repos</url>

</repository>

</repositories>

<dependencies>

<!-- 添加依赖组件,根据上方配置的版本参数和repository知识库下载依赖 -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>${hadoop.version}</version>

</dependency>

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-exec</artifactId>

<version>${hive.version}</version>

</dependency>

<!-- junit是java的单元测试框架 -->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.10</version>

<scope>test</scope>

</dependency>

</dependencies>

</project>3. UDF函数开发测试

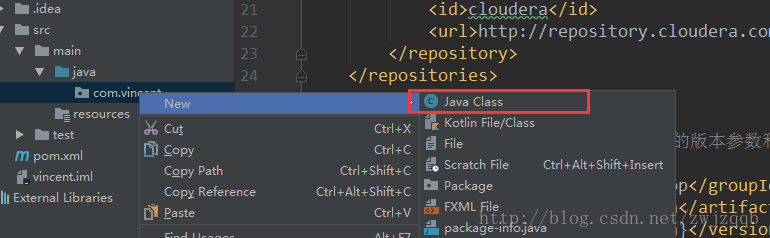

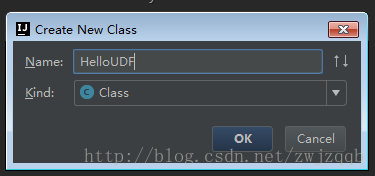

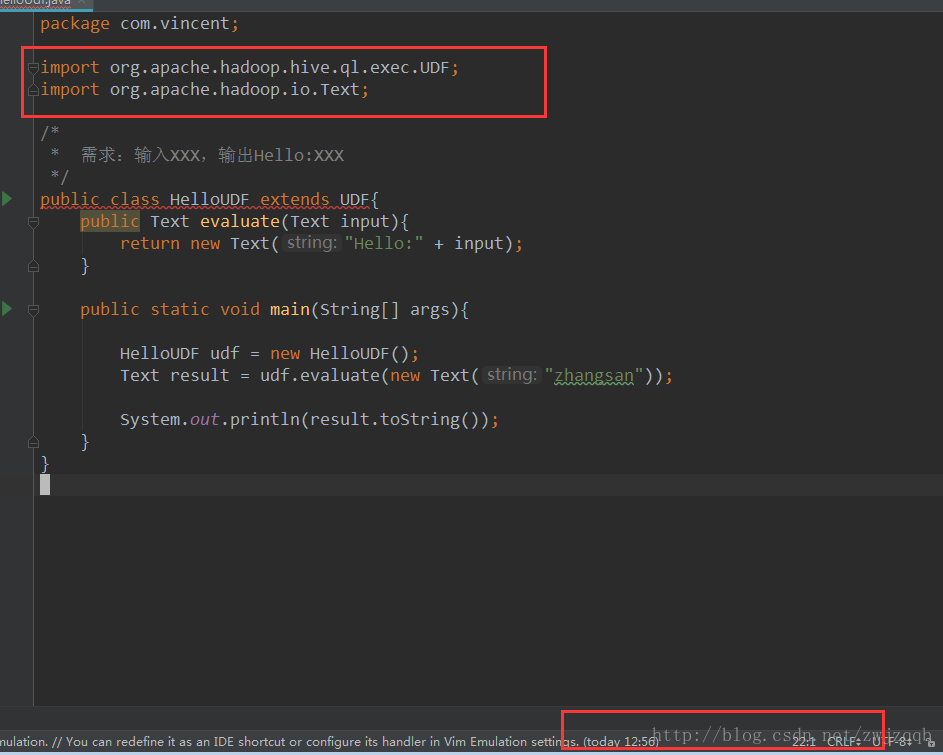

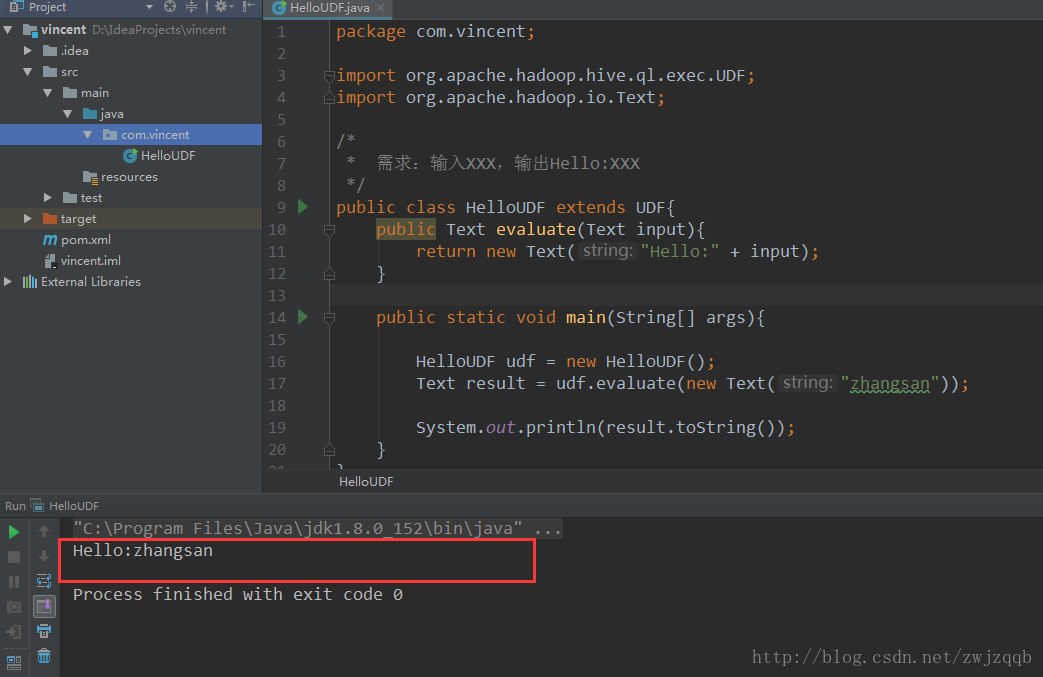

创建一个java class文件,开发代码,测试:

注意,这个地方配置名字为HelloUDF,那么类名也必须是这个,大小写都不可以换

贴入代码:

可以看出,有一些包还是没有下载的,需要等待IDEA自动下载

这个地方的类名,必须是HelloUDF,否则会报错:

Error:(9, 8) java: 类HelloUDF是公共的, 应在名为 HelloUDF.java 的文件中声明

已经完成下载了

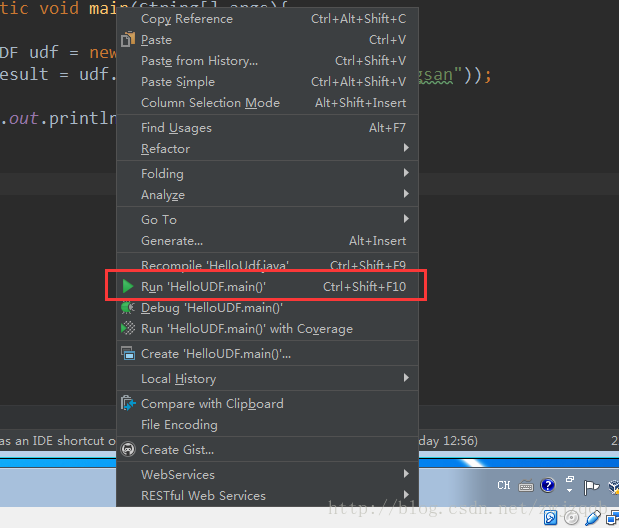

下载完成后尝试运行测试:

执行成功

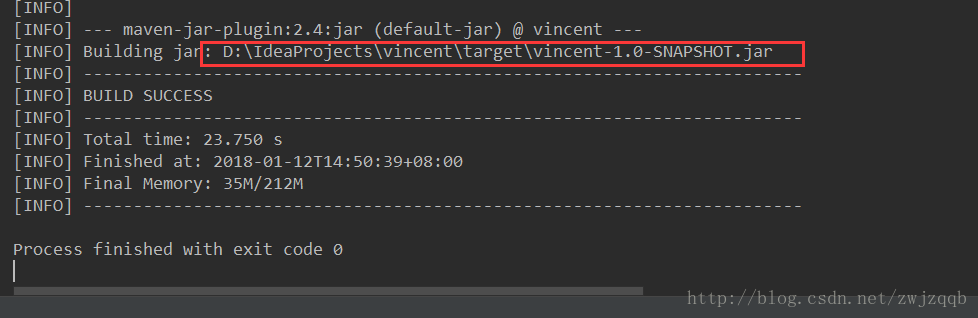

4. 导出jar包

5. 上传hive测试

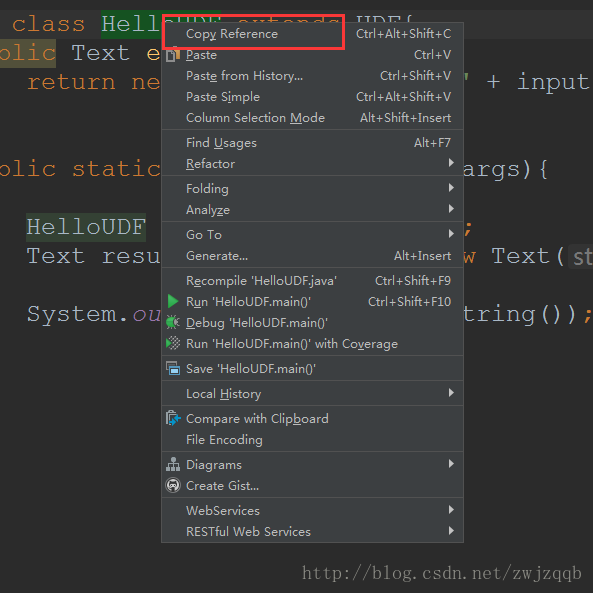

找到该函数,鼠标右键选择Copy Reference 获得该函数的全路径

su - hadoop

cd /home/hadoop/lib

cp -av /tmp/vincent-1.0-SNAPSHOT.jar .

hive

add jar /home/hadoop/lib/vincent-1.0-SNAPSHOT.jar;

-- 将上传的jar包导入到classpath变量里

list jars;

-- 查看导入的jar包

create temporary function say_hello as 'com.vincent.HelloUDF';

-- 创建一个临时函数,关联该jar包

-- as 后面的路径就是上一步获得的全路径

show functions like 'say*';

-- 查看创建的函数

select 'lisi',say_hello('lisi');

-- 测试以上创建了一个临时的函数,当前会话生效,

hive

add jar /home/hadoop/lib/vincent-1.0-SNAPSHOT.jar;

create function vincent.say_hello1 as 'com.vincent.HelloUDF';

-- 创建一个vincent库的say_hello1函数,永久性的

show functions like 'say*';

select 'lisi',say_hello1('lisi');

-- 当前default是没有该函数的

use vincent;

show functions like 'say*';

select 'lisi',say_hello1('lisi');

-- 此处有一个BUG,show functions无法看到该函数

-- 但是可以直接使用

-- 如果重新在vincent库中创建同名函数,则会报错函数已存在使用 add jar 命令是当前会话生效的,重新打开一个hive会话,使用vincent.say_hello1报错,

如果要添加一个永久的函数对应永久的路径,则可以如下操作:

create function vincent.say_hello3

as 'com.vincent.HelloUDF'

using jar 'hdfs:///tmp/vincent-1.0-SNAPSHOT.jar';

use vincent;

select 'lisi',say_hello3('lisi');

-- 将jar包放到hdfs上,不可以放到OS上,然后创建函数关联路径即可

-- 依然存在 show functions不可见的BUG[TOC]

进阶版的maven 打部分依赖到jar包