TurboTransformers 是腾讯开源的BERT推理模型

TurboTransformers 支持 python 和 C++接口进行调用。TurboTransformers 支持 TensorFlow 和 PyTorch 预训练模型的载入。它可以作为 huggingface/transformers 的推理加速插件,通过加入几行 python 代码获得 BERT 模型的端对端加速效果。

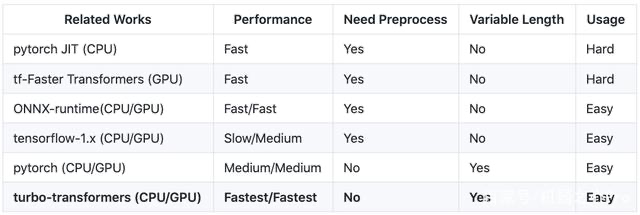

和 ONNX-runtime、TensorRT、Torchlib 等推理优化引擎相比,TurboTransformers 在性能和使用方式上都具备优势。

使用方式:

1. 安装TurboTansformers容器环境

1.1 下载镜像

可参考官方github地址上的步骤进行构建,也可以直接下载官方已经构造好的cpu/gpu镜像(我是这么操作的)

docker pull thufeifeibear/turbo_transformers_cpu:latest

1.2 构造自己的容器

容器使用,参考菜鸟教程:Docker 容器使用 | 菜鸟教程