前言

这是深圳大学、香港城市大学和南洋理工大学发表在CVPR2022的一篇暗图增强的论文。

URetinex-Net借鉴了Retinex模型,该模型基于人眼对亮度感知的理论,旨在分离图像中的色彩和光照信息。通过深度学习的手段,该项目提出了一种深度展开网络,能够更精确地估计图像的亮度分布,从而在提升图像亮度的同时保留原有的色彩信息和细节。

学习资料:

- 论文题目:《URetinex-Net: Retinex-based Deep Unfolding Network for Low-light Image Enhancement》(URetinex-Net:基于Retinex的低光图像增强深度展开网络)

- 原文地址:Wu_URetinex-Net_Retinex-Based_Deep_Unfolding_Network_for_Low-Light_Image_Enhancement_CVPR_2022_paper.pdf

- 源码地址:GitHub - AndersonYong/URetinex-Net: Code Released for URetinex-Net

目录

2.1 Retinex Based LLIE Methods—基于Retinex的LLIE方法

2.2. Deep Unfolding Methods—深部展开法

3. The Proposed Unfolding Network—提出的展开网络

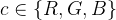

3.2 URetinex-Net Framework—URetinex-Net框架

3.2.1 Initialization Module—初始化模块

3.2.2 Unfolding Optimization Module—展开优化模块

3.2.3 Illumination Adjustment Module—照度调整模块

4.1. Implementation Details and Data sets—实验细节和数据集

4.2. Comparison with the state-of-the-art—与SOTA对比

Abstract—摘要

翻译

Retinex模型方法在具有良好设计的先验知识下,在低光图像增强中的层级操纵方面显示出有效性。然而,常用的手工设计的先验和基于优化的解决方案缺乏适应性和效率。为了解决这些问题,本文提出了一种基于Retinex的深度展开网络(URetinex-Net),通过将优化问题展开成一个可学习的网络,将低光图像分解为反射层和照明层。通过将分解问题公式化为隐式先验正则化模型,本文精心设计了三个基于学习的模块,分别负责数据依赖初始化、高效展开优化和用户指定的照明增强。特别地,提出的展开优化模块引入了两个网络,以数据驱动方式自适应地拟合隐式先验,可以实现噪声抑制和细节保留,以获得最终的分解结果。在真实世界的低光图像上进行的大量实验从定性和定量上证明了所提方法相对于最先进方法的有效性和优越性。代码可以在GitHub - AndersonYong/URetinex-Net: Code Released for URetinex-Net找到。

精读

过去方法以及不足: Retinex模型在低光图像增强中有效,但缺乏适应性和效率。

解决方案: 提出了URetinex-Net,这是一种基于Retinex的深度展开网络。 将优化问题展开成一个可学习的网络,将低光图像分解为反射层和照明层。

方法设计:

- 数据依赖初始化:一个模块负责根据数据进行初始化。

- 高效展开优化:引入两个网络,以数据驱动方式自适应地拟合隐式先验,实现噪声抑制和细节保留。

- 用户指定的照明增强:一个模块负责用户指定的照明增强。

实验结果: 在真实世界的低光图像上进行的大量实验,从定性和定量上证明了所提方法相对于最先进方法的有效性和优越性。

1. Introduction—引言

翻译

在光线较差的环境中拍摄的图像通常会受到低对比度和低可见度的影响,这对人类视觉和许多高层次视觉任务(如目标检测)都提出了挑战。为了揭示低光图像中隐藏的细节并避免后续视觉任务性能的退化,研究人员在低光图像的对比度增强、纹理恢复和噪声去除方面做出了巨大努力。特别是在低光图像增强(LLIE)方面,提出了许多方法,包括直方图均衡化、锐化掩模算法、Retinex方法、多重曝光融合和基于深度学习的方法。由于Retinex理论很好地模拟了人类视觉的色觉,基于Retinex理论的LLIE方法引起了广泛关注。根据Retinex理论,一幅图像可以分解为反射和照明两个组成部分。数学上,观察到的图像I可以表示为:

其中,R、L和·分别表示反射、照明和元素级乘法。在一些早期的Retinex方法中,首先估计照明,然后将反射作为最终增强的结果。尽管可以从输入中恢复大量细节,但它常常导致图像看起来不自然和过度曝光。后来,提出了许多具有良好可解释性的基于模型的方法来解决公式(1)中的不适定分解问题,其中各种手工设计的先验作为正则化项引入模型中。然后,通过Gamma校正进一步增强照明。设计显式先验以适应数据是使模型有效的关键,但对于基于模型的方法来说,在各种场景中具有足够的适应性是一个挑战。此外,大多数采用传统迭代优化方案的基于模型的方法对单个图像调整的成本很高,这将阻碍其在实时应用中的发展。

由于基于模型的方法存在这些局限性,研究人员利用深度网络以数据驱动的方式恢复低光图像。在这些基于学习的方法中,基于Retinex的方法使用深度网络来估计反射和照明,并增强照明。然而,大多数这些方法在分解后对反射进行去噪操作,导致细节丢失。此外,基于学习的方法缺乏可解释性和灵活性,这给分析设计网络的潜在局限性带来了困难。

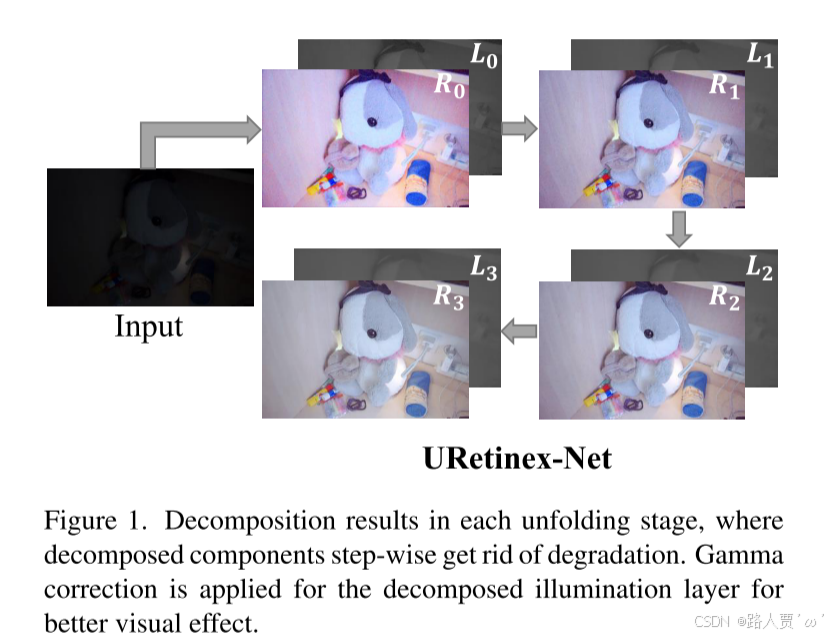

为此,我们提出了一种基于Retinex的深度展开网络(URetinex-Net),用于在RGB色彩空间中揭示低光图像。为了结合基于模型和基于学习方法的优势,我们将基于Retinex的分解问题公式化为一个隐式先验正则化模型,其中稳健的正则化项由可学习的网络推断,而不是使用手工设计的先验。具体来说,公式化模型的能量函数通过交替半二次分裂算法分解为四个单变量子问题,并通过迭代最小化四个子问题来解决这个优化问题。然后,我们将优化方案展开成一个深度网络。对于涉及先验项的子问题,引入两个网络以自适应地拟合隐式先验,而其他涉及保真项的子问题则通过相应的闭式解法来解决。在展开优化过程中,分解的反射和照明逐步消除退化。此外,公式化模型避免了设计显式先验项。考虑到初始化对优化的重要影响,我们提出了一个初始化模块以促进优化。最后,我们设计了一个照明调整模块,根据用户指定的光照水平灵活地增强照明图。

综上所述,本文的贡献主要体现在三个方面:·

- 在传统的基于模型的方法基础上,提出了一种新的基于模型的深度展开网络(URetinex-Net),该网络由初始化、优化和光照调整三个功能清晰的模块组成,继承了基于模型的方法的灵活性和可解释性。

- 我们提出的URetinexNet中的优化模块将优化过程展开到一个深度网络中,该网络利用基于学习的方法的强大建模能力来自适应地拟合依赖于数据的先验。

- 在真实数据集上进行了大量的实验,证明了我们的URetinex网络的高效性和优越性,它可以实现对噪声的抑制和对最终增强结果的细节保护。

精读

过去对于图像增强的尝试

- 直方图均衡化、锐化掩模算法、Retinex方法、多重曝光融合和基于深度学习。

- Retinex理论通过将图像分解为反射和照明两个部分来增强低光图像。

Retinex方法的局限性

- 早期方法通过估计照明和增强反射,但容易导致不自然和过度曝光。

- 基于模型的方法虽然具有良好可解释性,但缺乏适应性,迭代优化方案成本高,不适合实时应用。

本文提出解决方案

提出了基于Retinex的深度展开网络——URetinex-Net。

方法设计

- 将Retinex分解问题公式化为隐式先验正则化模型,用可学习网络代替手工设计的先验。

- 使用交替半二次分裂算法将能量函数分解为四个子问题,通过迭代最小化解决优化问题。

- 优化方案展开为深度网络,两个网络自适应拟合隐式先验,其他子问题通过闭式解法解决。

URetinex-Net的优势

- 分解的反射和照明逐步消除退化,避免显式先验设计。

- 提出初始化模块优化起始条件。

- 设计照明调整模块,根据用户指定光照水平灵活增强照明。

2. Related Work—相关工作

2.1 Retinex Based LLIE Methods—基于Retinex的LLIE方法

翻译

基于模型的方法:经典的Retinex理论模拟了人类视觉系统(HVS),该理论假设观察到的颜色取决于物体本身的内在成分以及落在物体上的外在非均匀光源。自然地,图像可以分解为反射和照明,如公式(1)所示。在变分框架下,提出了几种Retinex分解模型。然后,通过调整估计的照明,恢复目标低光图像。随后,提出了几种能量函数基于最大后验(MAP)框架的基于模型的方法。Guo等人提出了一种结构感知正则化模型,以基于初始照明图进行细化。为了模拟噪声引起的退化,Li等人进一步在目标函数中引入了噪声项,以帮助去除噪声并放大细节。Hao等人使用高斯全变差作为正则项来建立分解模型。总体而言,传统的基于模型的方法大多依赖于精心设计的手工先验或某些统计模型。然而,当应用于各种场景时,这些先验受限于模型能力。

深度学习方法:在过去的十年中,基于深度学习的方法在低光图像增强(LLIE)问题上取得了令人瞩目的成果。受到Retinex理论的启发,Wei等人提出了一个端到端可训练的网络Retinex-Net,该网络包括分解模块和照明调整模块。为了在Retinex-Net中实现去噪操作,BM3D被用作反射的后处理层,这意味着Retinex-Net无法处理极低光图像中的严重噪声。在Wei等人之后,KinD采用了一个可训练的去噪模块来恢复反射。此外,KinD在照明调整模块中设计了一个可学习的映射函数,使得图像可以在用户指定的光照水平下灵活恢复。最近,Zhang等人结合Retinex理论和最大熵,提出了一个使用直方图均衡操作来对反射进行约束的自监督框架。

尽管这些方法在LLIE上表现出色,但它们缺乏可解释性,这会阻碍它们在LLIE中的发展。此外,基于反射描绘内在成分在不同光照环境下应保持一致的理论,大多数基于Retinex的深度学习方法在分解后恢复反射,这会导致细节的丢失。

精读

ModelBased Methods:—基于模型的方法

(1)经典Retinex理论:模拟人类视觉系统,将图像分解为反射和照明两个部分。

(2)Retinex分解模型: 在变分框架下提出,通过调整估计的照明恢复低光图像。

(3)最大后验(MAP)框架方法:

- Guo等人提出结构感知正则化模型细化照明图。

- Li等人引入噪声项以去除噪声并放大细节。

- Hao等人使用高斯全变差作为正则项建立分解模型。

不足:传统的基于模型的方法依赖手工设计的先验或统计模型,在不同场景中应用时受限于模型能力。

Deep Learning-Based Methods:—基于深度学习的方法

Retinex-Net:

- Wei等人提出了包含分解模块和照明调整模块的端到端可训练网络Retinex-Net。

- 使用BM3D作为反射的后处理层,但不能处理极低光图像中的严重噪声。

KinD: 采用可训练的去噪模块恢复反射,并在照明调整模块中设计了可学习的映射函数。

自监督框架: Zhang等人结合Retinex理论和最大熵,提出了使用直方图均衡操作约束反射的自监督框架。

方法局限性:

这些方法虽然性能优异,但缺乏可解释性,限制了其在LLIE中的发展。

大多数基于Retinex的深度学习方法在分解后恢复反射,导致细节丢失。

2.2. Deep Unfolding Methods—深部展开法

翻译

基于模型的低光图像增强(LLIE)方法具有高度的可解释性和灵活性,而基于学习的LLIE方法在以数据驱动的方式学习复杂映射方面显示出优势。此外,深度神经网络在推理过程中表现快速,计算效率特别高。在过去的十年中,利用基于模型和基于学习方法优势的展开(或展开)算法引起了广泛关注。

Gregor和Lecun首先设计了一种时间展开算法来解决稀疏编码优化中的迭代收缩和阈值算法,使所提出的算法在较少的迭代次数内产生具有竞争力的性能。受这种优化方案的启发,深度展开算法在许多重要的图像处理问题上产生了巨大影响,如超分辨率、图像去噪、杂波抑制和雨滴去除。

最近,Liu等人提出了一种用于照明估计和噪声去除的无监督展开框架,但这种方法会忽略反射和照明之间的相互关系。我们的方法与其有两个主要区别:(1)我们倾向于在统一框架中同时估计输入图像的反射和照明;(2)我们的网络可以通过用户定义的比例灵活地增强照明。

精读

基于模型的方法: 高度可解释且灵活。

基于学习的方法: 数据驱动,能学习复杂映射,推理速度快,计算效率高。

展开算法:

- 结合基于模型和基于学习的方法,近年来受到关注。

- Gregor和Lecun首次设计时间展开算法,提升稀疏编码优化性能。

- 深度展开算法在超分辨率、图像去噪、杂波抑制、雨滴去除等领域有重要影响。

我们的方法不同之处在于:同时估计反射和照明,且可以根据用户定义的比例灵活增强照明。

3. The Proposed Unfolding Network—提出的展开网络

3.1 Problem Formulation—问题描述

翻译

在这一部分中,我们首先介绍我们提出的方法的公式,然后介绍框架的细节。

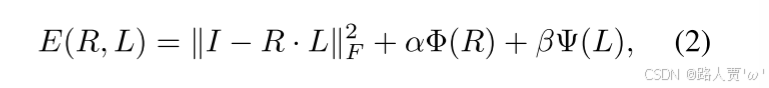

经典的基于 Retinex 的模型假设图像可以通过公式 (1) 分解为反射率和照明,并开发了各种手工设计的先验来在 MAP 框架下解决这个病态的分解问题。因此,可以通过最小化以下正则化能量函数来获得反射率和照明:

其中

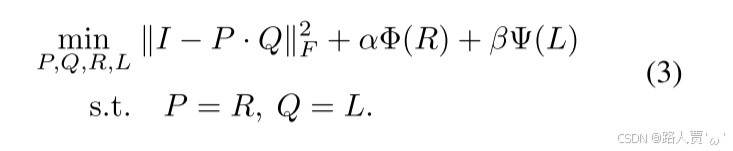

一般而言,为了便于优化,保真项和正则化项被分开处理,因此我们引入两个辅助变量 P 和 Q 分别逼近𝑅 和 𝐿。相应地,这导致了以下最小化问题:

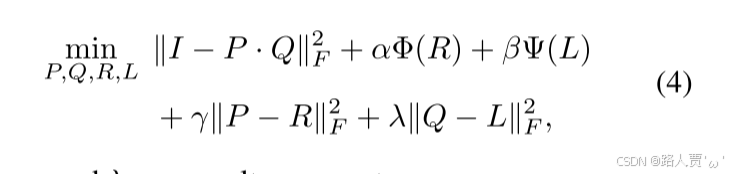

为了处理等式约束,引入了两个二次惩罚项,并将问题重写为:

其中

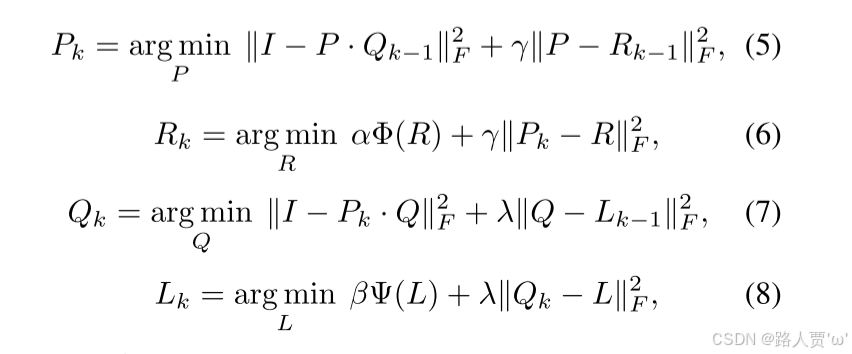

为了解决公式 (4) 中的问题,我们采用交替更新变量的方法,即在固定其他变量的情况下更新一个变量。因此,我们将问题分解为四个单变量子问题,并通过以下交替方案进行优化:

其中

精读

前面公式(1)表示了经典的Retinex模型假设图像可以通过方程分解为反射率和照度。

因此,可以通过最小化以下正则化函数来获得反射率和照度:

为了便于优化,将保真项和正则化项分开处理,因此引入了两个辅助变量P和Q,分别逼近R和L。因此,这导致了以下最小化问题:

为了处理等式约束,引入两个二次惩罚项,并将问题重写:

为了解决方程中的问题 (4),通过交替更新一个变量的值与其他变量的值。将问题分解为四个单变量子问题,使用以下交替方案优化。

3.2 URetinex-Net Framework—URetinex-Net框架

3.2.1 Initialization Module—初始化模块

翻译

由于难以设计特定的正则化项

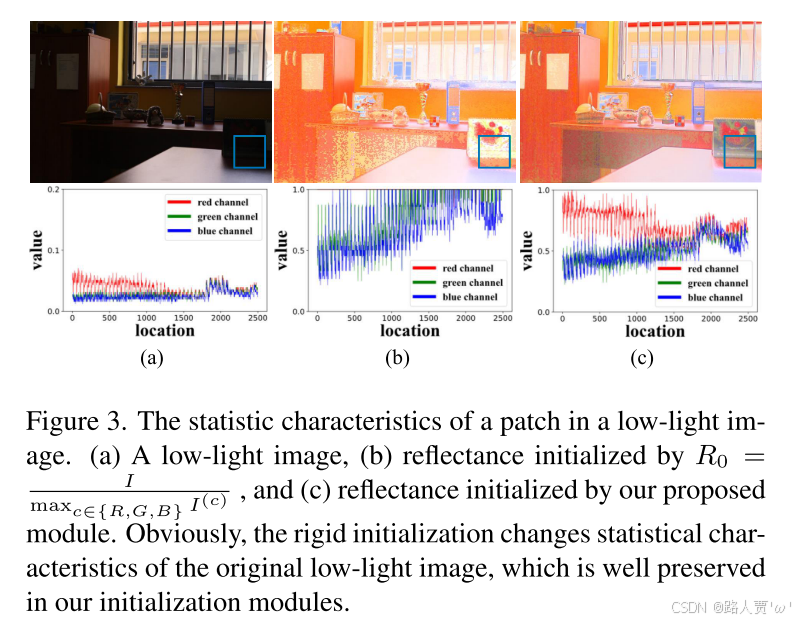

初始化在优化过程中起着重要作用。在传统的优化方案中(如ADMM),随机或全零初始化被广泛使用。考虑到可靠的初始化有助于性能提升,我们希望获得一个具有丰富信息的初始照明和反射,而不是随机值或全零值。

直观地,为了保持图像

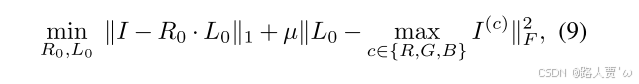

因此,为了揭示粗略细节但避免引起失真,我们提出了一个名为D的数据依赖初始化模块,该模块使用全卷积(Conv)网络自适应地同时学习

其中

此外,由于缺乏真实的反射图,使用正常光照图像生成清晰的反射图,这些反射图应接近于低光照图像的反射图。因此,在后续的展开优化模块中,正常光照图像的反射图被用作参考。基于初始化模块的网络架构,我们进一步对正常光照图像的照明施加结构感知平滑约束,然后用于分解正常光照图像的损失函数如下:

(公式打得累鼠我了。。。)

精读

初始化的重要性

随机或全零初始化常用,但可靠的初始化更有利于性能。

传统初始化方法

- 使用三个颜色通道的最大值初始化L0,得到R0 = I / L0。

- 这种方法易导致颜色失真。

数据依赖的初始化模块

提出一个使用全卷积网络的初始化模块D,自适应学习R0和L0。

初始化模块由三个 Conv+LeakyReLU 层组成,后面是卷积层和 ReLU 层。

整个卷积层的内核大小设置为3*3。

损失函数设计:

第一项是重建损失,第二项是结构保留损失,鼓励初始化照明保留图像整体结构。

正常光图像参考:

- 使用正常光图像生成清晰反射作为参考。

- 对正常光图像的照明施加结构感知平滑约束。

3.2.2 Unfolding Optimization Module—展开优化模块

翻译

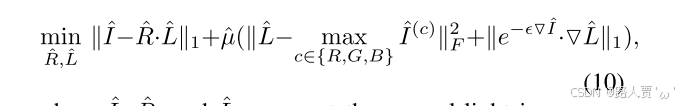

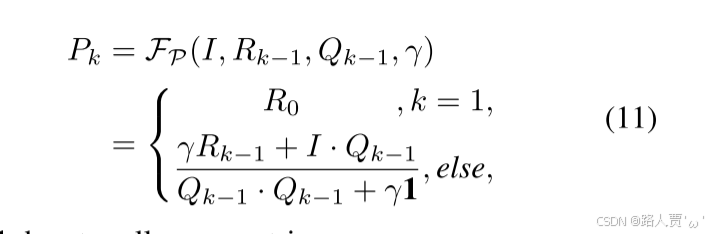

展开优化模块旨在通过

其中,1 表示全为 1 的矩阵。

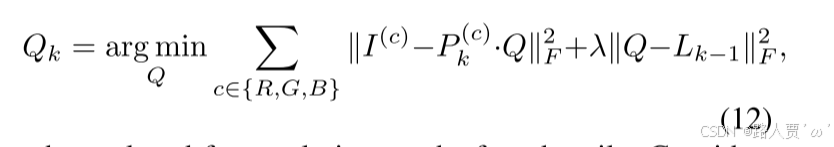

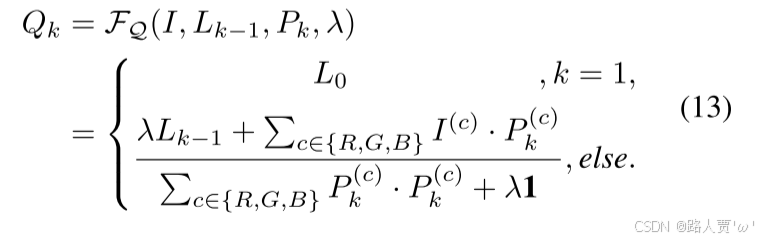

同样地,可以通过求解公式(7)中的

其闭合形式的解很容易找到。在考虑初始光照的情况下,

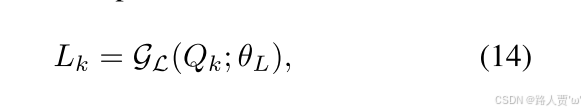

更新

其中

然后,通过以类似的方式将退化的

其中

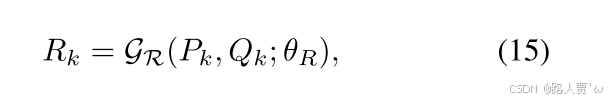

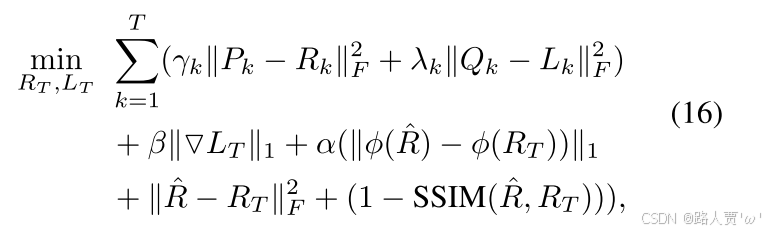

展开优化模块以端到端的方式训练,其中

其中,

显然,即使在深度神经网络架构中,所提出的展开优化模块也具有良好的可解释性,其中

精读

Updating rules for P and Q:—更新P和Q的规则

模块目标:

展开优化模块通过迭代解决四个单变量子问题,在T次迭代中更新变量。

迭代映射:

更新步骤映射到深度神经网络架构,推理被展开为T个阶段,每个阶段更新P、Q、L和R。

P的更新规则:

P子问题是经典最小二乘问题,通过求导得到闭式解,更新公式基于初始反射。

Q的更新规则:

Q的更新可以通过求解方程中的Q子问题来完成,由于RGB通道共享同一灰度照明层,更新公式基于初始照明。

Updating rules for L and R—更新L和R的规则

L和R的更新规则:

对于L和R子问题,不再手工设计先验,而是采用基于学习的方法探索隐式先验。 引入两个网络GL和GR分别更新L和R。

更新R的网络:

用GR表示,输入为Pk和Qk,θR为可学习参数。

使用压缩和激励(SE)块融合Pk和Qk以更新Rk。

展开优化模块的损失函数如下:

包含每个阶段的MSE损失、结构相似性损失和感知损失。 总损失函数为多个损失项的加权和。

3.2.3 Illumination Adjustment Module—照度调整模块

翻译

在实际操作中,没有图像增强的标准光照水平,因此灵活调整光照是适应不同实际需求所必需的。对于低光照图像增强(LLIE),伽马校正被广泛用于增强光照图,即

其中

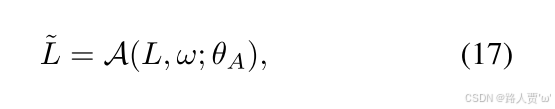

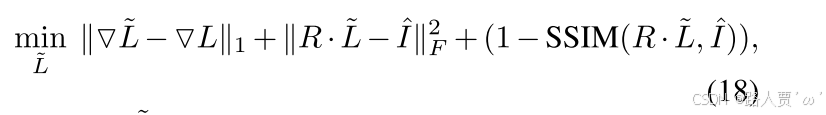

由于光照图的分布不均匀,我们将

光照调整模块的损失函数如下:

其中

尽管 KinD [41] 也开发了一个灵活的光照调整网络,但它依赖于正常光照图像的分解光照图,这可能会破坏输入

精读

照明调整的必要性:

没有图像增强的真实光照水平,需要灵活调整以适应不同需求。

现有方法:

伽马校正:通过公式

学习方式的照明调整:

本文提出一个照明调整模块,以低光照照明 L 和用户指定的增强比率 ω 作为输入,表示为

使用轻量级卷积网络,卷积核大小为5×5。

损失函数:

包含梯度一致性损失、重构损失和结构相似性损失,以确保调整后的照明图保持与原图的一致性并能重建正常光照图像。

优点: 不依赖正常光照图像的分解照明图,保持低光照照明的一致性。 能够灵活调整照明并保持结构一致性。

4. Experiments—实验

4.1. Implementation Details and Data sets—实验细节和数据集

翻译

为了评估我们提出的方法的性能,我们在LOL数据集[34]上训练和测试了我们的模型,该数据集包含500对低光照/正常光照图像对,并在各种曝光时间下从真实世界中捕获。我们遵循了[41]中的训练数据设置。为了进行更有说服力的比较,我们将模型扩展到SICE数据集[2],该数据集包含589个具有多级曝光的自然场景,并随机选择了108对曝光不足/正常曝光的图像。此外,我们采用MEF数据集[19]进行视觉比较,以展示我们提出的方法的效率。

URetinex-Net的每个模块分别进行训练,批量大小设置为4。为了提高训练效率,我们在训练展开模块时使用小的补丁大小(48×48)。通过消融实验,我们发现T=3已经取得了令人满意的结果,因此在接下来的实验中,T经验设置为3。每个模块使用Adam优化器进行训练,学习率为0.0001,在30K次迭代后衰减10倍。启发式地,μ、μ̂、α、β和ε分别设置为0.1、0.1、1、20和10。根据[36],罚参数β和γ期望迭代增加以实现稳定收敛。在这里,我们初始设置β和γ分别为0.5和0.1,并在每个阶段增加0.05。所有实验都在NVIDIA Tesla V100 GPU上,使用PyTorch[28]框架进行。

精读

数据集:

- LOL数据集

- SICE数据集

- MEF数据集

实验设置:

- batch size:4

- patch size:48×48

- 优化器:ADAM

- 学习率:0.0001,在30K迭代后衰减10%

- 超参数设置:μ、μ̂、α、β和ε分别设置为0.1、0.1、1、20和10

4.2. Comparison with the state-of-the-art—与SOTA对比

翻译

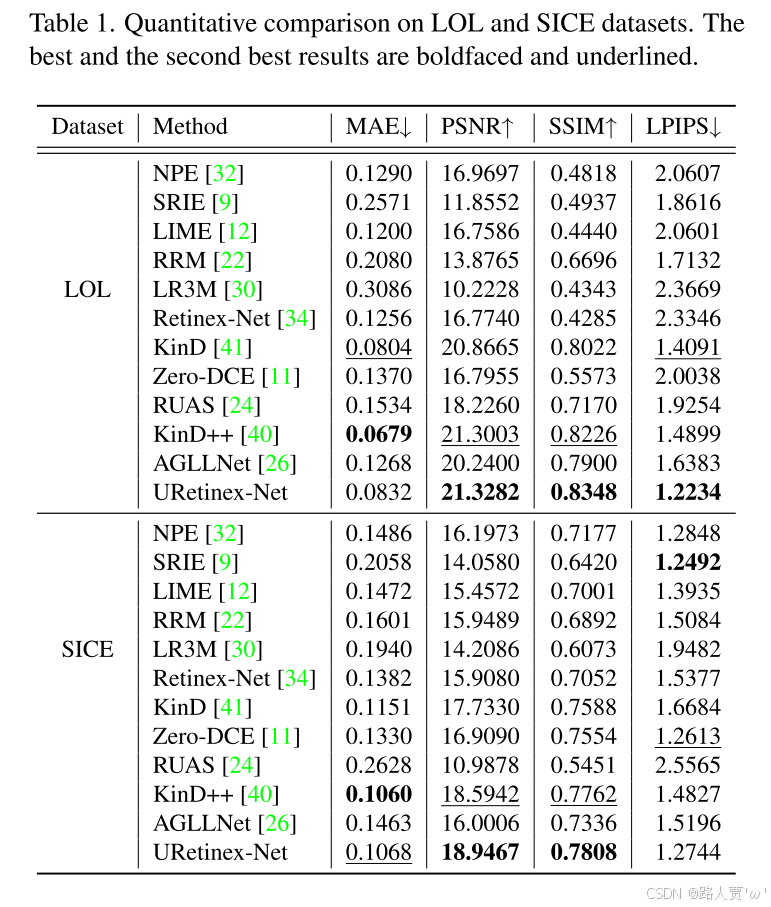

我们对五种传统的基于Retinex的方法进行了定性和定量比较,包括NPE [32]、SRIE [9]、LIME [12]、RRM [22]和LR3M [30]。此外,为了验证我们模型在从数据中学习隐式先验方面的效率,我们与包括Retinex-Net [34]、KinD [41]、Zero-DCE [11]、RUAS [24]、AGLL-Net [26]和KinD++ [40]在内的最新(SOTA)基于学习的方法进行了比较。Retinex-Net、KinD、KinD++和RUAS已在LOL数据集上进行训练,因此我们使用其提供的模型进行评估。对于Zero-DCE,我们使用LOL训练数据集中的裁剪图像重新组织训练数据,并按照其默认设置通过扩展数据集进行微调。为了测量颜色、结构和高级特征相似性的差异,我们使用MAE、PSNR、SSIM和LPIPS [37]作为指标。PSNR和SSIM值越高,图像质量越好。相反,MAE和LPIPS值越低,图像质量越好。

LOL数据集上的定量结果如表1所示。显然,我们的方法在大多数指标上都优于其他方法,除了MAE稍微逊色于KinD和KinD++。在PSNR、SSIM和LPIPS方面,我们的结果远优于所有其他方法,表明了所提出方法的有效性。视觉比较见补充材料。

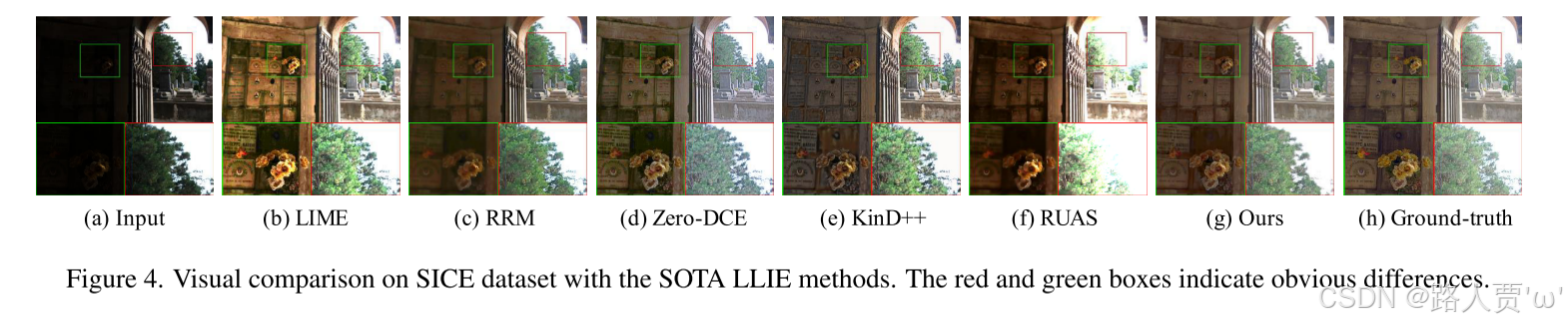

为了验证提出的URetinex-Net的泛化性能,我们在没有重新训练或微调的情况下进一步在SICE数据集上进行评估。结果报告如表1和图4所示。与其他方法相比,URetinex-Net在未见过的场景中泛化得更好。从图4可以看出,一些模型(例如NPE、SRIE、LIME、Retinex-Net和Zero-DCE)在增强后引入甚至放大了噪声,因此在照亮暗区时会出现严重的噪声失真和颜色退化。RRM在其目标函数中引入了噪声项,并设计了一个精心设计的正则化项,但它未能保留细小的细节。KinD++可以去除噪声,但由于过度锐化导致外观不自然(见图4(e)中花后面的墙),这导致不自然的外观。RUAS由于忽略了其框架中的反射,在结果中导致过度曝光(见图4(f)中的叶子)。AGLLNet是一个没有基于Retinex设置的多分支CNN架构,而显然我们的模型在所有指标上都优于它,这表明了我们基于Retinex的展开策略的有效性。

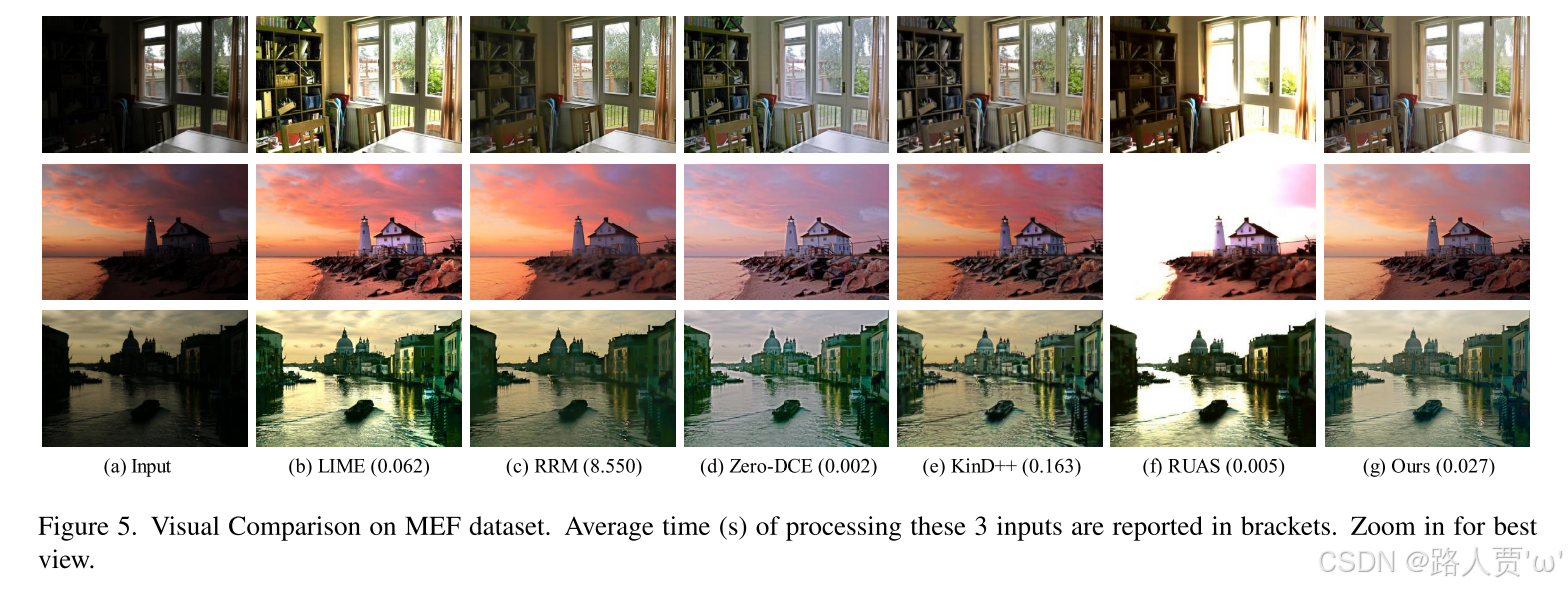

此外,我们在MEF数据集上进行了广泛的视觉比较。我们在图5中报告了性能和速度方面排名前五的方法。虽然传统的基于模型的方法在某种程度上可以恢复低光图像,但它们在迭代优化过程中耗时。相比之下,我们的方法在推理过程中节省了更多时间。此外,作为一种基于学习的LLIE方法,Zero-DCE具有快速处理速度,但它在实现噪声抑制和达到令人满意的效果方面能力有限。KinD++和RUAS以后处理方式去除噪声,这可能带来其他问题,如细节丢失、模糊甚至图像质量变差。与所有这些方法相比,我们的模型能够在噪声抑制和细节保留的同时充分显示低光图像。表明与精心设计的手工规划先验相比,我们的展开模块可以施加更鲁棒的隐式先验。特别是,我们的模型显示出细节恢复的独特优势,说明了我们展开优化的优越性。更多比较结果和分析可以在补充材料中找到。

精读

本文和五种传统的基于Retinex的方法(NPE、SRIE、LIME、RRM和LR3M)进行对比

结论:显然,我们的方法在大多数指标上都取得了比其他方法更好的结果,表明了该方法的有效性。

本文还与基于SOTA的学习方法RetinexNet、Kind、Zero-DCE、RUAS、AGLLNet和Kind++进行了比较

结论:与其他方法相比,URetinex-net对未知场景具有更好的泛化能力。

本文还在MEF数据集上进行了广泛的可视化比较。

结论:我们的方法在迭代优化过程节省了更多的推理时间。

4.3. Ablation Study—消融实验

翻译

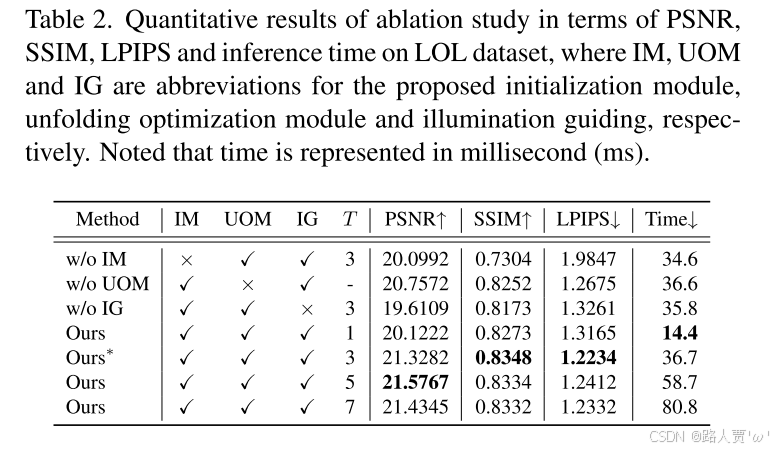

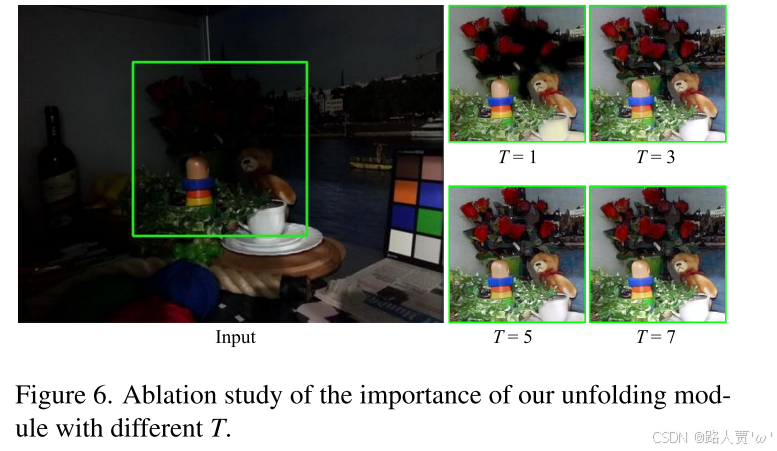

消融研究的结果如表2所示。我们首先通过与刚性初始化方式(例如,

精读

为了说明展开优化模块的有效性,进一步简单地将 GR 和 GL 的网络堆叠 T 次并丢弃展开优化,保持与 URetinex-Net 相同的网络容量。最后,研究了 URetinex-Net 在选择不同的阶段 T 下的性能。

5. Conclusion—结论

翻译

在本文中,我们提出了一种用于真实世界低光照图像增强的URetinex-Net。基于传统模型方法的优化过程,我们首先将Retinex分解问题公式化为隐式先验正则化模型,然后将优化中的更新步骤展开到深度神经网络中。通过利用基于学习的方法,估计的反射率和照明可以自适应地符合数据依赖的先验。大量实验结果验证了所提出的URetinex-Net能够高效地增强低光照图像,同时成功地抑制噪声并保留细节。

精读

- 提出URetinex-Net用于低光图像增强。

- 将Retinex分解问题公式化为隐式先验正则化模型。

- 优化步骤展开为深度神经网络。

- 估计的反射和照明自适应调整。

- 实验结果证明高效增强图像,抑制噪声并保留细节。