【NLP高频面题 - 分布式训练】ZeRO1、ZeRO2、ZeRO3分别做了哪些优化?

重要性:★★

NLP Github 项目:

-

NLP 项目实践:fasterai/nlp-project-practice

介绍:该仓库围绕着 NLP 任务模型的设计、训练、优化、部署和应用,分享大模型算法工程师的日常工作和实战经验

-

AI 藏经阁:https://gitee.com/fasterai/ai-e-book

介绍:该仓库主要分享了数百本 AI 领域电子书

-

AI 算法面经:fasterai/nlp-interview-handbook#面经

介绍:该仓库一网打尽互联网大厂NLP算法面经,算法求职必备神器

-

NLP 剑指Offer:https://gitee.com/fasterai/nlp-interview-handbook

介绍:该仓库汇总了 NLP 算法工程师高频面题

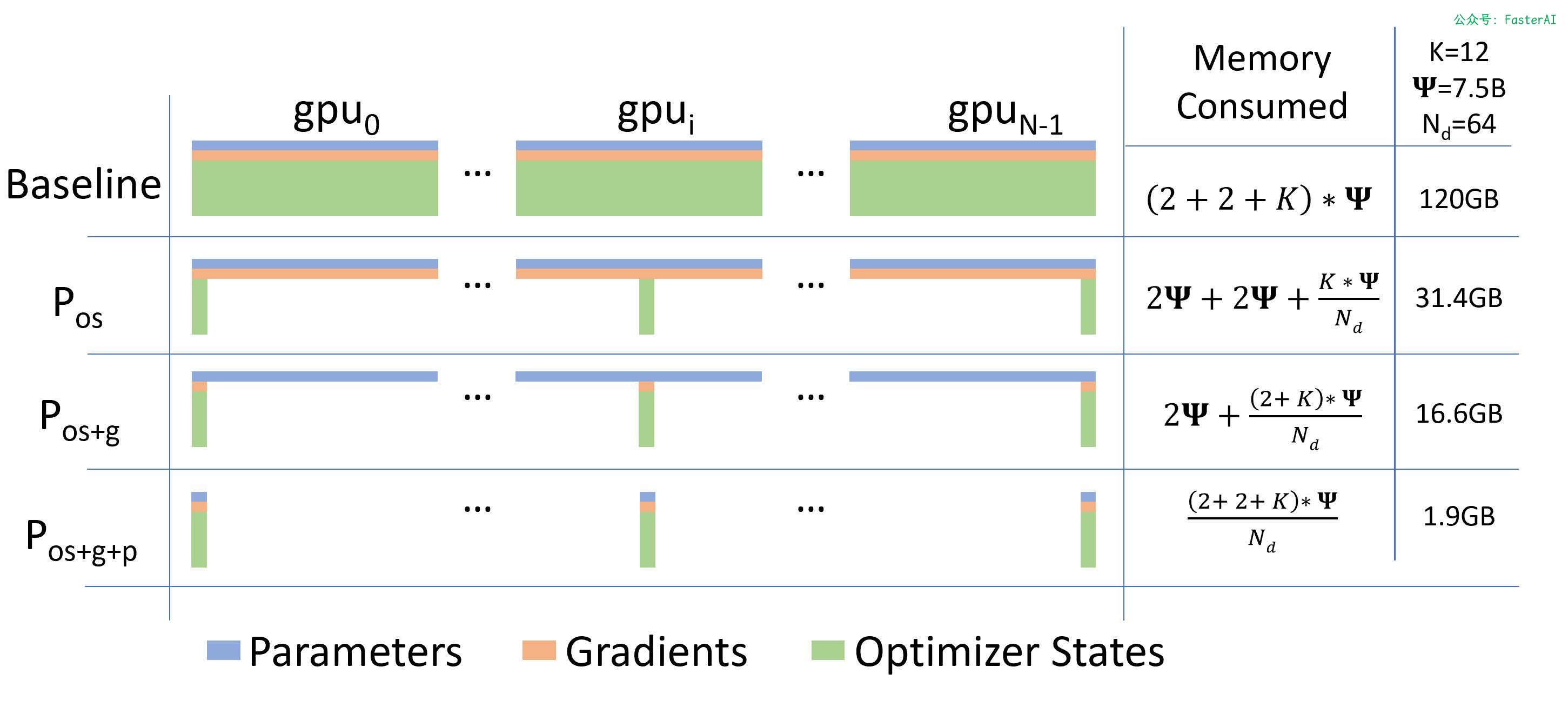

ZeRO被分为了三个级别:

- ZeRO1:对优化器状态进行拆分。显存消耗减少 4 倍,通信量与数据并行相同。

- ZeRO2:在ZeRO1的基础上,对梯度进行拆分。显存消耗减少 8 倍,通信量与数据并行相同。

- ZeRO3:在ZeRO2的基础上,对模型参数进行拆分。模型占用的显存被平均分配到每个 GPU 中,显存消耗量与数据并行的并行度成线性反比关系,但通信量会有些许增加。

论文中给出了三个阶段的显存消耗分布情况:

ZeRO1

模型训练中,正向传播和反向传播并不会用到优化器状态,只有在梯度更新的时候才会使用梯度和优化器状态计算新参数。因此每个进程单独使用一段优化器状态,对各自进程的参数更新完之后,再把各个进程的模型参数合并形成完整的模型。

假设我们有 𝑁𝑑 个并行的进程,ZeRO-1 会将完整优化器的状态等分成 𝑁𝑑 份并储存在各个进程中。当反向传播完成之后,每个进程的优化器会对自己储存的优化器状态(包括Momentum、Variance 与 FP32 Master Parameters)进行计算与更新。更新过后的Partitioned FP32 Master Parameters会通过All-gather传回到各个进程中。完成一次完整的参数更新。

通过 ZeRO-1 对优化器状态的分段化储存,7.5B 参数量的模型内存占用将由原始数据并行下的 120GB 缩减到 31.4GB。

ZeRO2

第二阶段中对梯度进行了拆分,在一个Layer的梯度都被计算出来后: 梯度通过All-reduce进行聚合, 聚合后的梯度只会被某一个进程用来更新参数,因此其它进程上的这段梯度不再被需要,可以立马释放掉。

通过 ZeRO-2 对梯度和优化器状态的分段化储存,7.5B 参数量的模型内存占用将由 ZeRO-1 中 31.4GB 进一步下降到 16.6GB。

ZeRO3

第三阶段就是对模型参数进行分割。在ZeRO3中,模型的每一层都被切片,每个进程存储权重张量的一部分。在前向和后向传播过程中(每个进程仍然看到不同的微批次数据),不同的进程交换它们所拥有的部分(按需进行参数通信),并计算激活函数和梯度。

初始化的时候。ZeRO3将一个模型中每个子层中的参数分片放到不同进程中,训练过程中,每个进程进行正常的正向/反向传播,然后通过All-gather进行汇总,构建成完整的模型。

NLP 大模型高频面题汇总

NLP基础篇

-

【NLP 面试宝典 之 模型分类】 必须要会的高频面题

-

【NLP 面试宝典 之 神经网络】 必须要会的高频面题

-

【NLP 面试宝典 之 主动学习】 必须要会的高频面题

-

【NLP 面试宝典 之 超参数优化】 必须要会的高频面题

-

【NLP 面试宝典 之 正则化】 必须要会的高频面题

-

【NLP 面试宝典 之 过拟合】 必须要会的高频面题

-

【NLP 面试宝典 之 Dropout】 必须要会的高频面题

-

【NLP 面试宝典 之 EarlyStopping】 必须要会的高频面题

-

【NLP 面试宝典 之 标签平滑】 必须要会的高频面题

-

【NLP 面试宝典 之 Warm up 】 必须要会的高频面题

-

【NLP 面试宝典 之 置信学习】 必须要会的高频面题

-

【NLP 面试宝典 之 伪标签】 必须要会的高频面题

-

【NLP 面试宝典 之 类别不均衡问题】 必须要会的高频面题

-

【NLP 面试宝典 之 交叉验证】 必须要会的高频面题

-

【NLP 面试宝典 之 词嵌入】 必须要会的高频面题

-

【NLP 面试宝典 之 One-Hot】 必须要会的高频面题

-

…