kafka作为一个实时的分布式消息队列,实时的生产和消费消息,这里我们可以

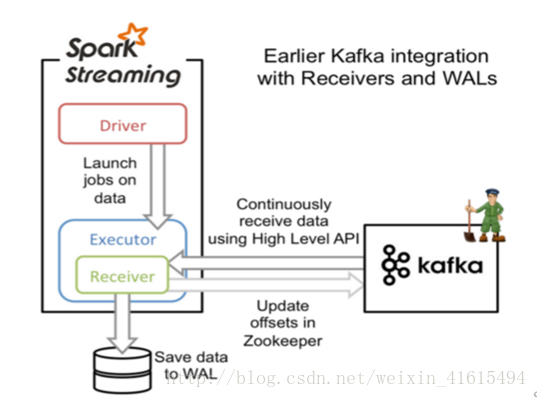

1.KafkaUils.createDstream方式:利用SparkStreaming实时计算框架实时的读取kafka中的数据然后进行计算。在spark1.3版本后,kafkaUtils里面提供了两个创建dstream的方法,一种为KafkaUtils.createDstream,另一种为KafkaUtils.createDirectStream。

构造函数为KafkaUtils.createDstream(ssc,[zk], [consumer group id], [per-topic,partitions] ) 使用了receivers来接收数据,利用的是Kafka高层次的消费者api,对于所有的receivers接收到的数据将会保存在Spark executors中,然后通过Spark Streaming启动job来处理这些数据,默认会丢失,可启用WAL日志,它同步将接受到数据保存到分布式文件系统上比如HDFS。 所以数据在出错的情况下可以恢复出来 。

|

A、创建一个receiver来对kafka进行定时拉取数据,ssc的rdd分区和kafka的topic分区不是一个概念,故如果增加特定主消费的线程数仅仅是增加一个receiver中消费topic的线程数,并不增加spark的并行处理数据数量。

B、对于不同的group和topic可以使用多个receivers创建不同的DStream

C、如果启用了WAL(spark.streaming.receiver.writeAheadLog.enable=true)

同时需要设置存储级别(默认StorageLevel.MEMORY_AND_DISK_SER_2),

即KafkaUtils.createStream(….,StorageLevel.MEMORY_AND_DISK_SER)

1.1KafkaUtils.createDstream实践

(1) 添加pom依赖

<properties>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

<scala.version>2.10.6</scala.version>

<scala.compat.version>2.10</scala.compat.version>

<encoding>UTF-8</encoding>

</properties>

<dependencies>

<!-- 添加scala的依赖 -->

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>${scala.version}</version>

</dependency>

<!-- 添加spark的依赖 -->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.10</artifactId>

<version>2.2.0</version>

</dependency>

<!-- 导入spark sql的依赖 -->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-sql_2.10