Self-supervised Image-specific Prototype Exploration for Weakly Supervised Semantic Segmentation 论文阅读

文章信息:

发表于:CVPR 2022

原文链接:https://arxiv.org/abs/2203.02909

源码:https://github.com/chenqi1126/SIPE

Abstract

弱监督语义分割(WSSS)基于图像级标签的研究因其低标注成本而受到广泛关注。现有方法通常依赖于类激活映射(CAM),该方法通过测量图像像素与分类器权重之间的相关性生成分割结果。然而,分类器往往只关注于判别性区域,而忽略了图像中其他有用的信息,导致生成的定位图不完整。为了解决这一问题,我们提出了一种自监督的图像特定原型探索方法(SIPE),包括图像特定原型探索(IPE)和通用-特定一致性(GSC)损失。

具体来说,IPE针对每张图像定制原型,以捕获完整的区域,形成了我们的图像特定类激活映射(IS-CAM),该方法通过两个连续的步骤实现。此外,GSC通过构建通用 CAM 和特定 IS-CAM 的一致性,进一步优化特征表示,并赋予原型探索自我纠正的能力。

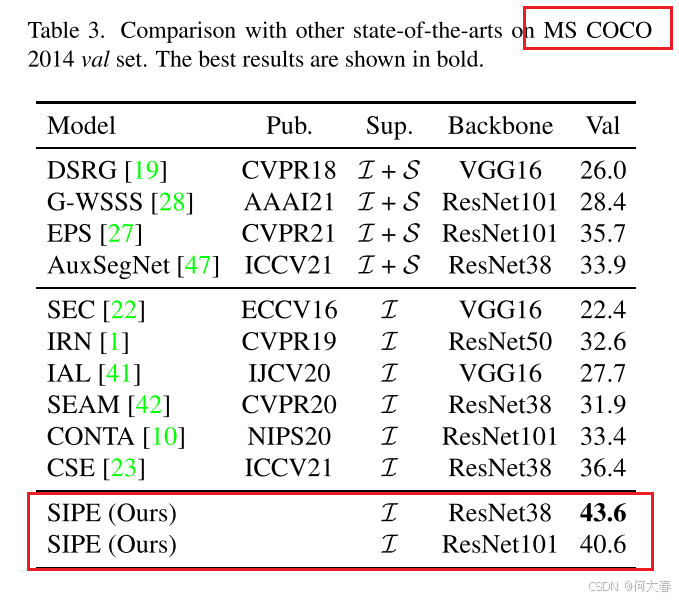

我们在 PASCAL VOC 2012 和 MS COCO 2014 分割基准数据集上进行了广泛的实验,结果表明,仅使用图像级标签的 SIPE 方法达到了新的最先进性能。代码已公开,地址为 https://github.com/chenqi1126/SIPE。

1. Introduction

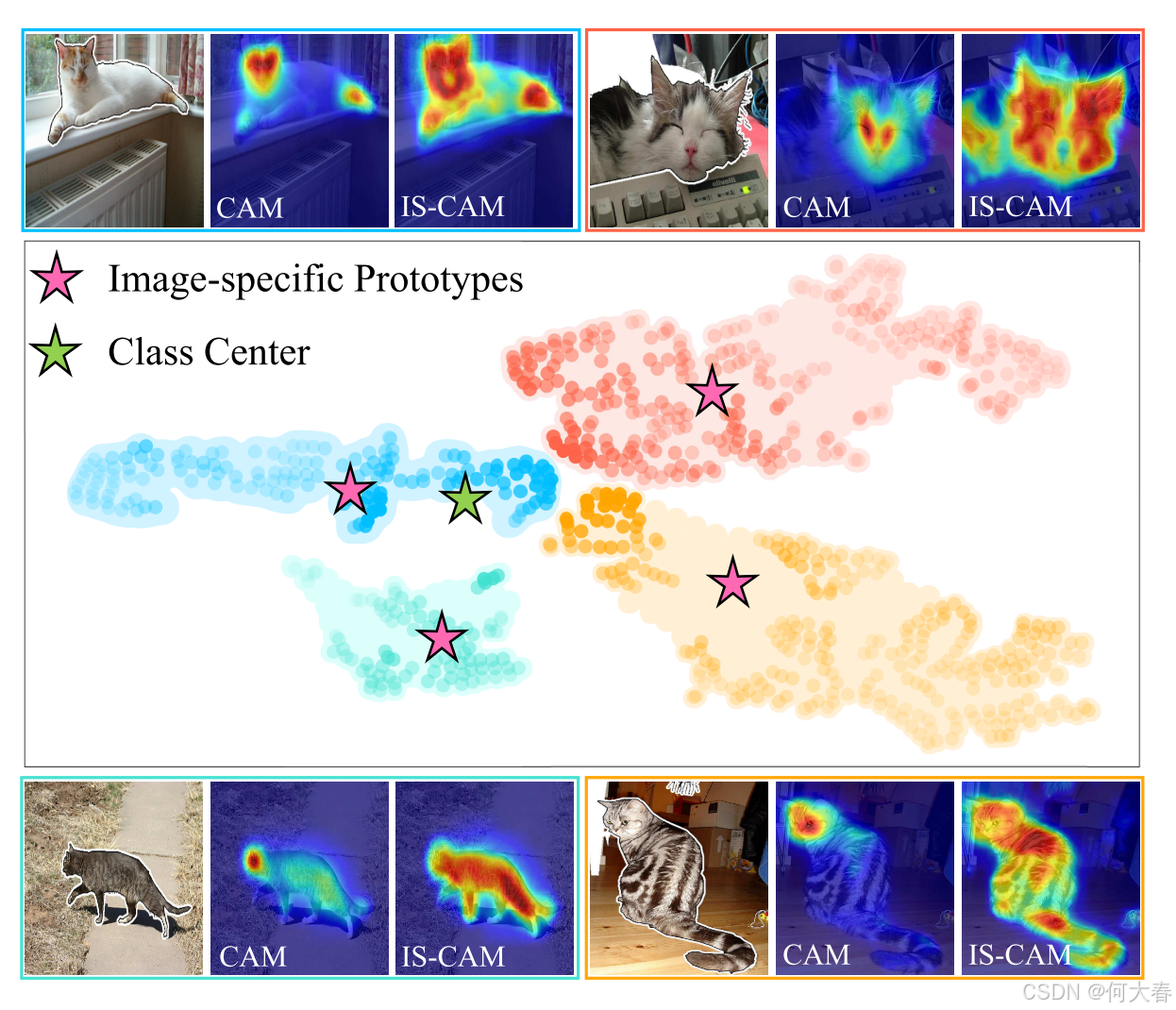

图1. 主要动机。我们通过 t-SNE [39] 可视化了四张猫图像的像素级特征分布,透明度表示激活强度。原始CAM使用类别中心(绿色星星)对每个像素进行激活。我们的方法提取了图像特定的原型(粉色星星),生成了图像特定CAM(IS-CAM),能够捕捉更完整的区域。

语义分割的目标是为图像中的每个像素分配一个语义类别标签,这在自动驾驶 [14]、医学影像 [38] 和遥感图像解译 [17] 等领域得到了广泛应用。得益于卷积神经网络(CNNs),语义分割在全监督方式下取得了显著进展。然而,训练一个全监督的分割模型需要大量像素级标注,这种标注过程既昂贵又耗时。 一种替代方法是利用弱标注进行学习,例如图像级标签 [2]、边界框 [26, 49]、涂鸦标注 [29, 34, 46] 和点标注 [3, 5]。在这些研究中,基于图像级标签的弱监督语义分割(WSSS)在学术界中受到了广泛关注。

大多数现有方法利用类激活映射(Class Activation Mapping, CAM) [53] 技术为目标对象提供定位线索。具体来说,这些方法通过训练分类器,将其学习到的权重视为每个类别的通用表示,即类别中心。随后,这个类别中心与图像像素进行关联,以生成定位图,如图 1 所示。然而,CAM 往往只关注少数主要区域(如猫的头部),而忽略了其他有用的线索(如猫的身体)。 为了解释这个问题,我们可视化了从训练好的分类网络中提取的前景像素级特征。这些特征用四种不同颜色表示,其透明度表示 CAM 的激活程度。我们发现,类别中心总是对较近的像素(对应某些主要区域)给予高激活值,而忽略了较远的像素。这种不平衡的激活导致了如图 1 所示的不完整定位图。 此外,通过特征的质心(粉色星星)激活每张图像的特征,可以有助于探索更完整的区域(参见图 1 中的 Image-Specific CAM,简称 IS-CAM)。因此,本文旨在定制图像特定的原型,以自适应地描述图像本身的特征。

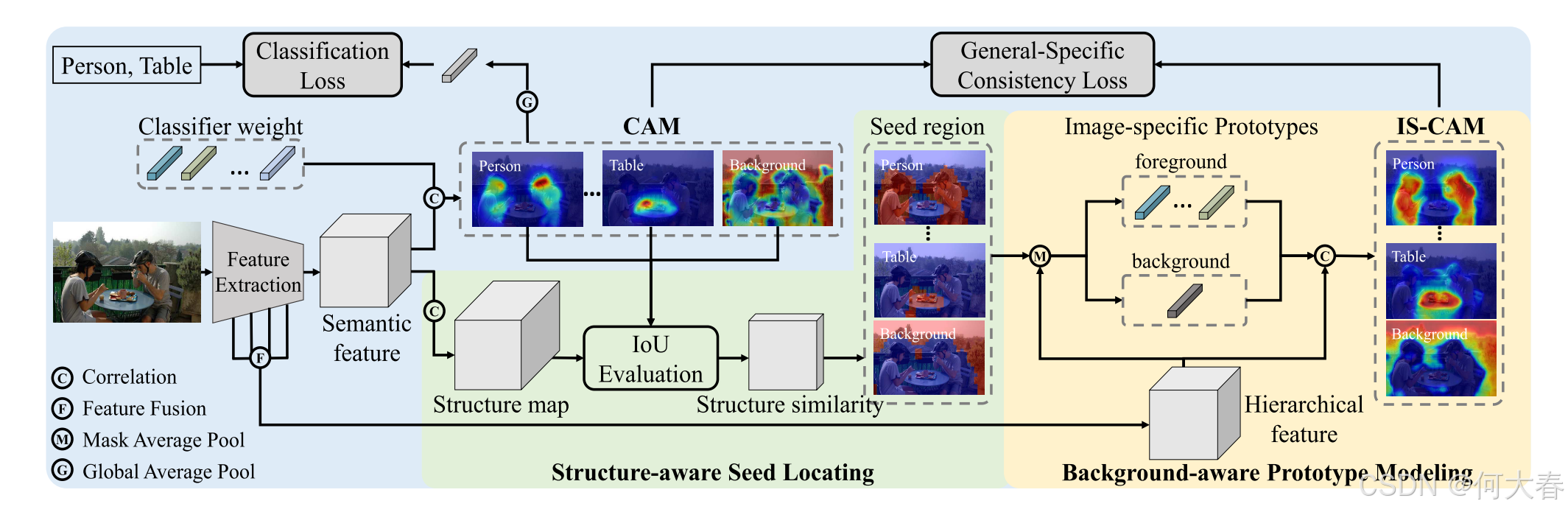

为此,我们提出了一种新的弱监督语义分割框架,称为自监督图像特定原型探索(Self-supervised Image-specific Prototype Exploration, SIPE)。所提出的 SIPE 包括图像特定原型探索(Image-specific Prototype Exploration, IPE)和通用-特定一致性(General-Specific Consistency, GSC)损失,具体结构如图 2 所示。

具体而言,IPE 通过两个连续的步骤实现原型的特征化,从而能够捕获更完整的定位图。在第一步中,我们利用像素间的语义关系来探索空间结构线索,从而定位每个类别的鲁棒种子区域。基于这些种子区域,我们提取图像特定的原型,并通过原型相关性生成我们的 IS-CAM。

此外,GSC 的提出旨在构建通用 CAM 和我们特定 IS-CAM 的一致性。这种自监督信号进一步优化了特征表示,并赋予原型探索自我校正的能力。我们在 Pascal VOC 2012 [11] 和 MS COCO 2014 [30] 数据集上进行了大量实验,结果表明,在仅使用图像级标签的情况下,我们的 SIPE 达到了新的最先进性能。

我们的主要贡献可概括为:

-

我们提出了自监督图像特定原型探索(Self-supervised Image-specific Prototype Exploration, SIPE),用于学习图像特定的知识,以实现弱监督语义分割。

-

我们提出了图像原型探索(Image Prototype Exploration, IPE),为每张图像定制特定的图像原型。该方法通过结构感知的种子定位和背景感知的原型建模实现,使模型能够捕获更完整的定位图。

-

我们提出了一种通用-特定一致性(GSC)损失,用于有效地约束原始CAM和IS-CAM,从而增强特征表示能力。

2. Related Work

由于标注成本较低,基于图像级标签的弱监督语义分割逐渐受到越来越多的关注。大多数现有方法采用**类激活映射(CAM)**生成定位图,并将其优化为伪标签,以训练一个全监督分割模型。为了获得高性能的分割模型,许多策略被用来提升定位图的质量。

Erasure and accumulation.擦除方法通过有意从图像[23][37][43]或特征图[8][18]中移除辨别性区域,来探索更多的目标区域。然而,擦除大部分辨别性区域可能会使分类器感到困惑,从而导致误报。为避免这一问题,一些研究通过对扩张卷积率[44]、图像尺度[50]、空间位置[24]以及训练过程[20]进行精心设计的采样,来累积多个激活结果。

Cross-image mining.考虑到图像之间的共享语义,一些研究设计了跨图像关系挖掘模块,如跨图像相似度[13]、最大二分匹配[31]和共注意力分类器[36],以挖掘弱标签的语义上下文。此外,还通过图卷积网络[28]和自注意力机制[45]探索多图像的协同信息,以捕捉潜在的知识。

Background Modeling.许多方法[21, 27, 47, 48]通过使用辅助显著性图来获得精确的背景,这非常费力。没有辅助图的情况下,Fan等人[12]提出了类内判别器,用于区分每个类的前景和背景。然而,由于图像中物体和场景的多样性,为每个类学习一个通用的类内判别器是相当棘手的。

Self-supervised Learning.近年来,自监督方法挖掘潜在信息并构建监督信号,已被证明是缩小全监督和弱监督语义分割之间监督差距的有前景的解决方案。Wang等人[42]对来自不同变换图像的CAM应用一致性正则化,以实现自监督学习。Chang等人[4]引入了一种自监督任务,发现子类别,提供额外的监督以增强特征表示。

与现有方法不同,我们充分考虑了图像的独特性,提出了图像特定原型来发现完整的区域,并构建自监督方式以增强特征表示。

3. Approach

图2. 所提出的SIPE框架用于弱监督语义分割的概览。它主要包括两种方法:图像特定原型(IPE)探索和通用-特定一致性(GSC)损失。具体而言,在我们的IPE中,提出了一种基于结构感知的种子定位方法以获取更稳健的种子区域,同时开发了一种基于背景感知的原型建模方法用于提取分层特征。此外,我们在两种CAM(即通用CAM和我们的IS-CAM)之间加入了一致性正则化。这种自监督信号在CAM和IS-CAM中都有效地进行了校正。

本节详细阐述了用于弱监督语义分割的SIPE框架,如图2所示。首先,我们简要回顾了CAM的基础知识。然后,我们描述了探索图像特定原型和图像特定CAM(IS-CAM)的流程。最后,引入了带有一般-特定一致性(GSC)的自监督学习,以增强特征表示。

3.1. Class Activation Mapping

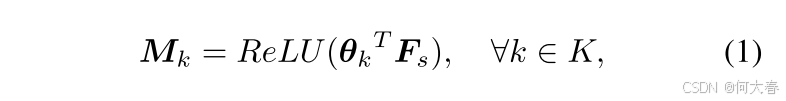

给定一张输入图像和一个预训练的分类网络,针对 K K K 个前景类别的类激活图 M f = { M k } k = 1 K M_f = \{M_k\}_{k=1}^K Mf={Mk}k=1K 可以表示为:

其中, F s F_s Fs 是网络最后一层的语义特征, θ k \boldsymbol{\theta}_k θk 表示第 k k k个分类器的权重,因此 M k M_k Mk 是第 k k k 类的特定激活图。按照以往的工作,CAM 会通过空间轴上的最大值进行归一化到 [ 0 , 1 ] [0,1] [0,1],从而可以被视为每个类别的概率。

考虑到背景在分割任务中的重要性,我们参考文献 [42] 基于 M f M_\mathrm{f} Mf 估计背景激活图 M b M_\mathrm{b} Mb。由于 CAM 往往只能部分覆盖目标区域,估计的背景通常在前景区域内包含较高的响应,这会带来显著的噪声。为减少这种混淆,我们通过引入衰减系数 α = 0.5 \alpha=0.5 α=0.5 来减弱背景概率:

我们将处理后的背景激活图与前景激活图结合为一个整体,即 M = M ^ f ∪ M b M=\hat{M}_f \cup M_b M=M^f∪Mb,以帮助模型学习背景知识。

3.2. Image-specific Prototype Exploration

图像特定原型被提出用于表示每个类别的特征分布,从而捕获更完整的区域。与少样本分割中的原型表示方法 [33, 40, 52] 不同,弱监督语义分割 (WSSS) 中没有像素级的标注掩码。为了探索用于表征特征分布的图像特定原型,我们设计了一个高效的两步流程。第一步提供了稳健的类别种子区域,第二步在综合的特征空间中聚合这些种子,以实现精确的图像特定表示。

Structure-aware Seed Locating.一种直接获取种子的方法是经验性地为 CAM [19] 选择阈值,但由于物体和场景的多样性,很难在不同图像上使用固定的阈值。尽管 CAM 更关注具有区分性的区域,但它在其余区域也会产生较弱的激活。这意味着 CAM 具有提供语义对象空间结构的潜力。此外,一个像素的空间结构可以通过聚类高相关性的像素来构成。对于一张图像,可以通过将每个像素的空间结构与 CAM 匹配来确定其类别。基于上述分析,我们提出了一种结构感知种子定位方法,通过探索像素间的语义来捕捉空间结构,并利用 CAM 作为模板匹配最优类别。

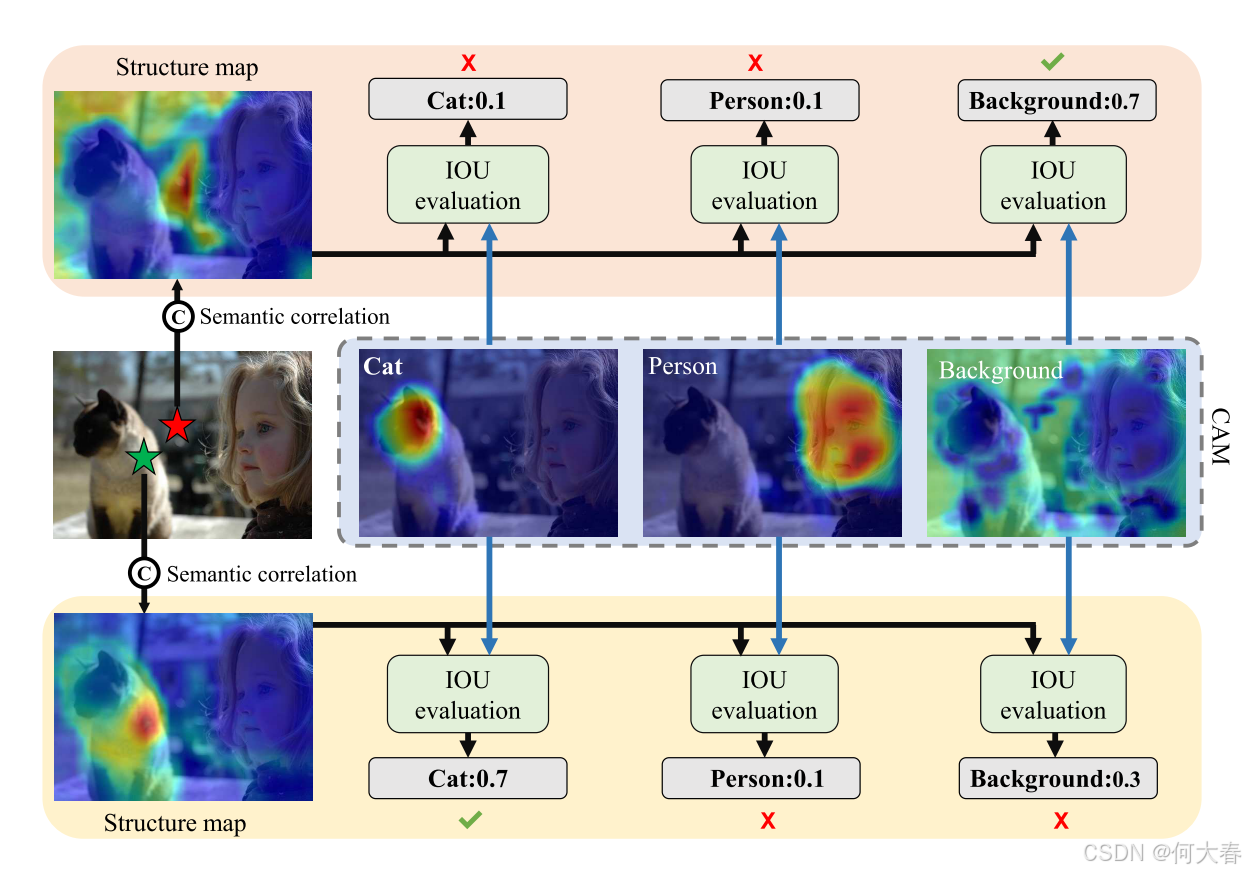

图 3. 结构感知种子定位的示意图,选定的前景(绿色)和背景像素(红色)。结构图是通过语义关联获得的。然后,可以通过 IoU 评估类别-wise 结构相似度,选择最大值作为最终类别。

图 3 \color{red}3 3展示了所提出的方法及其选择的前景和背景示例。首先,对于任意像素 i i i,我们将其语义特征向量 f i \boldsymbol{f}^i fi作为查询,用来计算与该特征图中所有像素的语义相关性。由于具有高相关性分数的像素更可能属于同一类别,这些高相关性像素可以突出空间结构。因此,我们通过像素间的语义相关性来定义一个像素的空间结构:

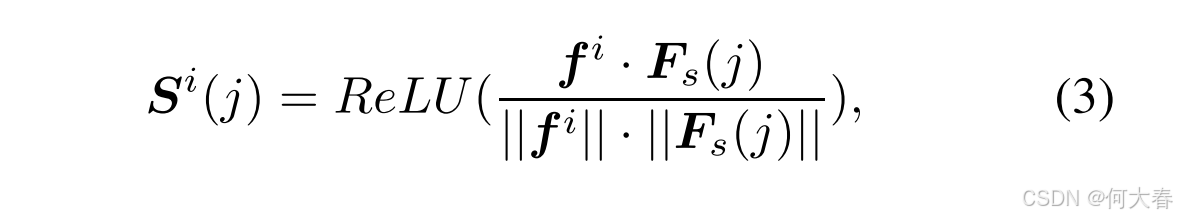

其中, ⋅ \cdot ⋅ 表示点积运算, j j j 是特征图以及结构图上的空间索引。 S i ( j ) \boldsymbol{S}^i(j) Si(j) 表示像素 i i i 与像素 j j j 之间的语义相关性,而 S i \boldsymbol{S}^i Si 是像素 i i i 的结构图。我们通过 ReLU 函数抑制负相关性,以消除无关像素的影响。

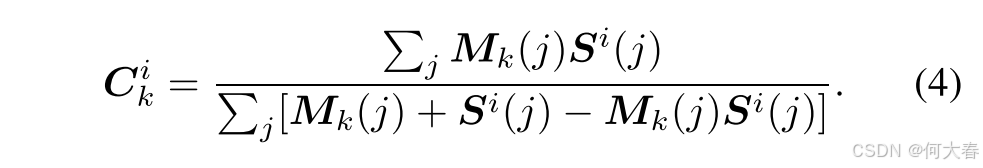

其次,我们计算像素 i i i 的结构图与 CAM 之间的按类别 IoU(交并比),作为结构相似性:

C k i \boldsymbol{C}_k^i Cki 表示像素 i i i 相对于第 k k k 类的结构相似性。 j j j 是激活图和结构图上的空间索引。从图 3 可以看出,前景像素(绿色星标)与猫的身体相关联,并且在猫类别的 CAM 上获得了最高的 IoU。此外,背景像素(红色星标)与前景像素没有关联,因此更有可能属于背景类别。

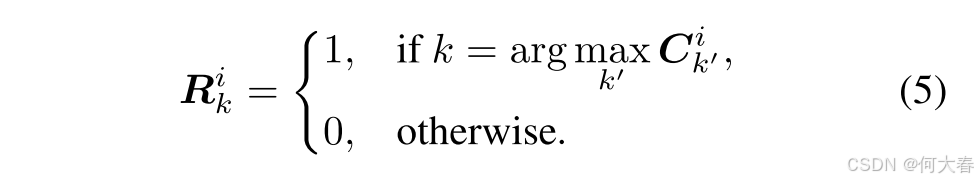

最后,将像素 i i i 分配给具有最大相似性的类别:

通过对图像的所有像素并行重复此过程,可以定位出前景和背景类别的种子区域 R R R,如图 2 所示。

Background-aware Prototype Modeling.在这一部分,我们同时建模前景和背景原型。考虑到背景没有特定的语义,因此在语义特征空间中很难探索具有代表性的背景原型。相反,浅层的特征包含丰富的低级视觉信息(例如颜色、纹理),这更适合用于建模与背景相关的信息。因此,我们修改了主干网络的架构,以捕捉层次化的特征,从而实现有效的原型表示。

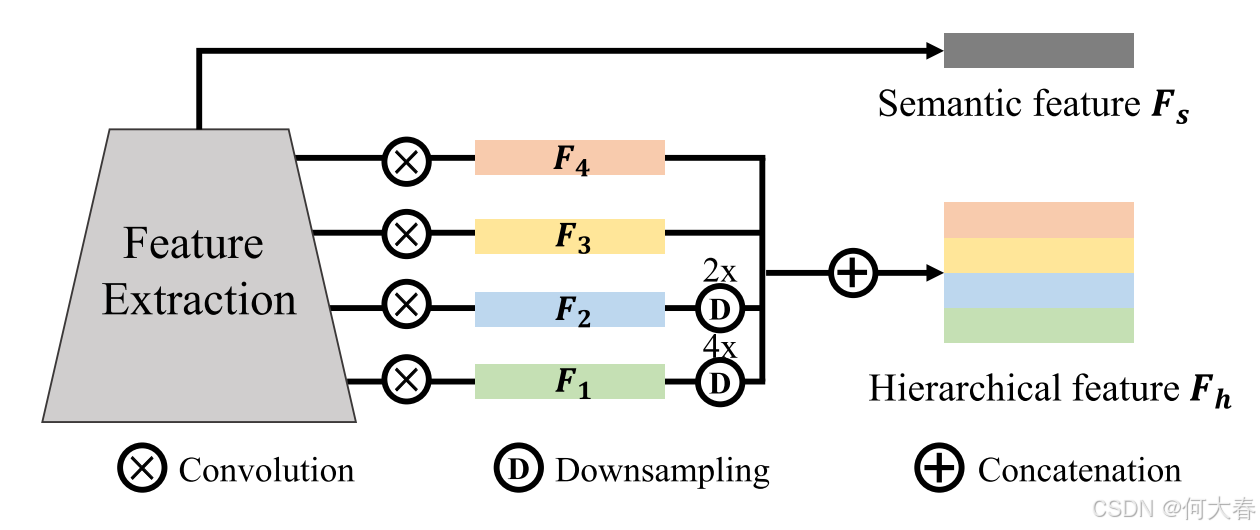

图 4. 修改后的骨干网络示意图,用于提取层次化特征表示。语义特征从最后一层提取,层次化特征是骨干网络四个阶段的融合。

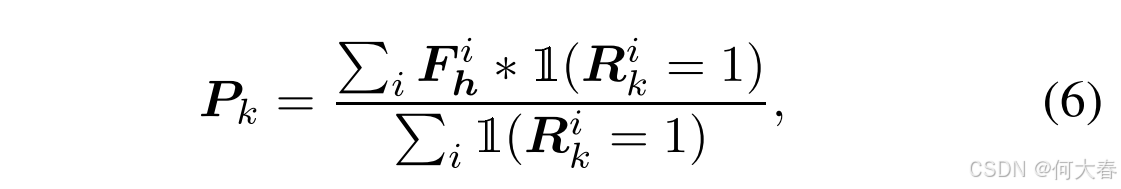

图 4 \color{red}4 4展示了修改后的主干网络架构。具体来说,我们添加了四个卷积层来提取多尺度的输出。然后,将这些多尺度输出调整为相同的大小并进行拼接,形成层次化特征 F h F_h Fh。因此,前景和背景的图像特定原型 P k P_k Pk 可以通过层次化特征空间中种子区域的质心来表示:

其中 i i i 索引空间位置, 1 ( ⋅ ) 1(\cdot) 1(⋅) 如果参数为真则输出 1,否则输出 0。这个过程对种子像素进行类别压缩,得到 K K K个前景原型和一个背景原型。

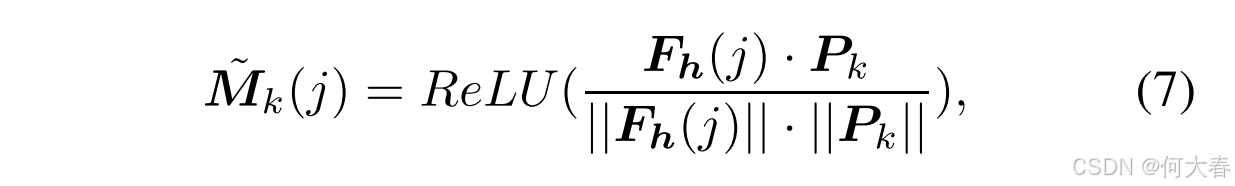

通过这些图像特定的原型,图像特定的类激活映射(IS-CAM)可以按以下方式计算:

其中, M ~ k ( j ) \tilde{\boldsymbol{M}}_k(j) M~k(j) 是第 k k k 类在像素 j j j 处的图像特定类激活映射(IS-CAM)。相关性被限制在 [-1, 1] 范围内,随后通过 ReLU 函数去除负相关。

与原始的 CAM 使用分类器权重作为类中心来计算每个像素的相关性不同,提出的 IS-CAM 利用针对每张图像定制的原型来实现更完整的物体区域。此外,背景原型建模提供了高质量的背景定位线索,从而帮助确定准确的前景区域。

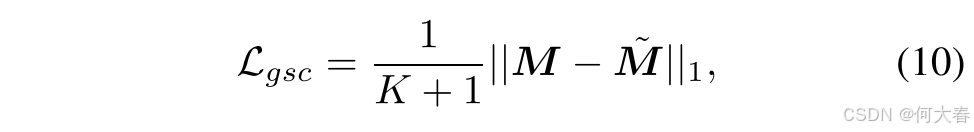

3.3. Self-supervised Learning with GSC

为了进一步利用图像特定的知识,我们引入了自监督学习范式。整体训练损失由多标签分类损失和通用-特定一致性(GSC)损失组成。

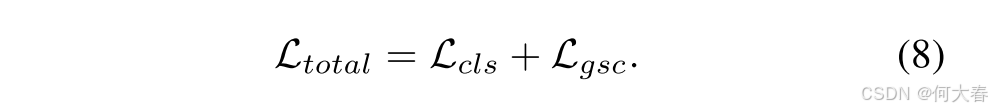

分类损失通过图像级类别标签 y y y 和预测 y ^ \hat{y} y^ 之间的多标签软边际损失来计算,预测 y ^ \hat{y} y^ 是通过对由CAM生成的前景图进行平均得到的。

其中σ是sigmoid激活函数。

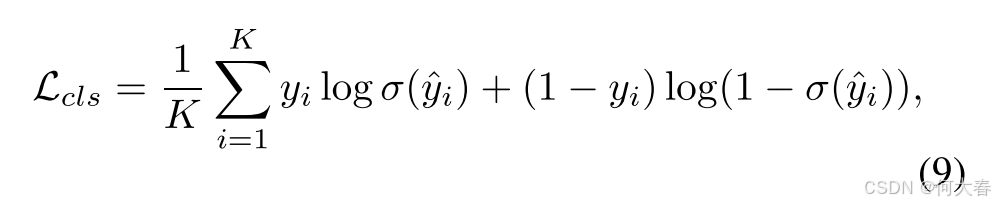

GSC(通用-特定一致性损失)用于最小化由分类器权重激活的原始CAM和由图像特定原型激活的ISCAM之间的差异。该一致性正则化的数学定义被表示为这两种CAM的L1归一化:

其中 M M M 和 M ~ \tilde{M} M~ 分别表示原始 CAM 和 IS-CAM。损失值对 K K K 个前景类别和一个背景类别进行平均。

通过这种一致性,图像特定的知识被注入到特征表示中,并在训练周期中完成协同优化。IS-CAM 使得原始 CAM 能够关注缺失的物体区域,这隐性地缩小了辨别像素和缺失像素之间的特征距离。此外,增强的语义和层次特征有助于捕捉更全面和准确的图像特定原型,进而提高定位图的质量。

4. Experiments

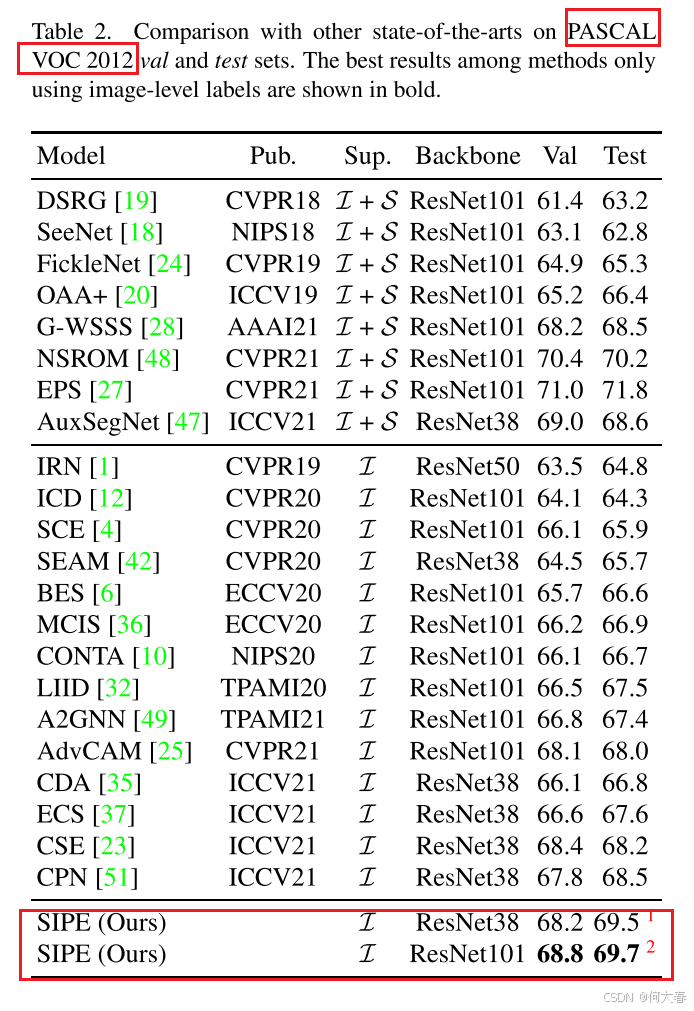

在本节中,我们首先详细说明实验设置,包括数据集、评估指标和实现细节。其次,我们在 PASCAL VOC 2012 数据集 [11] 和 MS COCO 2014 数据集 [30] 上,将我们的方法与最新的先进方法进行比较。最后,我们通过一系列消融实验验证所提出方法的有效性。

4.1. Experimental Settings

Dataset and Evaluated Metric.我们在 PASCAL VOC 2012 分割基准数据集 [11] 上评估所提出的方法,该数据集包含 20 个前景类别和 1 个背景类别。官方数据集划分为 1,464 张训练图像,1,449 张验证图像和 1,456 张测试图像。根据语义分割的常用实验协议,我们使用 SBD [15] 的额外标注构建了包含 10,582 张图像的扩展训练集。另一个数据集 MS COCO 2014 总共包含 81 个类别,包含 8 万张训练图像和 4 万张验证图像,对于弱监督语义分割而言具有挑战性。需要注意的是,在网络训练期间,这两个数据集仅提供图像级分类标签。我们使用平均交并比(mIoU)作为评估分割结果的指标。PASCAL VOC 测试集的结果通过官方评估服务器获得。

Implementation Details.在我们的实验中,采用了基于 ImageNet [9] 预训练的 ResNet50 [16] 作为主干网络,输出步幅为 16,其中全连接层被替换为一个输出通道为 20 的分类器。数据增强策略与 [25] 相同,包括随机翻转、随机缩放和裁剪。模型使用 2 块 Nvidia A100 GPU,在批量大小为 16 的条件下进行训练。采用 SGD 优化器对模型进行 5 轮训练,动量为 0.9,权重衰减为 1e-4。主干网络和新添加层的学习率分别设置为 0.1 和 1。我们使用多项式(poly)学习率调度器,将学习率按 0.9 的指数衰减。

Inference.在推理阶段,网络通过分层特征生成前景和背景种子,并将其激活为定位图。不同于其他研究 [25, 42] 通过检查训练集上的各种 mIoU 分数来生成伪标签的方法,我们直接利用背景定位图计算伪标签。

4.2. Comparison with State-of-the-arts

5. Conclusion

本文提出了一种用于弱监督语义分割的自监督图像特定原型探索(Self-supervised Image-specific Prototype Exploration, SIPE)方法。在我们的框架中,提出了一种图像特定原型探索(Image-specific Prototype Exploration, IPE)方法,用以生成更优的定位图。这一方法通过结构感知的种子定位和背景感知的原型建模实现。此外,我们设计了一种通用-特定一致性(General-Specific Consistency, GSC)损失,用于高效地对通用CAM和图像特定CAM(IS-CAM)进行正则化,从而增强特征表示。大量实验表明,SIPE在两个著名的基准数据集上使用图像级标签达到了新的最先进性能。

阅读总结

真好,前几年原型感觉百花齐放,现在再用类似的原型做相关任务感觉会被说Lack of Novelty。迷茫,很多新工作都和大模型有关了,LLM或VLM,传统的改进网络结构在一些领域感觉不够打了。拥抱大模型,怎么拥抱,还要探索。继续沉淀吧。

这篇文章,还是比较好理解的内容纯属翻译,我也懒得整理了。