ELK日志系统分析

ELK的工作原理:

1.将日志进行集中化管理

2.将日志格式化(Logstash)并输出到Elasticsearch

3.对格式化后的数据进行索引和存储(Elasticsearch)

4.前端数据的展示(Kibana)

Elasticsearch特点:

分布式、零配置、自动发现、索引自动分片、索引副本机制、RESTful风格接口、多数据源、自动搜索负载

分片的主要原因:

水平分割扩展、增大存储量

分布式并行跨分片操作,提高性能和吞吐量

Logstash:

它只做三件事:数据输入、数据加工(过滤、改写)、数据输出,通过组合输入和输出,可以实现多种需求

Logstash的主要组件

Shipper:日志收集者

Indexer:日志存储者

Broker:日志Hub

Search and Storage : 允许对事件进行搜索和存储

Web Interface : 基于Web的展示页面

Kibana的功能:

Elasticsearch无缝之集成、整合数据、复杂数据分析、让更多团队成员受益、接口灵活、配置简单、可视化多数据源、简单数据导出

端口:

elasticsearch : tcp 9200

elasticsearch-head : tcp 9100

kibana: tcp 5601

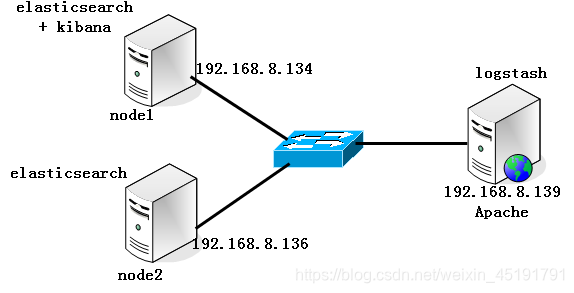

依据上图配置网络

在俩个ELK节点服务器上配置域名解析

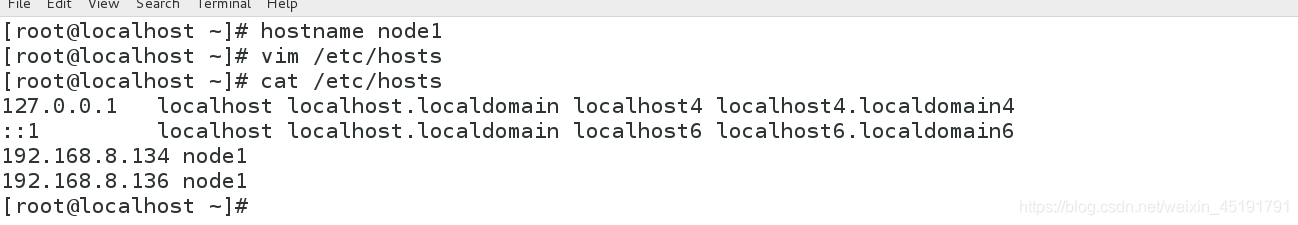

Node1的配置

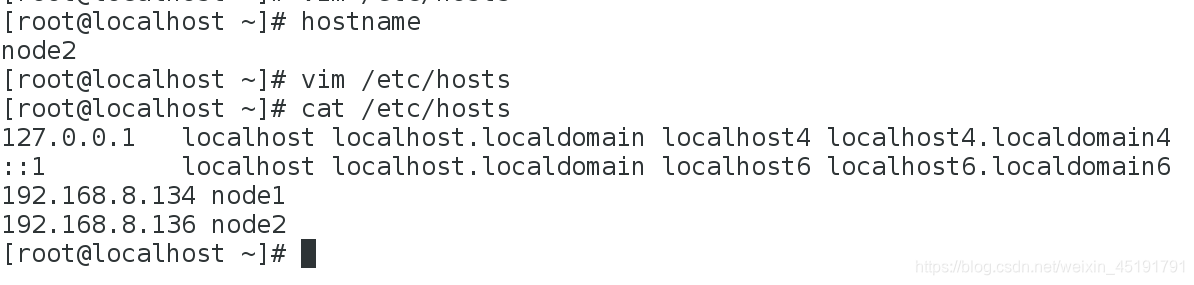

Node2的配置

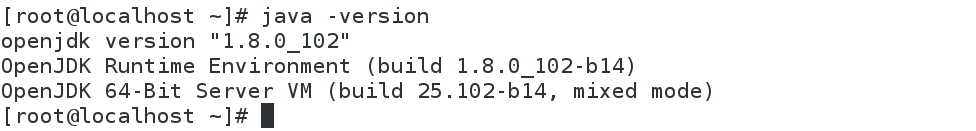

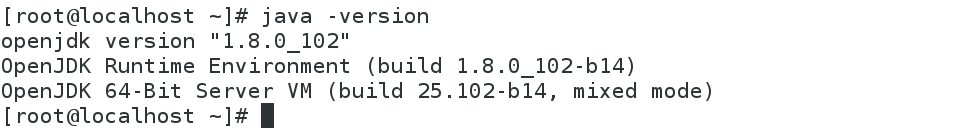

检查Java环境

Node1

Node2

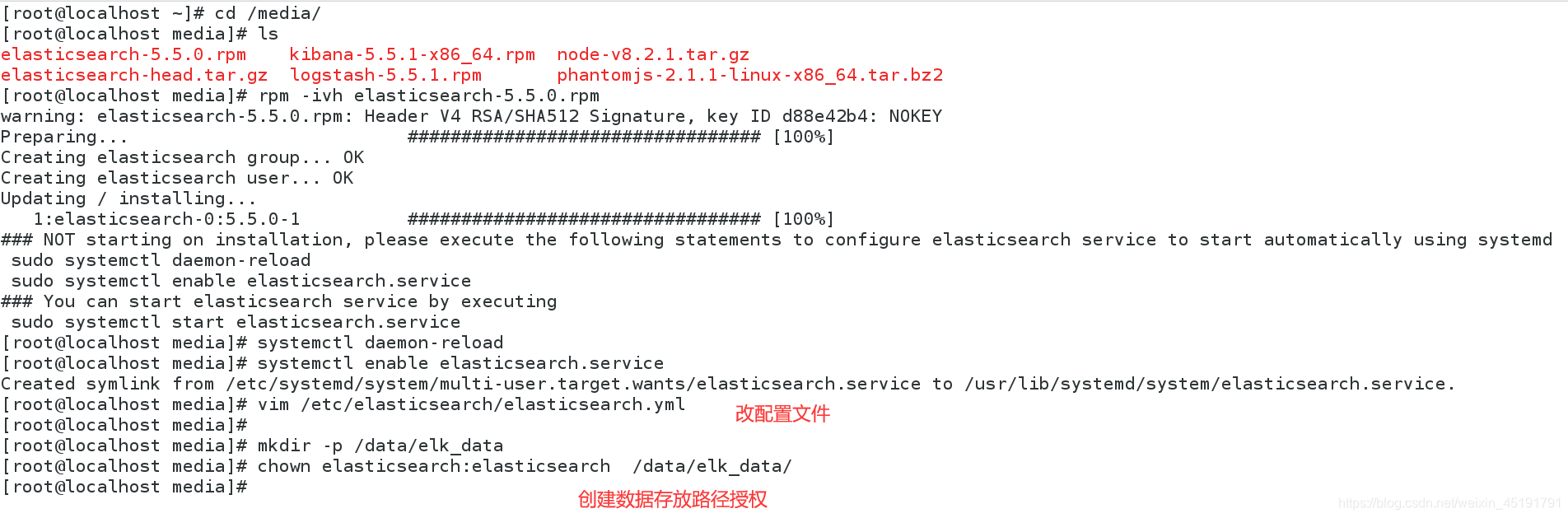

部署Elasticsearch软件

俩台Node都需要部署Elasticsearch软件

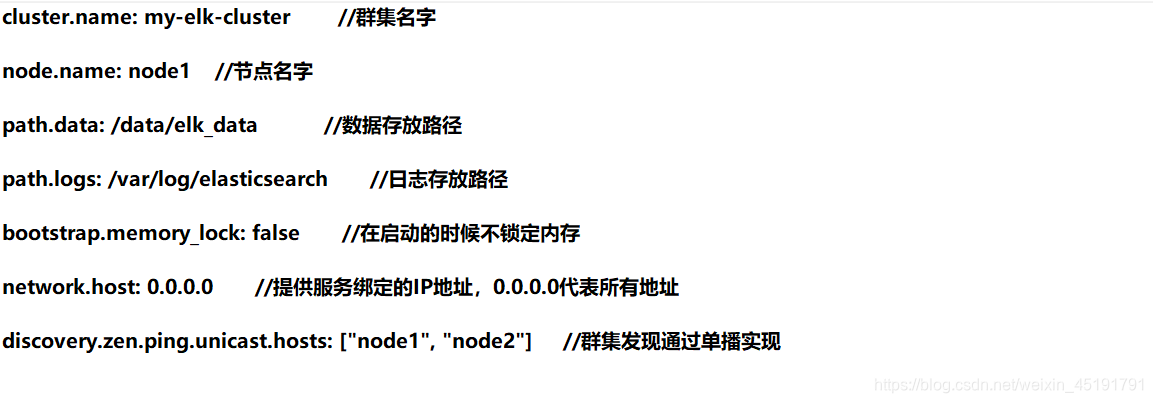

配置文件修改内容(俩台步骤相同,只需改个节点名字)

开启服务

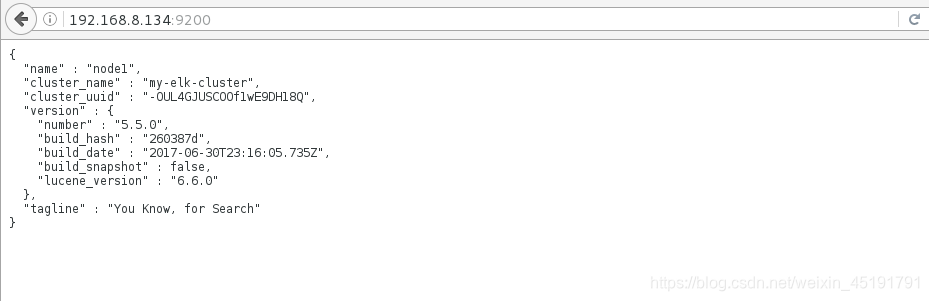

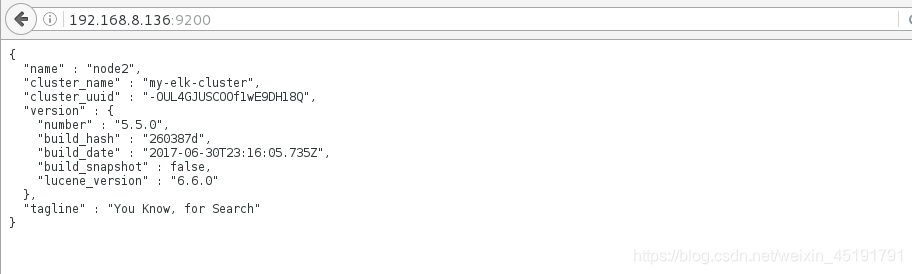

查看节点上的信息(打开浏览器输入http://Node服务器的IP:9200)

Node1

Node2

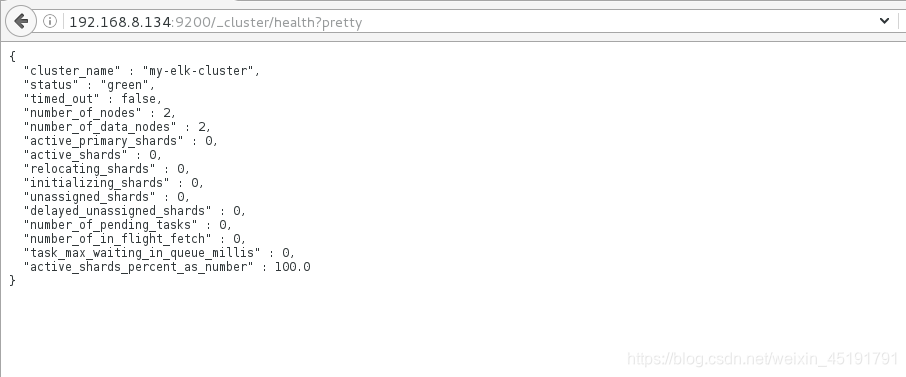

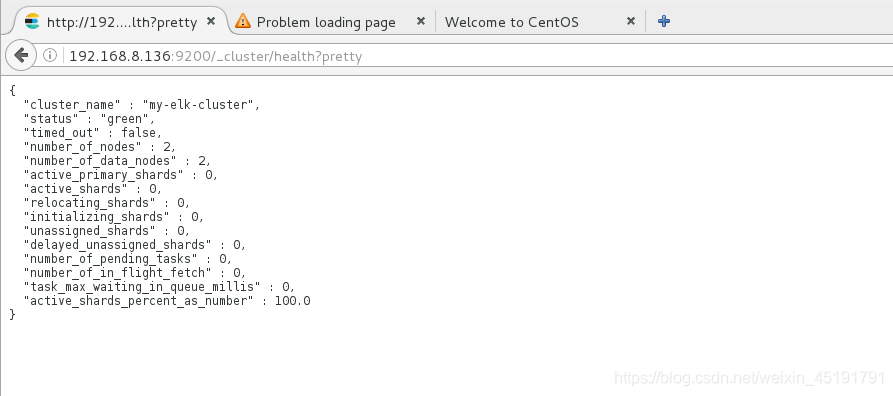

打开浏览器输入http://Node服务器的IP:9200/_cluster/health?pretty 查看群集的健康情况,status值为green(绿色),表示节点健康运行

node1

node2

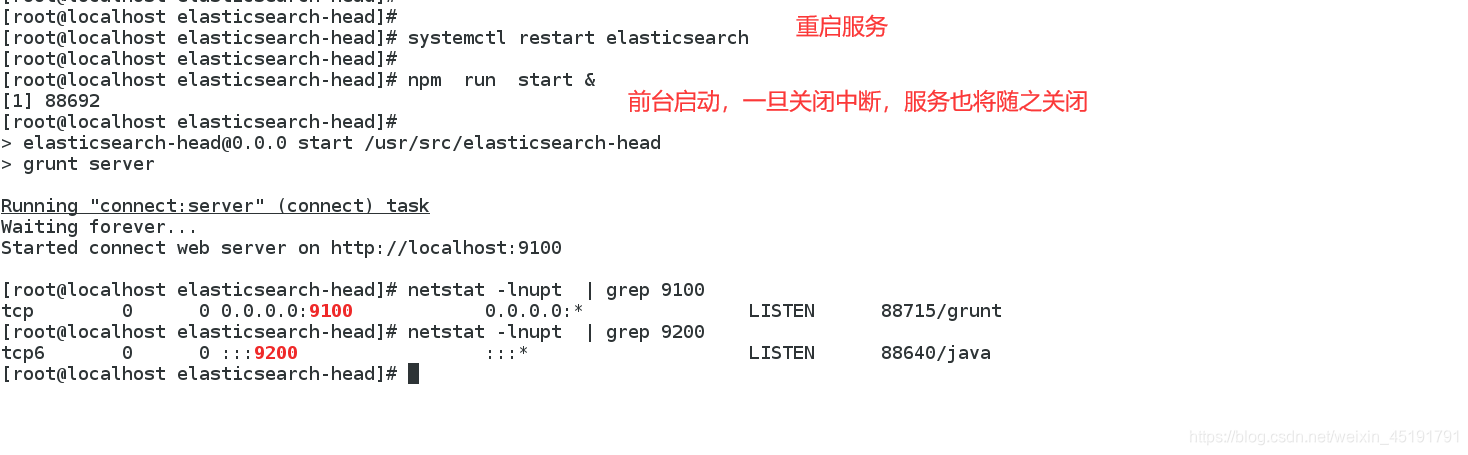

安装Elasticsearch—head插件(解压后的目录不能有中文路径)

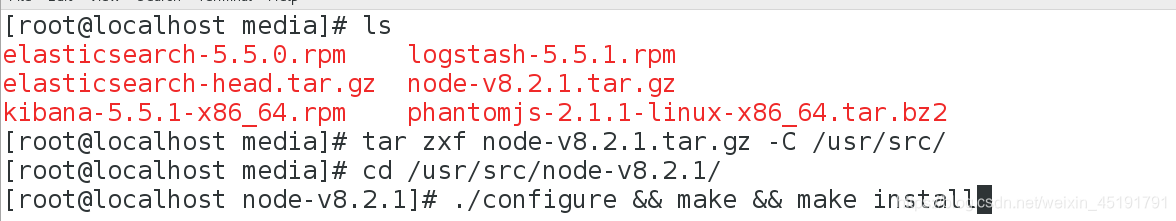

编译安装Node,编译安装时间较长大约40min

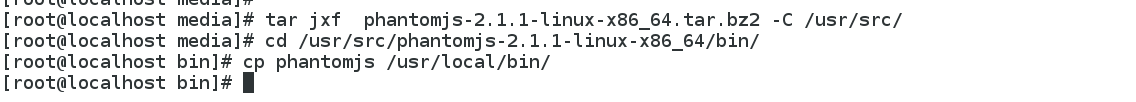

安装phantomjs

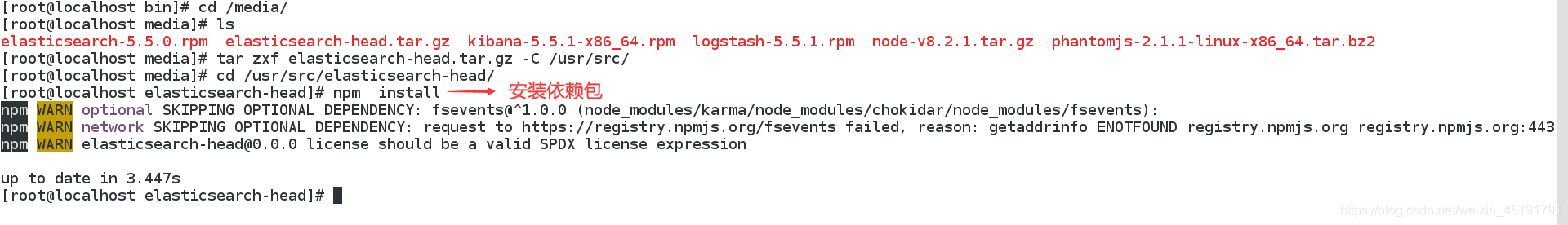

安装Elasticsearch—head

修改Elasticsearch主配置文件

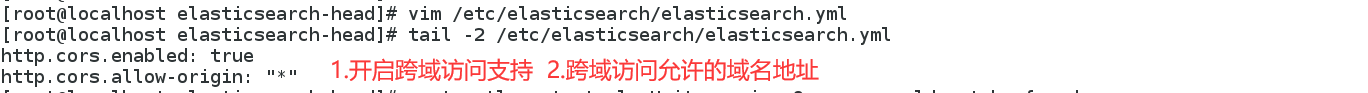

启动服务 必须在解压后的elasticsearch-head目录下启动服务,否则启动会失败

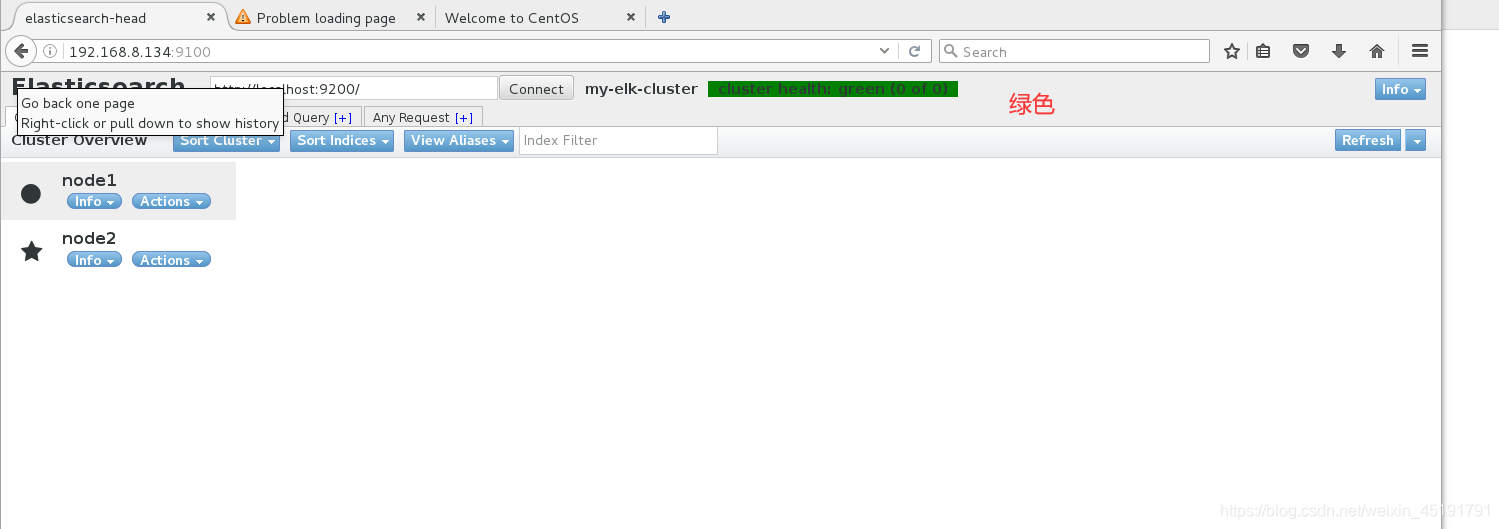

通过elasticsearch-head查看Elasticsearch信息,通过浏览器访问http://192.168.8.134:9100/并连接群集(可以看到群集很健康,健康值为绿色)

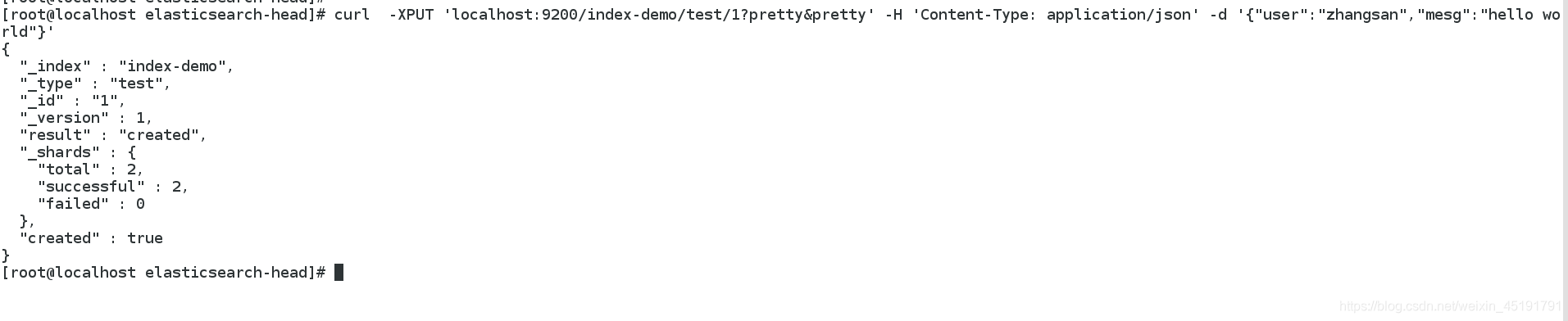

插入一条索引

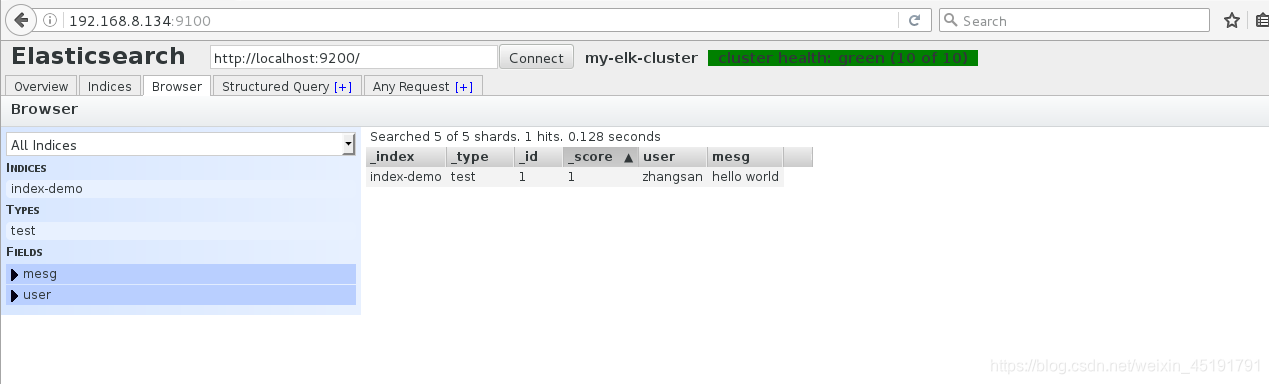

刷新浏览器,即可查看创建成功的索引

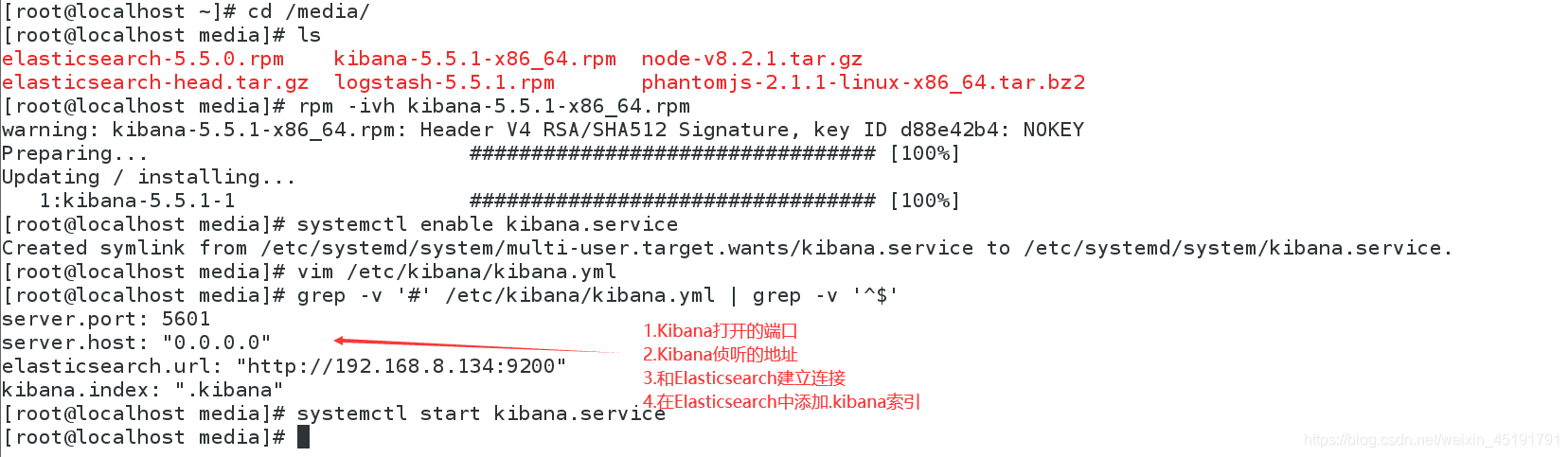

安装Kibana

在Node1服务器上安装Kibana,设置Kibana的主配置文件

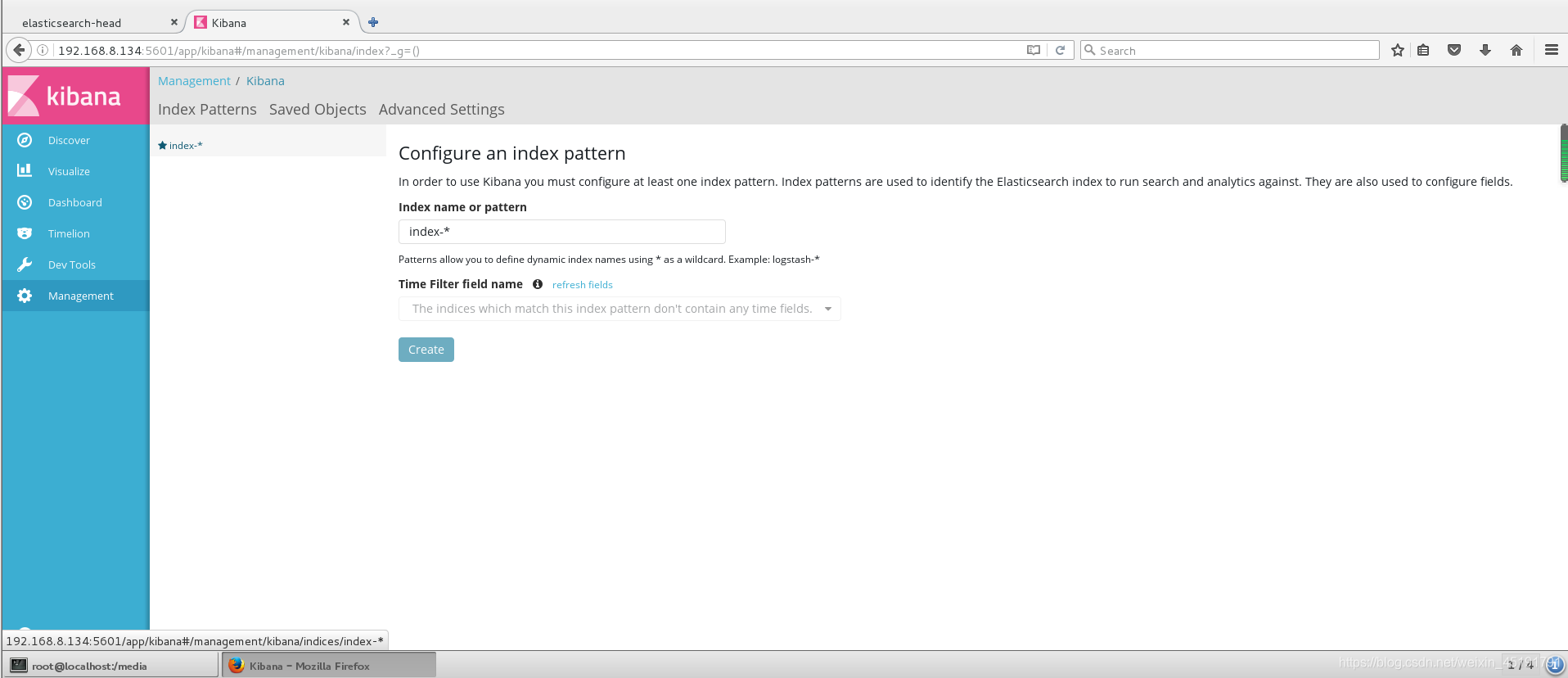

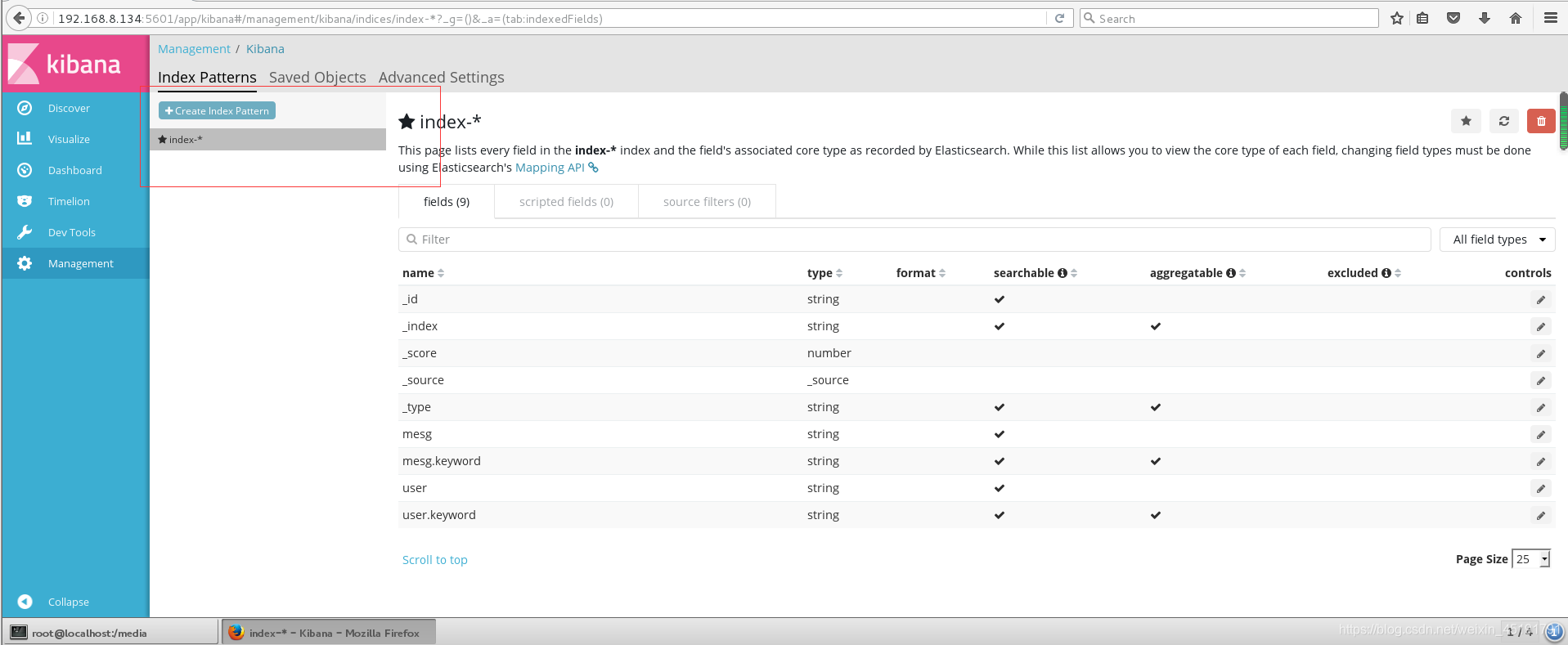

验证Kibana,浏览器访问http://192.168.8.134:5601,第一次登录需要添加一个Elasticsearch索引,添加前面船舰的index-demo

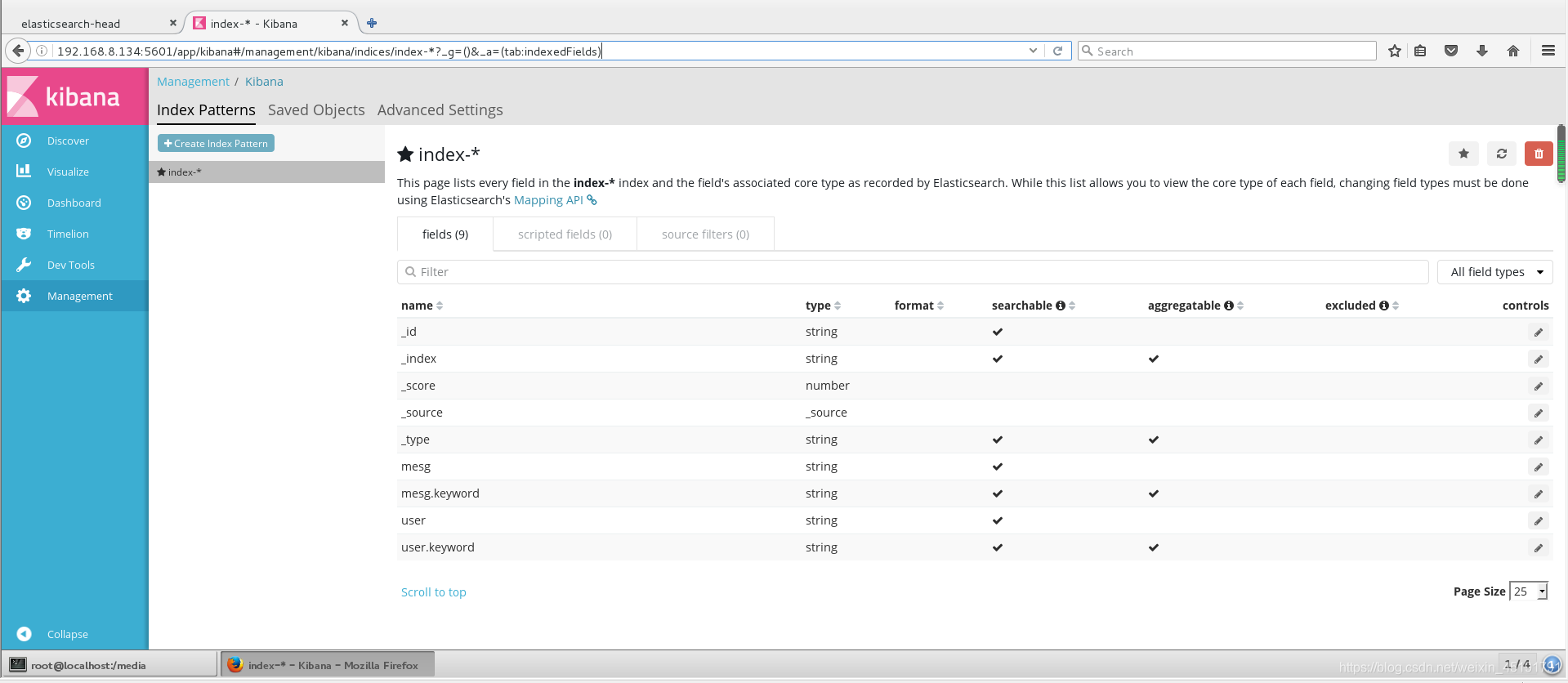

查看索引的字段

Logstash安装及使用方法

将apache服务器的日志添加到Elasticsearch并通过Kibana显示

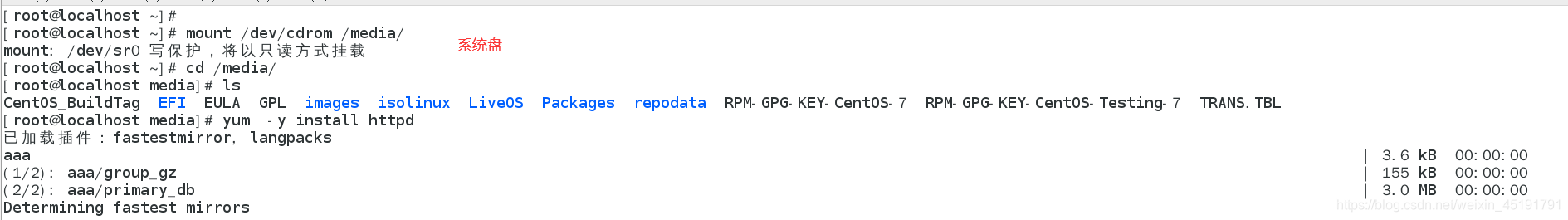

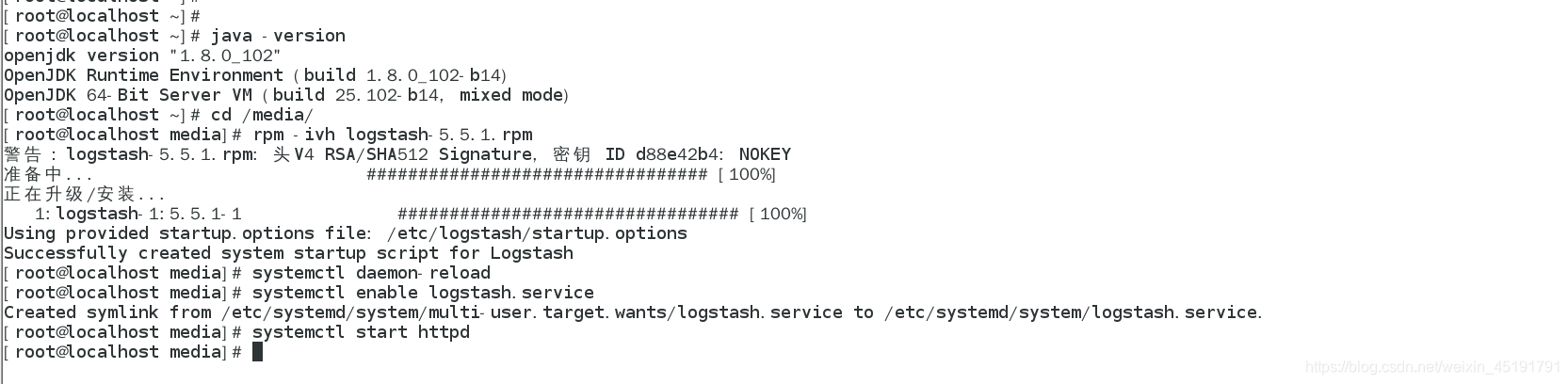

在apache上安装http、Logstash(需要java环境,安装之前检查当前机器java环境是否存在)

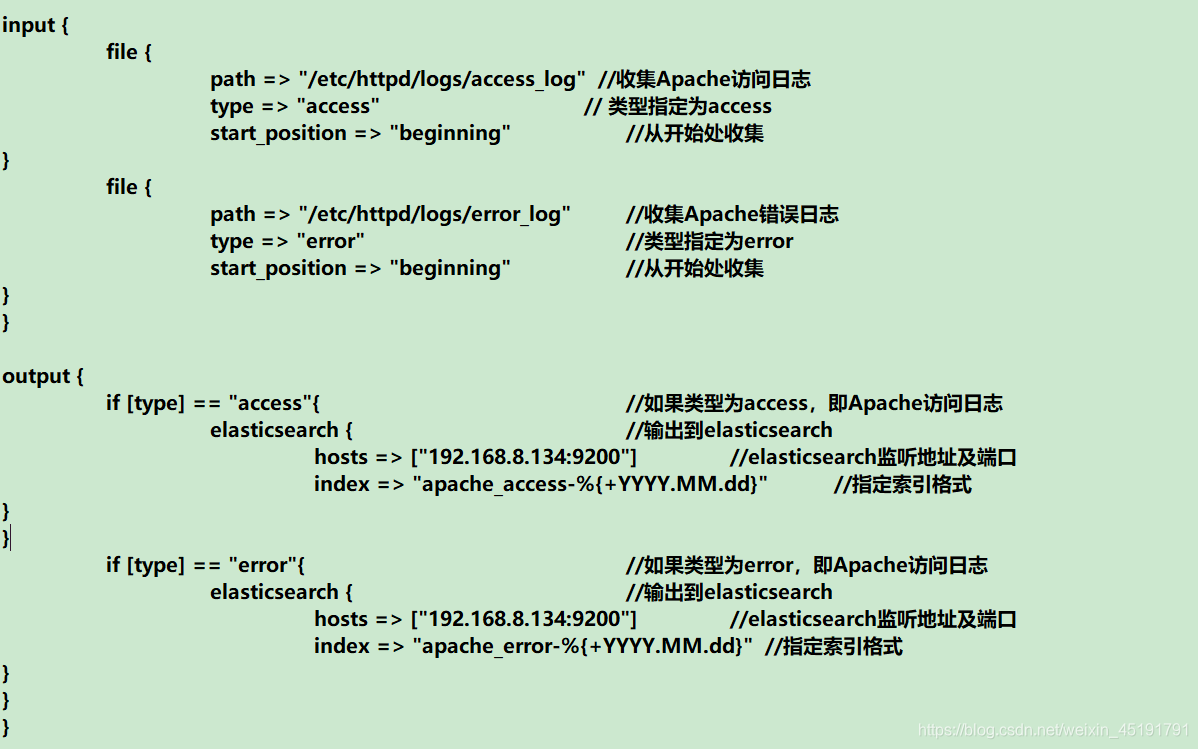

编写Logstash配置文件

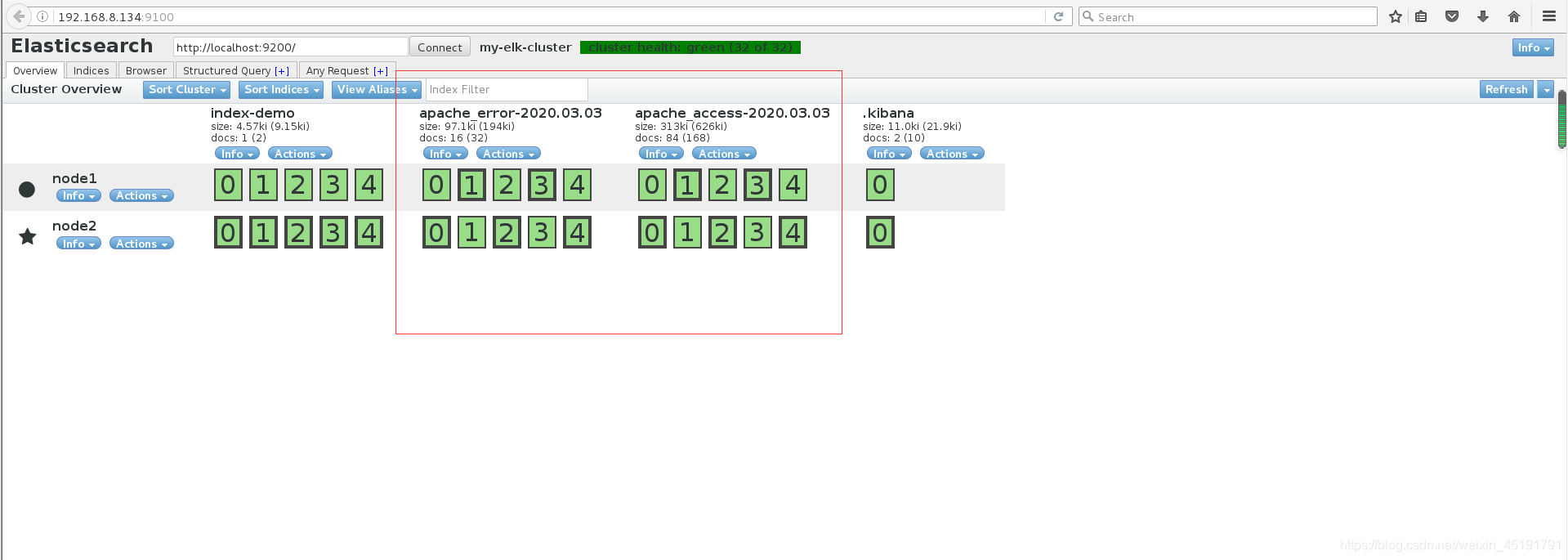

通过浏览器访问http://192.168.8.134:9100查看索引是否创建

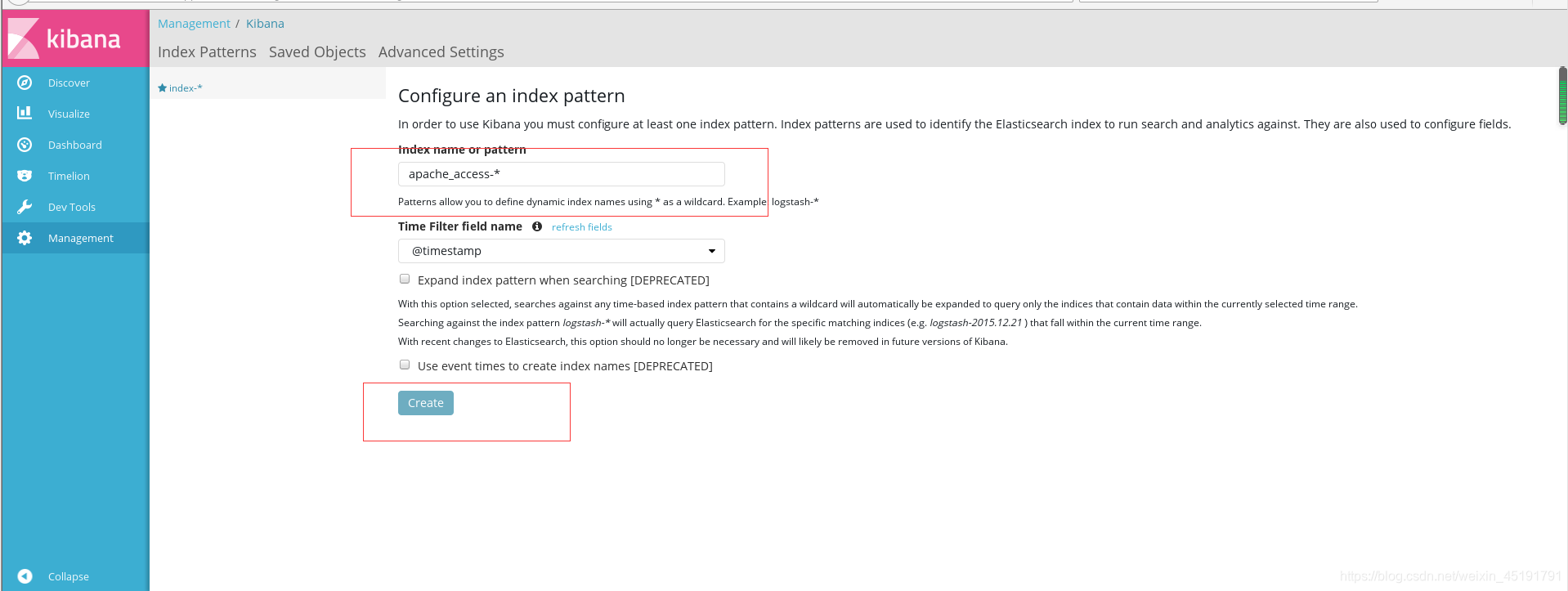

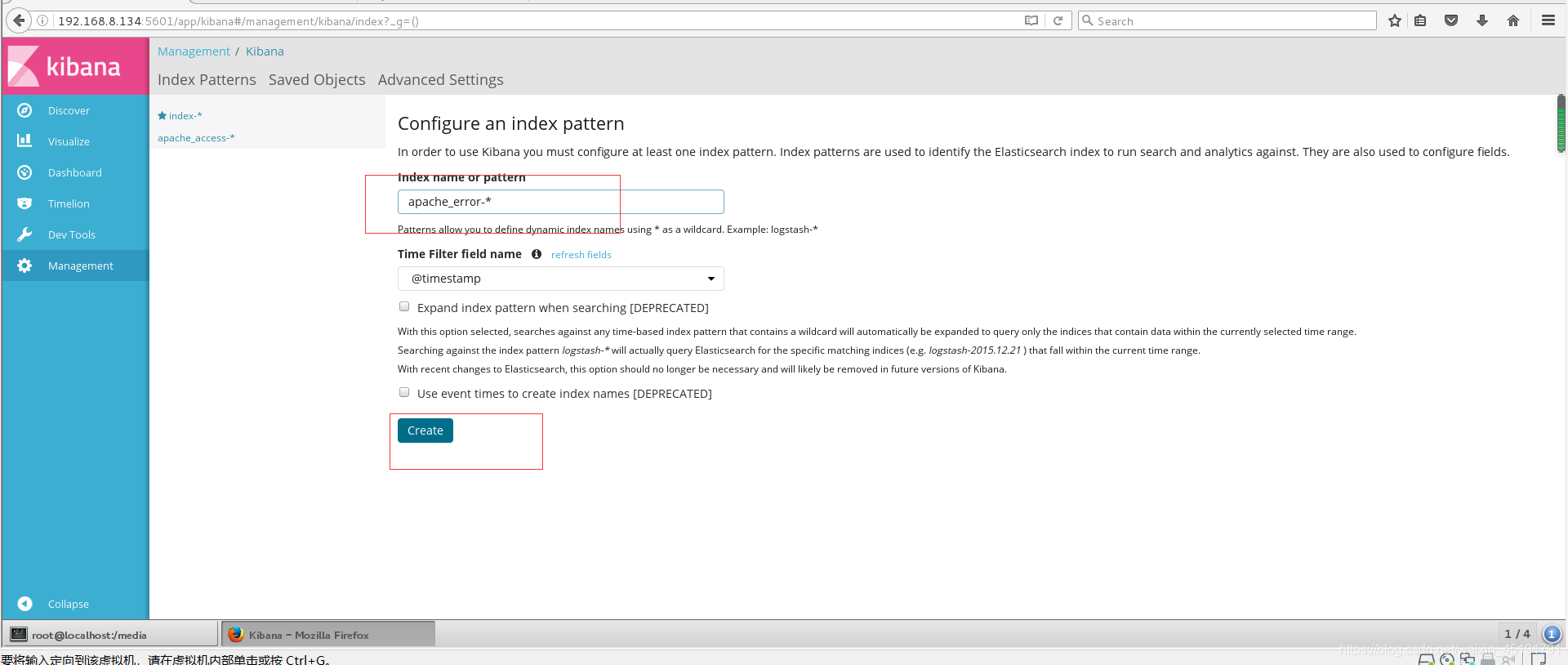

登录Kibana 单击“Create lndex Pattern”按钮添加索引

根据刚才在配置文件中创建的索引名来配置

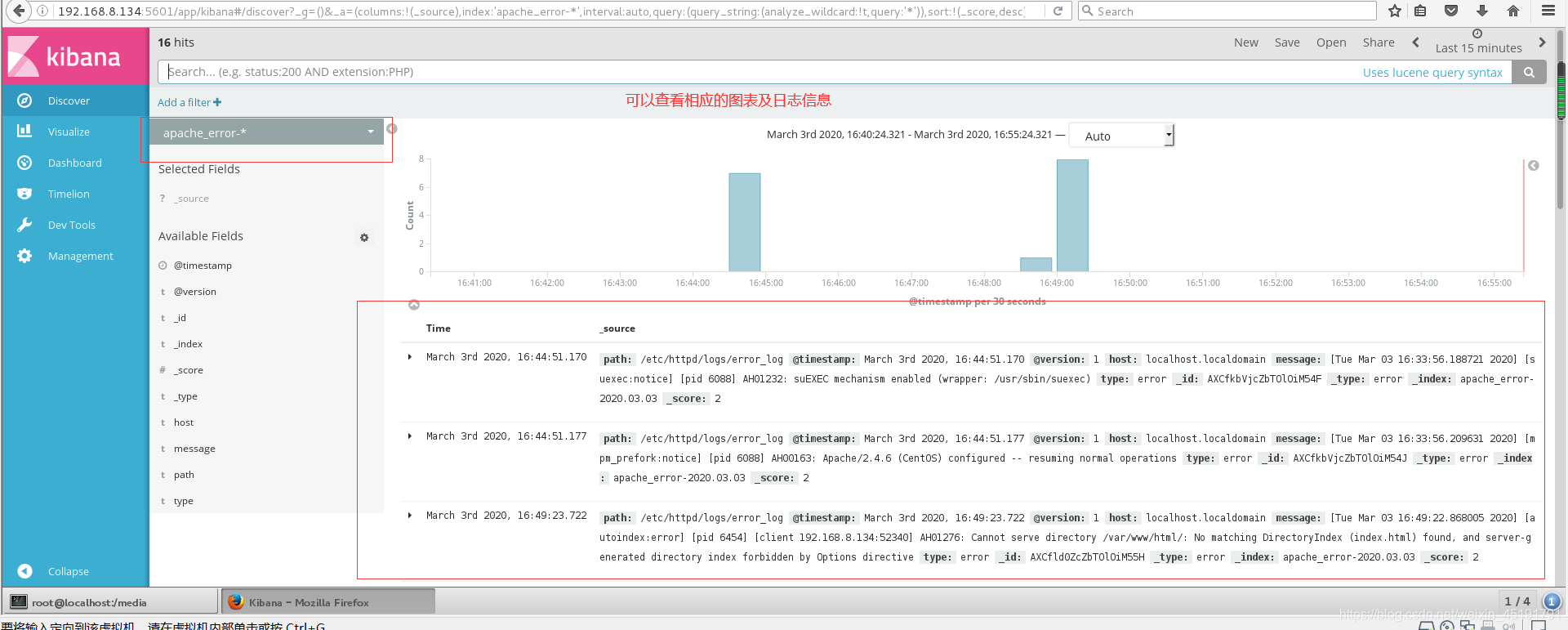

还可以根据Fields进行归类显示

点击Discover选项卡,在中间那一栏下拉列表中查看刚添加的俩个索引