knowledge distillation?

what is knowledge distillation?

how to knowledge distillation?

教师网络如何蒸馏到学生网络?

通过复用教师网络权重

或者度量最终输出/隐含特征之间的差异作为辅助损失实现

KD的提出

知识蒸馏从学生网络出发就是对教师网络的模仿

模仿标签

单纯的模仿

有思考的模仿

考虑软标签损失和硬标签损失

what is soft label(soft target) and hard label(hard target)?

hard target : 比如说 one-hot形式的分类输出(0,1,0,0)

soft target : 比如说加了temperature的softmax的分类输出

(0.1,0.8,0.1,0),考虑到了类间信息

temperature?dark knowledge?

temperature对于分类而言就是考虑到类间信息,总的来说加入T就是为了蒸馏教师网络的暗知识

添加了学生网络预测结果和软标签前身(未经历softmax)预测结果的差异损失

模仿隐含特征(Hint training)

模仿中间结果

在之前的基础上加了Hint training,这样就可以不针对分类问题了,也可以针对回归问题了。

模仿注意力

激活注意力图

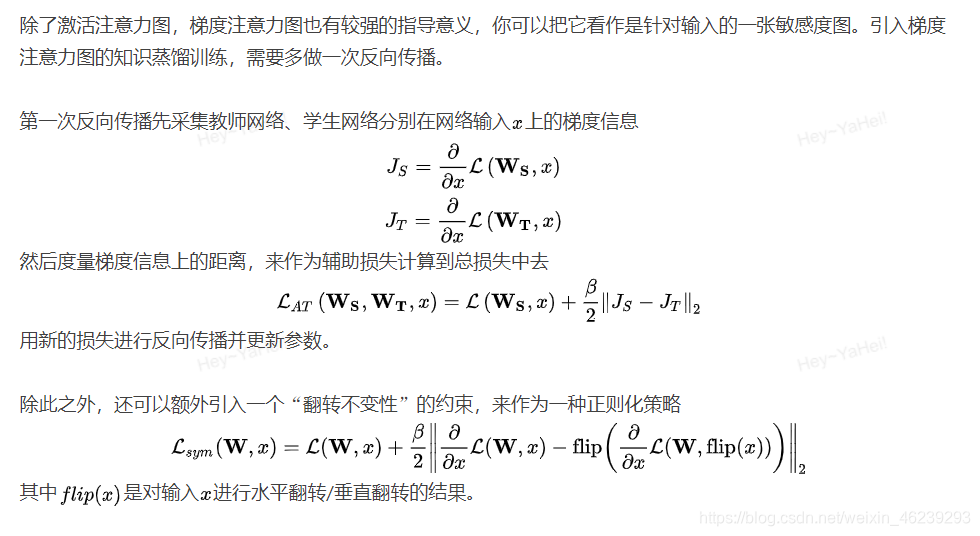

梯度注意力图

模仿思路

模仿决策边界

后续我的工作应该为加入Hint training的模仿中间结果和模仿标签两种

目前无源码

摘选部分需要的,可查看原文:知识蒸馏