欢迎关注【AI技术开发者】

上文中,我们成功搭建了FastGPT服务和New-api服务

我们现在需要配置New-api服务,使用New-api来同时使用多个厂商的大模型服务,如豆包、通义千问、混元、文心一言、Kimi等模型

首先,我们需要修改FastGPT容器的环境变量

OPENAI_BASE_URL = // New-api的服务地址,容器地址或外网地址都行

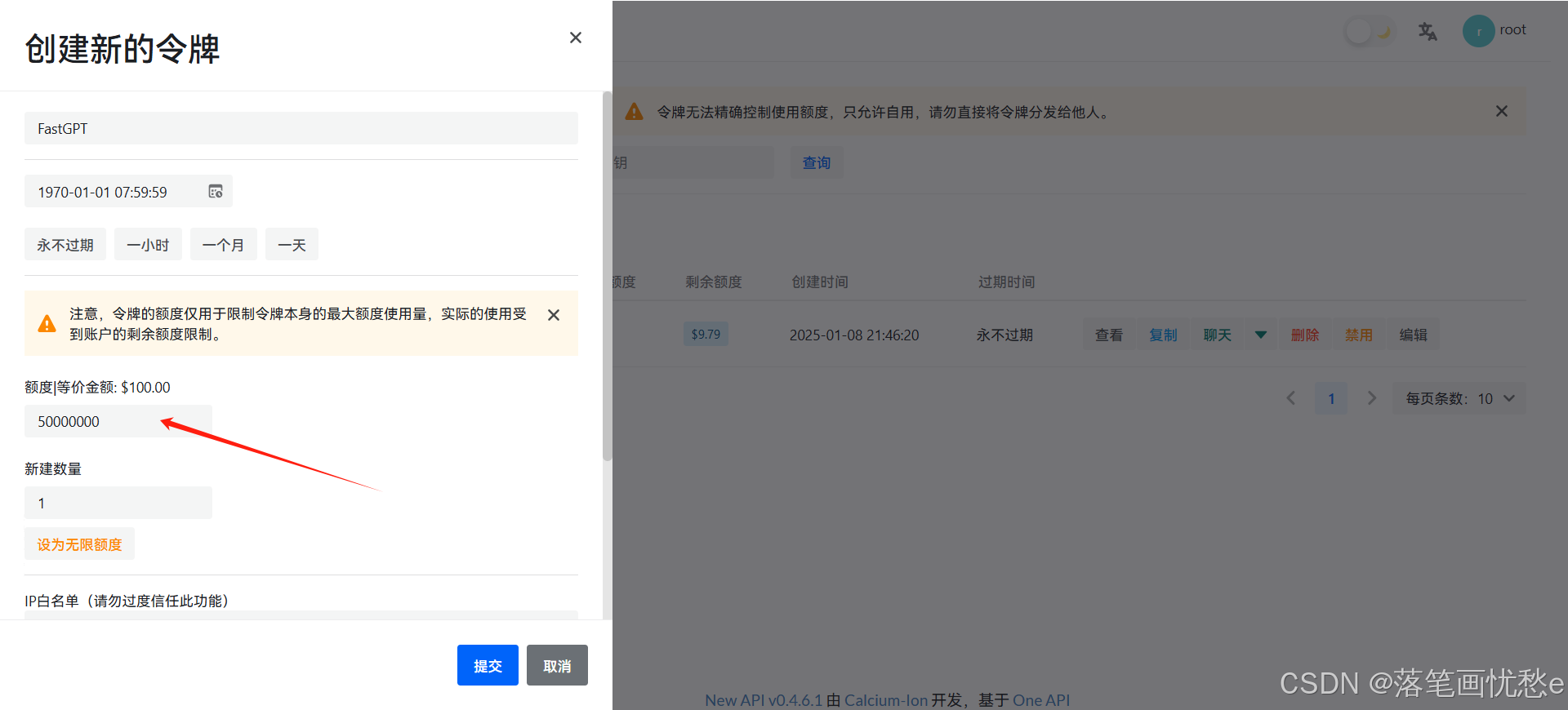

CHAT_API_KEY = // 访问Token

Token生成地址:

注意修改额度,以防不够用

然后修改FastGPT容器的config.json文件中的llmModels字段

这个是语言模型和视觉模型,按以下格式修改后放在这个文件里面

{

"provider": "OpenAI", // 模型提供商,主要用于分类展示,目前已经内置提供商包括:https://github.com/labring/FastGPT/blob/main/packages/global/core/ai/provider.ts, 可 pr 提供新的提供商,或直接填写 Other

"model": "gpt-4o-mini", // 模型名(对应OneAPI中渠道的模型名)

"name": "gpt-4o-mini", // 模型别名

"maxContext": 125000, // 最大上下文

"maxResponse": 16000, // 最大回复

"quoteMaxToken": 120000, // 最大引用内容

"maxTemperature": 1.2, // 最大温度

"charsPointsPrice": 0, // n积分/1k token(商业版)

"censor": false, // 是否开启敏感校验(商业版)

"vision": true, // 是否支持图片输入

"datasetProcess": true, // 是否设置为文本理解模型(QA),务必保证至少有一个为true,否则知识库会报错

"usedInClassify": true, // 是否用于问题分类(务必保证至少有一个为true)

"usedInExtractFields": true, // 是否用于内容提取(务必保证至少有一个为true)

"usedInToolCall": true, // 是否用于工具调用(务必保证至少有一个为true)

"usedInQueryExtension": true, // 是否用于问题优化(务必保证至少有一个为true)

"toolChoice": true, // 是否支持工具选择(分类,内容提取,工具调用会用到。)

"functionCall": false, // 是否支持函数调用(分类,内容提取,工具调用会用到。会优先使用 toolChoice,如果为false,则使用 functionCall,如果仍为 false,则使用提示词模式)

"customCQPrompt": "", // 自定义文本分类提示词(不支持工具和函数调用的模型

"customExtractPrompt": "", // 自定义内容提取提示词

"defaultSystemChatPrompt": "", // 对话默认携带的系统提示词

"defaultConfig": {}, // 请求API时,挟带一些默认配置(比如 GLM4 的 top_p)

"fieldMap": {} // 字段映射(o1 模型需要把 max_tokens 映射为 max_completion_tokens)

},

model为New-api中的模型名称

name为自定义名称,自己认识就行

vision注意语言模型不支持图片输入

下面修改vectorModels字段,部署向量模型(解析知识库需要用到)

按以下格式:

{

"provider": "通义千问",

"model": "qwen-multimodal-embedding-v1", // 模型名(与OneAPI对应)

"name": "通义千问-多模态向量", // 模型展示名

"charsPointsPrice": 0, // n积分/1k token

"defaultToken": 700, // 默认文本分割时候的 token

"maxToken": 3000, // 最大 token

"weight": 100, // 优先训练权重

"defaultConfig": {}, // 自定义额外参数。例如,如果希望使用 embedding3-large 的话,可以传入 dimensions:1024,来返回1024维度的向量。(目前必须小于1536维度)

"dbConfig": {}, // 存储时的额外参数(非对称向量模型时候需要用到)

"queryConfig": {} // 参训时的额外参数

}

下面部署重排模型,对知识库搜索结果进行排序,这个用处不大

修改reRankModels字段,按以下格式:

{

"model": "qwen-gte-rerank", // 模型名称

"name": "通义千问-重排", // 随意

"charsPointsPrice": 0,

"requestUrl": "new-api/v1/rerank",

"requestAuth": "安全凭证,已自动补 Bearer"

}

全部修改完毕后,重启容器

进入web页面,看到

即为接入成功

现在 我们创建一个应用 测试一下模型是否可用

欢迎关注【AI技术开发者】