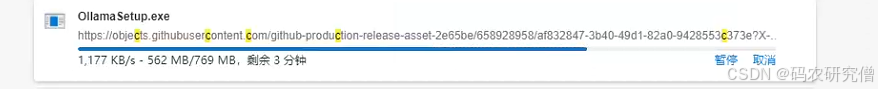

1. ollama下载

安装包下载:Window安装包

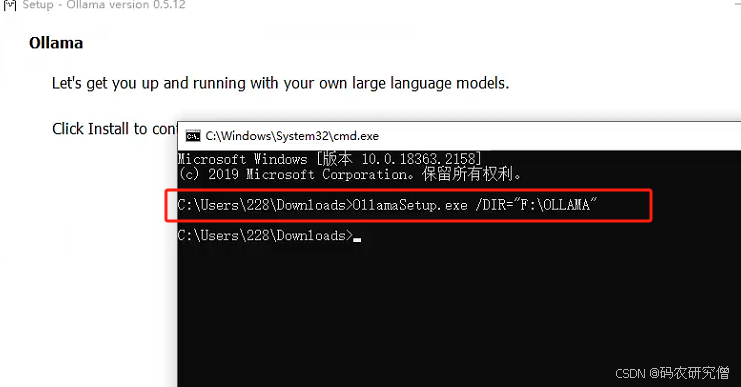

命令行方式安装:(不推荐使用exe方式进行安装,默认会在C盘路径下)

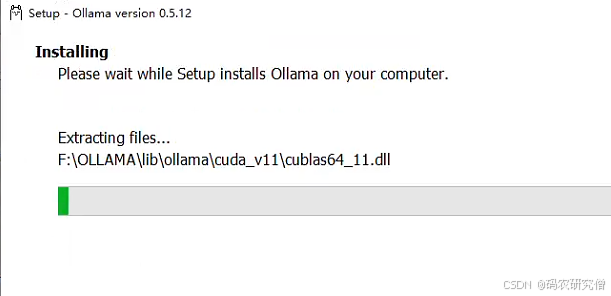

点击install之后:

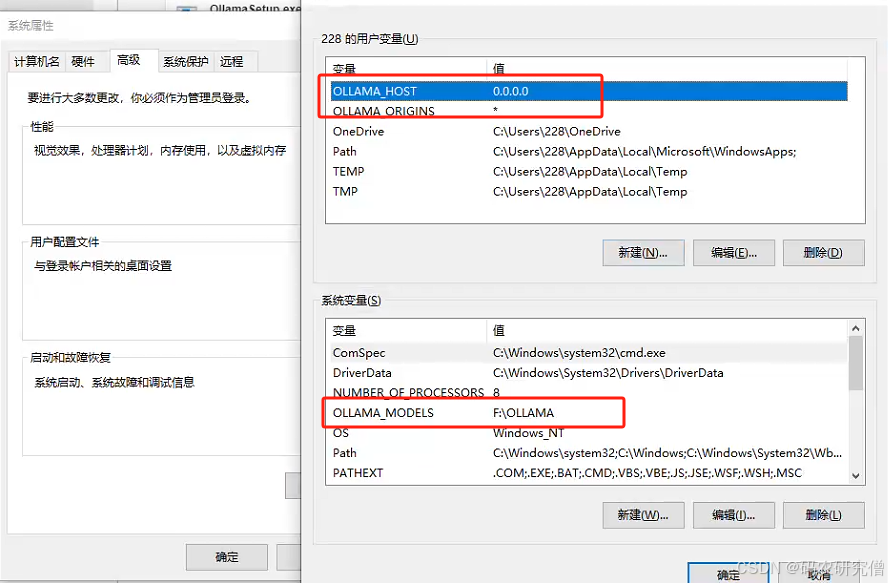

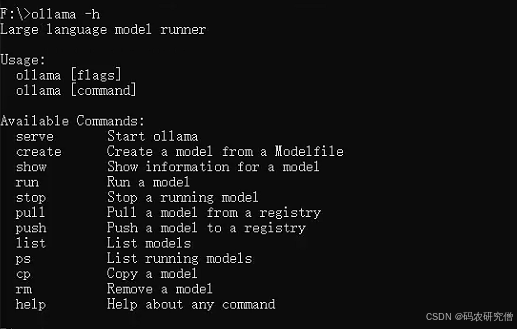

2. 环境变量

先配置环境变量,具体安装路径是系统变量:F:\OLLAMA

- OLLAMA_MODELS:下载位置

用户环境变量里,新增两个环境变量(下面两个是远程调用,如果不要远程,可以不配置):如何将 Chatbox 连接到远程 Ollama 服务:逐步指南

(下面这个变量建议ds模型下载之后再配置,否则需要重启,远程客户端才会生效!)

-

OLLAMA_HOST:0.0.0.0

-

OLLAMA_ORIGINS:*

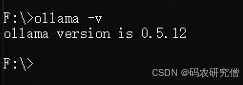

验证是否成功安装:ollama -v

查看命令的其他参数:ollama -h

后续转移模型的具体位置:(找个具体位置新建models目录)

变量名:OLLAMA_MODELS

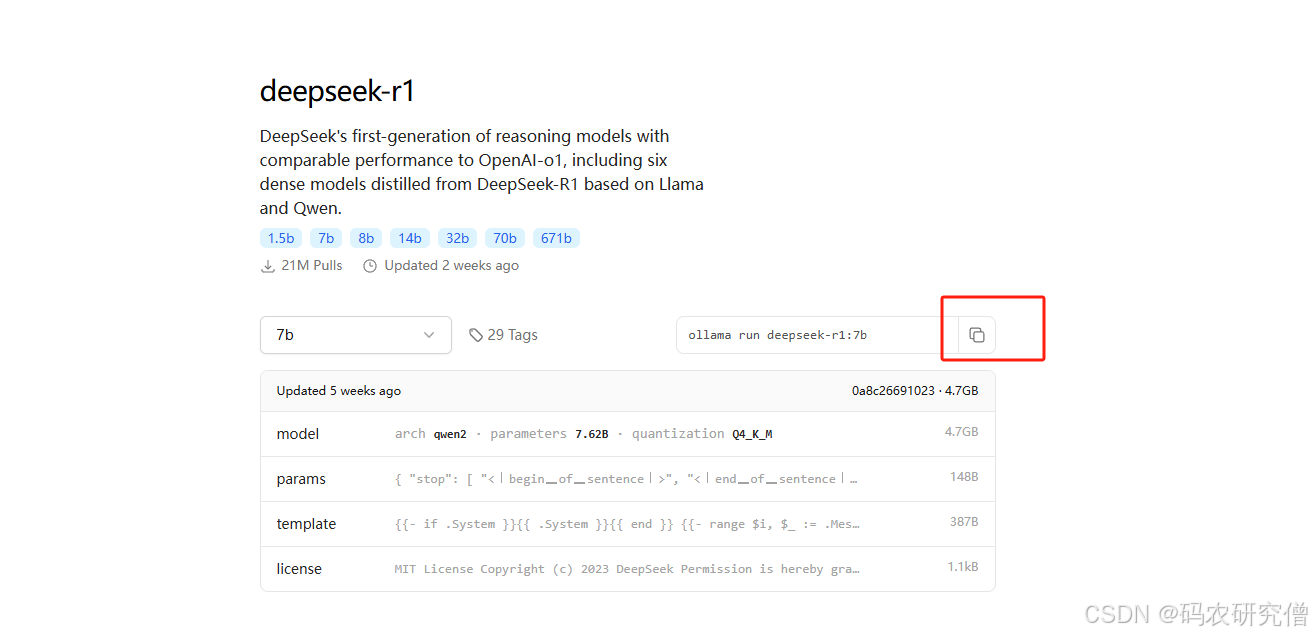

3. deepseek下载

大模型下载:添加链接描述

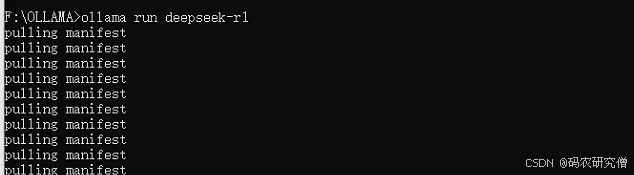

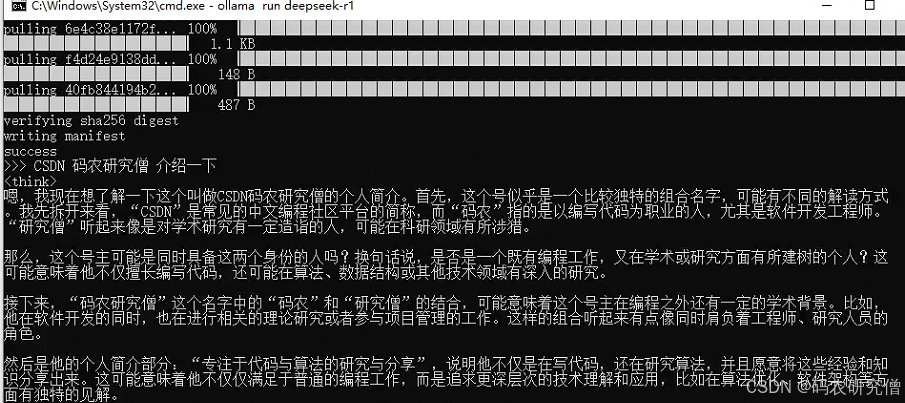

下载之后:ollama run deepseek-r1:7b

等待半个多小时,最后成功安装:

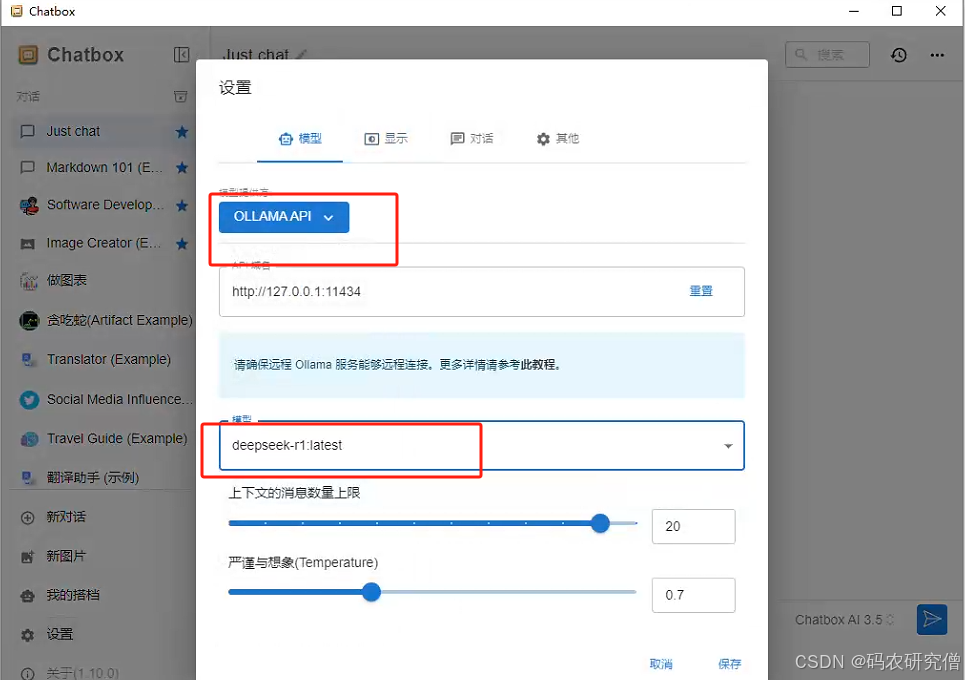

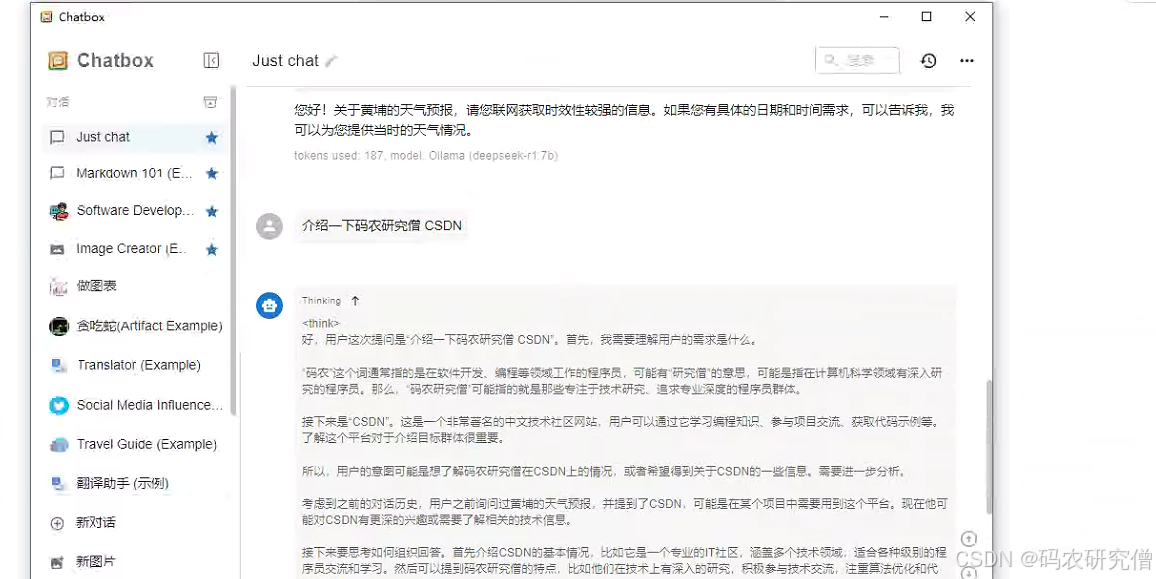

除了cmd还可使用网页版:https://web.chatboxai.app/

4. 彩蛋

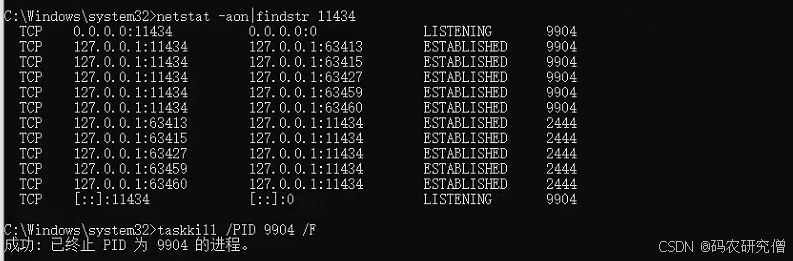

如果执行http://localhost:11434/,显示ollama is runnig,说明在启动中

但是ollama list确没有看到模型,可以看看是否有端口被占用了!

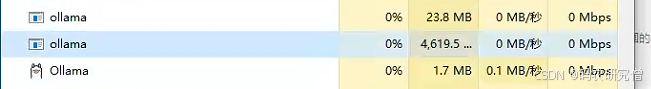

如果结束不掉,可以用任务管理器

后续如果要启动,可以通过 ollama run deepseek-r1:7b

之后可以在模型中看到 ollama ps

如果远程使用的,最好下载一个软件,网页版的衔接不上!找不到模型

另外一种结束的方式:

netstat -aon|findstr 11434