在人工智能和大模型技术飞速发展的今天,越来越多的开发者和研究者希望能够亲自体验和微调大模型,以便更好地理解和应用这些先进的技术。然而,高昂的GPU算力成本往往成为了阻碍大家探索的瓶颈。幸运的是,腾讯云Cloud Studio提供了免费的GPU算力资源,结合深度求索(DeepSeek)推出的DeepSeek-R1大模型,我们可以轻松地在云端部署和运行这些强大的模型,而无需花费一分钱。

Cloud Studio_在线编程_在线IDE_WebIDE_CloudIDE_腾讯云

本文将详细介绍如何利用腾讯云Cloud Studio的免费GPU资源,部署DeepSeek-R1大模型,并与之进行交互。我们将从Cloud Studio的使用开始,逐步介绍Ollama的安装与配置,最后展示如何部署DeepSeek-R1并与它进行对话。

1. Cloud Studio

1.1 Cloud Studio简介

腾讯云Cloud Studio是一个基于云的集成开发环境(IDE),它提供了丰富的开发工具和资源,帮助开发者更高效地进行代码编写、调试和部署。最近,Cloud Studio推出了免费的GPU算力资源,用户每个月可以免费使用10000分钟的GPU服务器,配置为16G显存、32G内存和8核CPU。这对于需要高性能计算资源的开发者来说,无疑是一个巨大的福音。(用完后记得点关闭机器,下次微调再开启就可以了,环境自动保存,每个月10000分钟根本用不完)

1.2 注册与登录

要使用Cloud Studio,首先需要注册一个腾讯云账号。注册完成后,登录Cloud Studio,你会看到一个简洁的用户界面,提供了多种开发模板供选择。这些模板涵盖了从基础的Python开发到复杂的大模型部署等多种场景。

1.3 选择Ollama模板

由于我们的目标是部署DeepSeek-R1大模型,因此我们可以直接选择Ollama模板。Ollama是一个用于管理和运行大模型的工具,它简化了模型的下载、安装和运行过程。选择Ollama模板后,Cloud Studio会自动为我们配置好Ollama环境,省去了手动安装的麻烦。

2. Ollama

2.1 Ollama简介

Ollama是一个开源的工具,专门用于管理和运行各种大模型。它支持多种模型格式,并且可以自动处理模型的依赖关系,使得模型的部署和运行变得非常简单。Ollama的官方网站提供了丰富的模型资源,用户可以根据自己的需求选择合适的模型进行下载和运行。

2.2 模型参数与选择

在Ollama的官网上,官网地址[1],每个模型的下方都会标注模型的参数量,例如7B、13B、70B等。这里的“B”代表Billion(十亿),表示模型的参数量。参数量越大,模型的复杂度和能力通常也越强,但同时也会消耗更多的计算资源。

对于腾讯云Cloud Studio提供的免费GPU资源(16G显存、32G内存、8核CPU),我们可以选择8B或13B的模型进行部署。如果你有更高的硬件配置,也可以尝试更大参数的模型,以获得更好的效果。

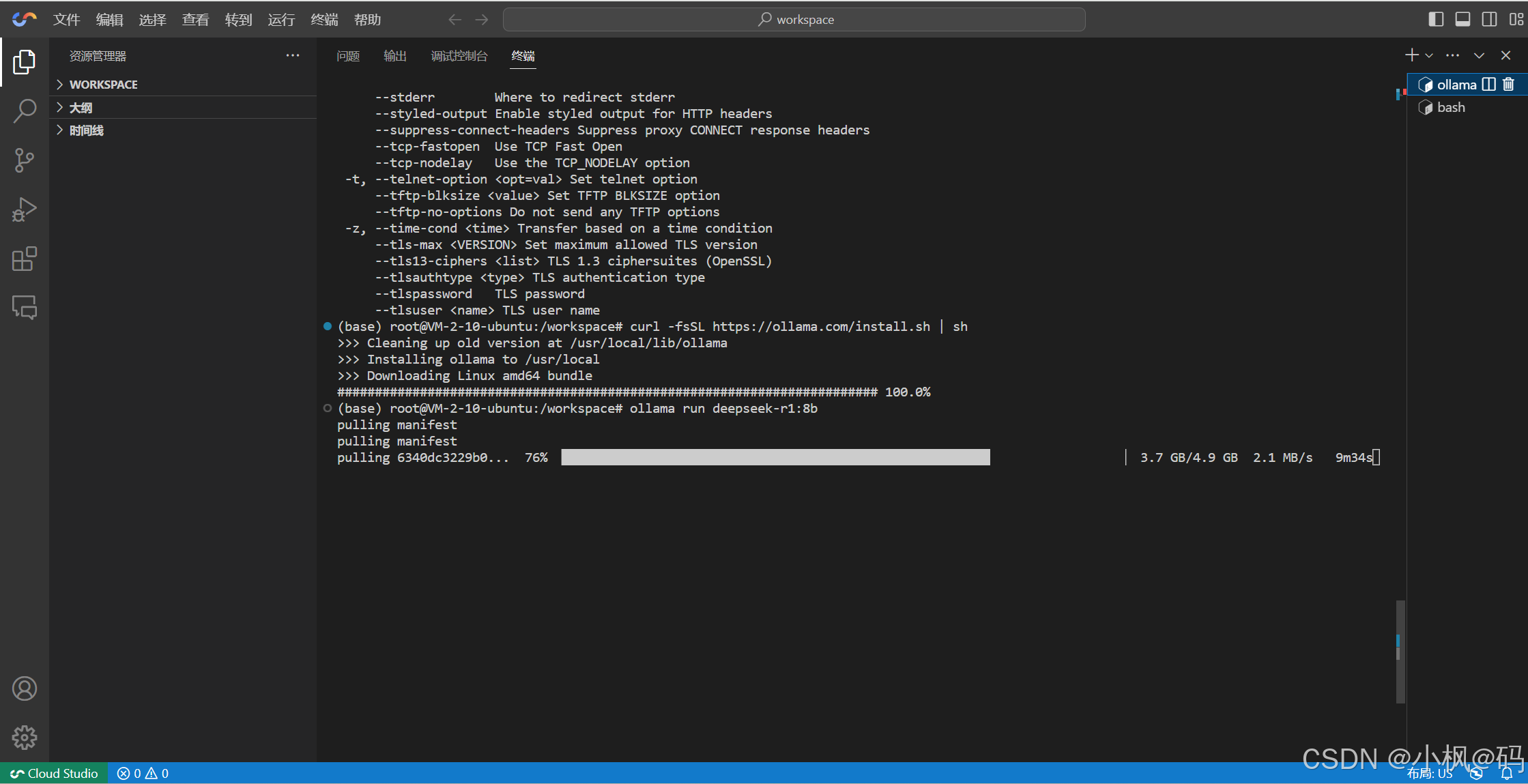

2.3 安装Ollama

在Cloud Studio中选择Ollama模板后,系统会自动为我们安装Ollama。如果你在其他环境中使用Ollama,可以通过以下命令进行安装:

curl -fsSL https://ollama.com/install.sh | sh安装完成后,你可以通过以下命令验证Ollama是否安装成功:

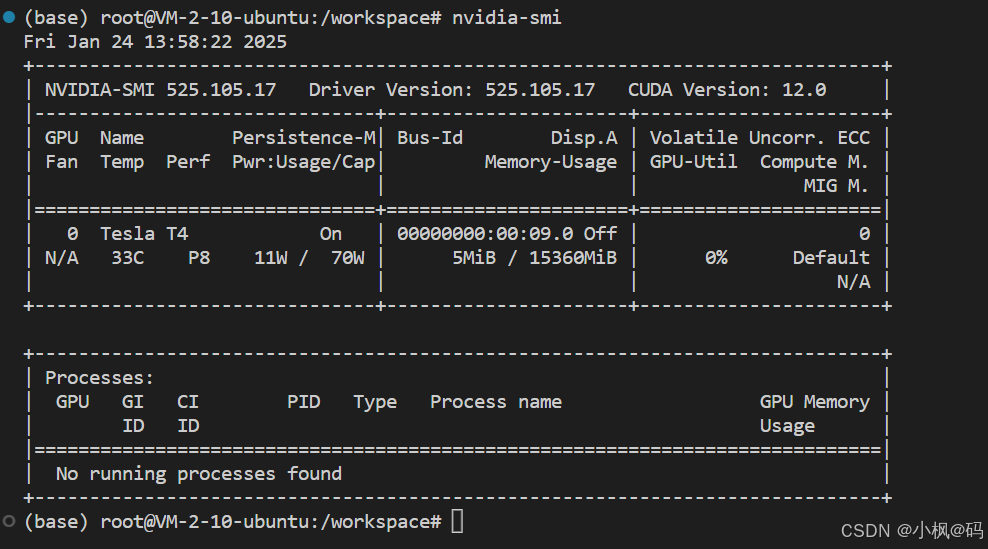

ollama --version查看gpu配置:

接下来就是ollama部署DeepSeek-R1,

3. DeepSeek-R1免费部署

3.1 DeepSeek-R1简介

DeepSeek-R1是深度求索(DeepSeek)推出的一款高性能大模型,它在多项自然语言处理任务中表现出色,尤其是在文本生成、对话系统和知识问答等领域。DeepSeek-R1的参数量从8B到70B不等,用户可以根据自己的硬件配置选择合适的模型进行部署。

3.2 下载与部署

Ollama中部署DeepSeek-R1非常简单。我们只需要运行以下命令即可:

ollama run deepseek-r1:8b有哪些模型,直接访问 ollama的官网即可。https://ollama.com/search?q=lam

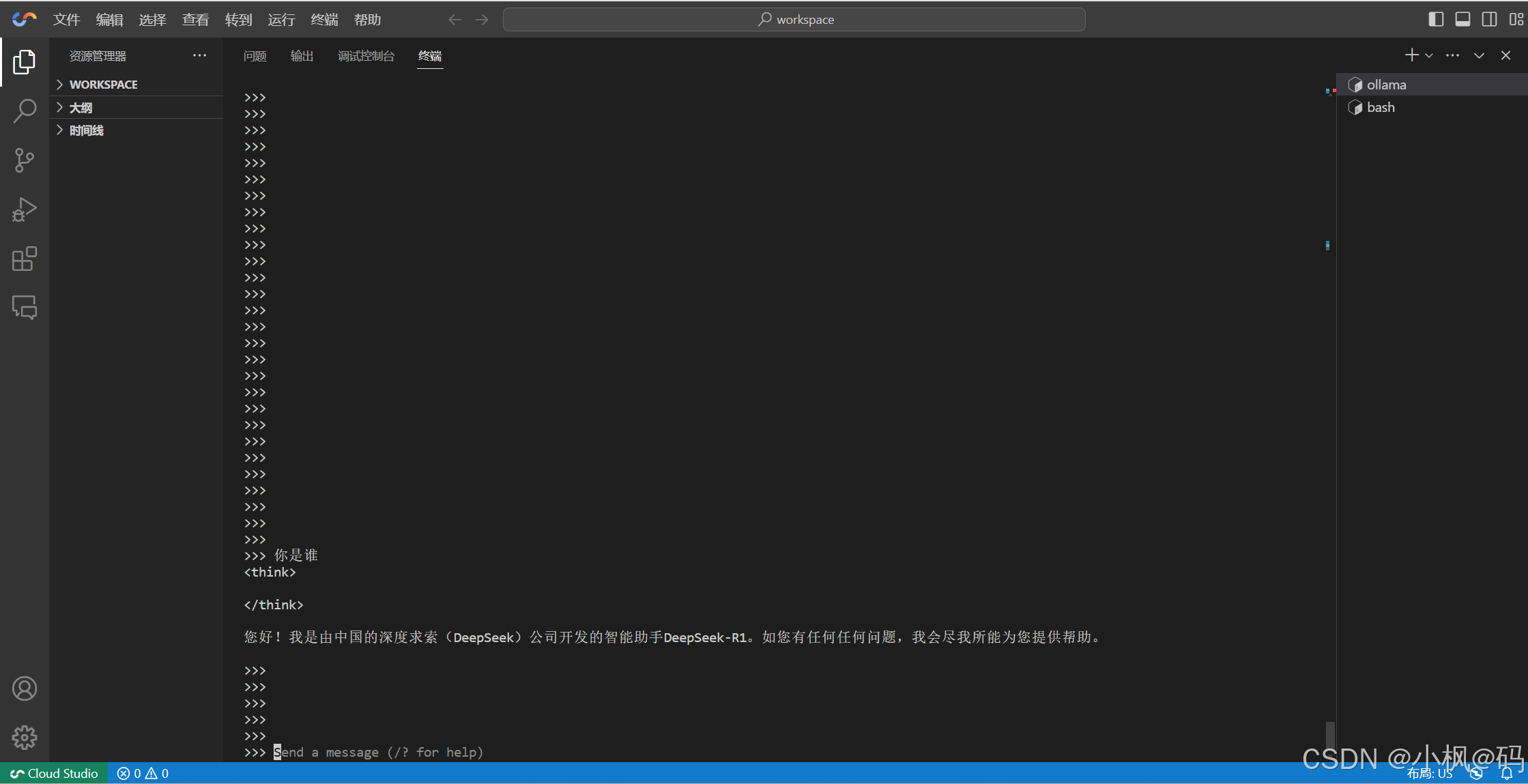

3.3 模型运行

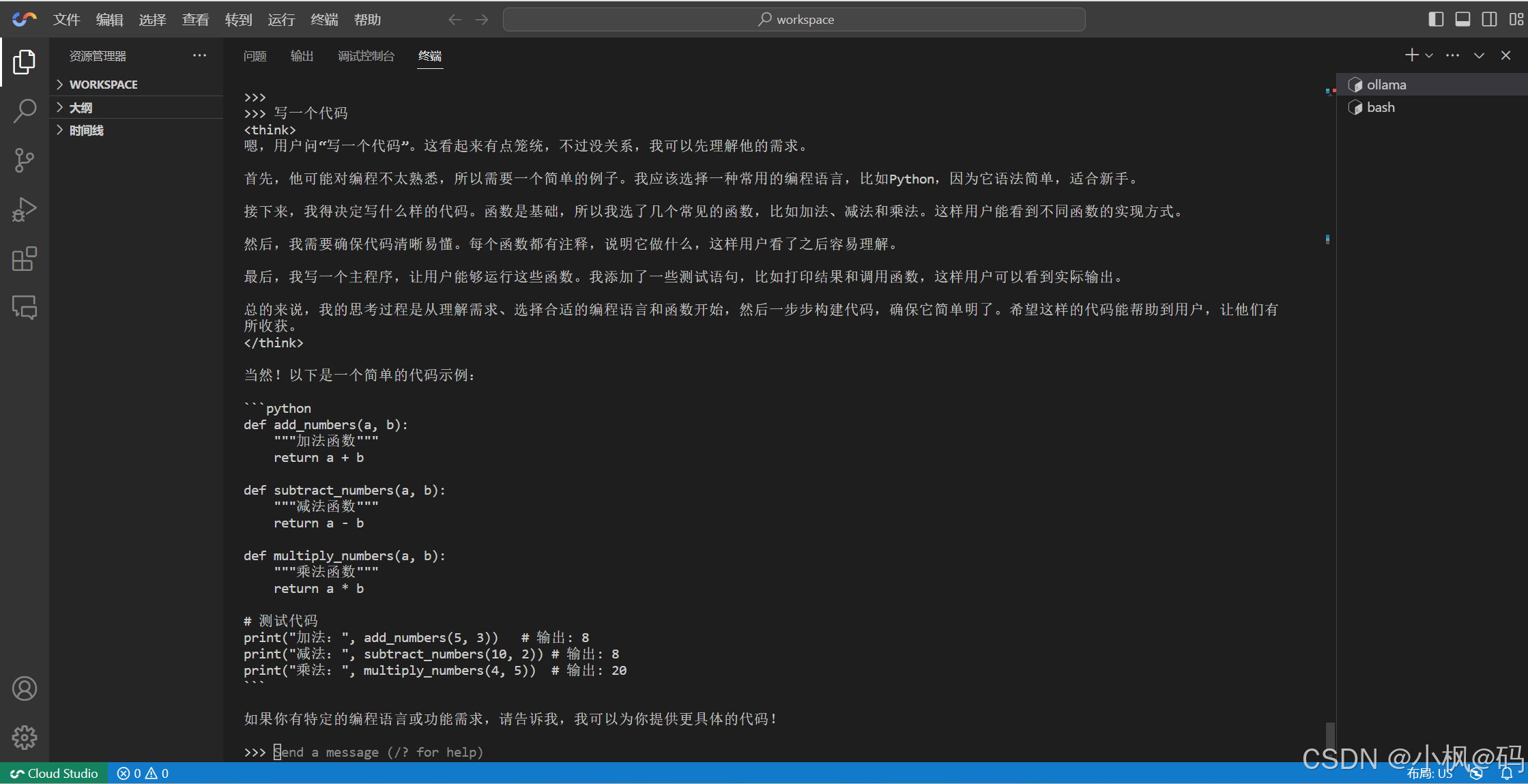

模型下载完成后,Ollama会自动启动DeepSeek-R1,并进入交互模式。此时,你可以直接在终端中输入问题或指令,与DeepSeek-R1进行对话。

4. 开始和DeepSeek-R1聊天

4.1 基本对话

与DeepSeek-R1的对话非常简单,你只需要在终端中输入你的问题或指令,模型会立即生成回复。

4.2 复杂任务

-

比如用DeepSeek-R1生成代码

-

4.3 模型微调

如果你对DeepSeek-R1的表现不满意,或者希望模型在某些特定任务上表现更好,你可以尝试对模型进行微调。微调的过程通常需要准备一些特定领域的数据集,并使用这些数据集对模型进行再训练。Ollama提供了简单的接口,帮助用户进行模型微调。

5. 总结

通过腾讯云Cloud Studio的免费GPU资源,结合Ollama和DeepSeek-R1,我们可以轻松地在云端部署和运行大模型,而无需担心高昂的硬件成本。无论是进行简单的对话,还是处理复杂的任务,DeepSeek-R1都能提供强大的支持。希望本文能够帮助你顺利部署DeepSeek-R1,并开启你的大模型探索之旅。

但是Ollama是一个推理框架,但是只针对个人,不针对企业。

1、Ollama上面所支持的所有大模型框架,都是经过量化处理的。可以说,Ollama上面加载的所有大模型都是阉割版本,精度没有标准版本那么高的。

2、Ollama目前对于分布式推理是比较弱的。

3、针对于企业的推理平台通常采用 VLLM。