强化学习

强化学习:概述

强化学习 (RL) 是机器学习的一个分支,专注于在特定情况下做出决策以最大化累积奖励。与依赖具有预定义答案的训练数据集的监督学习不同,强化学习涉及通过经验进行学习。在强化学习中,代理通过执行操作并通过奖励或惩罚获得反馈来学习在不确定、可能复杂的环境中实现目标。

强化学习的关键概念

- Agent 代理:学习者或决策者。

- Environment 环境:代理与之交互的一切。

- State 状态:代理所处的特定情况。

- Action 动作:代理可以采取的所有可能的行动。

- Reward 奖励:根据所采取的行动而从环境获得的反馈。

强化学习的工作原理

RL 的工作原理是通过反复试验来学习最佳行为。代理在环境中采取行动,获得奖励或惩罚,并调整其行为以最大化累积奖励。此学习过程具有以下特点:

- Policy 策略:代理根据当前状态确定下一步动作所使用的策略。

- Reward Function 奖励函数:根据状态和动作提供标量反馈信号的函数。

- Value Function 价值函数:估计给定状态的预期累积奖励的函数。

- Model of the Environment 环境模型:环境的表示,通过预测未来状态和奖励来帮助规划。

示例:走迷宫

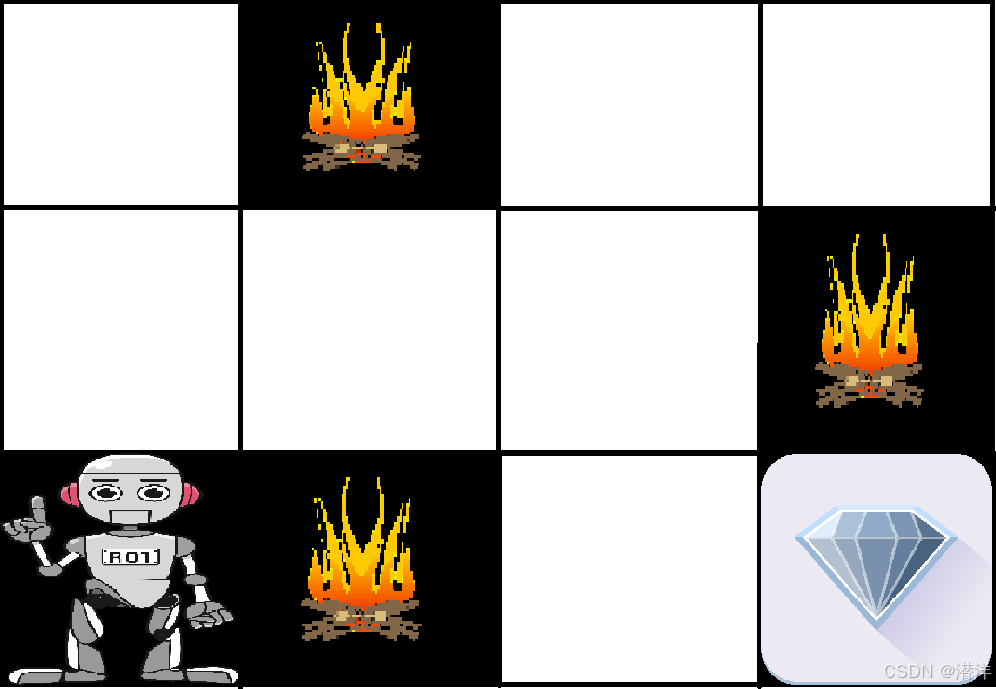

问题如下:我们有一个代理和一个奖励,中间有很多障碍。代理应该找到获得奖励的最佳路径。下面的问题更容易解释这个问题。

上图显示了机器人、钻石和火焰。机器人的目标是获得钻石作为奖励,并避开被点燃的障碍。机器人通过尝试所有可能的路径来学习