目录

0 基础

在很多基础应用中背景检出都是一个非常重要的步骤。例如顾客统计,使用一个静态摄像头来记录进入和离开房间的人数,或者是交通摄像头,需要提 取交通工具的信息等。在所有的这些例子中,首先要将人或车单独提取出来。 技术上来说,我们需要从静止的背景中提取移动的前景。

如果你有一张背景(仅有背景不含前景)图像,比如没有顾客的房间,没有交通工具的道路等,那就好办了。我们只需要在新的图像中减去背景就可以 得到前景对象了。但是在大多数情况下,我们没有这样的(背景)图像,所以 我们需要从我们有的图像中提取背景。如果图像中的交通工具还有影子的话, 那这个工作就更难了,因为影子也在移动,仅仅使用减法会把影子也当成前景。 真是一件很复杂的事情。

为了实现这个目的科学家们已经提出了几种算法。OpenCV 中已经包含了 其中三种比较容易使用的方法。我们一个一个学习一下吧。

1 BackgroundSubtractorMOG

这是一个以混合高斯模型为基础的前景/背景分割算法。它是P.KadewTraKuPong和 R.Bowden 在 2001 年提出的。它使用 K(K=3 或 5)个高斯分布混合对 背景像素进行建模。使用这些颜色(在整个视频中)存在时间的长短作为混合 的权重。背景的颜色一般持续的时间最长,而且更加静止。一个像素怎么会有 分布呢?在 x,y 平面上一个像素就是一个像素没有分布,但是我们现在讲的 背景建模是基于时间序列的,因此每一个像素点所在的位置在整个时间序列中 就会有很多值,从而构成一个分布。

在编写代码时,我们需要使用函数: cv2. bgsegm. createBackgroundSubtractorMOG() 创建一个背景对象。 这个函数有些可选参数,比如要进行建模场景的时间长度, 高斯混合成分的数量,阈值等。将他们全部设置为默认值。

fgbg = cv2.bgsegm.createBackgroundSubtractorMOG(history, nmixtures, backgroundRatio, noiseSigma)

- history:时间长度,默认200

- nmixtures:高斯混合成分的数量,默认5

- backgroundRatio:背景比率,默认0.7

- noiseSigma:噪声强度(亮度或每个颜色通道的标准偏差)。默认 0表示一些自动值。

然后在整个视频中 我们是需要使用 backgroundsubtractor.apply() 就可以得到前景的掩模了

fgmask = fgbg.apply(frame)

下面是一个简单的例子:

import numpy as np

import cv2

cap = cv2.VideoCapture('video.mp4')

fgbg = cv2.bgsegm.createBackgroundSubtractorMOG()

while(1):

ret, frame = cap.read()

fgmask = fgbg.apply(frame)

cv2.imshow('frame', fgmask)

cv2.imshow('original', frame)

k = cv2.waitKey(30) & 0xff

if k == 27:

break

cap.release()

cv2.destroyAllWindows()

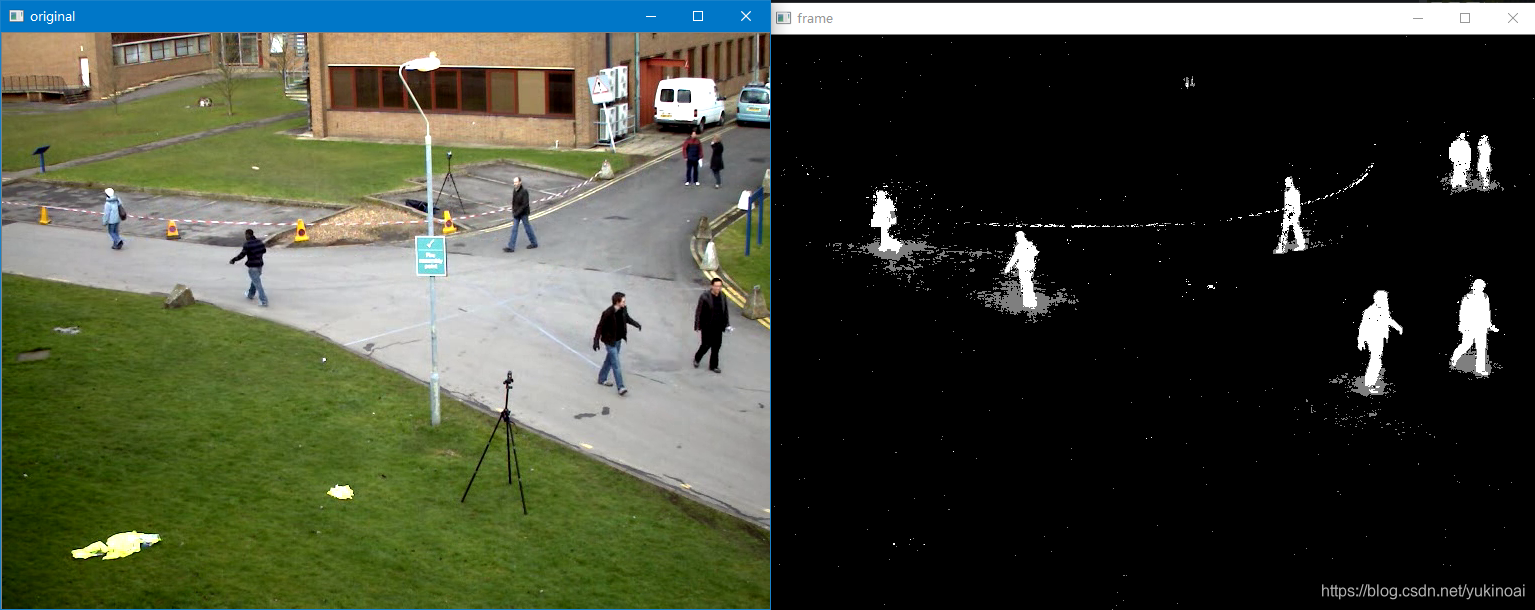

结果如下:

2 BackgroundSubtractorMOG2

这个也是以高斯混合模型为基础的背景/前景分割算法。它是以 2004 年和 2006 年 Z.Zivkovic 的两篇文章为基础的。这个算法的一个特点是它为每 一个像素选择一个合适数目的高斯分布。(上一个方法中我们使用是 K 高斯分布)。这样就会对由于亮度等发生变化引起的场景变化产生更好的适应。

和前面一样我们需要创建一个背景对象。但在这里我们我们可以选择是否检测阴影。如果 detectShadows = True(默认值),它就会检测并将影子标记 出来,但是这样做会降低处理速度。影子会被标记为灰色。

fgbg = cv2.createBackgroundSubtractorMOG2(history, varThreshold, detectShadows)

- history:时间长度,默认500

- varThreshold:像素和模型之间的平方Mahalanobis距离的阈值,以确定背景模型是否很好地描述了像素。此参数不会影响后台更新。默认16

- detectShadows:如果为true(默认),则算法将检测阴影并标记它们。它会略微降低速度,因此如果您不需要此功能,请将参数设置为false。

import numpy as np

import cv2

cap = cv2.VideoCapture('video.mp4')

fgbg = cv2.createBackgroundSubtractorMOG2()

while(1):

ret, frame = cap.read()

fgmask = fgbg.apply(frame)

cv2.imshow('frame', fgmask)

cv2.imshow('original', frame)

k = cv2.waitKey(30) & 0xff

if k == 27:

break

cap.release()

cv2.destroyAllWindows()

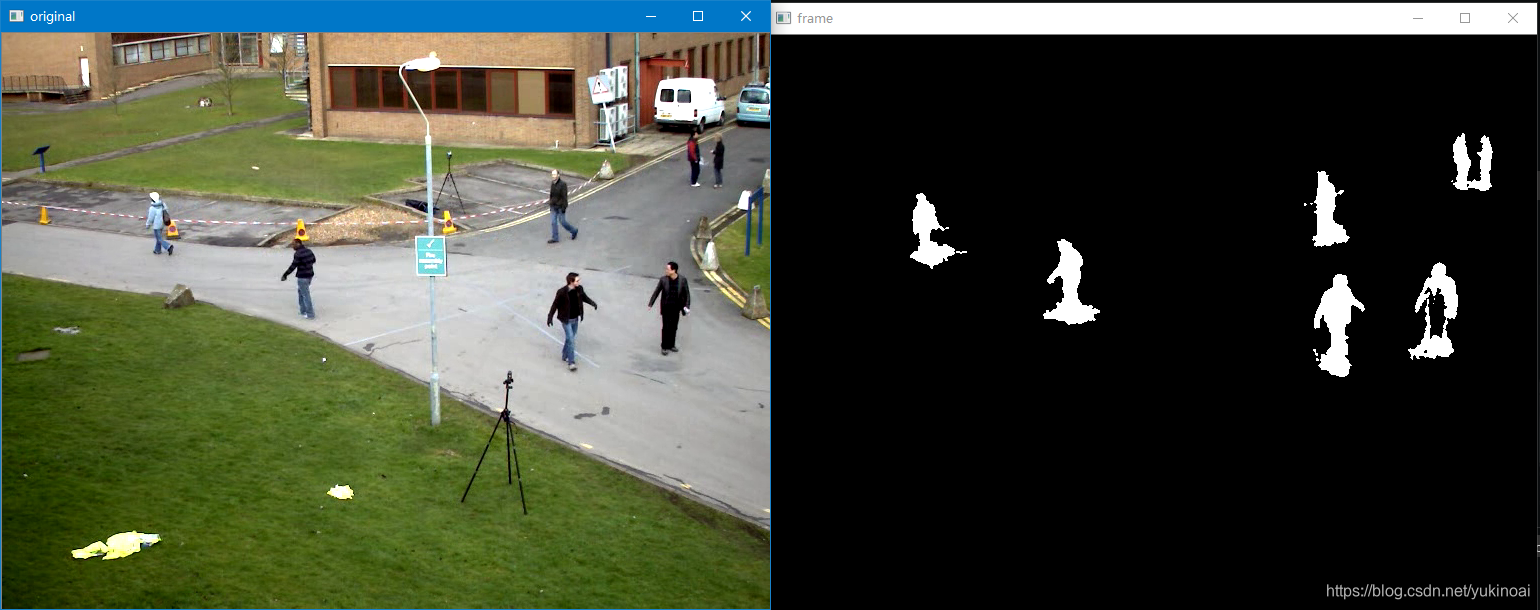

结果如下:

3 BackgroundSubtractorGMG

此算法结合了静态背景图像估计和每个像素的贝叶斯分割。这是 2012 年 Andrew_B.Godbehere,Akihiro_Matsukawa 和 Ken_Goldberg 在文章中提出的。

它使用前面很少的图像(默认为前 120 帧)进行背景建模。使用了概率前景估计算法(使用贝叶斯估计鉴定前景)。这是一种自适应的估计,新观察到的 对象比旧的对象具有更高的权重,从而对光照变化产生适应。一些形态学操作 如开运算闭运算等被用来除去不需要的噪音。在前几帧图像中你会得到一个黑色窗口。

fgbg = cv2.bgsegm.createBackgroundSubtractorGMG(initializationFrames,decisionThreshold)

- initializationFrames:于初始化背景模型的帧数,默认120

- decisionThreshold:阈值,超过该阈值,标记为前景,否则为背景,默认0.8

对结果进行形态学开运算对与去除噪声很有帮助。

import numpy as np

import cv2

cap = cv2.VideoCapture('video.mp4')

kernel = cv2.getStructuringElement(cv2.MORPH_ELLIPSE, (3, 3))

fgbg = cv2.bgsegm.createBackgroundSubtractorGMG()

while(1):

ret, frame = cap.read()

fgmask = fgbg.apply(frame)

fgmask = cv2.morphologyEx(fgmask, cv2.MORPH_OPEN, kernel)

cv2.imshow('frame', fgmask)

cv2.imshow('original', frame)

k = cv2.waitKey(30) & 0xff

if k == 27:

break

cap.release()

cv2.destroyAllWindows()

结果如下:

此外还有

BackgroundSubtractorGSOC算法:

import numpy as np

import cv2

cap = cv2.VideoCapture('video.mp4')

fgbg = cv2.bgsegm.createBackgroundSubtractorGSOC()

while(1):

ret, frame = cap.read()

fgmask = fgbg.apply(frame)

cv2.imshow('frame', fgmask)

cv2.imshow('original', frame)

k = cv2.waitKey(30) & 0xff

if k == 27:

break

cap.release()

cv2.destroyAllWindows()

BackgroundSubtractorLSBP算法

import numpy as np

import cv2

cap = cv2.VideoCapture('video.mp4')

fgbg = cv2.bgsegm.createBackgroundSubtractorLSBP()

while(1):

ret, frame = cap.read()

fgmask = fgbg.apply(frame)

cv2.imshow('frame', fgmask)

cv2.imshow('original', frame)

k = cv2.waitKey(30) & 0xff

if k == 27:

break

cap.release()

cv2.destroyAllWindows()