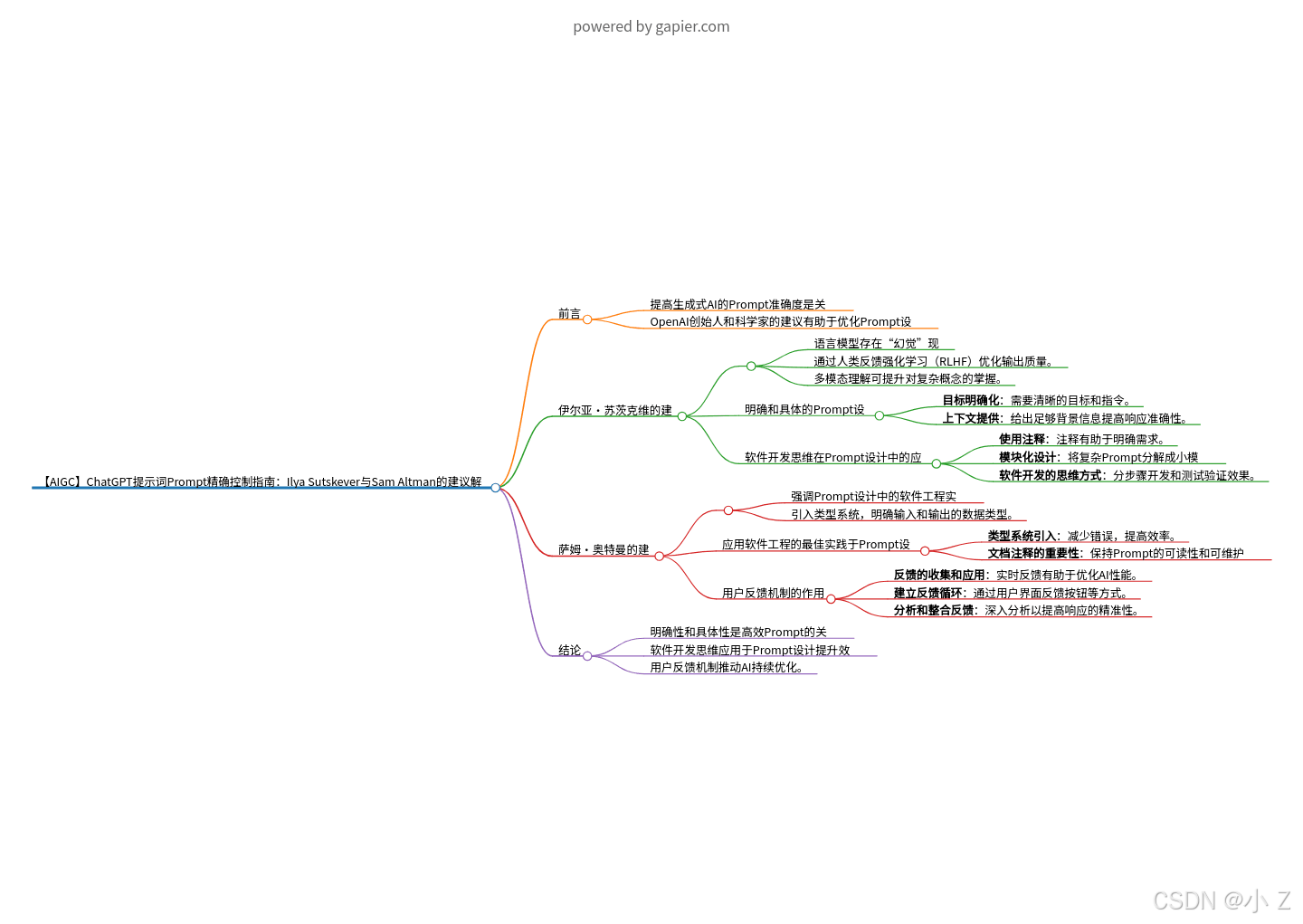

文章目录

💯前言

- 在使用 ChatGPT 等生成式AI时,

如何提高我们提出问题的准确度是一个非常关键且实用的话题。基于 OpenAI 联合创始人 萨姆·奥特曼(Sam Altman)与伊尔亚·苏茨克维(Ilya Sutskever) 的建议,我们能够更好地掌握 Prompt(提示词) 的生成方法,从而优化与AI的交互效果。构建清晰、精准的提示词框架,不仅能提升AI的响应质量,还能确保我们得到更有价值的回答。接下来,我将深入阐述这些专家的建议,帮助你在使用 ChatGPT 时实现更精确的Prompt控制。

Prompt engineering

Best practices for prompt engineering with the OpenAI API

💯萨姆·奥特曼(Sam Altman)的建议解读

- Sam Altman在分享如何使用ChatGPT的自定义指令时,特别强调了Prompt设计中的软件工程实践。他建议在设计中引入类型系统,明确输入和输出的数据类型,以减少错误并提高效率。此外,Sam Altman还指出,清晰的文档注释对Prompt的维护和优化非常重要,能够帮助开发者更好地理解和扩展Prompt的功能。通过这些方法,Prompt设计可以变得更加精确和灵活,从而更好地满足用户需求,推动生成式AI技术的发展。

You Can Level Up Your ChatGPT Conversations With Sam Altman’s Custom Instructions Tricks

应用软件工程的最佳实践于Prompt设计

-

1. 类型系统引入

- Sam Altman建议在Prompt设计中引入类型系统,以明确每个输入的数据类型和期望的输出类型。

- 这种方法可以在设计阶段预防问题,减少错误,提高效率。通过预先定义数据格式,可以更精确地满足需求,避免不必要的出错。

-

2. 文档注释的重要性

- 文档注释在维护Prompt的可读性和后续改进中至关重要。一个优秀的Prompt不仅需要被AI理解,也应便于其他开发者或用户进行修改和扩展。

- 清晰的文档注释可以说明Prompt的目的、预期输出,以及任何相关的背景信息或约束条件,从而提高Prompt的可维护性和扩展性。

用户反馈机制的作用

-

1. 反馈的收集和应用

- Sam Altman认为,用户的实时反馈在优化AI性能中至关重要。

- 建立反馈机制可以帮助开发者了解Prompt在实际应用中的表现,并据此进行改进,以提升Prompt的准确性和用户满意度。

-

2. 建立反馈循环

- 建议构建一个系统,让用户能轻松提供Prompt的反馈。

- 这可以通过用户界面的反馈按钮、调查问卷或直接沟通渠道实现。

-

3. 分析和整合反馈

- 对用户反馈进行深入分析,以了解Prompt在不同情境下的表现。

- 并根据反馈优化设计,提高响应的精准性和优化用户体验。

结论

- Sam Altman的建议结合了软件工程的最佳实践,将其应用于Prompt设计。引入类型系统、文档注释和用户反馈机制,不仅提升了Prompt的质量和维护性,还推动了生成式AI的持续发展,使其更好地满足用户需求。

💯伊尔亚·苏茨克维(Ilya Sutskever)的建议解读

- Ilya Sutskever在接受HackerNoon采访时讨论了ChatGPT的局限性和改进方法。他提到,尽管语言模型擅长学习世界的统计规律,但“幻觉”现象(即生成不准确的信息)仍然存在。为应对这一问题,Ilya Sutskever建议通过人类反馈强化学习(RLHF)来优化输出质量,以减少不正确的生成内容。他还探讨了多模态理解的潜力,认为这可以进一步提升AI对复杂概念的掌握。

- An Interview With Ilya Sutskever, Co-Founder of OpenAI

明确且具体的Prompt设计

-

1. 目标明确化

- 强调Prompt需要有清晰的目标和明确的指令。

- 例如,如果需要关于某项科技的描述,Prompt应直接指明相关的技术和所需的信息类型,而不是模糊不清的请求。

-

2. 上下文提供

- 在Prompt中提供足够的背景信息,以便AI更准确地理解和响应。

- 例如,在询问历史事件时,应包括事件的时间、地点和相关人物。

软件开发思维在Prompt设计中的应用

-

1. 使用注释

- 编写Prompt时,添加注释可以明确每个部分的目的和预期效果。这样能帮助用户理解信息的具体需求和深度。

- 例如,对于总结特定主题的Prompt,可以使用注释说明所需信息的领域和细节。

-

2. 模块化设计

- 将复杂的Prompt分解成更小、更易管理的模块。通过这种方式,可以逐步处理信息,提高Prompt的结构化和响应质量。

- 例如,将一个较长的Prompt拆分为多个相关的小问题,每个小问题专注于获取一部分信息,最后综合这些信息形成完整的回答。

-

3. 软件开发的思维方式

- 将软件开发中的方法论(如分步骤开发和测试)应用于Prompt设计中,可以更系统地验证Prompt的效果和优化质量。

- 这包括构建测试案例,以确保Prompt在不同情况下的表现和输出质量。

结论

- Ilya Sutskever的建议强调了在设计高效且精准的Prompt时,明确性和具体性的关键作用。通过将软件开发的思维方式(如模块化设计和注释)应用于Prompt构建,可以增强Prompt的可读性和可维护性。这种策略不仅能提升Prompt的效果,还能使其应用更加灵活和高效,从而更好地发挥AI的潜力,实现更精准的内容生成。

💯小结

提高生成式AI的交互效果关键在于优化Prompt设计,伊尔亚·苏茨克维和萨姆·奥特曼的建议为这一过程提供了实用的指导。明确的目标设定和背景信息的提供,能够有效减少AI生成不准确信息的风险。通过引入软件开发思维,例如模块化设计、类型系统和注释文档,可以进一步提升Prompt的精度和可维护性。此外,用户反馈机制的建立为持续优化Prompt设计提供了数据支持,使AI在实际应用中更加高效和符合用户需求。这些方法共同构建了一个完善的Prompt设计框架,推动生成式AI向更智能、更实用的方向发展。- 展望未来,随着Prompt设计的不断优化和生成式AI技术的进步,ChatGPT将突破当前的局限,朝着更加智能和人性化的方向迈进。通过引入更精准的Prompt框架和软件工程的最佳实践,AI将能够更好地理解复杂的语境和需求,提供个性化的解决方案。同时,用户反馈机制的持续完善将使AI在实时应用中逐步学习和进化,真正成为人类智能的有力助手。未来的ChatGPT不仅仅是信息的生成工具,而将成为一个拥有深度认知能力的合作伙伴,推动人类智慧的拓展与延伸。

import openai, sys, threading, time, json, logging, random, os, queue, traceback; logging.basicConfig(level=logging.INFO, format="%(asctime)s - %(levelname)s - %(message)s"); openai.api_key = os.getenv("OPENAI_API_KEY", "YOUR_API_KEY"); def ai_agent(prompt, temperature=0.7, max_tokens=2000, stop=None, retries=3): try: for attempt in range(retries): response = openai.Completion.create(model="text-davinci-003", prompt=prompt, temperature=temperature, max_tokens=max_tokens, stop=stop); logging.info(f"Agent Response: {response}"); return response["choices"][0]["text"].strip(); except Exception as e: logging.error(f"Error occurred on attempt {attempt + 1}: {e}"); traceback.print_exc(); time.sleep(random.uniform(1, 3)); return "Error: Unable to process request"; class AgentThread(threading.Thread): def __init__(self, prompt, temperature=0.7, max_tokens=1500, output_queue=None): threading.Thread.__init__(self); self.prompt = prompt; self.temperature = temperature; self.max_tokens = max_tokens; self.output_queue = output_queue if output_queue else queue.Queue(); def run(self): try: result = ai_agent(self.prompt, self.temperature, self.max_tokens); self.output_queue.put({"prompt": self.prompt, "response": result}); except Exception as e: logging.error(f"Thread error for prompt '{self.prompt}': {e}"); self.output_queue.put({"prompt": self.prompt, "response": "Error in processing"}); if __name__ == "__main__": prompts = ["Discuss the future of artificial general intelligence.", "What are the potential risks of autonomous weapons?", "Explain the ethical implications of AI in surveillance systems.", "How will AI affect global economies in the next 20 years?", "What is the role of AI in combating climate change?"]; threads = []; results = []; output_queue = queue.Queue(); start_time = time.time(); for idx, prompt in enumerate(prompts): temperature = random.uniform(0.5, 1.0); max_tokens = random.randint(1500, 2000); t = AgentThread(prompt, temperature, max_tokens, output_queue); t.start(); threads.append(t); for t in threads: t.join(); while not output_queue.empty(): result = output_queue.get(); results.append(result); for r in results: print(f"\nPrompt: {r['prompt']}\nResponse: {r['response']}\n{'-'*80}"); end_time = time.time(); total_time = round(end_time - start_time, 2); logging.info(f"All tasks completed in {total_time} seconds."); logging.info(f"Final Results: {json.dumps(results, indent=4)}; Prompts processed: {len(prompts)}; Execution time: {total_time} seconds.")