目录

安装部署示例

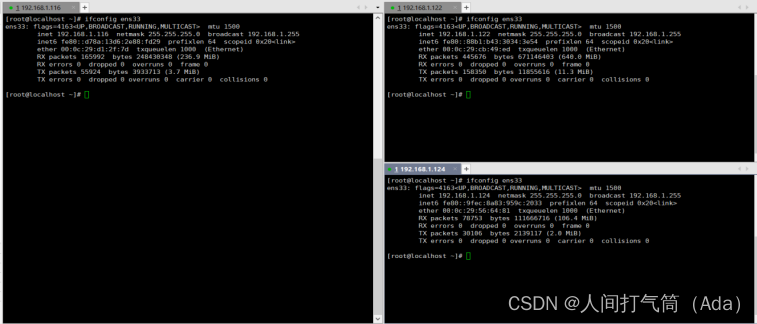

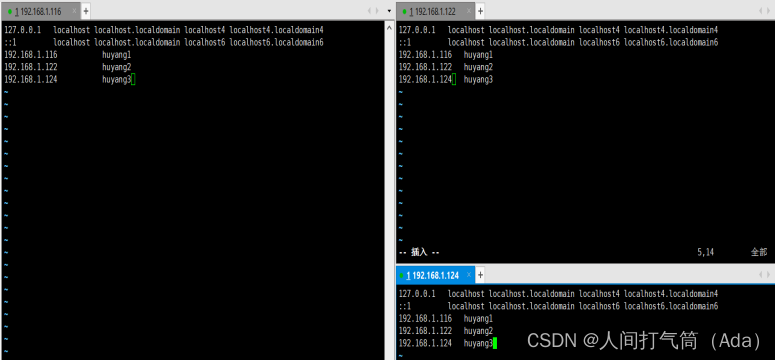

以下是一个比较简单的使用 ceph-deploy 工具进行 Ceph 集群部署的示例步骤,假设我们使用 CentOS 7 系统部署 Ceph,且三台服务器的 IP 地址分别是 192.168.1.116,192.168.1.122 和 192.168.1.124:

(一)准备环境

在三台服务器上都执行以下操作:

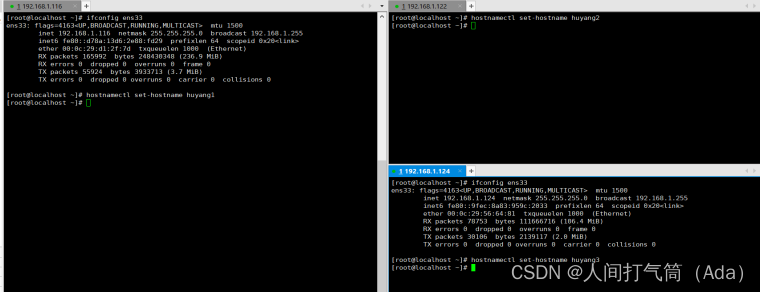

1). 设置主机名

hostnamectl set-hostname huyang1 (或者huyang2或者huyang3)

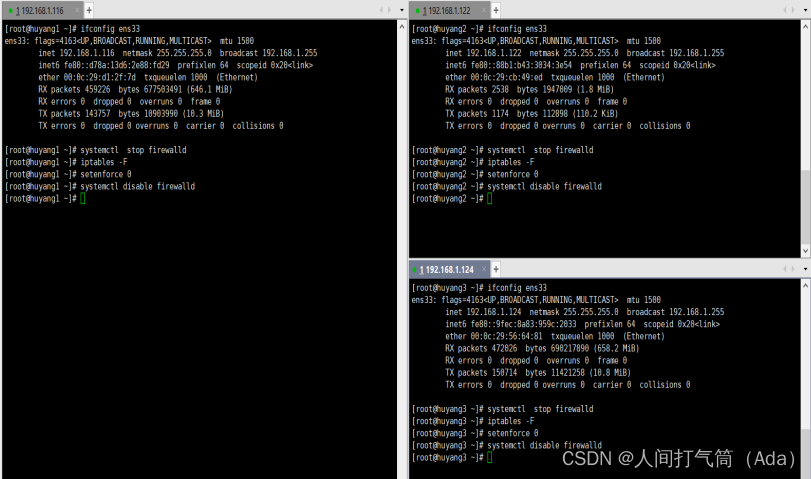

2). 关闭防火墙

为了简化操作,先在所有节点关闭防火墙:

systemctl stop firewalld

systemctl disable firewalld

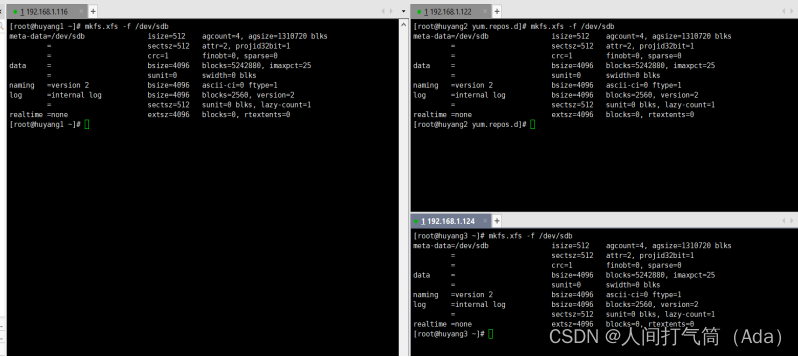

3).添加sdb磁盘并格式化

huyang1:mkfs.xfs /dev/sdb

huyang2:mkfs.xfs /dev/sdb

huyang3:mkfs.xfs /dev/sdb

4).配置hosts解析文件

vim /etc/hosts

192.168.1.116 huyang1 192.168.1.122 huyang2

192.168.1.124 huyang3

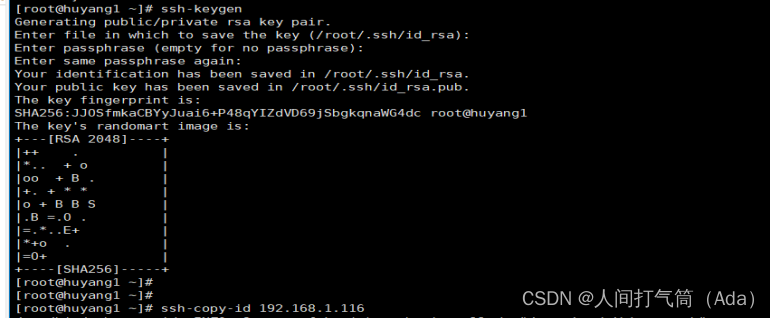

5).配置免密登录

huyang1:ssh-keygen #三台主机都需要做ssh免密

huyang1:ssh-copy-id 192.168.1.116

huyang1:ssh-copy-id 192.168.1.122

huyang1:ssh-copy-id 192.168.1.124

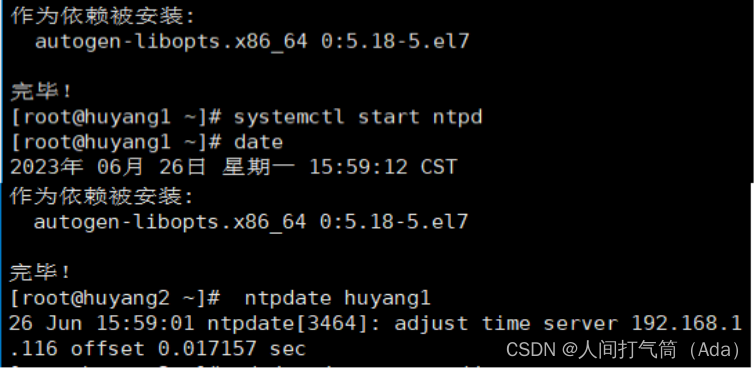

6).同步时区

【huyang1/2/3】:yum -y install ntp

【huyang1】:systemctl start ntpd

【huyang2/3】:ntpdate huyang1

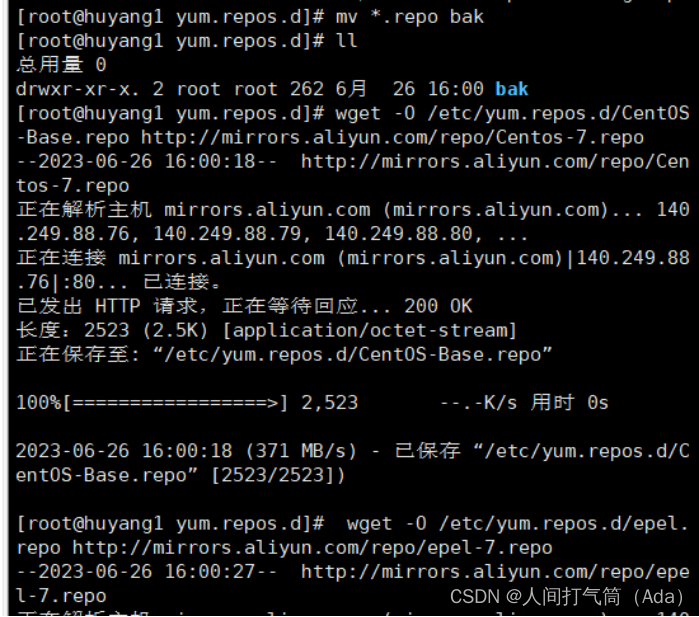

7). 安装 Ceph 包

在所有节点上安装 EPEL yum 仓库,然后安装 Ceph 包:

[huyang1/2/3]:cd /etc/yum.repos.d

[huyang1/2/3]:mkdir bak

[huyang1/2/3]:mv *.repo bak

[huyang1/2/3]:

wget -O /etc/yum.repos.d/CentOS-Base.repo

http://mirrors.aliyun.com/repo/Centos-7.repo

wget -O /etc/yum.repos.d/epel.repo

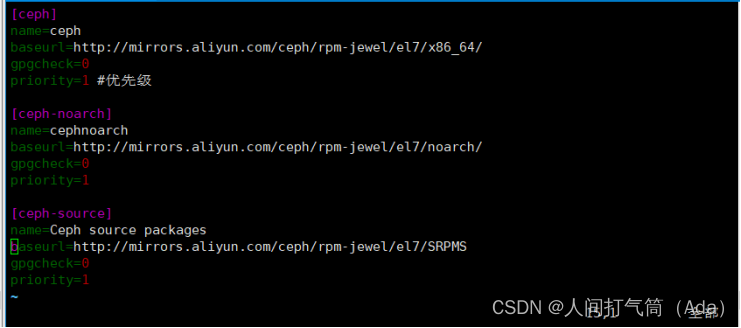

[huyang1/2/3]:vim /etc/yum.repos.d/ceph.repo

插入以下内容:

[ceph]

name=ceph

baseurl=http://mirrors.aliyun.com/ceph/rpm-jewel/el7/x86_64/

gpgcheck=0

priority=1 #优先级

[ceph-noarch]

name=cephnoarch

baseurl=http://mirrors.aliyun.com/ceph/rpm-jewel/el7/noarch/

gpgcheck=0

priority=1

[ceph-source]

name=Ceph source packages

baseurl=http://mirrors.aliyun.com/ceph/rpm-jewel/el7/SRPMS

gpgcheck=0

priority=1

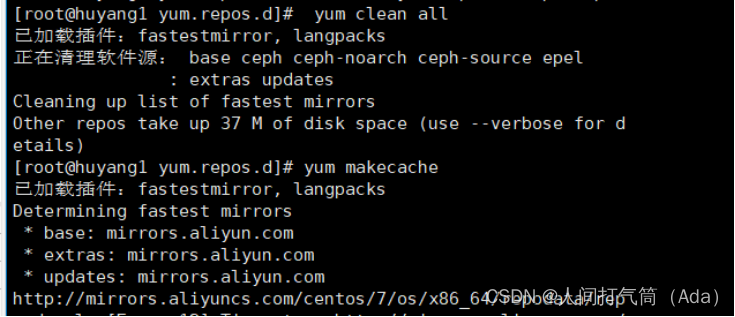

[huyang1/2/3]:yum clean all

[huyang1/2/3]:yum makecache

(二)创建 Ceph 集群

1、 安装ceph-deploy管理工具

yum -y install ceph-deploy

2、 创建ceph集群

mkdir /etc/ceph && cd /etc/ceph

ceph-deploy new huyang1

3、 修改ceph副本数

编辑配置文件(ceph.conf),配置集群选项和 OSD 存储路径: vim ceph.conf

[global]

fsid = f7ce6b7c-b5c7-45ce-a394-2604b2bdc2e6

mon_initial_members = huyang1

mon_host = 192.168.1.116

auth_cluster_required = cephx

auth_service_required = cephx

auth_client_required = cephx

osd_pool_default_size = 2 #增加这行内容,表示副本数为2

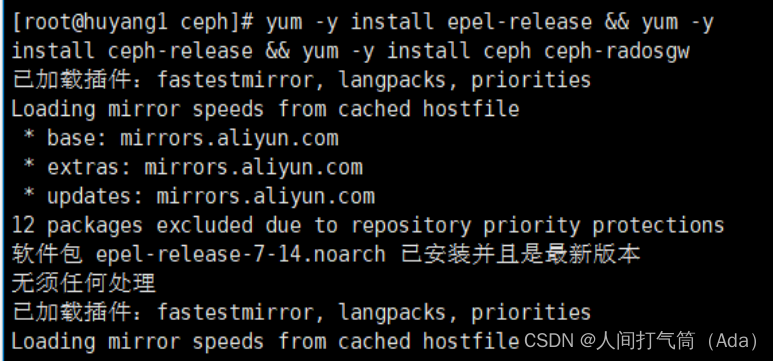

4、 安装ceph

[huyang1/2/3]:

yum -y install epel-release

yum -y install ceph-release

yum -y install ceph ceph-radosgw

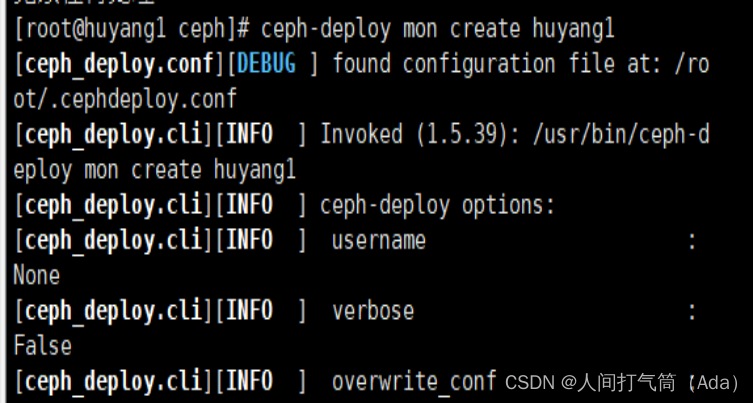

5、 安装ceph monitor

[huyang1]:ceph-deploy mon create huyang1

6、 收集节点的keyring文件

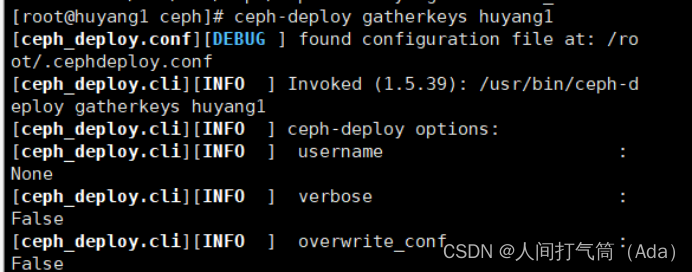

[huyang1]:ceph-deploy gatherkeys huyang1

收集之后呈现下列情况:

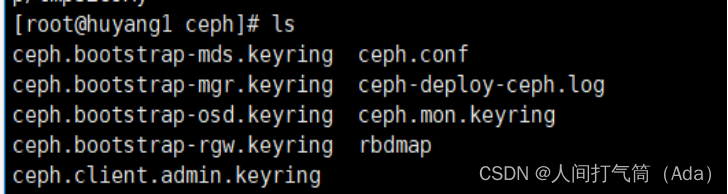

[huyang1]:ls

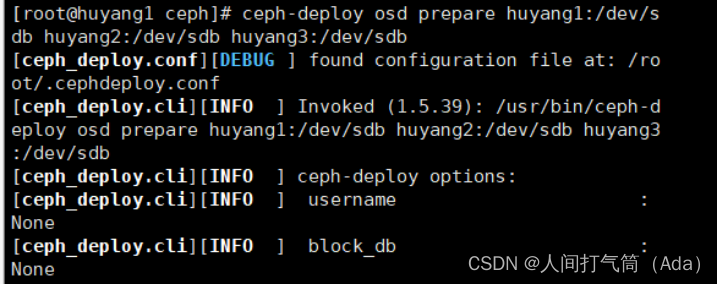

7、 创建osd服务

[huyang1]:ceph-deploy osd prepare huyang1:/dev/sdb

huyang2:/dev/sdb huyang3:/dev/sdb

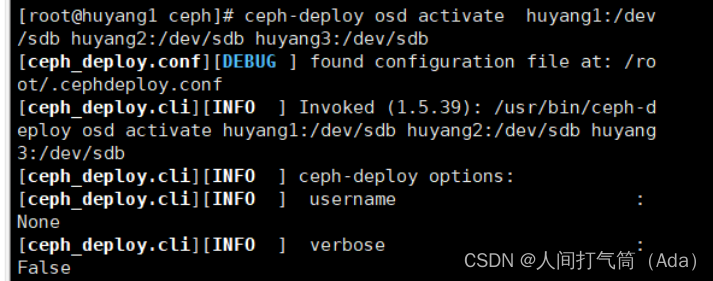

8、 激活osd服务

[huyang1]:ceph-deploy osd activate huyang1:/dev/sdb

huyang2:/dev/sdb huyang3:/dev/sdb

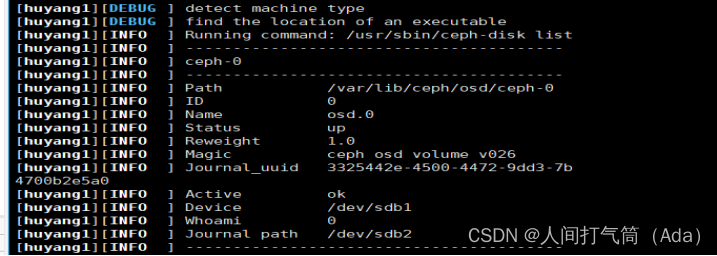

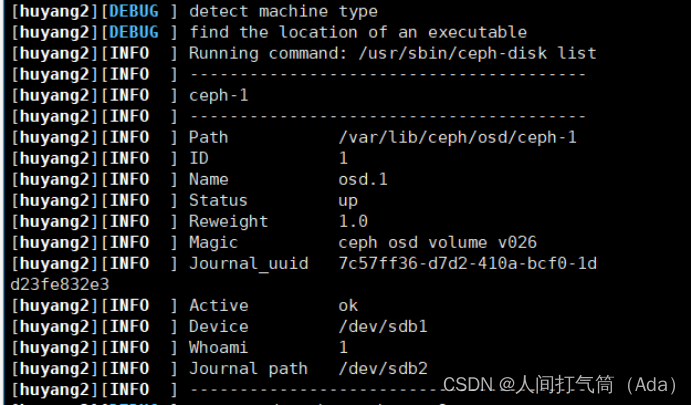

9、 查看osd的状态

[huyang1]:

ceph-deploy osd list huyang1 huyang2 huyang3

huyang1:

huyang2:

huyang3:

查看ceph集群的状态:

[huyang1]:ceph health

[huyang1]:ceph -s

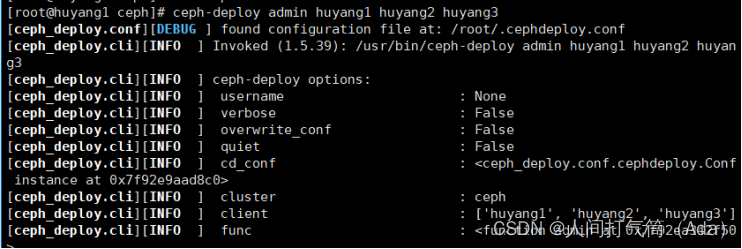

10、 将所有主机的配置统一

[huyang1]:ceph-deploy admin huyang1 huyang2 huyang3

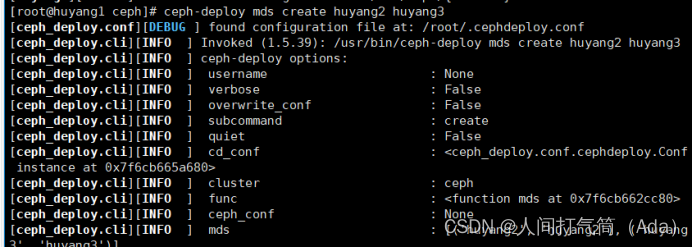

11、 部署mds服务

[huyang1]:ceph-deploy mds create huyang2 huyang3

12、 查看mds的状态

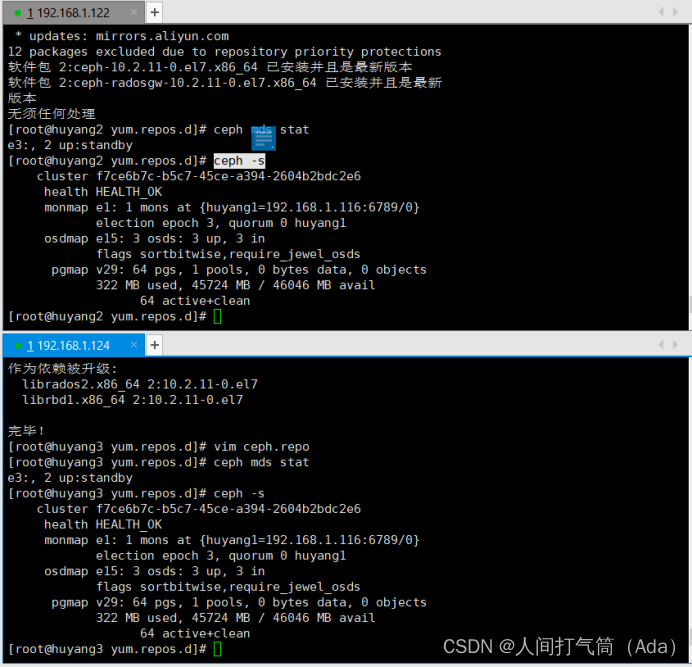

[huyang2/3]: ceph mds stat

13、 查看ceph集群的状态

[huyang2/3]: ceph -s

以上操作ceph集群基本上就搭建完毕