目录

Kafka的安装

前提,已安装docker和docker-compose。

拉取镜像

docker pull bitnami/zookeeper:latest

docker pull bitnami/kafka:latest

docker-compose.yaml如下

version: '3'

services:

zookeeper:

image: 'bitnami/zookeeper:latest'

ports:

- '2181:2181'

environment:

- ALLOW_ANONYMOUS_LOGIN=yes

kafka:

image: 'bitnami/kafka:latest'

ports:

- '9092:9092'

environment:

- KAFKA_BROKER_ID=1

- KAFKA_CFG_LISTENERS=PLAINTEXT://:9092

- KAFKA_CFG_ADVERTISED_LISTENER=PLAINTEXT://127.0.0.1:9092

- KAFKA_CFG_ZOOKEEPER_CONNECT=zookeeper:2181

- ALLOW_PLAINTEXT_LISTENER=yes

depends\_on:

- zookeeper

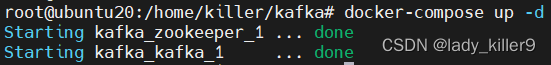

启动命令

docker-compose up -d

截图

之后的相关命令若涉及容器id,请自行更换

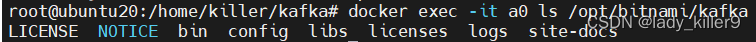

文件与配置

目录

docker exec -it a0 ls /opt/bitnami/kafka

查看目录命令

截图

重要目录解释如下:

- bin: 脚本目录

- config:配置目录

- libs:第三方依赖库目录

- logs:日志

bin

重要的shell脚本加粗了,之后会用

connect-distributed.sh kafka-dump-log.sh kafka-storage.sh

connect-mirror-maker.sh kafka-features.sh kafka-streams-application-reset.sh

connect-standalone.sh kafka-get-offsets.sh kafka-topics.sh

kafka-acls.sh kafka-leader-election.sh kafka-transactions.sh

kafka-broker-api-versions.sh kafka-log-dirs.sh kafka-verifiable-consumer.sh

kafka-cluster.sh kafka-metadata-shell.sh kafka-verifiable-producer.sh

kafka-configs.sh kafka-mirror-maker.sh trogdor.sh

kafka-console-consumer.sh kafka-producer-perf-test.sh windows

kafka-console-producer.sh kafka-reassign-partitions.sh zookeeper-security-migration.sh

kafka-consumer-groups.sh kafka-replica-verification.sh zookeeper-server-start.sh

kafka-consumer-perf-test.sh kafka-run-class.sh zookeeper-server-stop.sh

kafka-delegation-tokens.sh kafka-server-start.sh zookeeper-shell.sh

kafka-delete-records.sh kafka-server-stop.sh

config

connect-console-sink.properties connect-mirror-maker.properties server.properties

connect-console-source.properties connect-standalone.properties tools-log4j.properties

connect-distributed.properties consumer.properties trogdor.conf

connect-file-sink.properties kraft zookeeper.properties

connect-file-source.properties log4j.properties

connect-log4j.properties producer.properties

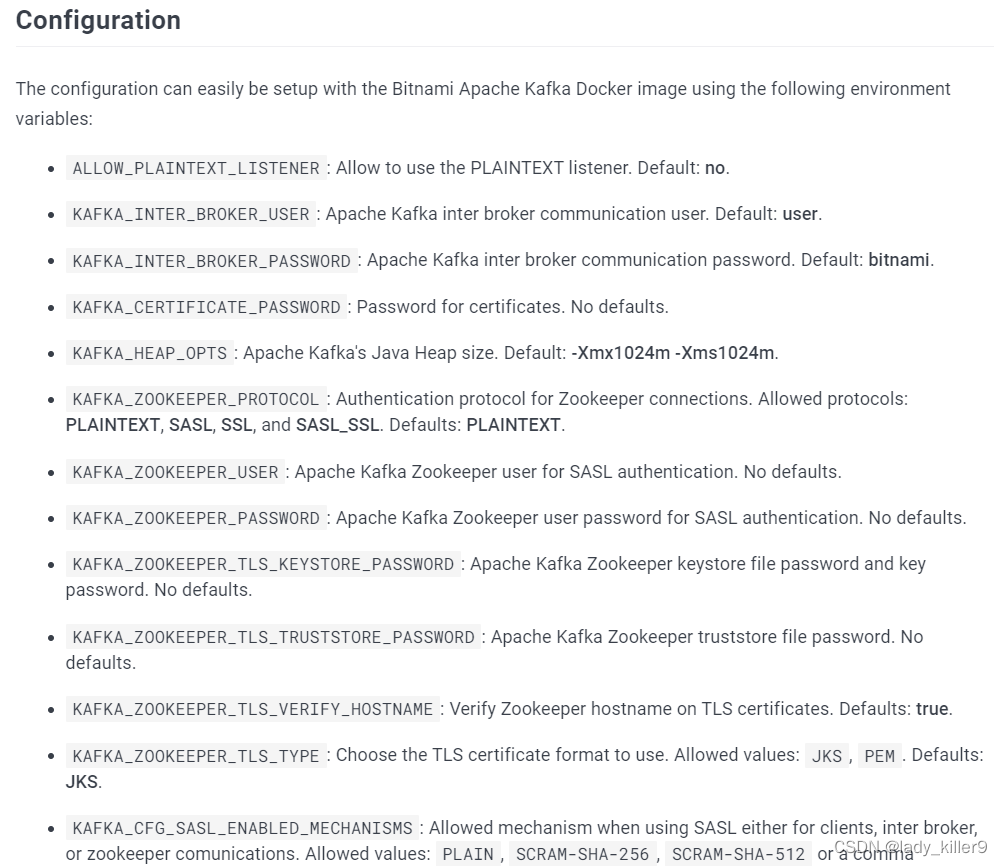

配置文件

server.properties

- broker.id: 唯一id值,通过环境变量设置为了1

- log.dirs: kafka集群日志目录,默认是log.dirs=/bitnami/kafka/data

- zookeeper.connect:zookeeper地址端口,格式域名/ip:port,这块是zookeeper:2181,在docker的网络中可以解析为另一容器的ip

更多配置可以查看参考中Dockerhub链接的Configuration部分

producer.properties

- bootstrap.servers:kafka的ip:port,这里是localhost:9092

- compression.type:压缩类型,默认是none, 一共有四种,none, gzip, snappy, lz4, zstd,推荐排序LZ4 > GZIP > Snappy,详见腾讯云压缩算法对比

consumer.properties

- group.id:消费者组id,默认为test-consumer-group

- auto.offset.reset:offset设置,三种latest, earliest, none,看情况设置

命令行简单使用

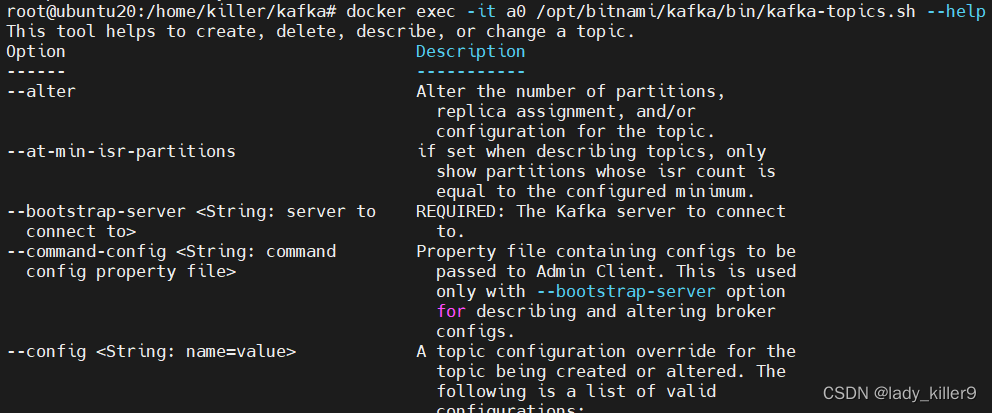

kafka-topics.sh

对主题topic进行增删改查的工具

常用选项如下:

- –bootstrap-server:kafka服务器ip:port,必须的

- –create:创建主题

- –delete:删除主题

- –describe:描述主题

- –list:查看主题列表

- –alter:修改主题的 partitions等

- –topic <String: topic>:主题名

- –topic-id <String: topic-id>:主题id

- –partitions <Integer: # of partitions>:主题的partition

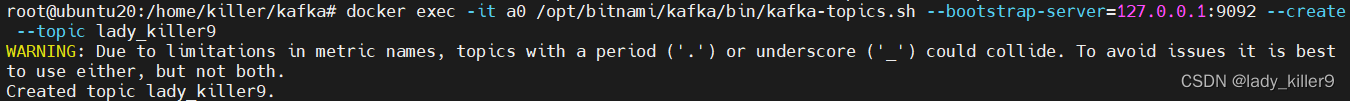

新增

命令

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-topics.sh --bootstrap-server=127.0.0.1:9092 --create --topic lady_killer9

截图

查看列表

命令

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-topics.sh --bootstrap-server=127.0.0.1:9092 --list

截图

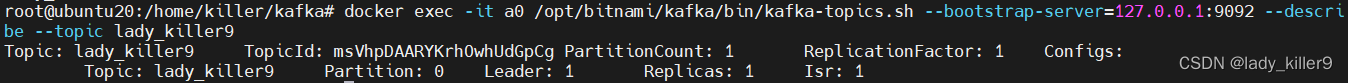

查看详情

命令

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-topics.sh --bootstrap-server=127.0.0.1:9092 --describe --topic lady_killer9

截图

修改

命令

以修改主题partiion数量为例

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-topics.sh --bootstrap-server=127.0.0.1:9092 --alter --topic lady_killer9 --partitions 3

## 写在最后

**在结束之际,我想重申的是,学习并非如攀登险峻高峰,而是如滴水穿石般的持久累积。尤其当我们步入工作岗位之后,持之以恒的学习变得愈发不易,如同在茫茫大海中独自划舟,稍有松懈便可能被巨浪吞噬。然而,对于我们程序员而言,学习是生存之本,是我们在激烈市场竞争中立于不败之地的关键。一旦停止学习,我们便如同逆水行舟,不进则退,终将被时代的洪流所淘汰。因此,不断汲取新知识,不仅是对自己的提升,更是对自己的一份珍贵投资。让我们不断磨砺自己,与时代共同进步,书写属于我们的辉煌篇章。**

需要完整版PDF学习资源私我

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化资料的朋友,可以点击这里获取](https://bbs.csdn.net/topics/618540462)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**