| 标题 | Mitigating Matthew Effect: Multi-Hypergraph Boosted Multi-Interest Self-Supervised Learning for Conversational Recommendation |

|---|---|

| 期刊 | Proceedings of the 2024 Conference on Empirical Methods in Natural Language Processing |

| 年份 | 2024 |

| 关键词 | Conversational Recommendation, Matthew Effect, Multi-Hypergraph, Multi-Interest, Self-Supervised Learning |

🌟研究背景

在推荐系统领域,马太效应是一个棘手的问题。通俗来说,就是热门项目总是更受关注,而小众项目则被边缘化。这种现象在用户与系统交互过程中会进一步加剧,导致推荐结果的单一化和不公平。现有的方法大多关注静态推荐场景,但忽略了动态用户系统反馈循环中的马太效应问题。因此,本文提出了一种新的框架——HiCore,旨在通过学习多级用户兴趣来缓解对话推荐系统中的马太效应。

🔍相关工作

马太效应在推荐系统中的研究

-

用户兴趣多样性:许多研究致力于通过理解用户的多样化兴趣来提升推荐的多样性,但这些方法大多集中在静态场景中。

-

缓解流行度偏差:另一些研究则专注于减少流行度偏差,以确保各类项目的平衡曝光。然而,这些方法同样忽略了用户与系统交互的动态性。

对话推荐系统

-

基于属性的CRS:通过询问用户关于项目或其属性的问题来挖掘用户兴趣,但这种方法依赖于预定义的模板,生成的对话不够自然流畅。

-

基于生成的CRS:利用Seq2Seq架构将对话组件和推荐组件相结合,生成流畅连贯的响应。但这些方法在捕捉用户多样化兴趣方面存在挑战,因为用户-项目交互数据有限。

📝方法与创新

HiCore框架

本文提出的HiCore框架包含两个核心部分:多超图增强的多兴趣自监督学习(Multi-Hypergraph Boosted Multi-Interest Self-Supervised Learning)和兴趣增强的CRS(Interest-Boosted CRS)。

多超图构建

-

超图的定义:超图不同于传统图,它允许一条边连接多个节点。本文构建了多种超图来编码复杂的高阶用户关系模式。

-

多通道超图:包括项目导向、实体导向和词汇导向的三通道超图。通过这些超图,可以捕捉到用户兴趣的多级特征。

多兴趣自监督学习

-

超图卷积网络:通过超图卷积网络(HGCN)学习多级用户兴趣。

-

注意力机制:利用注意力网络(Attention)和图卷积网络(GConv)来学习最终的多兴趣表示。

-

自监督学习目标:采用InfoNCE作为学习目标,通过对比学习来优化模型。

兴趣增强的CRS

-

推荐模块:利用多兴趣表示来选择目标项目,并采用交叉熵损失函数进行优化。

-

对话模块:将多兴趣输入到Transformer中,生成信息丰富的对话响应。

📊实验

实验设计

-

数据集:本文在四个基准数据集上进行了评估,包括REDIAL、TG-REDIAL、OpenDialKG和DuRecDial。

-

基线方法:与多种现有方法进行了比较,包括TextCNN、SASRec、BERT4Rec等。

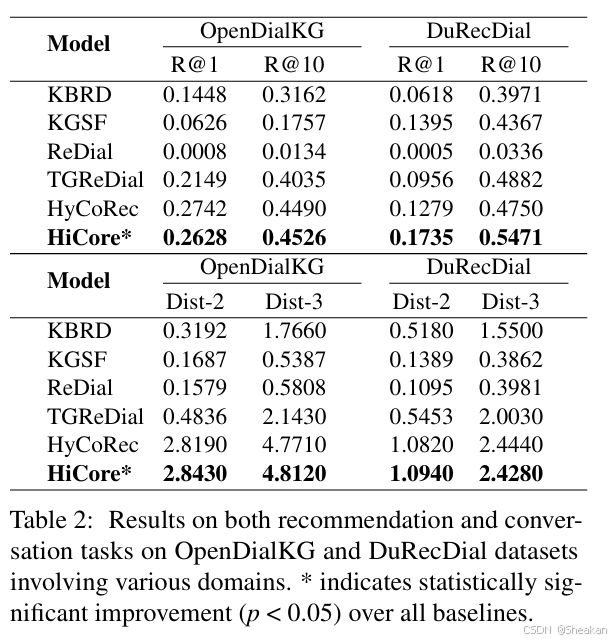

推荐性能

-

评估指标:使用Recall@K、MRR@K和NDCG@K(K=1, 10, 50)来评估推荐任务。

-

结果:HiCore在所有基线方法中表现最佳,证明了其在推荐任务中的优越性。

对话性能

-

评估指标:使用Distinct n-gram(Dist-n,n=2,3,4)来评估对话任务。

-

结果:HiCore在对话任务中也显著优于所有基线方法,证明了其在生成高质量对话响应方面的能力。

马太效应缓解

-

评估指标:使用Coverage@k、Average Popularity和Long Tail Ratio来评估马太效应的缓解效果。

-

结果:HiCore在所有数据集上都取得了最高的Coverage和最低的Average Popularity和Long Tail Ratio,证明了其在缓解马太效应方面的有效性。

🌈创新点

-

多超图构建:首次构建了三通道设置的多超图,用于学习多兴趣,以缓解CRS中的马太效应。

-

多兴趣自监督学习:通过超图卷积网络和注意力机制学习多级用户兴趣,并采用自监督学习目标进行优化。

-

兴趣增强的CRS:利用多兴趣表示增强对话和推荐任务,提升推荐的多样性和对话的自然性。