视觉SLAM实验要在Ubuntu20.04系统上使用ROS跑ORB-SLAM3,熟悉一下特征点法的SLAM,把安装过程总结记录下来。

一、配置版本信息

| 系统 | 版本 |

|---|---|

| ubuntu | 20.04 |

| Pangolin | 0.6 |

| Eigen | 3 |

| Opencv | 4.2 |

| usb_cam |

二、替换镜像源

# 默认注释了源码镜像以提高 apt update 速度,如有需要可自行取消注释

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic main restricted universe multiverse

# deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic main restricted universe multiverse

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-updates main restricted universe multiverse

# deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-updates main restricted universe multiverse

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-backports main restricted universe multiverse

# deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-backports main restricted universe multiverse

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-security main restricted universe multiverse

# deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-security main restricted universe multiverse

# 预发布软件源,不建议启用

# deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-proposed main restricted universe multiverse

# deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ bionic-proposed main restricted universe multiverse

执行命令更新源

sudo apt-get update

sudo apt-get upgrade

三、安装ROS环境

1、ROS简介

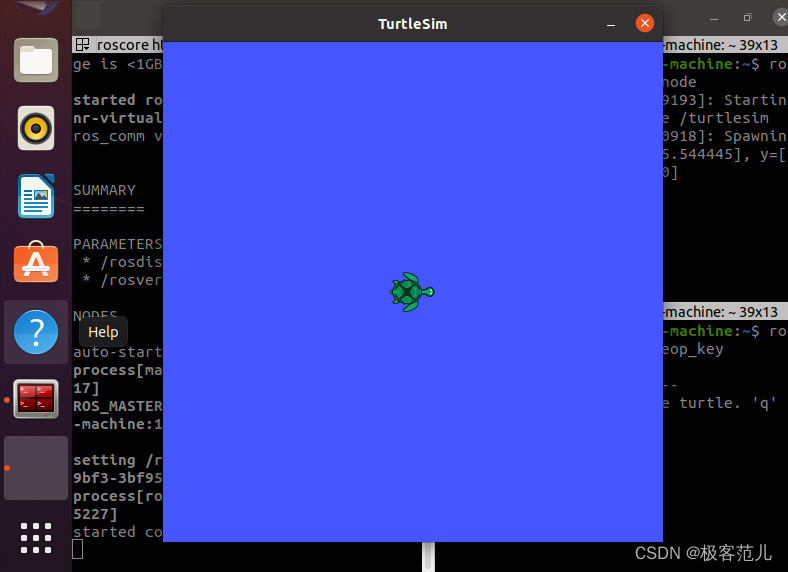

ROS全称Robot Operating System(机器人操作系统)

- ROS是适用于机器人的开源元操作系统

- ROS集成了大量的工具,库,协议,提供类似OS所提供的功能,简化对机器人的控制

- 还提供了用于在多台计算机上获取,构建,编写和运行代码的工具和库,ROS在某些方面类似于"机器人框架”

- ROS设计者将ROS表述为“ROS = Plumbing + Tools + Capabilities + Ecosystem",即ROS是通讯机制、工具软件包、机器人高层技能以及机器人生态系统的集合体

http://www.autolabor.com.cn/book/ROSTutorials/index.html

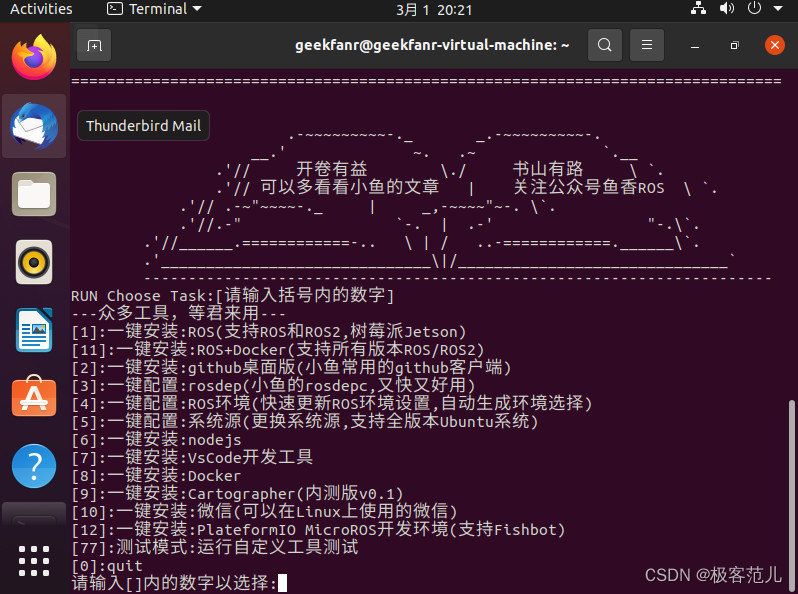

2、小鱼安装

小鱼老师把国外关于ROS的库放到了自己的服务器上,所以只用向他的服务器发送命令就能快速安装

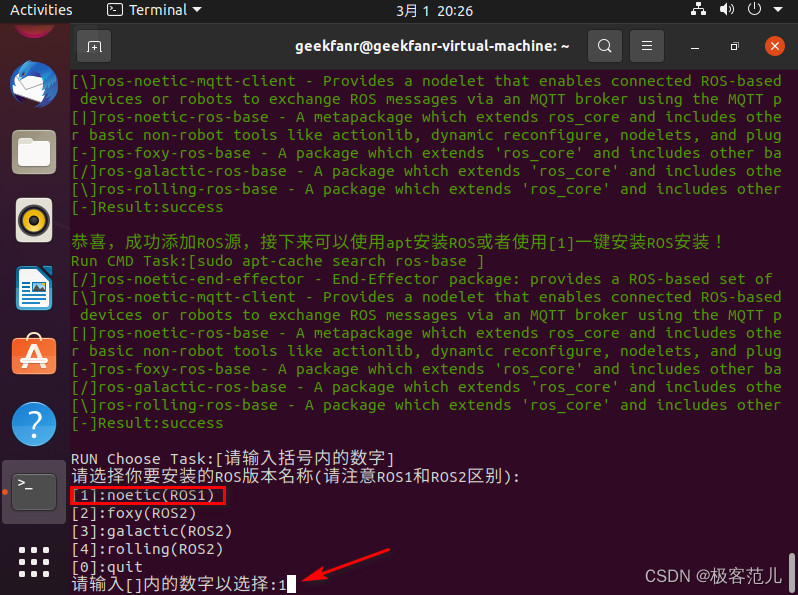

安装ROS系统配置比较复杂,Ubuntu20.04对应ROS版本为noetic,推荐使用小鱼老师的一键安装、配置ROS的代码

wget http://fishros.com/install -O fishros && bash fishros

平时使用都是ROS1,ROS2是ROS1的改进版本,支持多机,分布式,暂时不会使用。

四、环境配置

1、安装库

(1)安装git,g++

sudo apt-get install git

sudo apt install g++

建议先安装ROS中的cv_bridge和libopencv-dev,再安装和libopencv版本号一样的opencv库,这样可以避免opencv的版本冲突问题。

(2)安装cv_bridge库

sudo apt-get install libopencv-dev

sudo apt-get install ros-noekit-cv-bridge

(3)安装Opencv

①安装依赖项

sudo apt-get install build-essential libgtk2.0-dev libgtk-3-dev libavcodec-dev libavformat-dev libjpeg-dev libswscale-dev libtiff5-dev

sudo apt install python3-dev python3-numpy

sudo apt install libgstreamer-plugins-base1.0-dev libgstreamer1.0-dev

sudo apt install libpng-dev libopenexr-dev libtiff-dev libwebp-dev

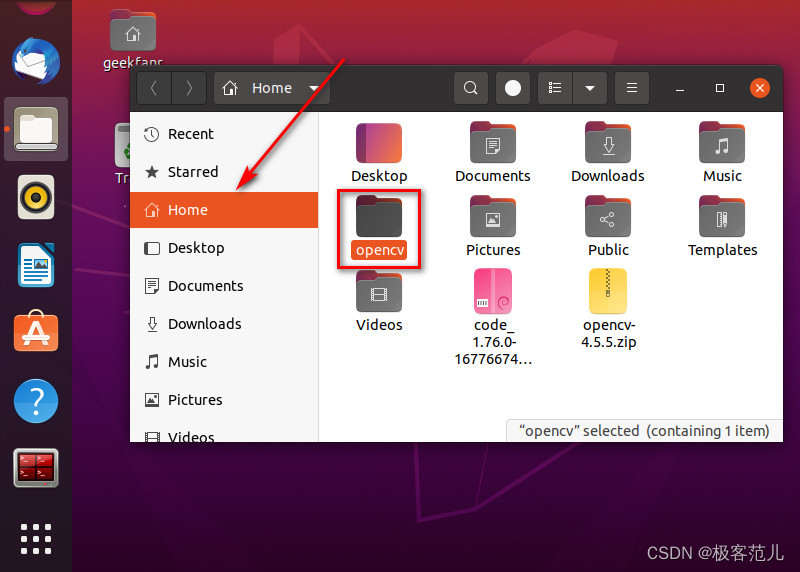

②下载Opencv源文件

解压至主目录,重新命名:opencv

③安装OpenCV

cd opencv

mkdir build

cd build

cmake -D CMAKE_BUILD_TYPE=Release -D OPENCV_GENERATE_PKGCONFIG=YES ..

make -j16

sudo make install

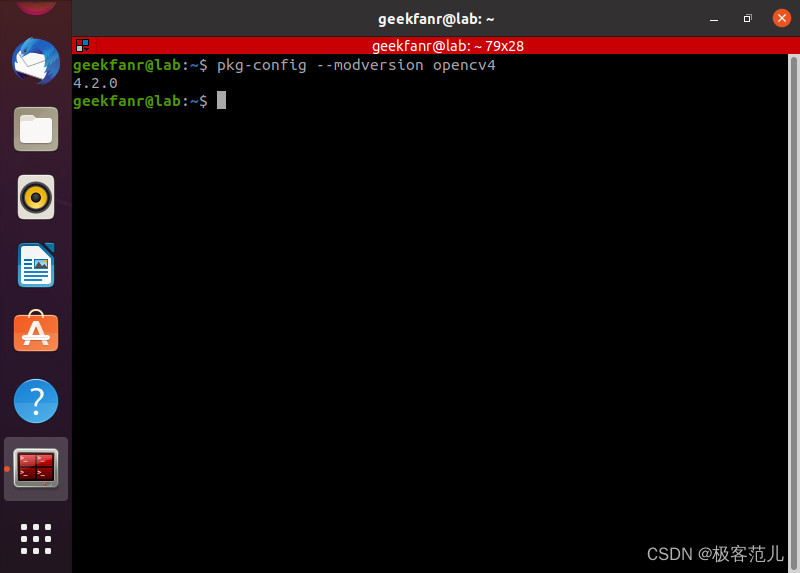

④查看版本号

pkg-config --modversion opencv4

由于noekit的自带libopencv版本是4.2.0,如果安装opencv3会出现版本冲突使编译不通过。如果安装opencv4但不是4.2.0依然会产生冲突,但编译能够通过,但运行时会出现核心已转储的问题。所以建议直接安装和libopencv一样的版本,小鱼的ROS已经自带OpenCV4.2.0,所以只需要挑着安装即可

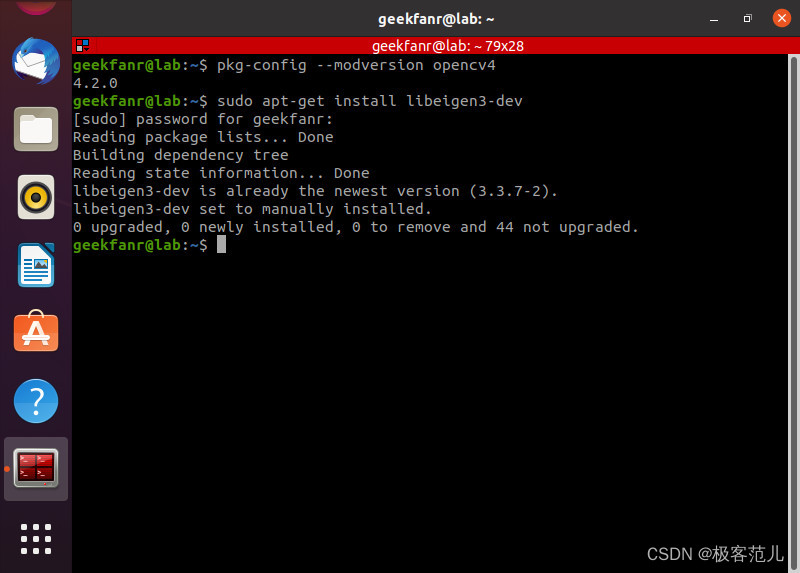

(4)安装EIGEN库

sudo apt-get install libeigen3-dev

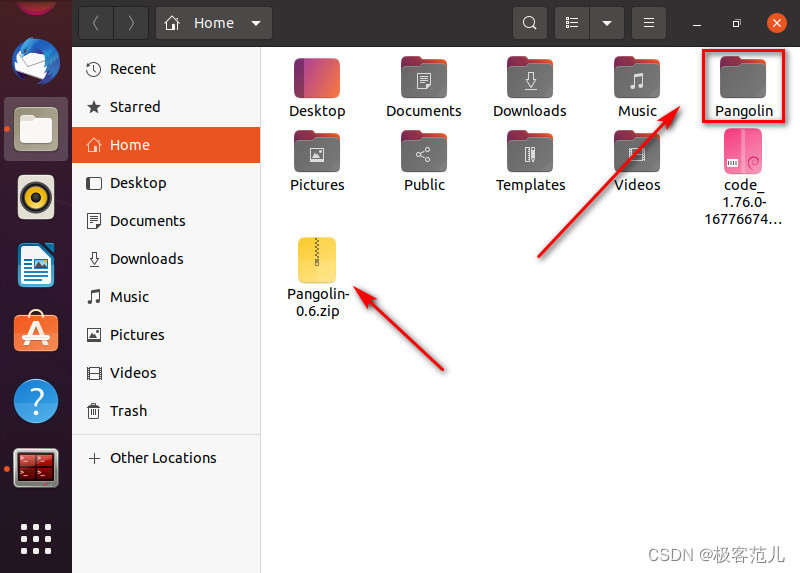

(5)安装Pangolin库

①下载Pangolin 0.6

解压到主目录,重新命名为Pangolin

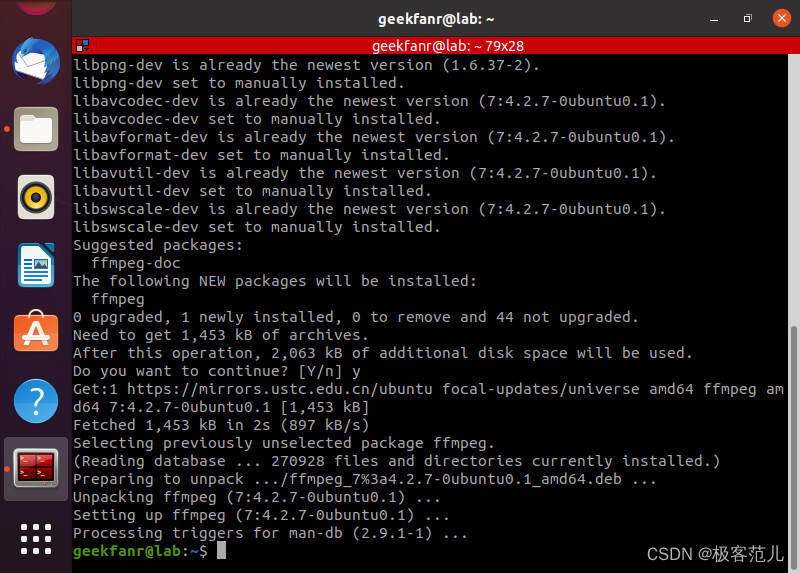

②安装依赖项

sudo apt-get install libglew-dev libboost-dev libboost-thread-dev libboost-filesystem-dev

sudo apt-get install ffmpeg libavcodec-dev libavutil-dev libavformat-dev libswscale-dev libpng-dev

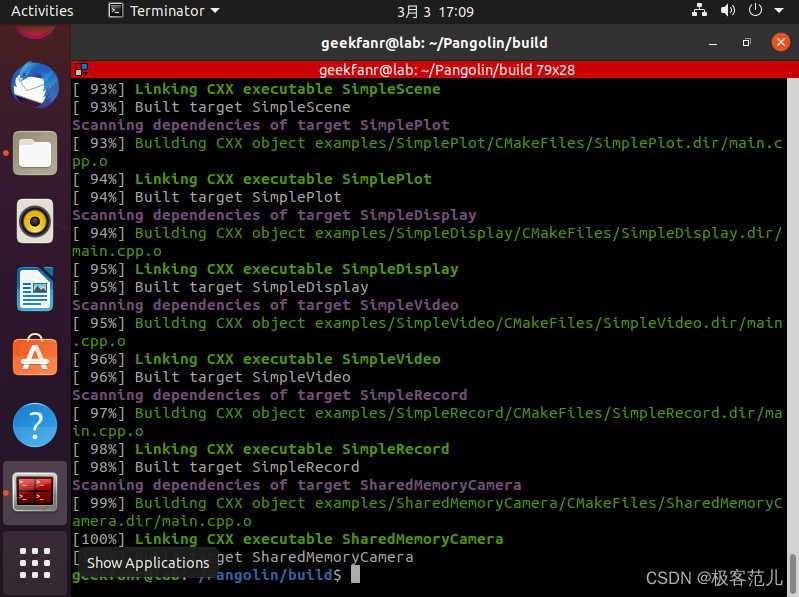

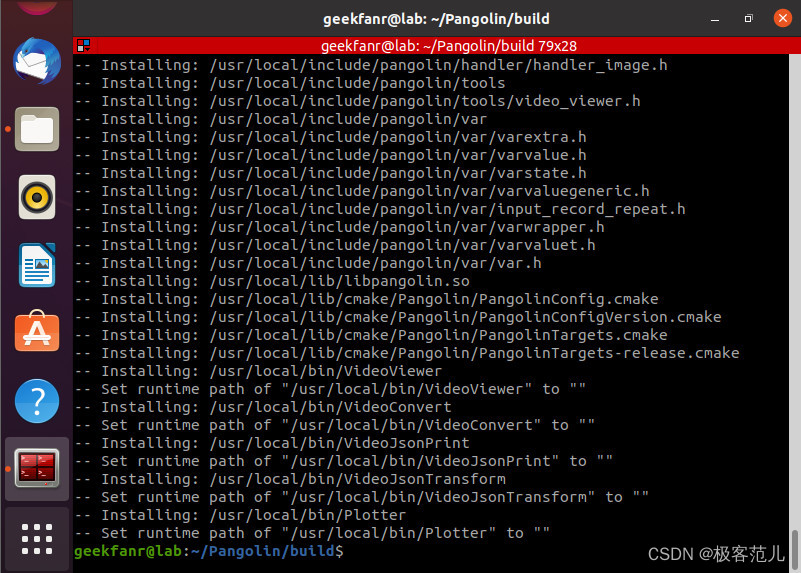

③编译安装

cd Pangolin

mkdir build && cd build

cmake -DCPP11_NO_BOOST=1 ..

make

sudo make install

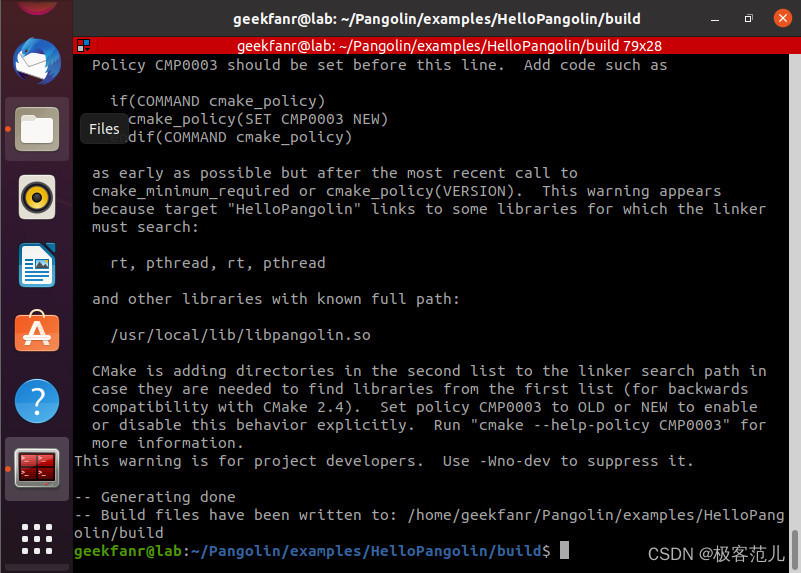

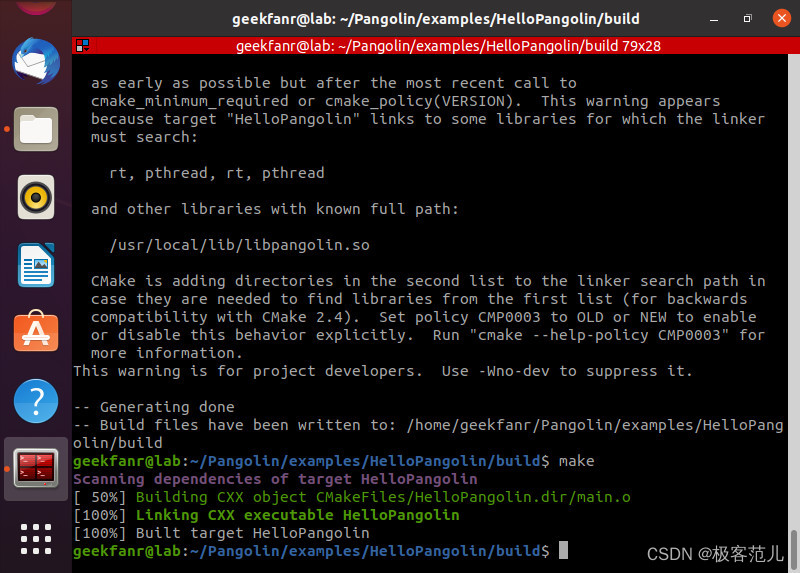

④验证

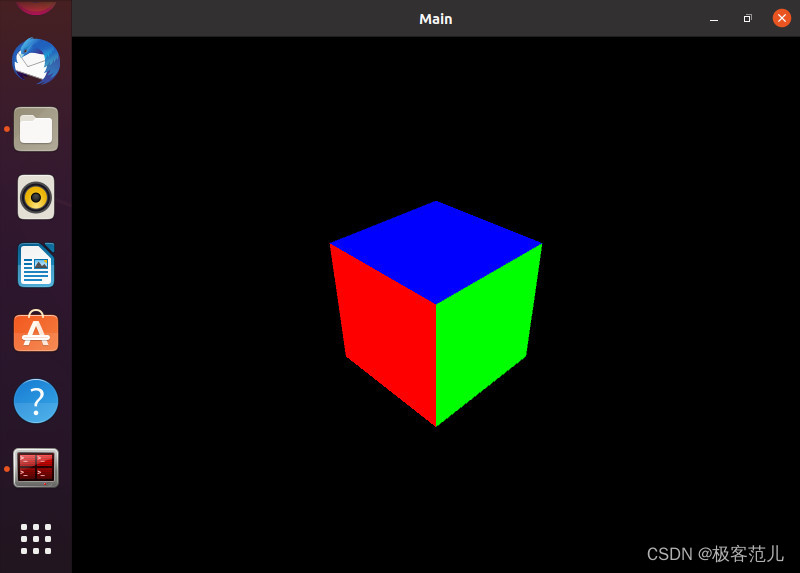

cd ../examples/HelloPangolin

mkdir build && cd build

cmake ..

make

./HelloPangolin

#成功会弹出如下窗口

(6)安装Boost库

①这里非常坑,官网上的依赖没有boost,但如果不安装boost会报很多的关于c++的错误,并且无法定位

②进入boost官网网址:http://www.boost.org/users/download/

③解压编译安装

tar -xvf boost_1_77_0.tar.gz

cd ./boost_1_77_0

./bootstrap.sh

sudo ./b2 install

2、ORB-SLAM3编译

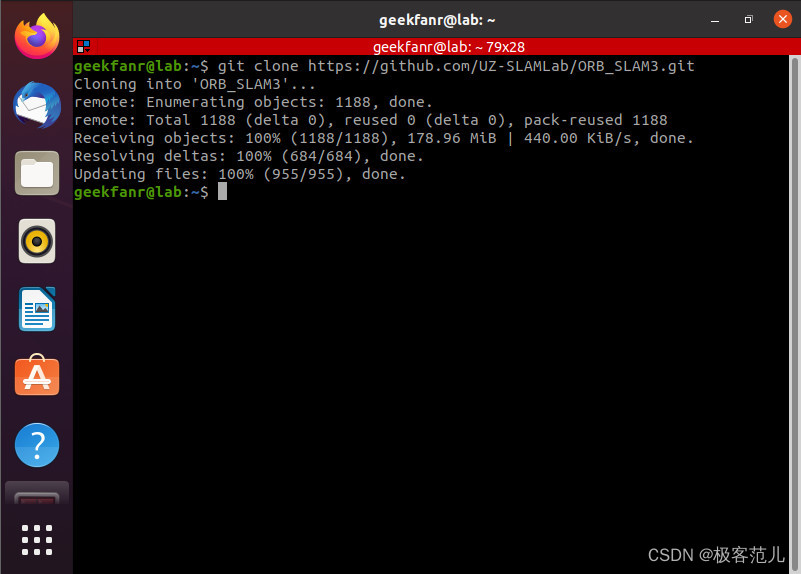

(1)下载ORB-SLAM3

git clone https://github.com/UZ-SLAMLab/ORB_SLAM3.git

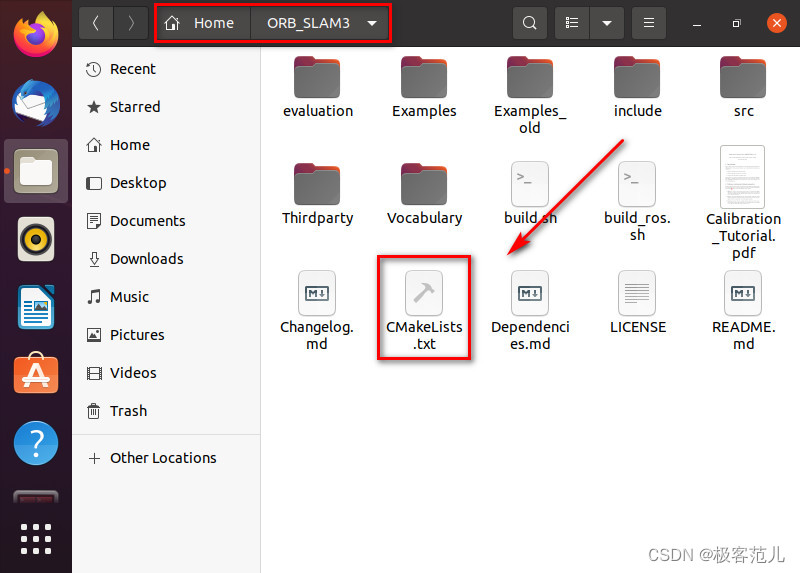

(2)修改源文件

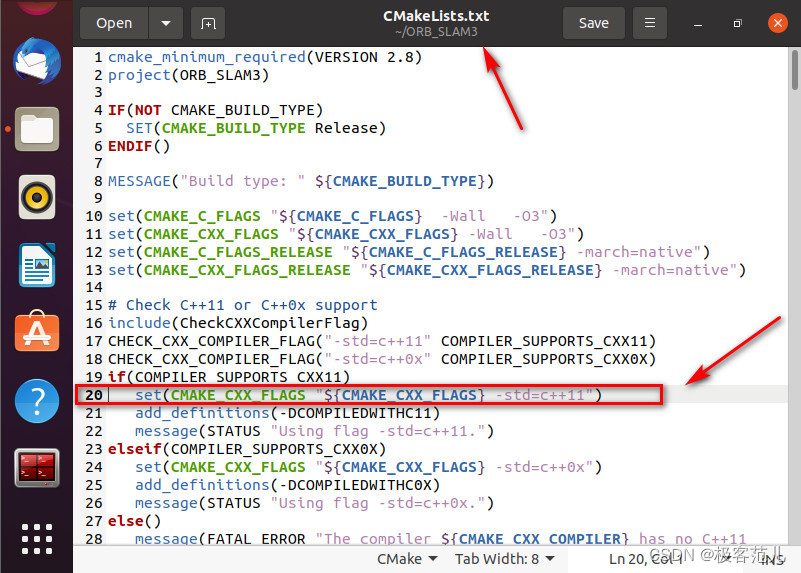

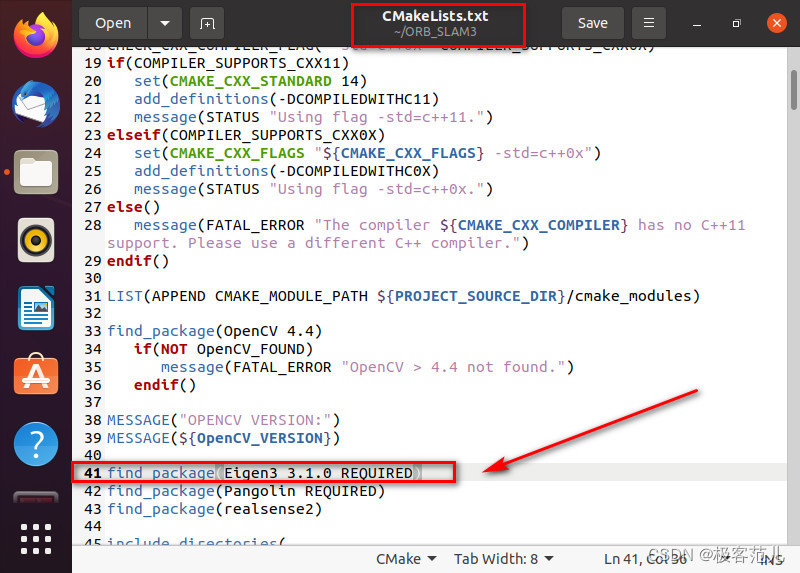

①ORB_SLAM3下CMakeLists.txt

- 第20行 c++11

set(CMAKE_CXX_STANDARD 14)

- 第41行 Eigen3

find_package(Eigen3 REQUIRED)

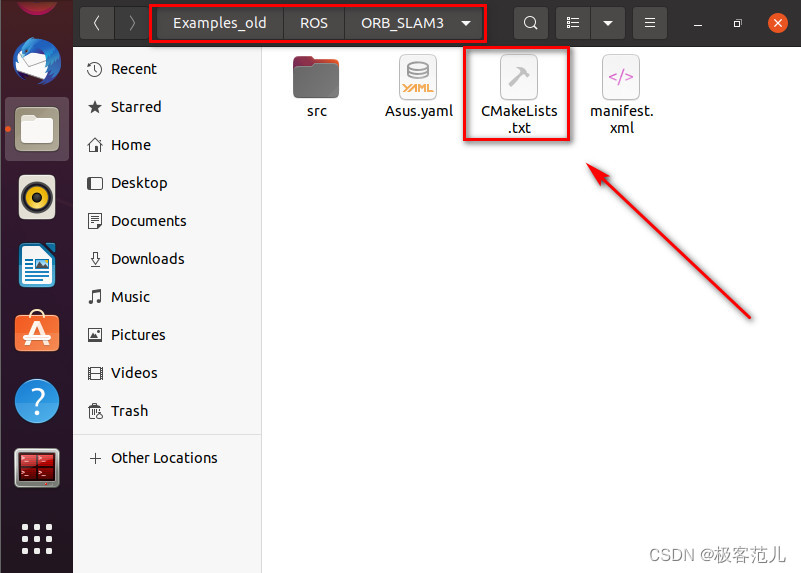

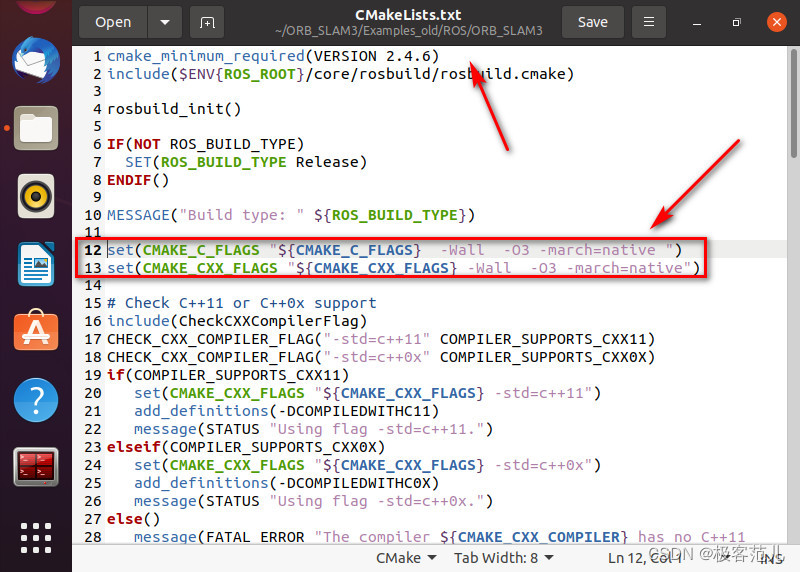

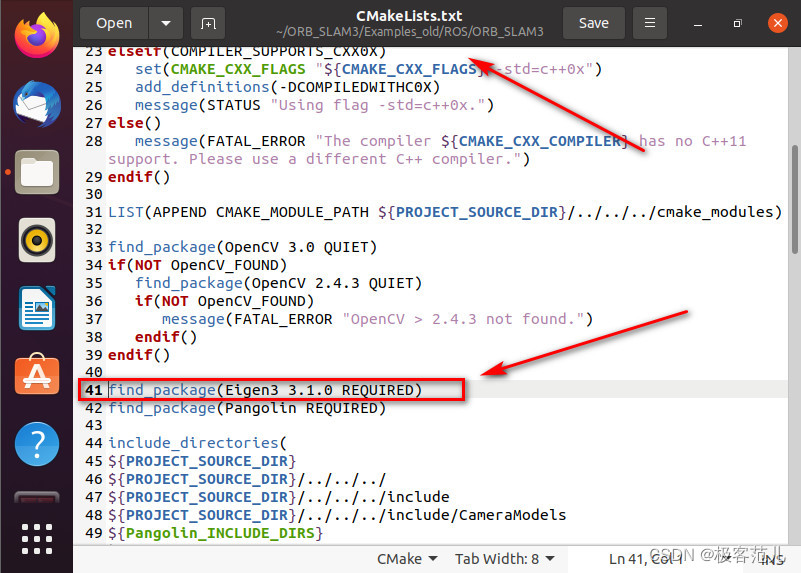

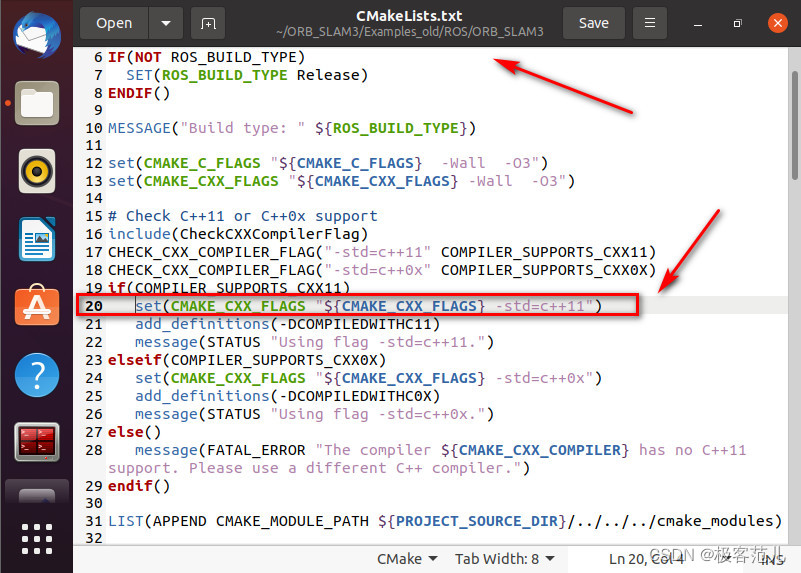

②修改ORB_SLAM3/Examples_old/ROS/ORB_SLAM3/CMakeLists.txt

- 第12、13行,去掉-march=native,避免运行一段时间后核心已转储的问题

set(CMAKE_C_FLAGS "${CMAKE_C_FLAGS} -Wall -O3")

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -Wall -O3")

第41行,将find_package(Eigen3 3.1.0 REQUIRED)修改

find_package(Eigen3 REQUIRED)

- 第20行,std=c++11

set(CMAKE_CXX_STANDARD 14)

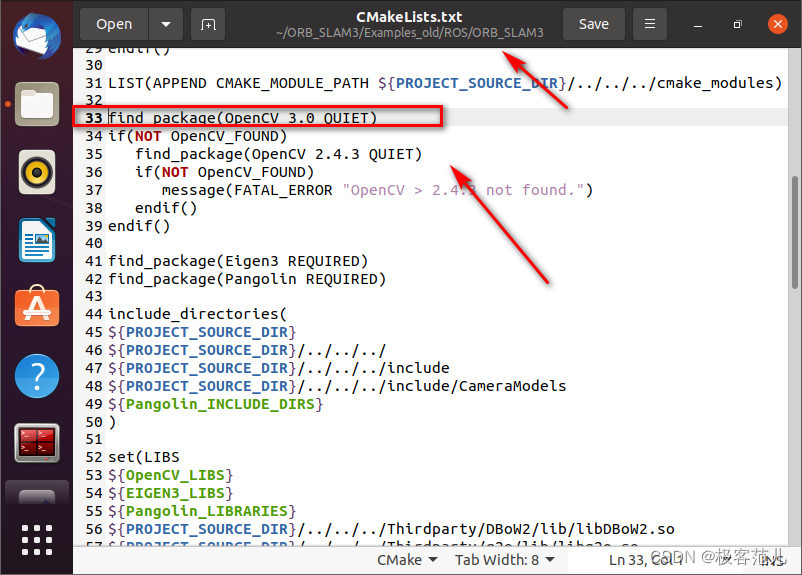

- 第33行OpenCV版本

find_package(OpenCV 4.2.0 REQUIRED)

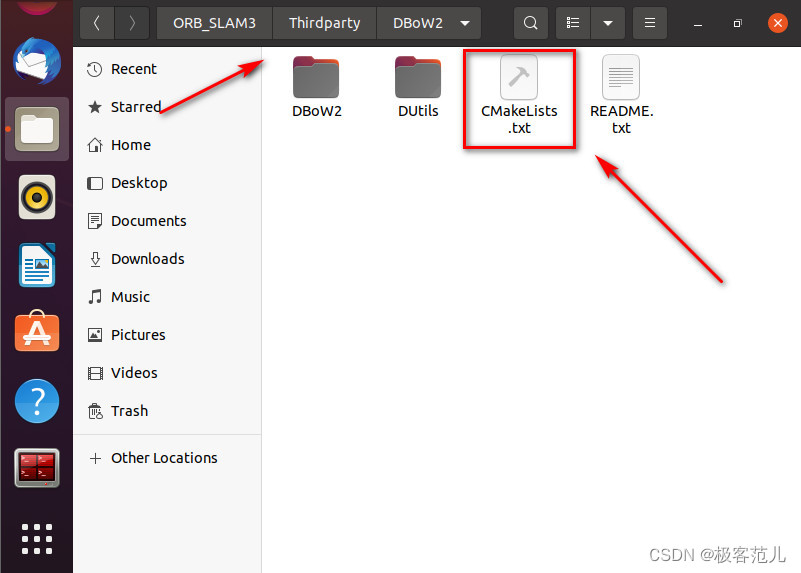

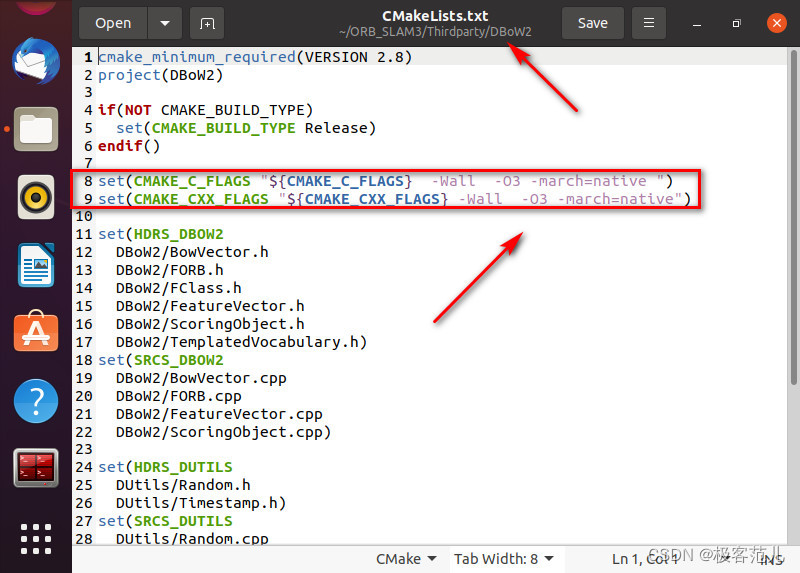

- 修改ORB_SLAM3/Thirdparty/DBoW2 /CMakeLists.txt

去掉-march=native,避免运行一段时间后核心已转储的问题

set(CMAKE_C_FLAGS "${CMAKE_C_FLAGS} -Wall -O3")

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -Wall -O3")

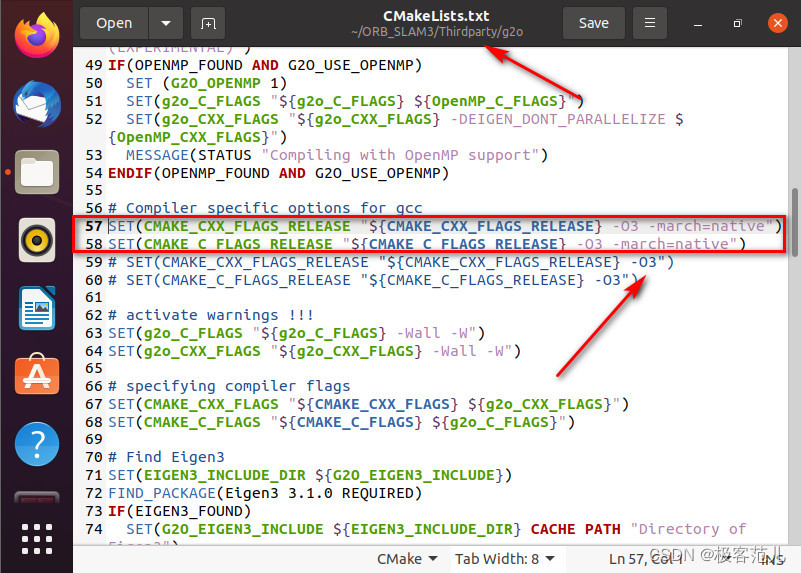

- 修改ORB_SLAM3/Thirdparty/g2o/CMakeLists.txt

去掉-march=native,避免运行一段时间后核心已转储的问题

set(CMAKE_C_FLAGS "${CMAKE_C_FLAGS} -Wall -O3")

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -Wall -O3")

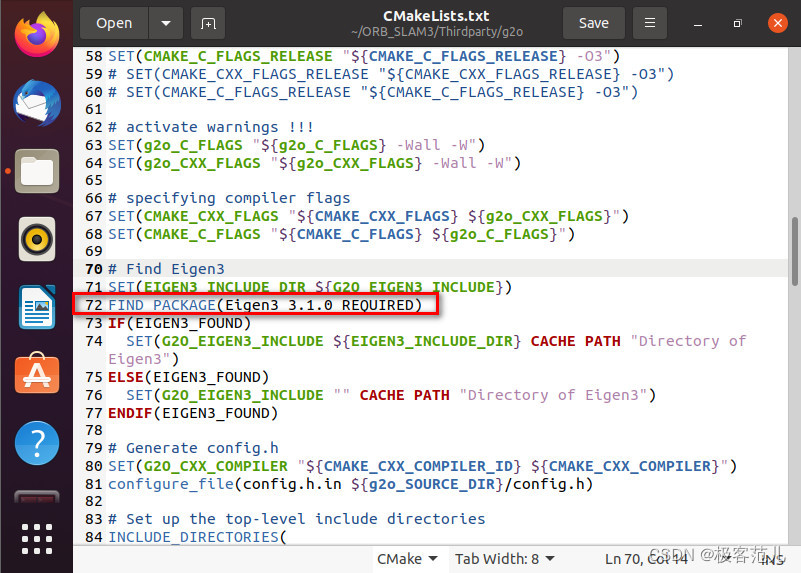

将find_package(Eigen3 3.1.0 REQUIRED)修改

find_package(Eigen3 REQUIRED)

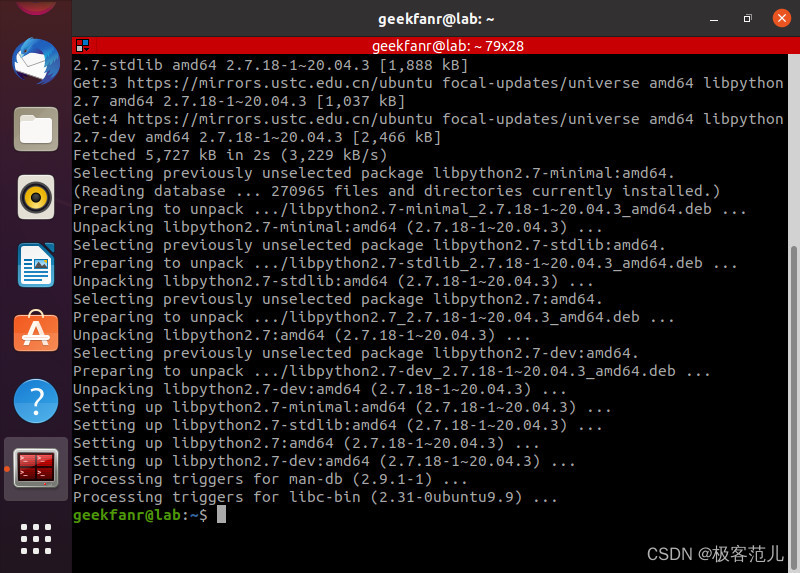

(3)安装python2.7

sudo apt install libpython2.7-dev

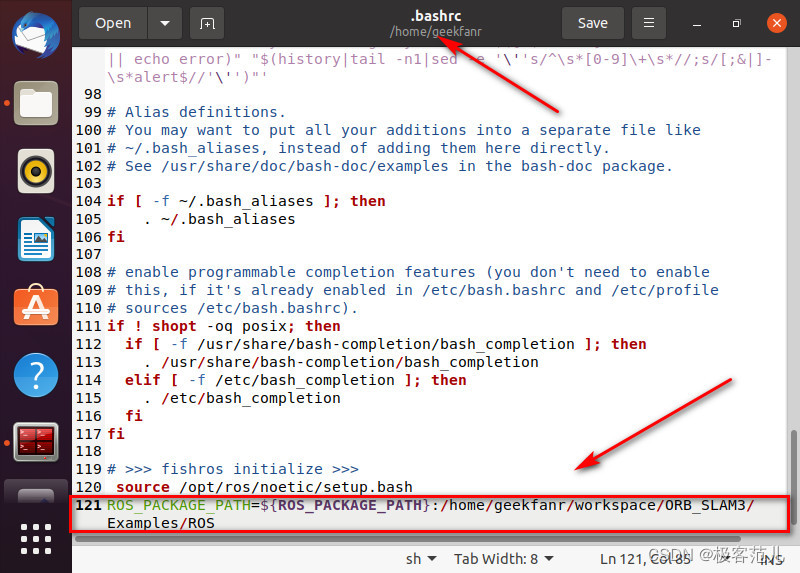

(4)添加ROS环境

①在编译ros版本时候需要初始化ROS,在**~/.bashrc的最后一行加入以下代码

sudo gedit ~/.bashrc

export ROS_PACKAGE_PATH=${ROS_PACKAGE_PATH}:/home/geekfanr/workspace/ORB_SLAM3/Examples/ROS

#保存退出

source ~/.bashrc

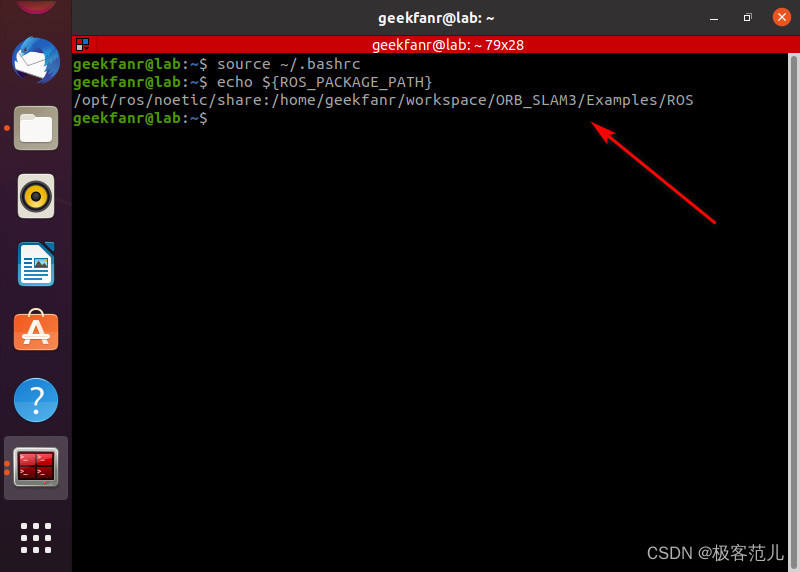

②再打开一个终端运行

echo ${ROS_PACKAGE_PATH}

如果能正确显示刚刚加入的地址则正常

ROS中使用许多工具前,要求需要初始化rosdep(可以安装系统依赖),rosdep 的初始化与更新

小鱼基于rosdep源码制作了rosdepc,专门服务国内ROS用户

sudo pip install rosdepc

(5)编译

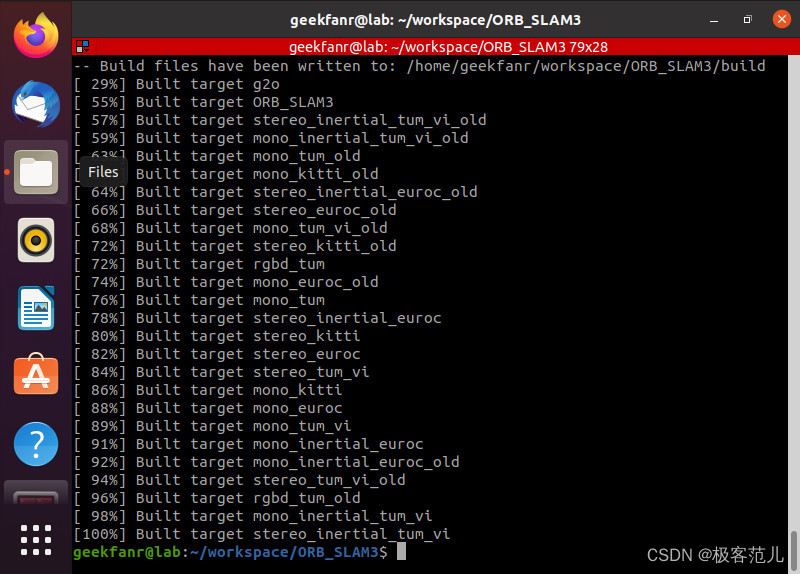

①编译ORB-SLAM3

cd ORB_SLAM3

chmod +x build.sh

./build.sh

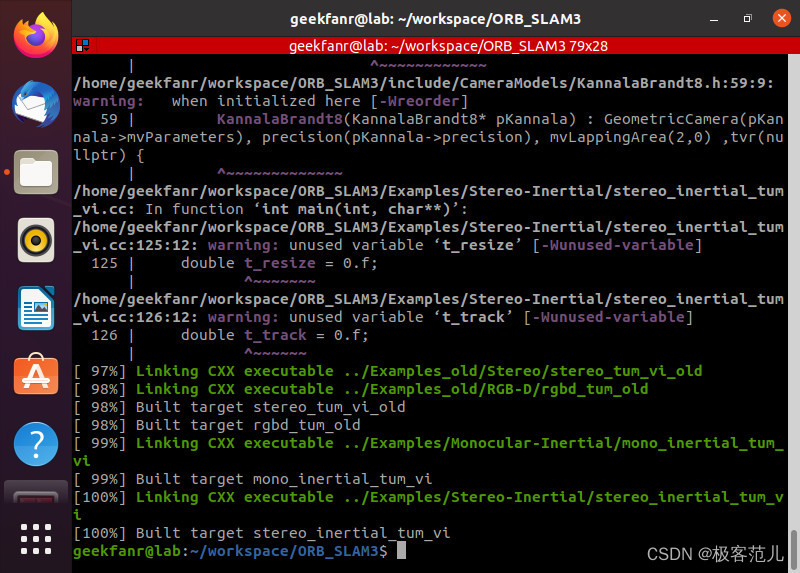

②编译ROS下ORB-SLAM3

cd ORB_SLAM3

chmod +x build_ros.sh

./build_ros.sh

五、ORB-SLAM3运行

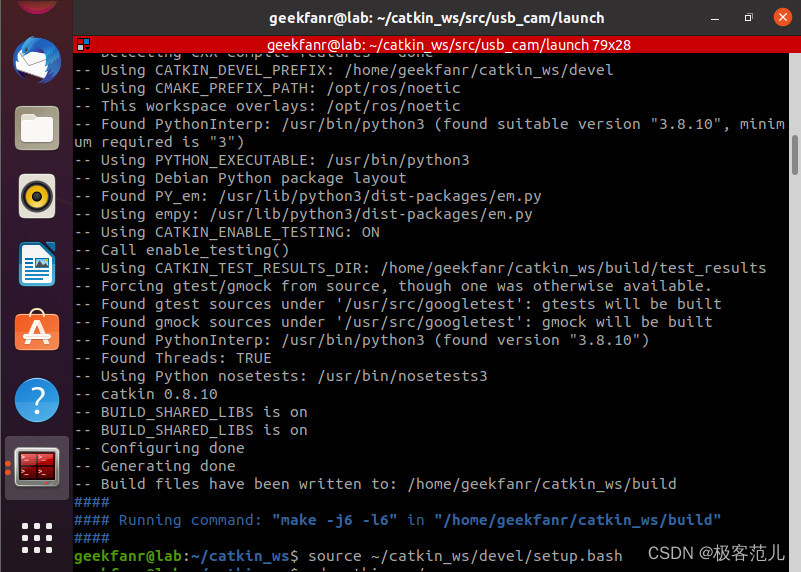

1、创建工作目录

mkdir -p ~/catkin_ws/src

cd ~/catkin_ws/src

catkin_init_workspace

cd ~/catkin_ws/

catkin_make

source ~/catkin_ws/devel/setup.bash

2、安装usb_cam

cd catkin_ws/src

git clone https://github.com/bosch-ros-pkg/usb_cam.git

cd ..

ctakin_make

source ./devel/setup.bash

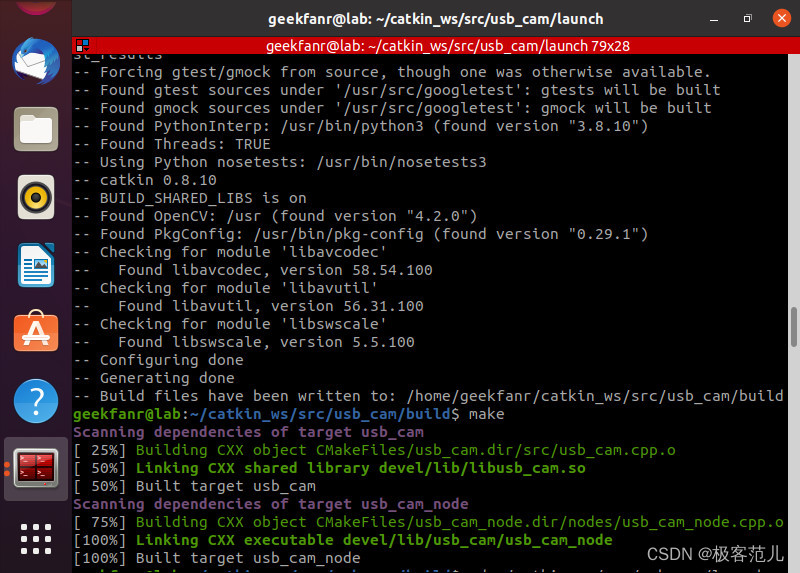

3、编译usb_cam

cd ~/catkin_ws/src/usb_cam

mkdir build

cd build

cmake ..

make

4、测试usb摄像头

打开新终端,运行ROS

roscore

cd ~/catkin_ws/

回到原终端运行launch文件

source devel/setup.bash

roslaunch usb_cam usb_cam-test.launch

这里注意,如果是虚拟机运行,需要把USB控制器的USB兼容性给为USB 3.1

5、相机标定

(1)安装v4l2

sudo apt-get install v4l-utils

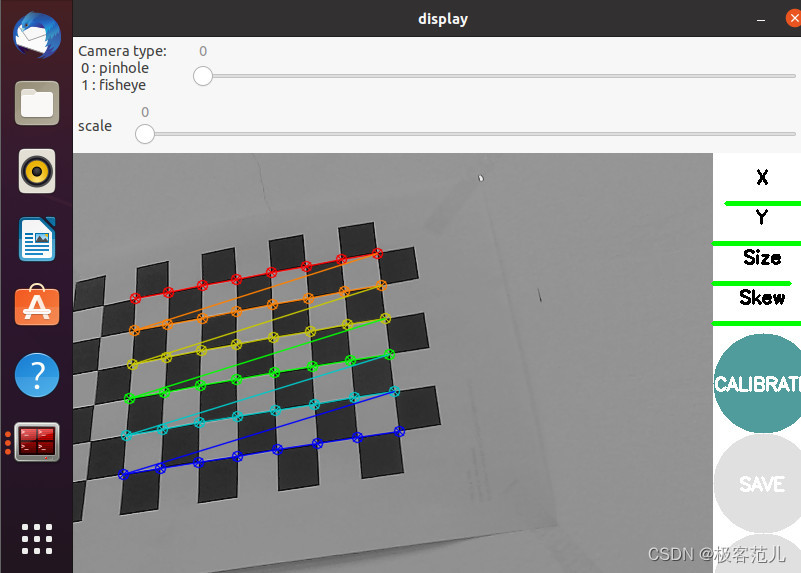

(2)张正友相机标定方法

在ROS中已经集成了对相机完成标定以及畸变矫正的整个流程,用起来非常方便。通常使用张正友相机标定方法,即利用平面坐标的单应性关系,流程简洁

(3)8×6的角点

黑白棋盘格是由9×7的黑白格组成,但是使用时仅仅用到内部交点数即8×6的角点

rosrun camera_calibration cameracalibrator.py –size 8×6 –square 0.03 image:=/usb_cam/image_raw

(4)保存标定结果

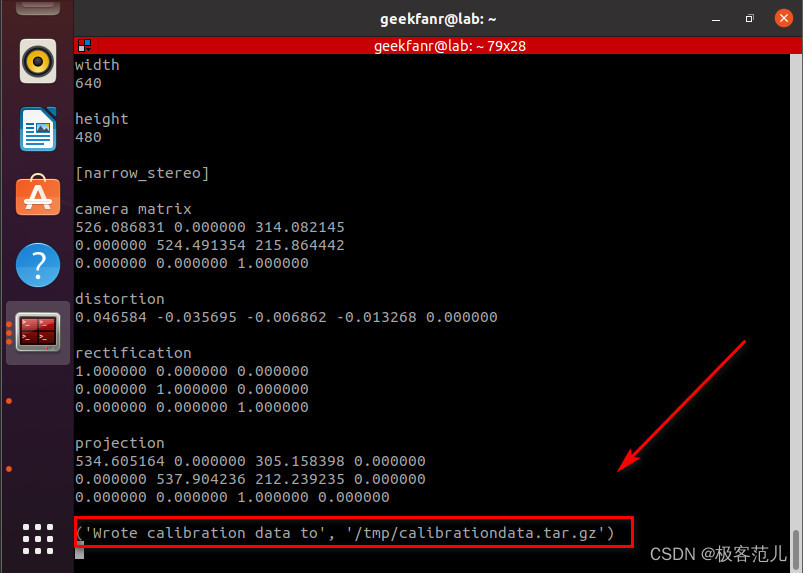

注意标定过程中左右,上下,前后,对角方向前后倾斜标定板,这样使得右边X,Y,Size,Skew变成绿色后,CALIBRATE按钮变为蓝色,然后点击(等上半分钟左右)变为下面三个按钮都可以点击,依次点击SAVE(保存)和COMMIT(提交)到相机配置文件中。即可将标定结果保存至本地。

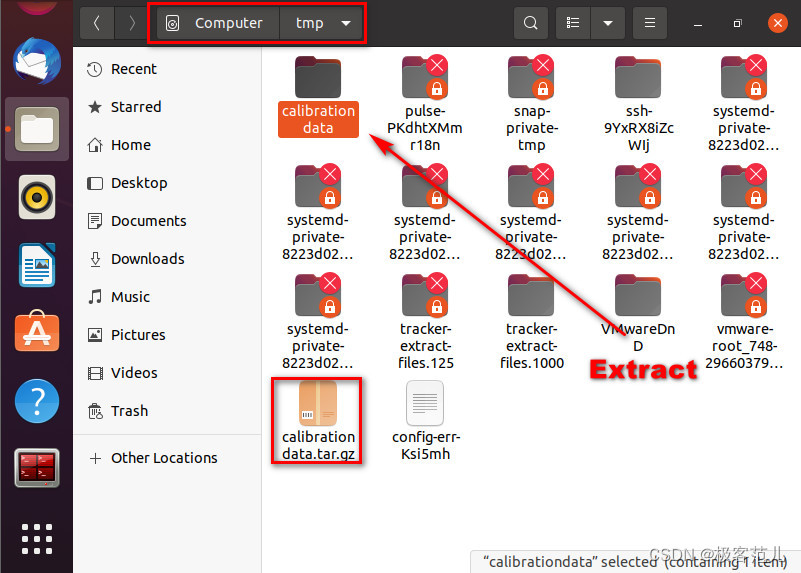

(5)标定结果文件calibrationdata.tar.gz

点击SAVE之后:(‘Wrote calibration data to’, ‘/tmp/calibrationdata.tar.gz’)

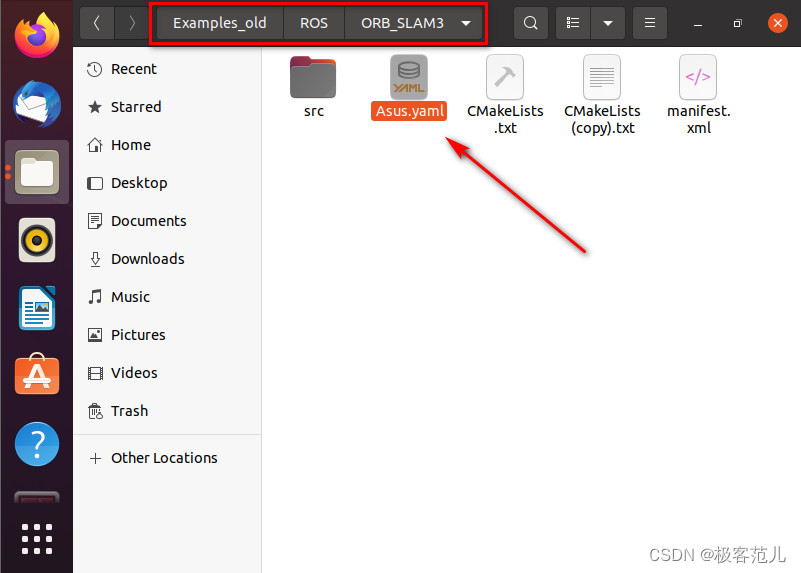

找到标定结果文件后,按照其数据修改Examples_Old/ROS/ORB_SLAM3目录下Asus.yaml

6、数据保存

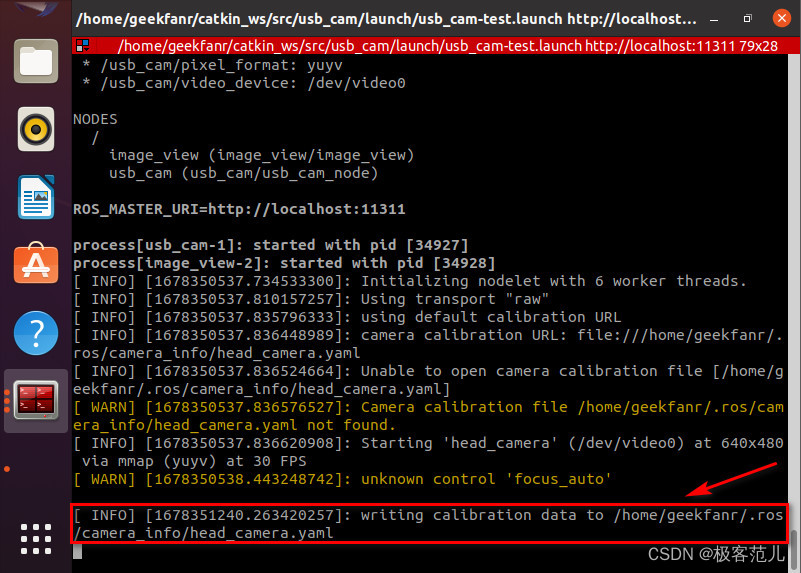

(1)点击save按钮,终端会打印生成文件及路径(计算机目录/tmp下)

(2)点击commit按钮,提交数据并退出程序,可以看到提示写入文件head_camera.yaml

writing calibration data to /home/geekfanr/.ros/camera_info/head_camera.yaml

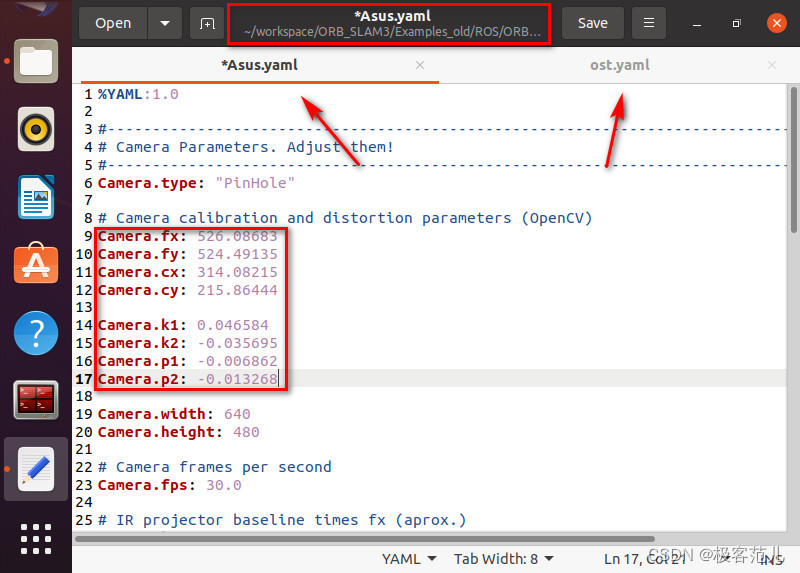

(3)修改Asus.yaml

找到标定结果文件后,按照其数据修改Examples_Old/ROS/ORB_SLAM3目录下Asus.yaml

(4)相机矩阵参数

由于OpenCV标定出来的文件,畸变参数好像和ORB-SLAM2使用的畸变参数略有不同,这里先不填,只填上相机矩阵的参数。

7、运行ROS下ORB-SLAM3

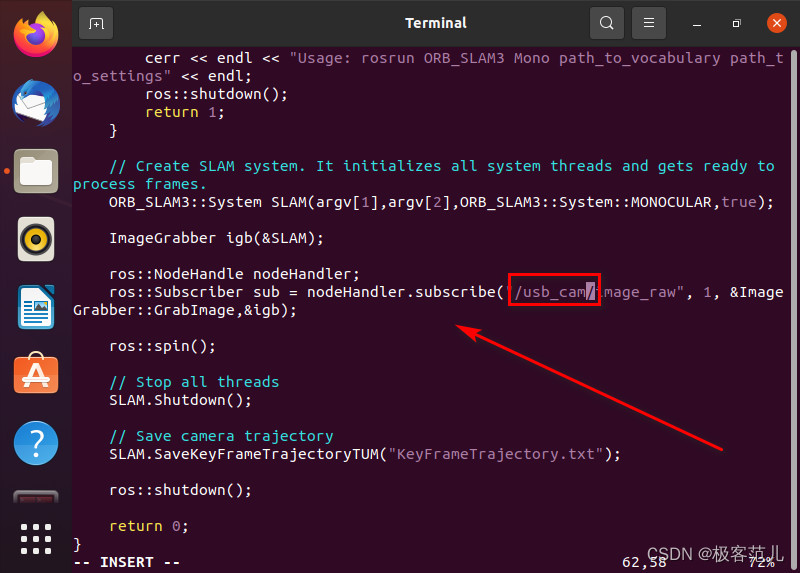

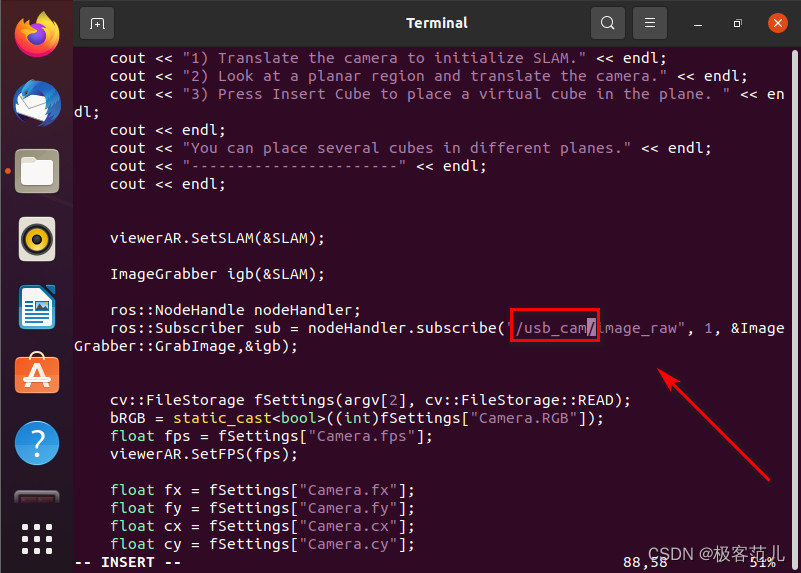

(1)接收话题名称更改

在运行程序之前,需要将ORB_SLAM3/Examples_Old/ROS/ORB_SLAM3/src/ros_mono.cc和ORB_SLAM3/Examples_Old/ROS/ORB_SLAM3/src/AR/ros_mono_ar.cc的接收话题名称更改

ros::NodeHandle nodeHandler;

ros::Subscriber sub = nodeHandler.subscribe("/usb_cam/image_raw", 1, &ImageGrabber::GrabImage,&igb);

ros::spin();

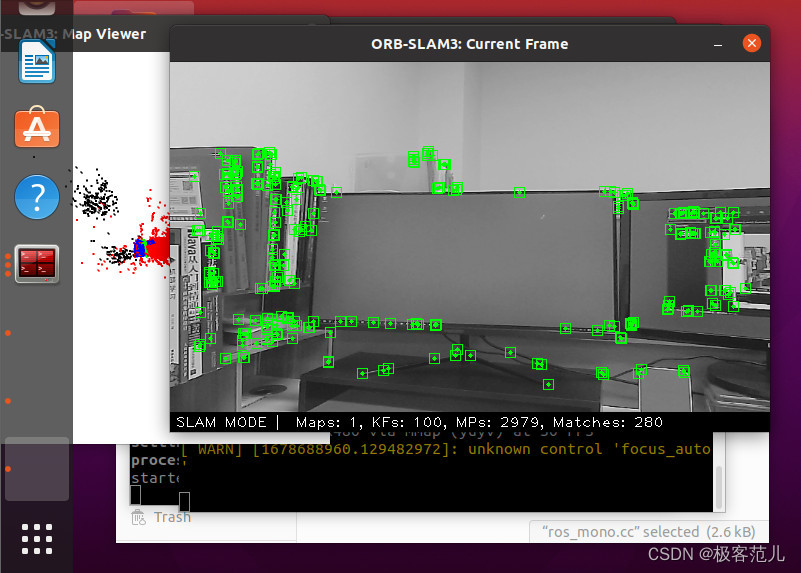

(2)执行单目实时usb_cam效果

rosrun ORB_SLAM3 Mono Vocabulary/ORBvoc.txt Examples/Monocular/EuRoC.yaml

六、总结

目前能够编译运行诸如此类的特征法SLAM开源项目了,虽然初学经历了各种尝试,但是熟悉了Linux系统和ROS系统的操作、cmake、shell、OpenCV等等,为了能够自己进行开发,还需要更深入的学习。

从开源项目入手,学习其理论和工程实现,是入门的捷径,只有看懂的代码才改的动代码,深入之后在其基础上做一定的改进。

工程实现只是科研的一部分,作为研究生,更重要的是抓住SLAM中的一个小问题,看看能否对现有的算法进行改进或者比较。所以还是要从论文出发,寻找灵感,去实现,并验证效果。