了解了LSTM原理后,一直搞不清Pytorch中input_size, hidden_size和output的size应该是什么,现整理一下

假设我现在有个时间序列,timestep=11, 每个timestep对应的时刻上特征维度是50, 那么input_size就是50

然后说hidden_size

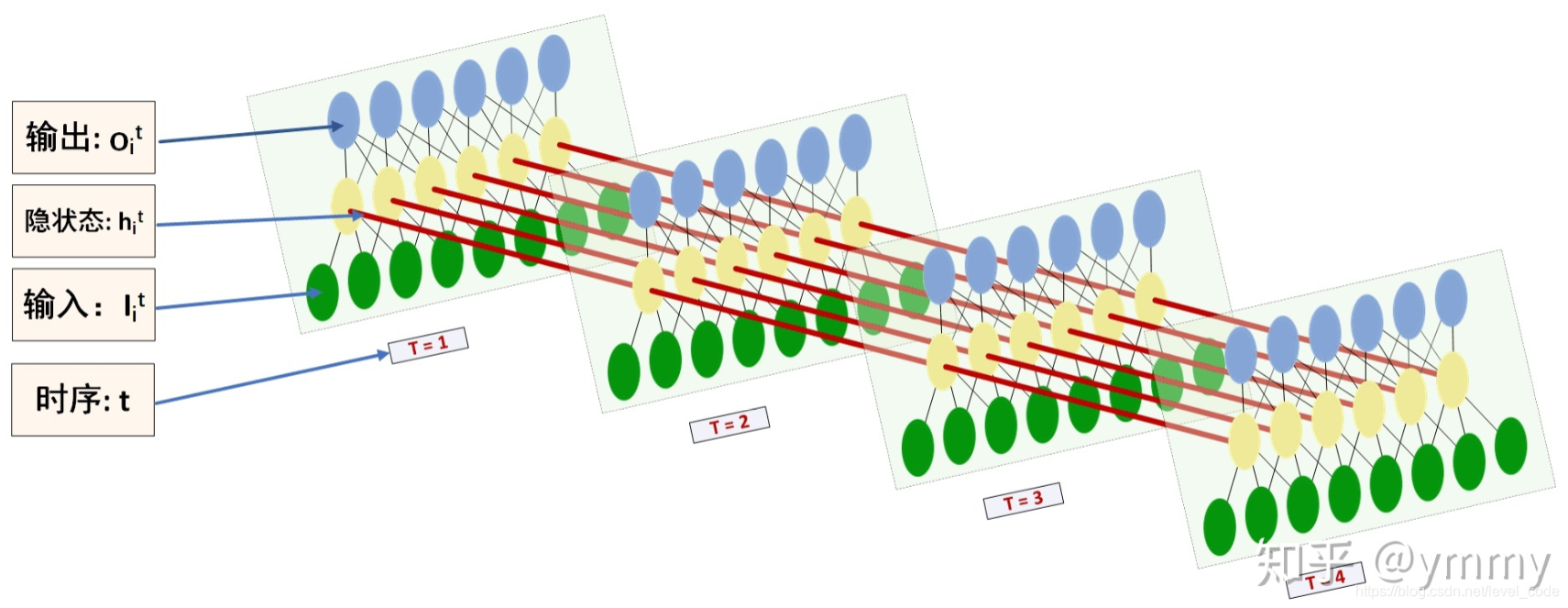

截知乎一个图比较好理解

hidden_size就是黄色圆圈,可以自己定义,假设现在定义hidden_size=64

那么output的size又是多少

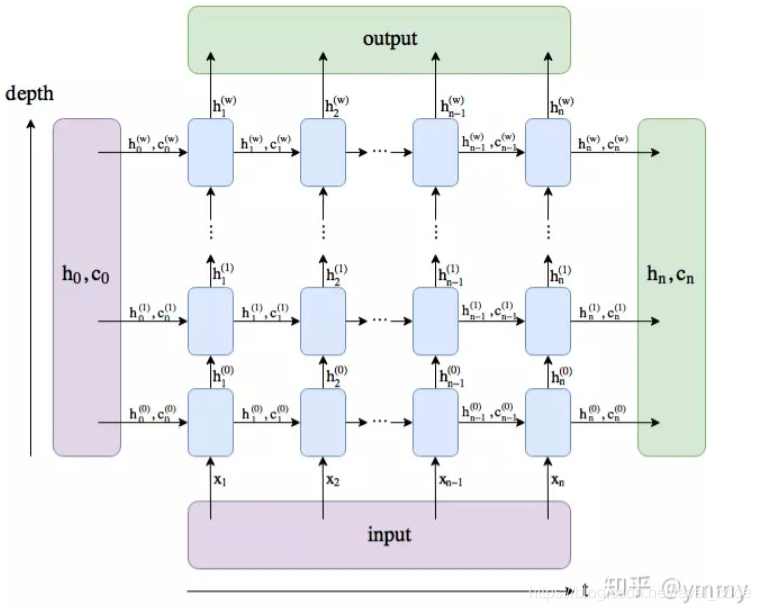

再截上面知乎的一个图

可以看到output是最后一层layer的hidden输出的组合,一层LSTM的话不用考虑layer,就是所有timestep上hidden_size的组合

假设现在batch_size=20, batch_first=True

那么output的size就是(batch, timestep, hidden_size)也就是(20,11,64)

验证一下:

class RNN(nn.Module):

def __init__(self):

super(RNN,self).__init__()

self.rnn = nn.LSTM(

input_size=50,

hidden_size=64,

num_layers=1,

batch_first=True,

)

self.out = nn.Linear(64,2) #最后时刻的hidden映射

def forward(self,x):

r_out, (h_n, h_c) = self.rnn(x, None)

print('lstm out size:')

print(r_out.shape) #这里输出output的size

out = self.out(r_out[:,-1,:]) #取最后一个时刻的hidden作输出

return out

输出:

lstm out size:

torch.Size([20, 11, 64])