C++与Java使用GDAL读写GDB矢量数据的效率问题、以及遇到的坑

一、引言

最近在写一个

GDB数据读并写到PG库的功能,一开始是使用Java调用GDAL来完成的,经过多线程、读写分离、队列等方式优化后速率还是不尽人意,在面临大量数据时耗时依旧很长。GDAL是C++开发的,于是便想到用C++来开发数据读取的功能,因为C++写入库太麻烦了,所以想到通过C++、Kafka再Java的方式,使用Kafka来作中间桥梁,C++读取数据往消息队列里面放,Java从队列里面获取数据再入库。虽然没有C++读取数据后直接入库效率高,但是我本人不是很会C++,更别提用C++写一个类似Mybatis的数据入库框架了。因为是第一次用C++版的GDAL,于是便作了效率验证,发现C++的效率居然没有Java高。

我在某乎上也提问过,原文 地址

二、代码

Java和C++都是使用的GDAL3.8.4,并且C++使用MSVC+CMake的方式编译Release版本,添加了优化编译参数/o2,代码以及结果如下:

Java:

import org.gdal.gdal.gdal;

import org.gdal.ogr.*;

public class Test04 {

public static void main(String[] args) {

long startTime = System.nanoTime();

gdal.AllRegister();

gdal.SetConfigOption("GDAL_FILENAME_IS_UTF8", "YES");

Driver driver = ogr.GetDriverByName("OpenFileGDB");

DataSource dataSource = driver.Open("F:\\dev_file\\test_file\\test.gdb");

int flag = 0;

for (int i = 0; i < dataSource.GetLayerCount(); i++) {

Layer layer = dataSource.GetLayer(i);

long l1 = layer.GetFeatureCount();

for (long l = 0; l < l1; l++) {

Feature feature = layer.GetNextFeature();

if (feature == null){

continue;

}

Geometry geometry = feature.GetGeometryRef();

//double area = geometry.GetArea();

//System.out.println("图层:" + i + "的第:" + l + "; 共:" + l1);

System.out.println("====== 图层:" + i + " ---矢量数据 ---> "

+ feature.GetGeometryRef().ExportToJson());

flag++;

}

}

System.out.println("共读取到:" + flag);

long endTime = System.nanoTime();

long duration = (endTime - startTime); // 单位为纳秒

System.out.println("耗时: " + duration / 1000000 + "毫秒");

}

}

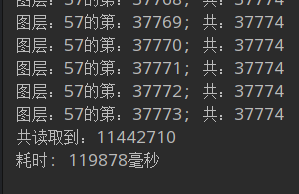

运行结果:

C++:

#include <iostream>

#include <chrono>

#include "gdal_priv.h"

#include "ogrsf_frmts.h"

using namespace std;

using namespace std::chrono;

int main() {

auto start = high_resolution_clock::now();

GDALAllRegister();

CPLSetConfigOption("GDAL_FILENAME_IS_UTF8", "YES");

const char *driver[] = {"OpenFileGDB", nullptr};

auto *data_set = static_cast<GDALDataset*>(GDALOpenEx(

R"(F:\dev_file\test_file\test.gdb)",

GDAL_OF_VECTOR, driver,

nullptr, nullptr));

if (data_set == nullptr){

cout << "数据源空" << endl;

exit(-1);

}

int total = 0;

int layer_count = data_set->GetLayerCount();

for (int i = 0; i < layer_count; ++i) {

auto *layer = static_cast<OGRLayer*>(data_set->GetLayer(i));

if (layer == nullptr){

cout << "图层为空" << endl;

continue;

}

layer->ResetReading();

int f = 0;

int *flag = &f;

OGRFeature *feature;

GIntBig feature_count = layer->GetFeatureCount();

while ((feature = layer->GetNextFeature()) != nullptr){

auto *geom = static_cast<OGRGeometry*>(feature->GetGeometryRef());

if (geom == nullptr){

cout << "矢量数据为空" << endl;

continue;

}

auto polygon = (OGRPolygon*)(geom);

//const double area = polygon->get_Area();

//cout << "图层:" << i << "的第:" << *flag << "; 共:" << feature_count << endl;

cout << "矢量数据:" << geom->exportToJson() << endl;

(*flag)++;

OGRFeature::DestroyFeature(feature);

}

total = total + *flag;

}

cout << "共读取到:" << total << endl;

GDALClose(data_set);

auto stop = high_resolution_clock::now();

auto duration = duration_cast<microseconds>(stop - start);

cout << "耗时: " << duration.count() / 1000 << " 毫秒" << endl;

return 0;

}

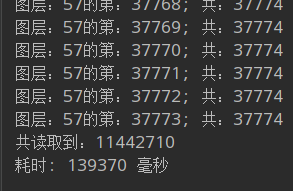

运行结果:

一开始我以为是驱动的问题,因为

C++在读取数据时用的是GDALOpenEx()函数,这个函数的第三个参数需要填一个驱动信息,但是也可以不填,如果不填GDAL就会自动获取适合数据的驱动,我手动指定了,发现效率并未提高。

再后来我以为是内存管理的问题,优化了读取过程中的指针产生以及销毁,发现效率并未有任何提升。

三、总结

经过对比,发现

C++的效率慢了不少,并且网上也没有前例,根本就无从下手。

理论上,

Java运行在JVM上,并且调用GDAL读取数据存在频繁的跨语言调用,它的效率应该比C++的更低才对,但是现实结果与理论相悖,确实很让人摸不着头脑。

后来经过很多的摸索后,我将控制台打印输出去掉了,并且替换为了实时计算每个

Feature的矢量的面积,使用函数:Geometry.GetArea(),运行最终发现C++的效率大幅度提升,是Java的一倍多。

通过这个结果,我们可以总结到,如果要比较两个语言的效率,尽量不要涉及到

IO操作,控制台打印就是一个耗时的IO操作。此外,根据这个结果可以认为C++的控制台打印效率没有Java的高。

还有一个让我疑惑的是,

Java在去掉控制台打印后,效率反而下降了,这个暂时没有搞清楚,后续有空再了解吧。

这个问题确实困扰了我很久,看起来也是一个不起眼的问题,希望你们别再遇到类似我的这种低级的问题。