背景介绍

在国内众多开源大模型中,上海人工智能实验室开源的书生浦语系列绝对占有一席之地。可能有很多同学还记得年初央视播出的首部人工智能生成动画片《千秋诗颂》,就是上海人工智能实验室的“书生筑梦”大模型制作的。具体可以查看以下新闻报道

国产文生视频大模型“筑梦”亮相 助央视制作AI动画片《千秋诗颂》

筑梦大模型是文生图大模型,我们今天介绍的重点是大语言模型,所以重点在书生浦语上。

正好我最近报名的书生·浦语大模型实战营需要写学习笔记。这篇文章既可以当做学习笔记,也可以给大家详细的介绍一下书生浦语系列产品。

书生浦语简介

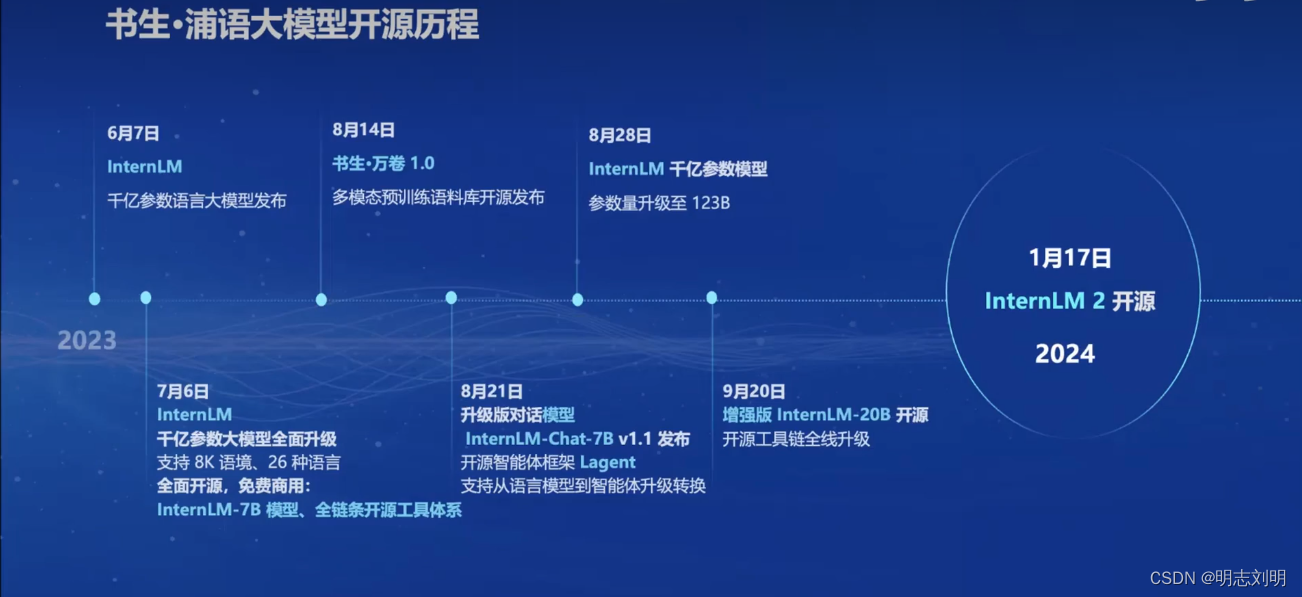

书生浦语大模型最早发布于2023年6月7日,英文名称为internLM,在2024年1月7日升级为internLM2,模型更强大,而且全面开源,免费商用。

跟智谱AI的ChatGLM和阿里的通义千问不一样的是,书生浦语没有面向大众提供体验网站和APP,但是却给想学习大模型的开发者提供了实战营和算力支持。实战营是滚动开营,我报名的是第二期,有算力支持可以动手实操,真的很棒。

列一下internLM2的学习资源,大家根据需要学习,当然更建议报名实战营,既可以找小伙伴共学,也能动手实操。

- 书生浦语官网(官网只是简单介绍,没有太多内容)

- 书生浦语GitHub仓库

- 书生·浦语大模型实战营(第二期)学习资料 (这个超级有用)

- 谱源内容平台(这个也超级有用,类似于huggingface和modelscope,有很多模型、数据集和应用)

报名实战营可以跳到本文末尾,扫海报上的二维码报名

internLM2的体系介绍

在参数规模上,internLM2分2个版本:

- 7B,70亿参数量,属于轻量型模型,适合算力不高的设备,但性能是不错的

- 20B,200亿参数量,参数量更高,综合性能更强。

在训练程度上,internLM2提供了3个版本:

- internLM2,标准版本,综合性能优秀,开发者在大部分应用开发中都可以选择这个标准版本;

- internLM2 Base,更底层的模型基座,标准版本就是基于Base继续训练出来的。相对于标准版本,Base版本可塑性更强,适合从底层开发的情形;

- internLM2-Chat,对话聊天版,相当于chatGPT,针对对话情形进行了专门训练和优化,适合开发聊天应用,更专业的说法叫做有很好的指令遵循能力。

internLM2的特点

关于internLM2的性能评比数据我就不说了,说一些大家可以理解的亮点和优势。

- 具有20万Token的超长上下文,相当于1/4本红楼梦喂给大模型学习,然后想问啥就问啥。

- 推理和数学能力超强,用internLM2构建智能客服、个人助理,都会有很好的体验;

- 代码能力提升,不懂的代码发给internLM2,他能进行逐行解释,特别适合我们程序员群体;

- 工具调用能力升级,可构建复杂智能体;智能体最近超级火,基本各个大厂都推出了智能体构建平台,用internLM2构建好的智能体会有很大的商业价值。

全链条体系介绍

上图显示了书生浦语数据、预训练、微调、部署、评测、应用6个阶段。在每个阶段,internLM2系列都提供了好用的工具或产品,由此构成了完整的开源开放体系。我觉得这是书生浦语系列最出色的部分。

数据准备阶段

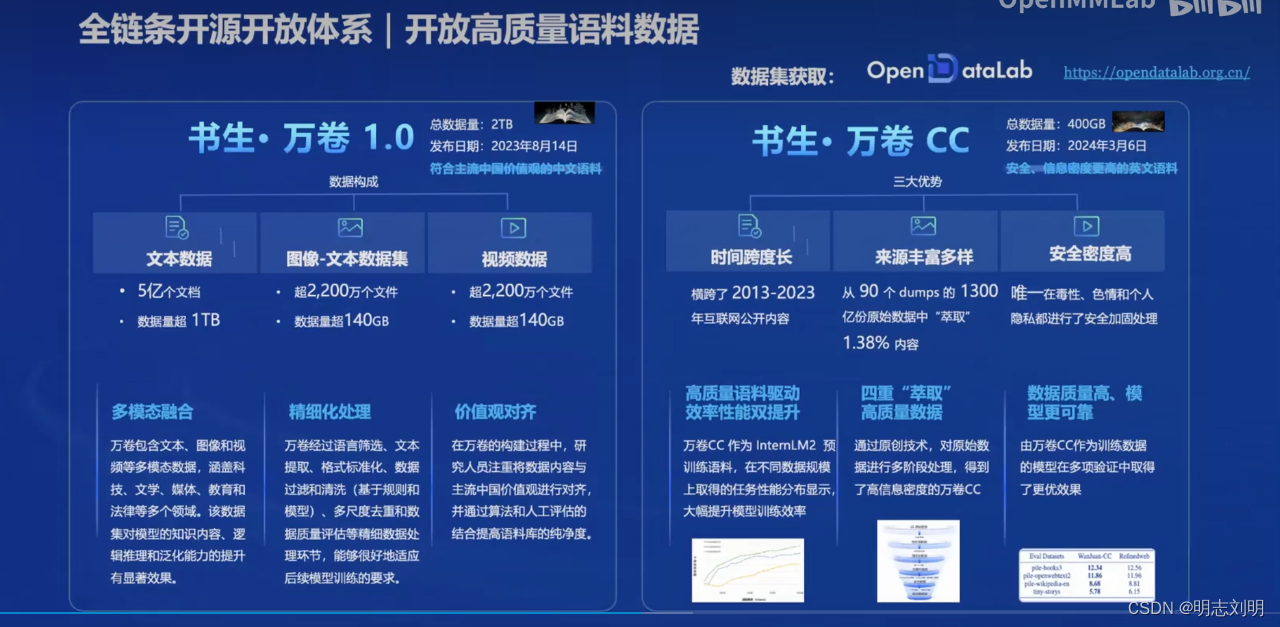

书生浦语提供了中文和英文2个版本的高质量语料数据库,中文语料数据库叫做书生万卷1.0,总数据量2TB,相当之大,英文语料数据库叫做书生万卷CC,总数据量400GB.两个数据库都是开源的,获取地址如下:

书生万卷数据获取连接

预训练阶段

书生浦语开源了预训练框架internEvo,这个预训练框架支持从8卡到千卡训练,据官方数据,千卡加速效率达到92%。这是个很厉害的数据,同时也是个巨烧钱的过程。

我没做过这种预训练,所以也没过多的关注interEvo,有钱的大佬可以多关注一下。

模型微调阶段

不同于预训练,微调是很多普通开发者都会涉及到的过程。微调包含增量续训和有监督微调两种方式;增量续训适合让模型学习专业领域新知识,有监督微调适合开发对话式应用。

书生浦语开源了xTuner微调框架。xTuner很火,百度搜一下,有很多教程,主要是因为xTuner作为微调工具真的好用,深受开发者喜欢。

xTuner具有以下特色:

- 适用性广,不仅能微调书生浦语大模型,还能微调Llama,Qwen,BaiChuan,ChatGLM等众多流行的开源大模型;支持加载HugggingFace、ModelScope模型和数据集;

- 多种微调算法,能覆盖各类SFT场景,只需要配置一下就可以了;

- 自动优化加速,能很大程度节省算力,让开发者省时省力还省钱;

- 支持硬件多,比如RTX 4060就可以跑起来,如果有土豪大佬可以用4090,。据说,最低能支持到RTX2080.

关于xTuner的使用教程,如果后期有时间,我也会写一篇文章介绍,如果等不及的小伙伴,自己百度搜索或者报名实训营吧。

模型部署阶段

模型部署主要是为了生产阶段的使用,多数开发者关注的是模型的轻量化,以便能节省资源消耗,还有部署的便捷性。书生浦语提供了LMDeploy部署框架,可以很好的解决这两个问题。

在轻量化上,LMDeploy支持4bit权重优化和8bit的k/v;在服务方式上,LMDeploy支持通过openai-server和gradio等方式提供RESTful服务。

模型评测阶段

书生浦语提供了模型评测体系司南,英文名称OpenCompass。司南主要包括3个部分:

- CompassRank:一个中立的性能评价榜单

- CompassKit:一个完整的大模型评测工具链,可用于数据污染检查、长文本能力评测、中英双语主观能力评测

- CompassHub:共建共享的大模型评测社区

我作为一个大模型应用开发者,平时更多的是关注第三方发布的榜单和评测结果,真正自己动手评测很少,相信很多开发者跟我一样。如果有更深入的大模型开发需求,就会用到评测工具了。需要的同学可以自己学习

应用开发阶段

大模型的应用开发是个很值得关注的领域。上文提到过,智能体最近非常非常火,智能体就是大模型开发的主要方式。

做大模型应用开发,很多开发者会使用LangChain。其实书生浦语也提供了很好用的智能体开发框架LAgent.

LAgent提供了便捷的开发方式,而且支持多种大语言模型,像上面提到的开源Llama,或者不开源的GPT4等等都可以用LAgent开发。并且LAgeng还支持丰富的工具,比如文生图,文生语音等等。

除了LAgent,书生浦语还提供了一个更牛掰的智能体开发工具箱AgentLego.AgentLego支持多模特,集成大量智能体开发工具。这个学的好,赚钱少不了啊!

总结

从上面介绍可以看到,书生浦语的全链条开放体系很全,且都是开源产品,可以免费商用。如果能把这整个体系和工具都学透,基本就了解了大模型开发的全貌。现在AI技术已在全社会掀起热潮,大家都应该或多或少的学习AI、了解AI.书生浦语的全链条开放体系,正好给了我们一个学习AI的好机会。

实战营报名

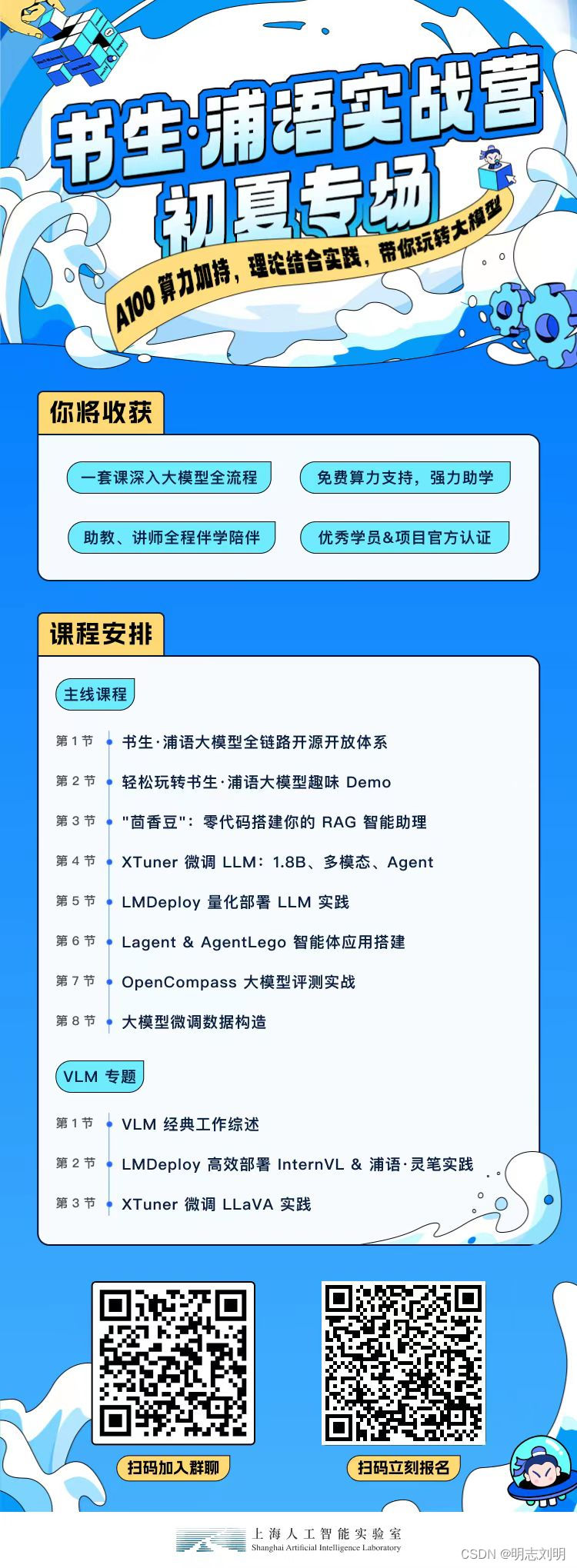

下面海报上列出了实战营的课程安排,是录播课程,随时随地可学,不用担心时间不匹配。如果想报名扫码填表即可,全程免费,机会不可错过。