要使用 Ollama 和 Chatbox 实现 DeepSeek R1 的本地 AI 助手,你需要完成以下几个步骤。

这个过程包括

-

安装 Ollama

-

配置 DeepSeek R1 模型

-

使用 Chatbox 作为前端与模型进行交互。

1. 安装 Ollama

Ollama 是一个用于本地运行大型语言模型的工具。

可以通过以下步骤安装 Ollama:

1.1 下载 Ollama

- 访问 Ollama 的 GitHub 仓库 或官方网站,下载适合你操作系统的安装包。

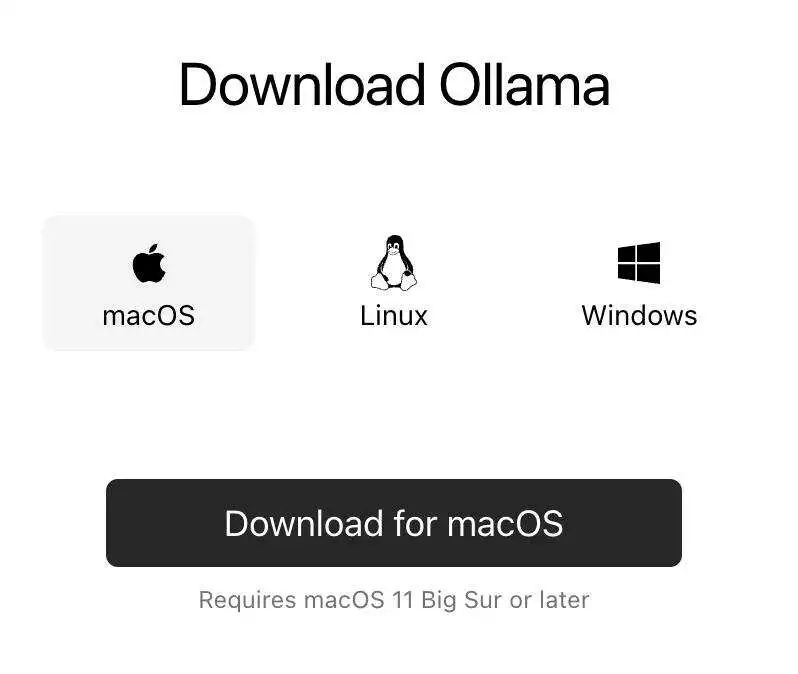

1.2 安装 Ollama

-

** Windows ** : 双击下载的安装包,按照提示完成安装。

-

** macOS ** : 将下载的 .dmg 文件拖到 Applications 文件夹中。

- ** Linux ** : 使用包管理器或直接运行下载的安装脚本。

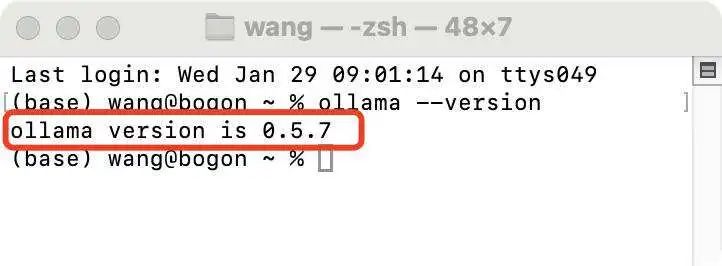

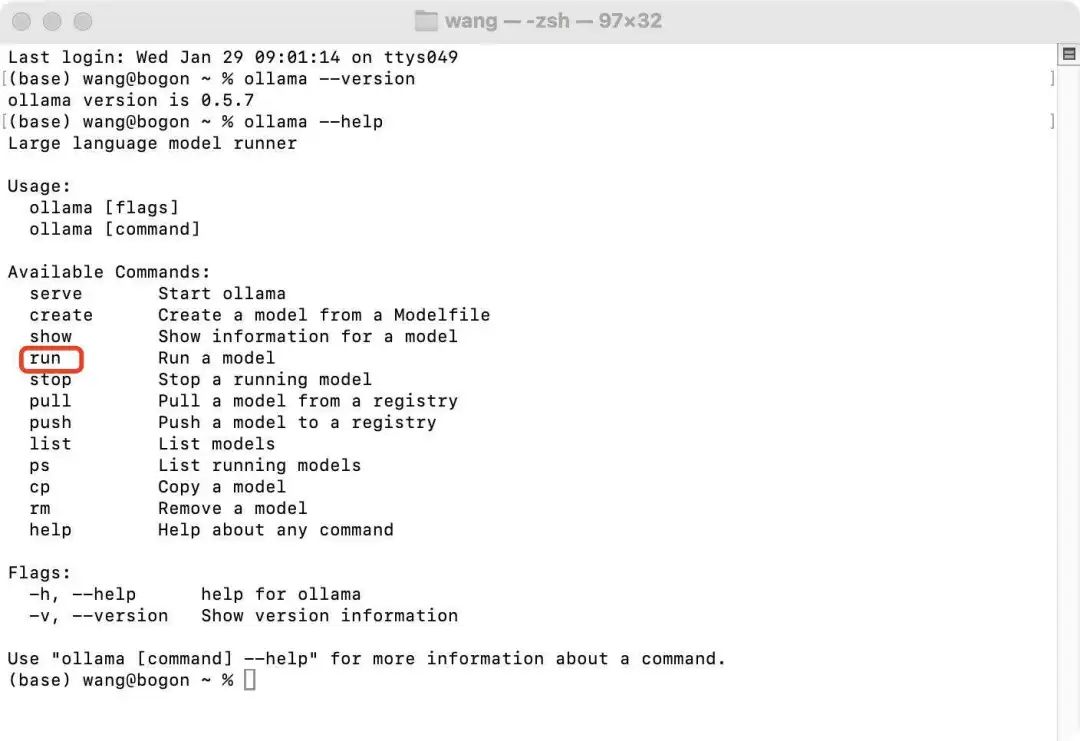

1.3 验证安装

- 打开终端或命令提示符,输入 ollama --version,确保安装成功。

1.4 Ollama常用命令

2. 配置 DeepSeek R1 模型

2.1 下载 DeepSeek R1 模型

-

从 Ollama的官方网站下载 DeepSeek R1 模型文件。

ollama run deepseek-r1:7b

2.2 启动模型

-

启动和下载模型是同一个命令,如果没有下载过的新模型会直接下载,以及下载过的则直接启动。

ollama run deepseek-r1:7b

3. 安装和配置 Chatbox

Chatbox 是一个用于与本地 AI 模型交互的前端工具。

可以通过以下步骤安装和配置 Chatbox:

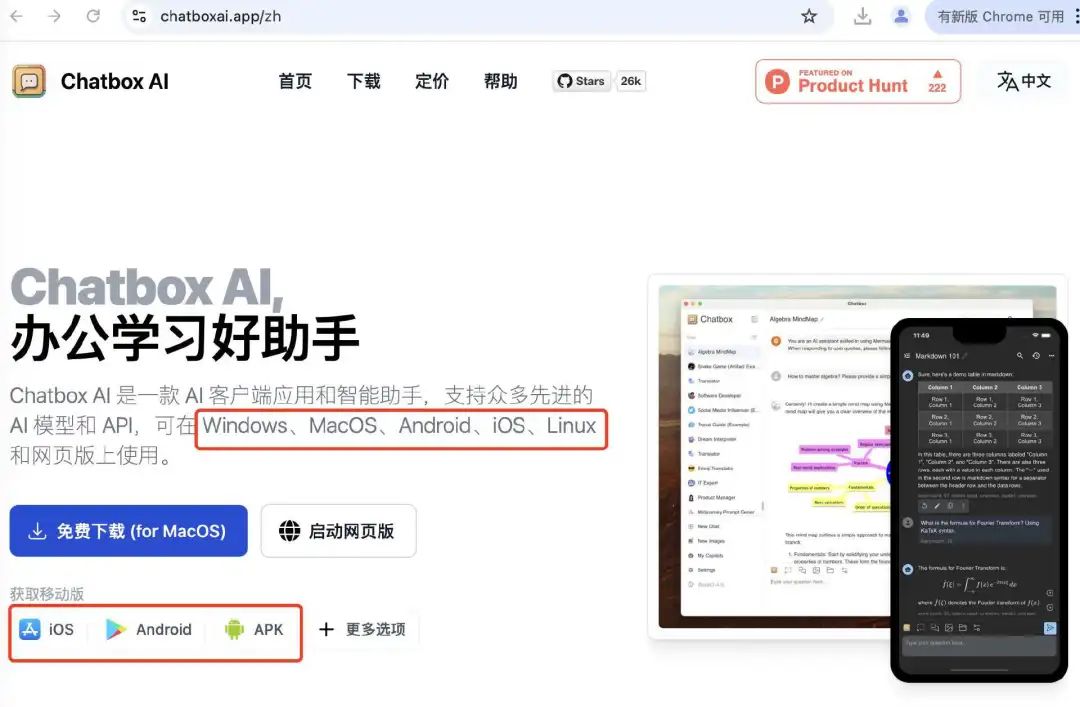

3.1 下载 Chatbox

- 访问 Chatbox 的 https://chatboxai.app/zh 官方网站,下载适合你操作系统的安装包。

3.2 安装 Chatbox

-

** Windows ** : 双击下载的安装包,按照提示完成安装。

-

** macOS ** : 将下载的 .dmg 文件拖到 Applications 文件夹中。

- ** Linux ** : 使用包管理器或直接运行下载的安装脚本。

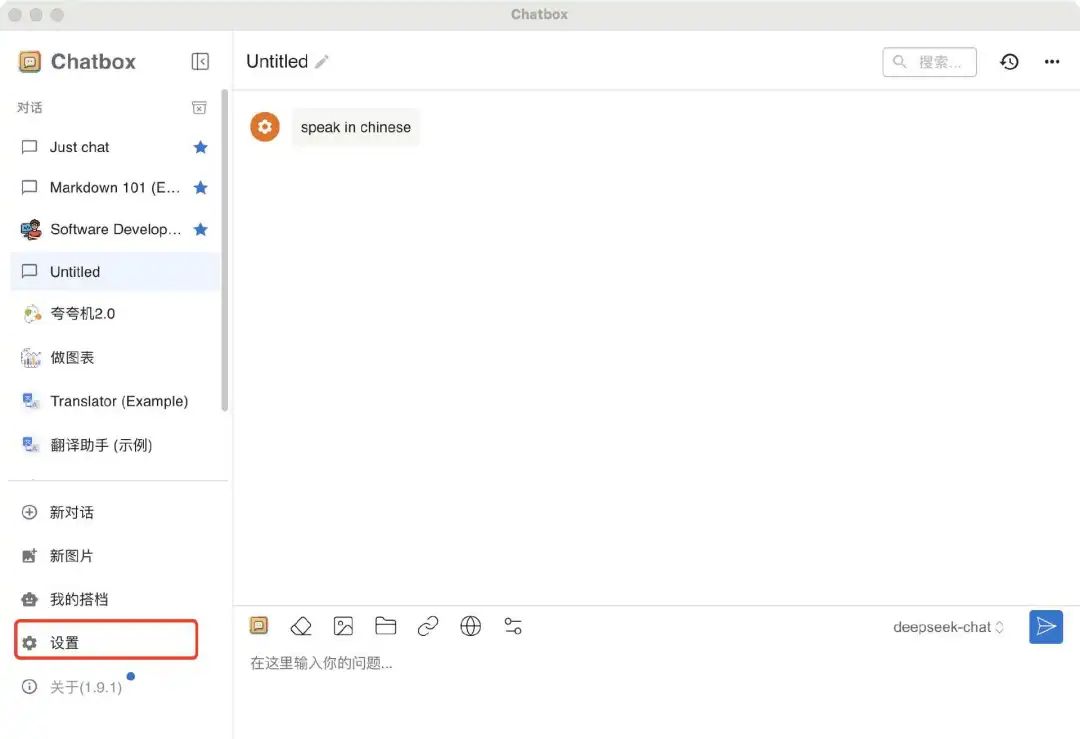

3.3 配置 Chatbox

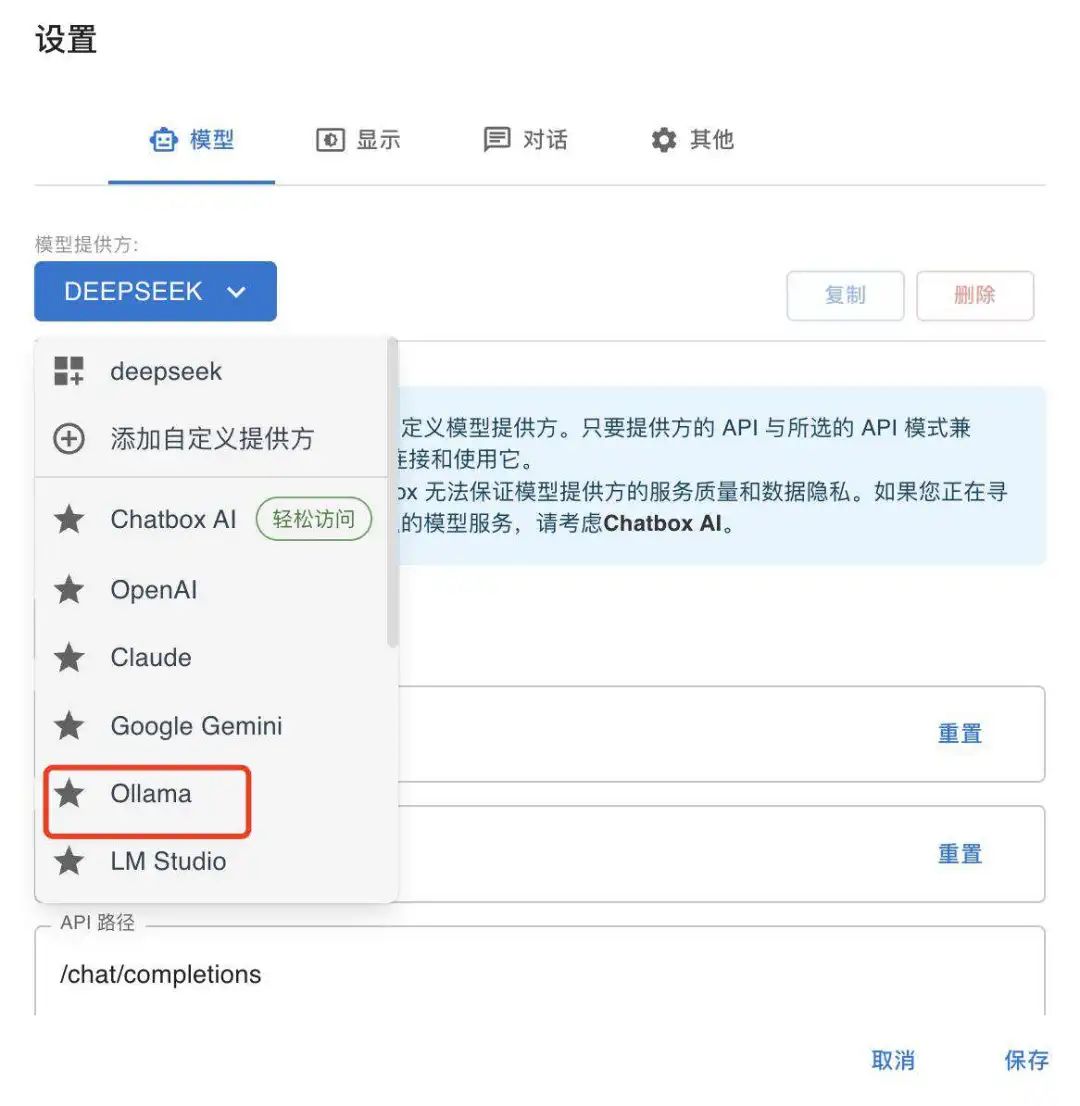

- 打开 Chatbox,进入设置页面。

- 在 Model 部分,选择 Ollama。

-

输入 Ollama 服务器的地址(通常是 http://127.0.0.1:11434 )。

-

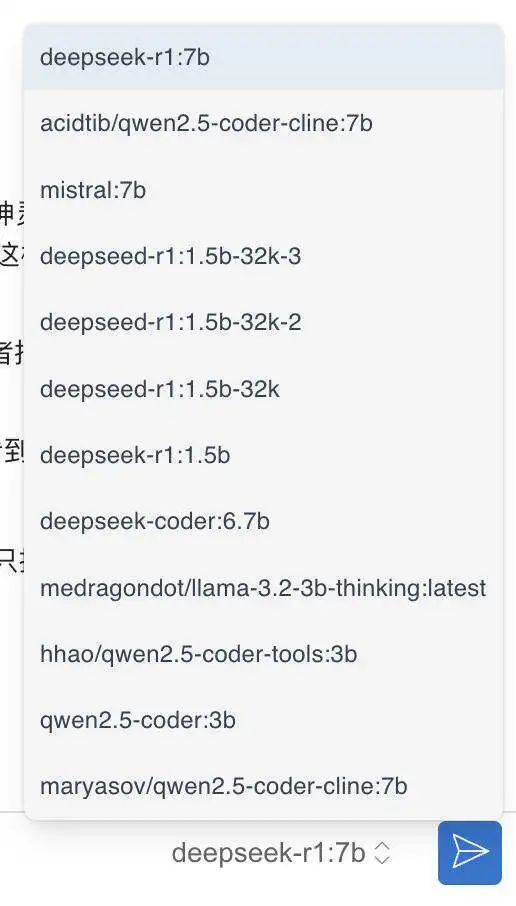

选择 DeepSeek R1 7b作为模型。

4. 使用 Chatbox 与 DeepSeek R1 交互

-

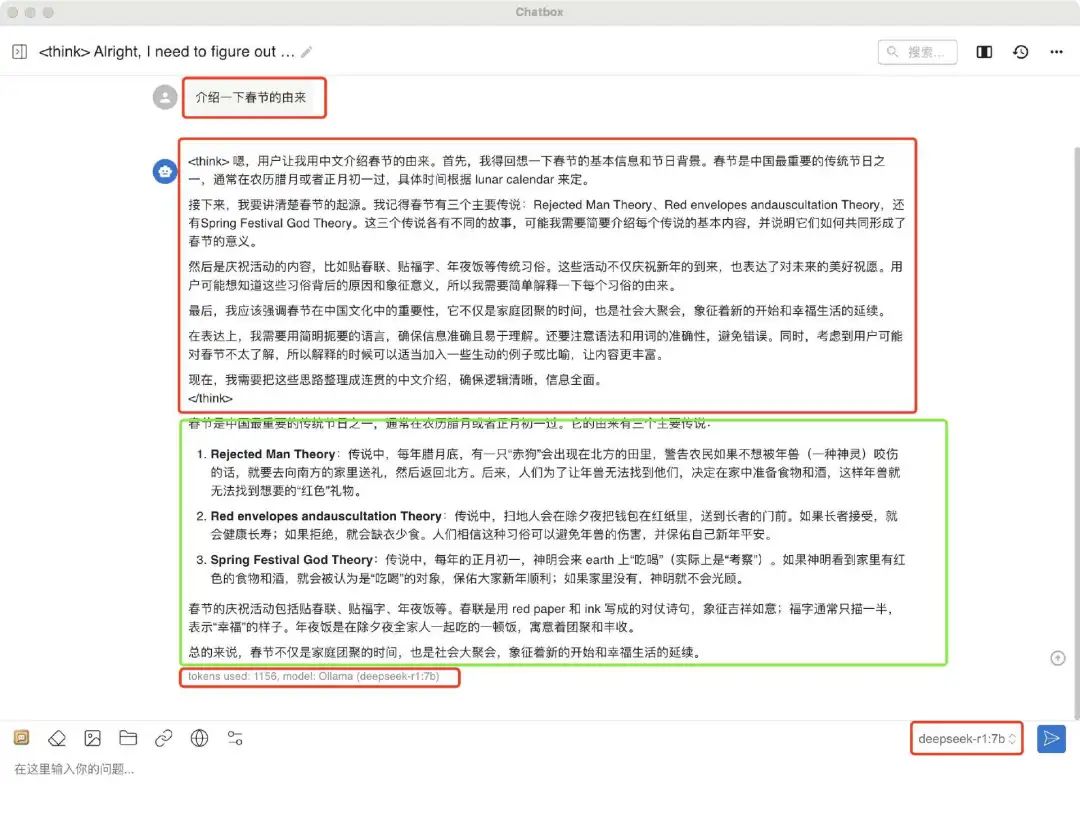

打开 Chatbox,输入你的问题或指令,如:“介绍一下春节的由来”

-

Chatbox 会将请求发送到 Ollama 服务器

-

首先显示 DeepSeek R1 的思考思路,在think标签里面,这个不是deepseek真正的回复。

-

think之外的才是deepseek给我们的答案。包括我们使用的模型和花费的tockens。

5. 优化和调试

- ** 性能优化 ** : 如果你的硬件资源有限,可以尝试调整 Ollama 的加载模型的大小,减少模型的资源占用。Ollama安装过的模型都可以使用的。

6. 其他注意事项

-

** 模型更新 ** : 定期检查模型的更新,确保你使用的是最新版本。

-

** 安全性 ** : 确保你的本地服务器和模型文件不会被未经授权的访问。

通过以上步骤,你应该能够成功在本地部署 DeepSeek R1 模型,并使用 Chatbox 作为前端与其进行交互。