最近在做自然语言处理的数据预处理部分——实体词,提取、抓取的数据集中包含中英文,那么我们只需要英文,不需要中文,于是就写了一个简单的脚本实现txt文本数据分类。

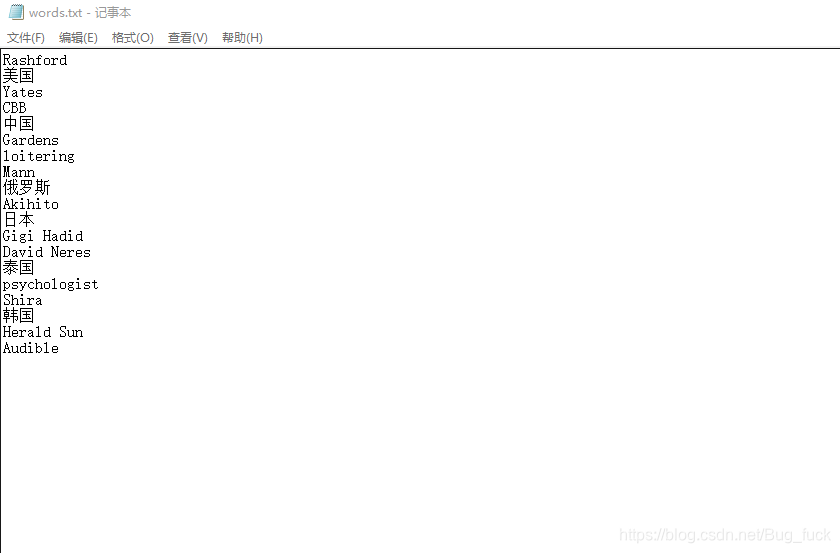

原数据如下(为了写这篇博客特意只提取了数据的一部分):

代码如下:

file_open = open(r'C:\Users\Administrator\Desktop\words.txt', 'r', encoding='gbk')

lines = file_open.readlines()

A = set()

B = set()

for line in lines:

B.add(line)

for char in line:

if u'\u4e00' <= char <= u'\u9fff':

A.add(line)

else:

break

with open('C:/Users/Administrator/Desktop/2.txt', 'w+') as f:

for stu in A:

print(stu)

f.write("".join(stu))

C = B - A

with open('C:/Users/Administrator/Desktop/3.txt', 'w+') as t:

for stb in C:

print(stb)

t.write("".join(stb))

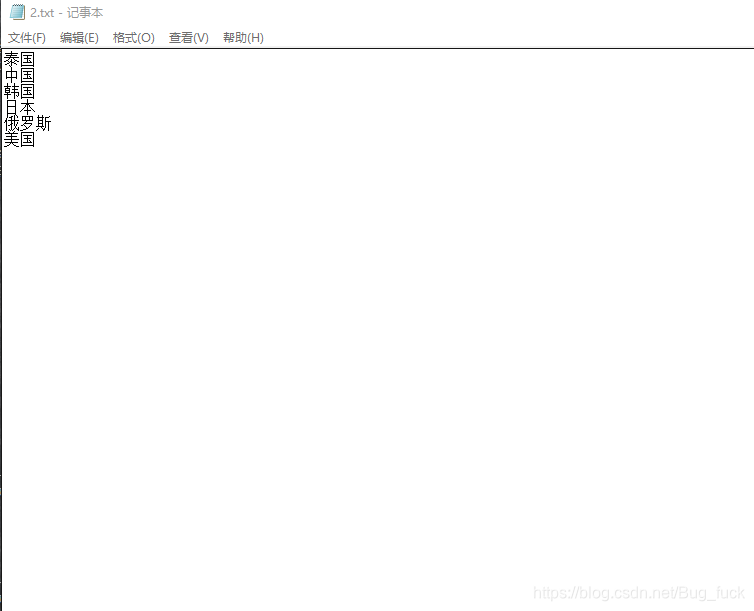

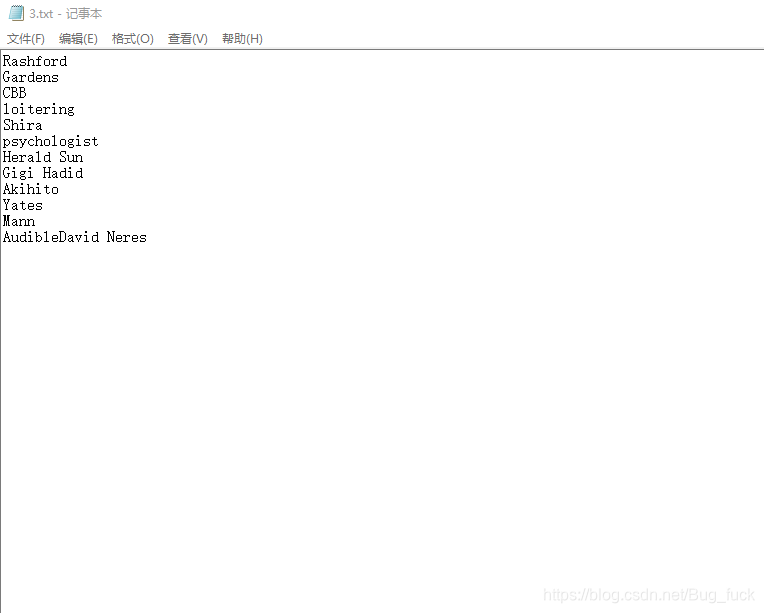

分类结果如下:

1、中文文本

2、英文文本