近年来,随着人工智能技术飞速发展,大语言模型(LLM)和多模态大语言模型(MLLM)成为了炙手可热的明星。它们不仅能处理文字,还能看图识字,简直是“全能选手”。这种能力得益于模型中加入的“视觉编码器”和“特征投影仪”,就好比给大脑装上了“眼睛”和“理解工具”。不过,模型越大,就越像个贪吃的怪兽,耗费大量资源,让使用它的人直呼“吃不消”。所以,如何让这些模型既聪明又省钱,成了大家绞尽脑汁的挑战。

根据“缩放定律”,模型越大,通常表现越好,但这也意味着更高的资源投入。于是,大家开始想办法“瘦身”,推出了轻量版的大语言模型和小型的多模态模型(s-MLLM),既能满足需求,又不那么“烧钱”。通过改进模型结构、用知识蒸馏和压缩技术“瘦身塑形”,这些模型依然保持着不错的表现力。加上预训练和监督微调的双重“训练课程”,模型在复杂的任务中也表现得游刃有余。

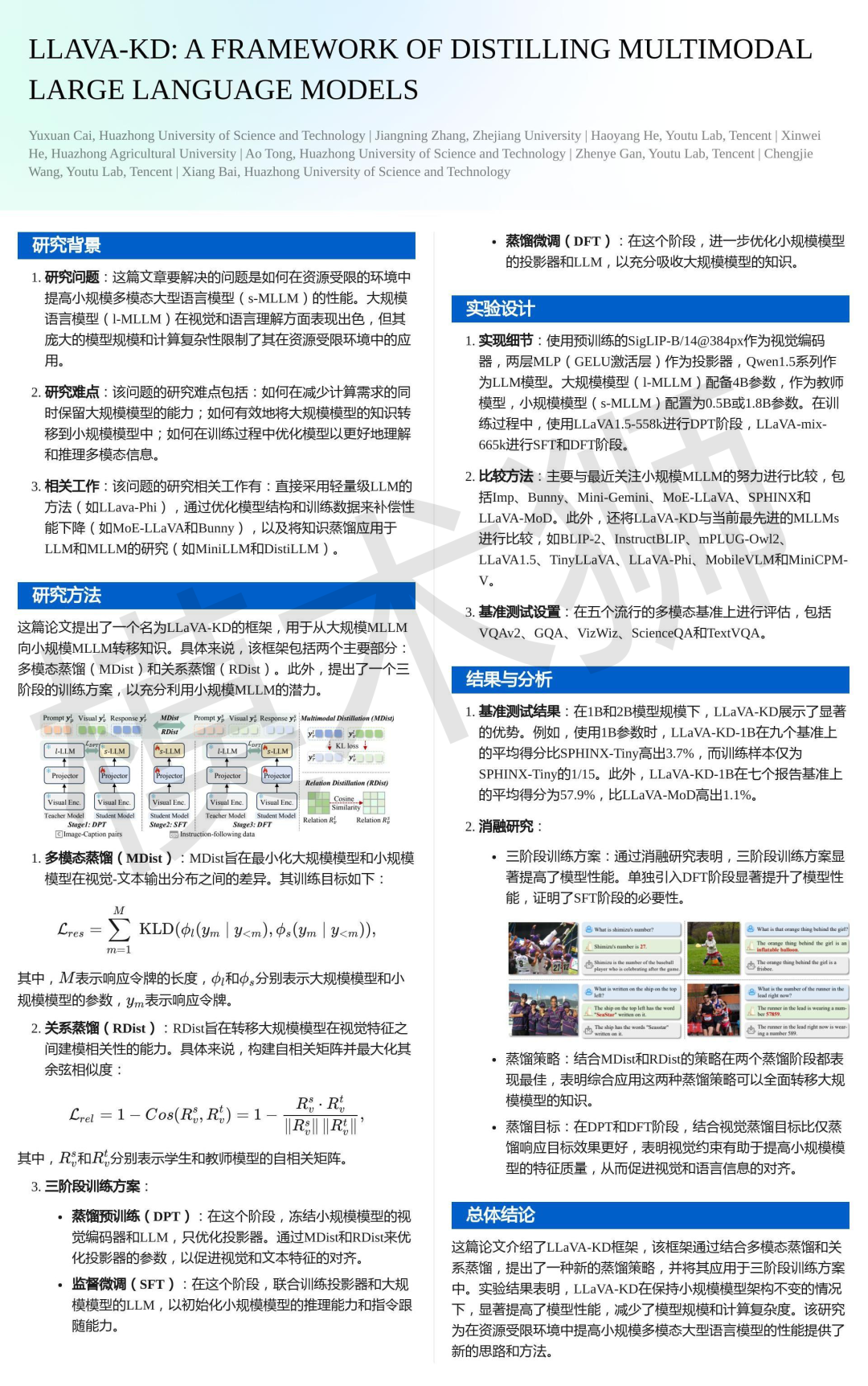

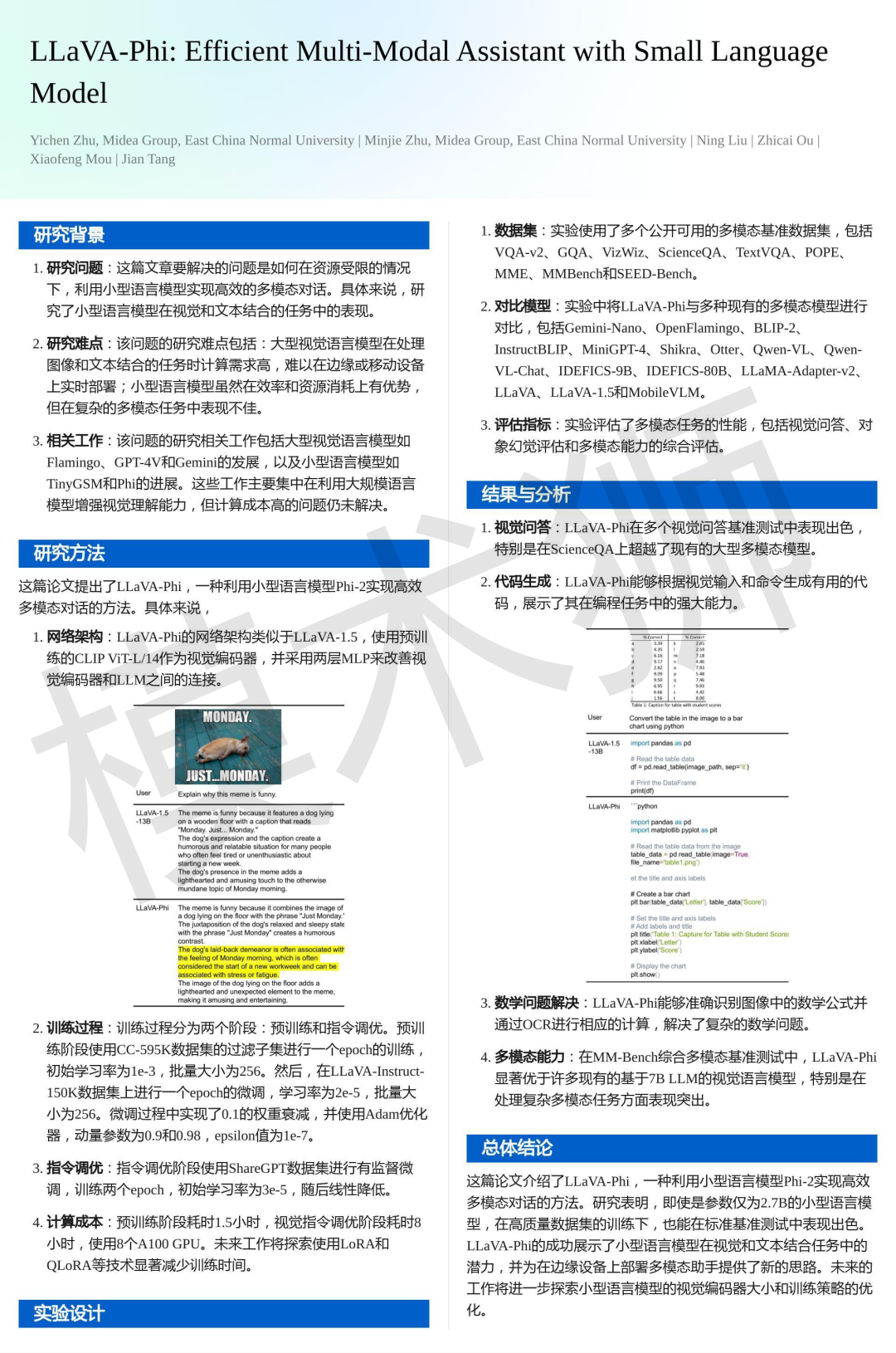

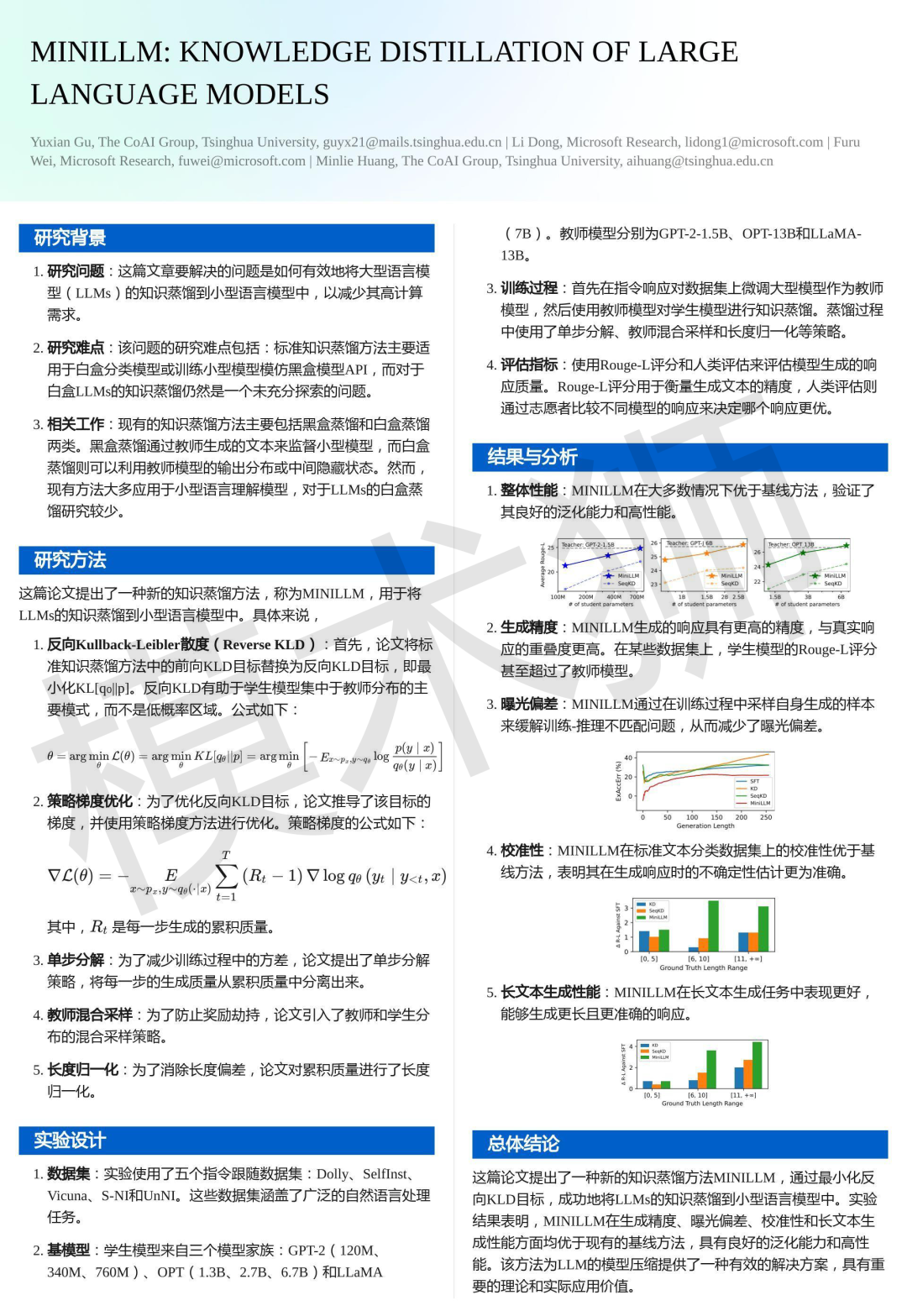

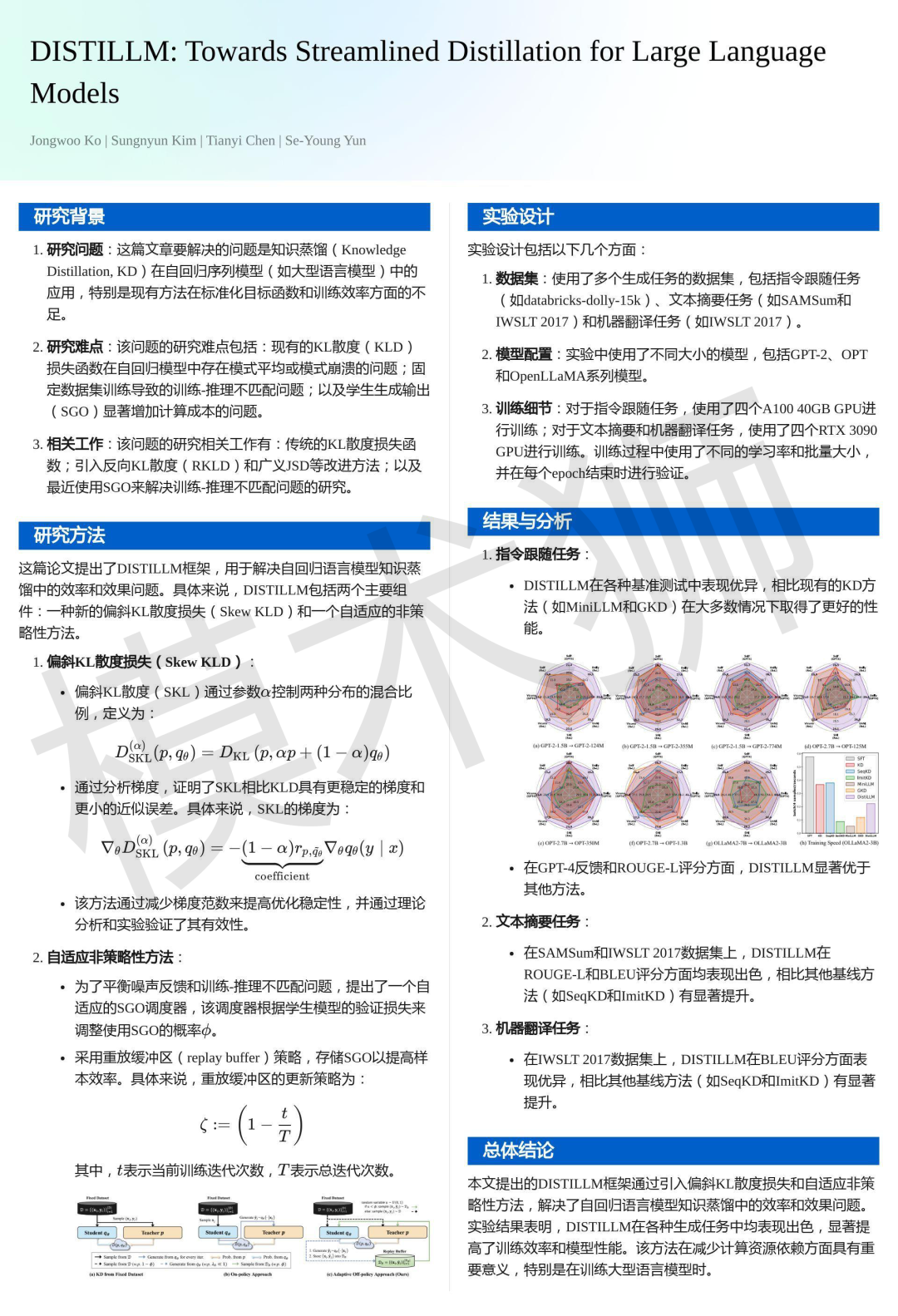

为了让大语言模型在自然语言处理中得到更广泛的应用,我们总结了四篇专注于多模态大语言模型(MLLM)的瘦身变体