目录

【说明】

efficientnetV2是目前基于CNN网络的最强分类模型,我们使用该模型对我们的项目做分类,目前我们使用的是28类,发现其泛化能力比较弱,学习能力是比较强的。

efficientnetV2的pytorch代码是参考的霹雳吧啦Wz大佬的

关于分类的C++推理代码,借鉴了

《C++使用onnxruntime/opencv对onnx模型进行推理(附代码)》

因为有些函数被弃用等,对其也做了一些修改,更方便测试

【步骤】

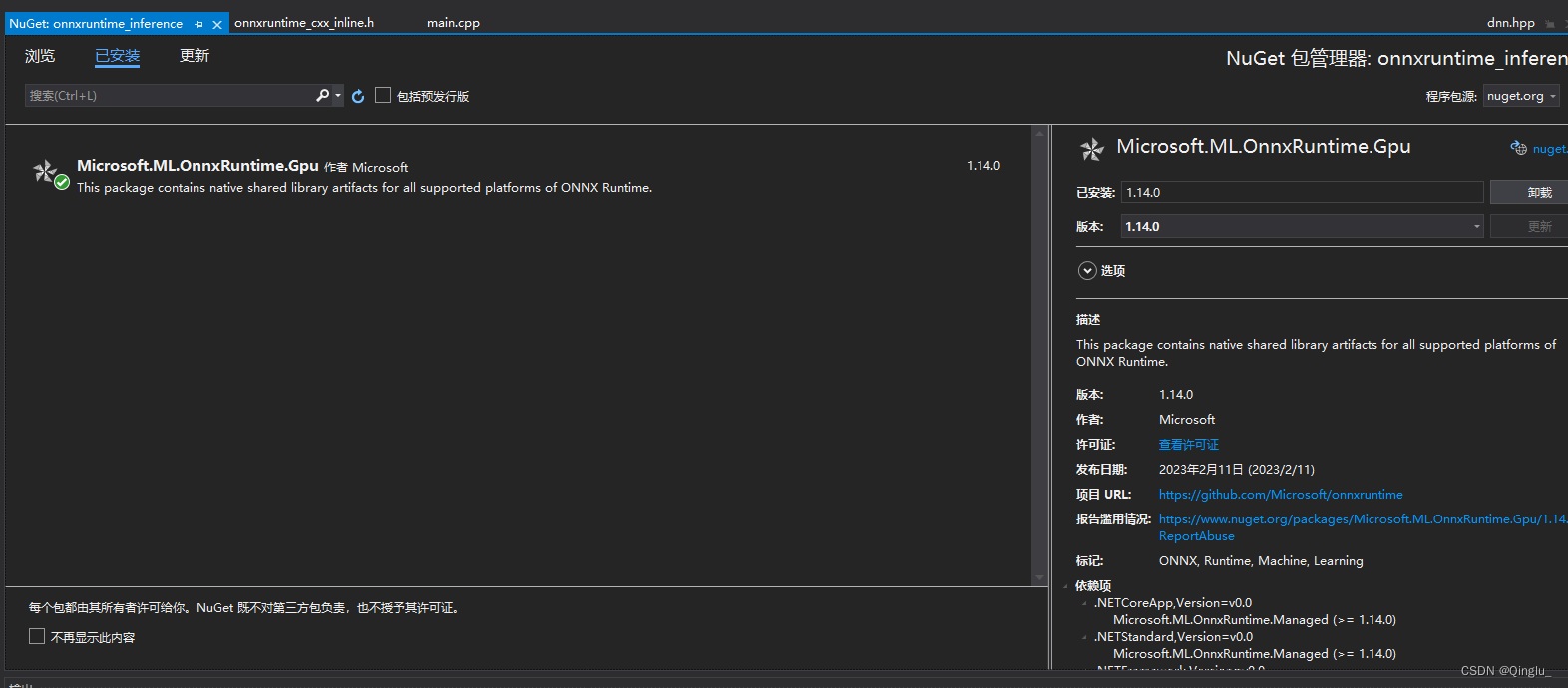

Ⅰ安装onnxruntime所需要的packages

打开VS2019->创建新项目->项目->管理NuGet程序包->搜索所需要的插件

Ⅱ 等待安装完毕

【代码部分】

#include <opencv2/core.hpp>

#include <opencv2/imgcodecs.hpp>

#include <opencv2/opencv.hpp>

#include <opencv2/highgui.hpp>

#include <opencv2/core/core.hpp>

#include <opencv2/imgproc/imgproc_c.h>

#include <opencv2/dnn.hpp>

#include <opencv2/core/utils/logger.hpp>

#include <iostream>

#include <onnxruntime_cxx_api.h>

#include <assert.h>

#include <vector>

#include <fstream>

using namespace cv; //当定义这一行后,cv::imread可以直接写成imread

using namespace std;

using namespace Ort;

using namespace cv::dnn;

/*******************************************************************************/

//如果使用CUDA加速

#define _CUDA_

//图像的宽和高

#define IMG_H 130

#define IMG_W 130

//种类

#define TOTAL_CATEGORY 28

String labels_txt_file = "H:\\Efficientnet\\onnxruntime_inference\\workspace\\index.txt";

vector<String> readClassNames();

//testDatasets path

const string Path{ "H:\\Efficientnet\\Test_Datasets\\_TN\\_TN1\\_TN (" };

//test label

const string _label_{ "TN1" };

/*如需修改模型的路径和名字,跳转到line104*/

/*******************************************************************************/

// 图像处理 标准化处理

void PreProcess(const Mat& image, Mat& image_blob)

{

Mat input;

image.copyTo(input);

//数据处理 标准化

std::vector<Mat> channels, channel_p;

split(input, channels);

Mat R, G, B;

B = channels.at(0);

G = channels.at(1);

R = channels.at(2);

B = (B / 255. - 0.5) / 0.5;

G = (G / 255. - 0.5) / 0.5;

R = (R / 255. - 0.5) / 0.5;

channel_p.push_back(R);

channel_p.push_back(G);

channel_p.push_back(B);

Mat outt;

merge(channel_p, outt);

image_blob = outt;

}

// 读取txt文件

std::vector<String> readClassNames()

{

std::vector<String> classNames;

std::ifstream fp(labels_txt_file);

if (!fp.is_open())

{

printf("could not open file...\n");

exit(-1);

}

std::string name;

while (!fp.eof())

{

std::getline(fp, name);

if (name.length())

classNames.push_back(name);

}

fp.close();

return classNames;

}

double Total_time{}, Ave_time{};

string label{};

const double _count_ = 44;

int main() // 返回值为整型带参的main函数. 函数体内使用或不使用argc和argv都可

{

float count_error{};

char file_name[50];

//关闭opencv输出的一大堆调试信息

cv::utils::logging::setLogLevel(utils::logging::LOG_LEVEL_SILENT);

//environment (设置为VERBOSE(ORT_LOGGING_LEVEL_VERBOSE)时,方便控制台输出时看到是使用了cpu还是gpu执行)

Ort::Env env(ORT_LOGGING_LEVEL_WARNING, "EfficientModel");

Ort::SessionOptions session_options;

// 使用1个线程执行op,若想提升速度,增加线程数

session_options.SetIntraOpNumThreads(5);

//CUDA加速开启(由于onnxruntime的版本太高,无cuda_provider_factory.h的头文件,加速可以使用onnxruntime V1.8的版本)

#ifdef _CUDA_

OrtSessionOptionsAppendExecutionProvider_CUDA(session_options, 0);

#endif

// ORT_ENABLE_ALL: 启用所有可能的优化

session_options.SetGraphOptimizationLevel(GraphOptimizationLevel::ORT_ENABLE_ALL);

//load model and creat session

#ifdef _WIN32

const wchar_t* model_path = L"H:\\Efficientnet\\onnxruntime_inference\\workspace\\efficient_static.onnx";

#else

const char* model_path = "H:\\Efficientnet\\onnxruntime_inference\\workspace\\efficient_static.onnx";

#endif

printf("Using Onnxruntime C++ API\n");

Ort::Session session(env, model_path, session_options);

// print model input layer (node names, types, shape etc.)

Ort::AllocatorWithDefaultOptions allocator;

//model info

// 获得模型又多少个输入和输出,一般是指对应网络层的数目

// 一般输入只有图像的话input_nodes为1

size_t num_input_nodes = session.GetInputCount();

// 如果是多输出网络,就会是对应输出的数目

size_t num_output_nodes = session.GetOutputCount();

printf("Number of inputs = %zu\n", num_input_nodes);

printf("Number of output = %zu\n", num_output_nodes);

//获取输入name;

//GetInputName和GetOutputName函数由于版本更新无法使用

const char* input_name;

AllocatedStringPtr input_name_Ptr = session.GetInputNameAllocated(0, allocator);

input_name = input_name_Ptr.get();

std::cout << "input_name:" << input_name << std::endl;

//获取输出name

const char* output_name;

AllocatedStringPtr output_name_Ptr = session.GetOutputNameAllocated(0, allocator);

output_name = output_name_Ptr.get();

std::cout << "output_name:" << output_name << std::endl;

//自动获取维度数量

auto input_dims = session.GetInputTypeInfo(0).GetTensorTypeAndShapeInfo().GetShape();

auto output_dims = session.GetOutputTypeInfo(0).GetTensorTypeAndShapeInfo().GetShape();

std::cout << "input_dims:" << input_dims[0] << std::endl;

std::cout << "output_dims:" << output_dims[0] << std::endl;

std::vector<const char*> input_names{ input_name };

std::vector<const char*> output_names = { output_name };

std::vector<const char*> input_node_names = { "input" };

std::vector<const char*> output_node_names = { "output" };

//加载图片

string Str_num{};

string ImgPath{};

for (int i = 1; i <= _count_; i++)

{

Str_num = to_string(i);

ImgPath = Path + Str_num + ").jpg";

Mat img = imread(ImgPath);

//imshow("Image ", img);

Mat det1, det2;

resize(img, det1, Size(IMG_H, IMG_W));

det1.convertTo(det1, CV_32FC3);

//std::cout << det1 << std::endl;

PreProcess(det1, det2); //标准化处理

//imshow("Image ", img);

Mat blob = dnn::blobFromImage(det2, 1., Size(IMG_H, IMG_W), Scalar(0, 0, 0), true, false);

//printf("Load success!\n");

clock_t startTime, endTime ;

//创建输入tensor

auto memory_info = Ort::MemoryInfo::CreateCpu(OrtAllocatorType::OrtArenaAllocator, OrtMemType::OrtMemTypeDefault);

std::vector<Ort::Value> input_tensors;

input_tensors.emplace_back(Ort::Value::CreateTensor<float>(memory_info, blob.ptr<float>(), blob.total(), input_dims.data(), input_dims.size()));

/*cout << int(input_dims.size()) << endl;*/

startTime = clock();

//推理(score model & input tensor, get back output tensor)

auto output_tensors = session.Run(Ort::RunOptions{ nullptr }, input_node_names.data(), input_tensors.data(), input_names.size(), output_node_names.data(), output_names.size());

endTime = clock();

assert(output_tensors.size() == 1 && output_tensors.front().IsTensor());

//除了第一个节点外,其他参数与原网络对应不上程序就会无法执行

//第二个参数代表输入节点的名称集合

//第四个参数1代表输入层的数目

//第五个参数代表输出节点的名称集合

//最后一个参数代表输出节点的数目

//获取输出(Get pointer to output tensor float values)

float* floatarr = output_tensors[0].GetTensorMutableData<float>(); // 也可以使用output_tensors.front(); 获取list中的第一个元素变量 list.pop_front(); 删除list中的第一个位置的元素

// 得到最可能分类输出

Mat newarr = Mat_<double>(1, TOTAL_CATEGORY); //定义一个1*28的矩阵

for (int i = 0; i < newarr.rows; i++)

{

for (int j = 0; j < newarr.cols; j++) //矩阵列数循环

{

newarr.at<double>(i, j) = floatarr[j];

}

}

/*cout << newarr.size() << endl;*/

vector<String> labels = readClassNames();

for (int n = 0; n < newarr.rows; n++) {

Point classNumber;

double classProb;

Mat probMat = newarr(Rect(0, n, TOTAL_CATEGORY, 1)).clone();

Mat result = probMat.reshape(1, 1);

minMaxLoc(result, NULL, &classProb, NULL, &classNumber);

int classidx = classNumber.x;

printf("\n current image classification : %s, possible : %.2f\n", labels.at(classidx).c_str(), classProb);

label = labels.at(classidx).c_str();

// 显示文本

//putText(img, labels.at(classidx), Point(10, 20), FONT_HERSHEY_SIMPLEX, 0.6, Scalar(0, 0, 255), 1, 1);

//imshow("Image Classification", img);

//waitKey(1000);

}

if (label != _label_)

{

//sprintf_s(file_name, "H:\\Efficientnet\\onnxruntime_inference\\error_img\\bmkg\\bm1\\%d.jpg", i);

//imwrite(file_name, img);

count_error += 1;

}

//计算运行时间

std::cout << "The run time is:" << (double)(endTime - startTime) / CLOCKS_PER_SEC << "s" << std::endl;

Total_time += (double)(endTime - startTime);

}

Ave_time = Total_time / _count_;

std::cout << "The Average time is:" << Ave_time <<"ms" << std::endl;

//std:; cout << count_error << std::endl;

std::cout << "Accurate rate:" << ((_count_ - count_error) / _count_) * 100 << "%" << std::endl;

printf("Done!\n");

system("pause");

return 0;

}

【报错问题及解决办法】

① E0135 class “Ort::Session” 没有成员 “GetOutputName”

借鉴下面这位大佬的博客

“GetInputName“: 不是 “Ort::Session“ 的成员

报错的代码,如下:

//获取输入name

const char* input_name = session.GetInputName(0, allocator);

std::cout << "input_name:" << input_name << std::endl;

//获取输出name

const char* output_name = session.GetOutputName(0, allocator);

std::cout << "output_name: " << output_name << std::endl;修改代码:

//获取输入name;

//GetInputName和GetOutputName函数由于版本更新无法使用

const char* input_name;

AllocatedStringPtr input_name_Ptr = session.GetInputNameAllocated(0, allocator);

input_name = input_name_Ptr.get();

std::cout << "input_name:" << input_name << std::endl;

//获取输出name

const char* output_name;

AllocatedStringPtr output_name_Ptr = session.GetInputNameAllocated(0, allocator);

output_name = output_name_Ptr.get();

std::cout << "output_name:" << output_name << std::endl;