1. 研究背景

随着人工智能技术的迅猛发展,越来越多的超大规模模型(如GPT-4和BERT)展现出了强大的自然语言处理能力。然而,这些模型的高效微调需要大量的计算资源和丰富的数据集。提示学习(prompt-based learning)作为一种新兴的方法,通过利用预定义的模板或提示,可以有效引导模型的输出,从而减少大规模再训练的需求。本研究的重点是探索和开发基于提示迁移的大模型高效微调的关键技术,理解其基本机制,识别最佳实践,并解决相关挑战。

**提示学习(Prompt-based Learning)**是一种新兴的机器学习方法,特别是在自然语言处理(NLP)领域,它通过向预训练语言模型提供预定义的“提示”(prompts),引导模型生成所需的输出,而不需要进行大量的再训练。这种方法利用了预训练模型中已经捕获的广泛知识和语言模式,通过设计合适的提示来激活和应用这些知识。

提示学习的核心在于设计和使用提示,这些提示可以是自然语言中的短语、句子或填空式的模板,用来引导模型的输出。例如,对于一个文本分类任务,可以设计一个包含类标签的模板,让模型根据输入的上下文填充合适的标签。举个简单的例子帮助理解:

假设我们有一个情感分析任务,目标是判断给定句子的情感是“积极”还是“消极”。使用提示学习,可以设计以下提示:

- 输入句子:“I love this movie!”

- 提示模板:“The sentiment of the sentence ‘I love this movie!’ is [MASK].”

- 模型输出:“positive”

2. 研究方法

2.1 提示学习

提示学习的方法可以分为手动提示工程和自动提示生成两大类:

- 手动提示工程(Manual Prompt Engineering):

- 描述:手动设计提示模板,根据任务需求精心构造提示。

- 优点:可以根据具体任务精确控制提示内容,提高输出的准确性。

- 缺点:耗时且需要领域专家的参与,难以扩展到大量任务。

- 自动提示生成(Automated Prompt Generation):

- 描述:使用算法和模型自动生成和优化提示。

- 优点:自动化过程更高效,能够适应多种任务,无需大量手工干预。

- 缺点:可能生成次优提示,需要进一步优化和调整。

具体方法包括如下:

- 填空提示(Cloze Prompts):这种方法通过在句子中留出一个空白(如[MASK])让模型填充。例如:“The capital of France is [MASK].”

- 问答提示(QA Prompts):通过设计问答形式的提示,引导模型生成答案。例如:“What is the capital of France? [MASK]”

- 描述性提示(Descriptive Prompts):通过提供背景和上下文信息,让模型生成更为详细的输出。例如:“The capital city of the country known for the Eiffel Tower is [MASK].”

核心优势:

- 效率高:减少了对大量标注数据和长时间训练的需求,通过设计提示有效利用预训练模型的能力。

- 灵活性强:适用于多种NLP任务,包括文本分类、文本生成、问答系统等。

- 资源节省:在没有大量计算资源的情况下,依然可以利用大规模预训练模型的强大能力。

挑战和局限性:

- 提示设计的复杂性:有效的提示设计需要一定的技巧和经验,手动设计的提示可能不具备广泛适用性。

- 模型依赖性:提示的效果高度依赖于预训练模型的质量和能力,不同模型对相同提示的响应可能不同。

- 泛化能力:对于一些特定任务,提示可能需要反复调整和优化,才能获得理想的结果。

2.2 大模型Fine-tuning

微调(Fine-tuning)预训练语言模型(Pretrained Language Models, PLMs)已经成为自然语言处理(NLP)领域的标准方法。通过在大规模语料库上进行预训练,语言模型可以捕获丰富的语言知识和模式。然后,通过微调这些预训练模型,使其适应具体的下游任务,如文本分类、情感分析和机器翻译,可以显著提高任务的性能和效果。随着PLMs的规模不断扩大,如BERT、GPT-3和GPT-4等,它们在各种NLP任务中表现出了强大的能力。然而,这些模型的微调需要大量的计算资源和内存,因为要调整模型中全部参数以适应每个下游任务。这种方法虽然有效,但对计算资源的需求极高,限制了其在资源受限环境中的应用。

Model-tuning是一种常见的微调方法,其核心思想是对整个预训练模型的参数进行微调,以适应具体的下游任务。具体步骤如下:

- 预训练阶段:在大规模语料库上训练语言模型,捕捉广泛的语言知识和模式。

- 微调阶段:将预训练好的模型应用到特定任务上,通过调节模型的全部参数,使其更好地执行该任务。

这种方法的优点是能够充分利用预训练模型的能力,通常可以取得优异的性能。但其缺点也很明显,即计算开销和内存需求极高,对于大模型尤为如此。为了应对model-tuning的高资源需求,研究人员提出了多种参数高效的微调方法,其中prompt-tuning尤为引人注目。

2.3 Prompt-tuning

Prompt-tuning是一种利用提示(prompts)引导模型输出的技术,而不是调整整个模型的参数。通过设计适当的提示,可以在不改变或只微调少量参数的情况下,激活预训练模型中已经学习到的知识来完成特定任务。

Prompt-tuning原理

- 提示设计:创建与任务相关的提示模板,提示可以是填空、问答或描述性语句。

- 例如,对于情感分析任务,可以使用提示:“这句话的情感是[MASK]。”

- 微调提示:在固定大部分模型参数的前提下,仅调整与提示相关的少量参数或在模型输入中嵌入提示。

- 任务执行:通过模型生成的响应来完成特定任务。

- 模型在看到提示后,填充或回答提示中的空白,完成具体的任务。

Prompt-tuning的优点是显而易见的:它显著减少了需要微调的参数数量,从而降低了计算和内存需求。同时,由于大部分参数保持不变,模型可以更容易地在不同任务之间切换,提升了多任务学习的灵活性。然而,提示设计的质量和效果在很大程度上决定了这种方法的成功,因此需要一定的技巧和经验。

2.4 PanDa算法

接下来介绍一种比较新颖的Prompt-tuning方法,PanDa [1]。

为了提升提示微调的性能,一种直观的想法是利用从中间任务到目标任务的知识转移。最近的研究提出了在提示微调上下文中利用迁移学习的方法,即提示迁移(Prompt Transfer, PoT)。PoT方法是使用相似源任务的已训练提示初始化目标任务的提示,然后在目标任务上进一步微调这些提示。虽然这种PoT方法可以比单纯的提示微调有所改进,但仍存在一些局限性。

现有的Prompt-tuning方法,存在如下局限性:

- 任务相似性敏感性:

- PoT的性能对源任务和目标任务之间的相似性非常敏感。PoT高度依赖提示迁移度量(prompt transferability metric)来检索适合的源任务,但现有的度量方法难以准确区分任务关系,导致难以合理选择源任务。

- 知识遗忘问题:

- 直接在目标任务上微调以源任务提示初始化的提示,可能导致源任务中学到的有用通用知识的遗忘。这与现有研究的结论类似,即PLM的顺序迁移学习容易遗忘之前学到的知识。

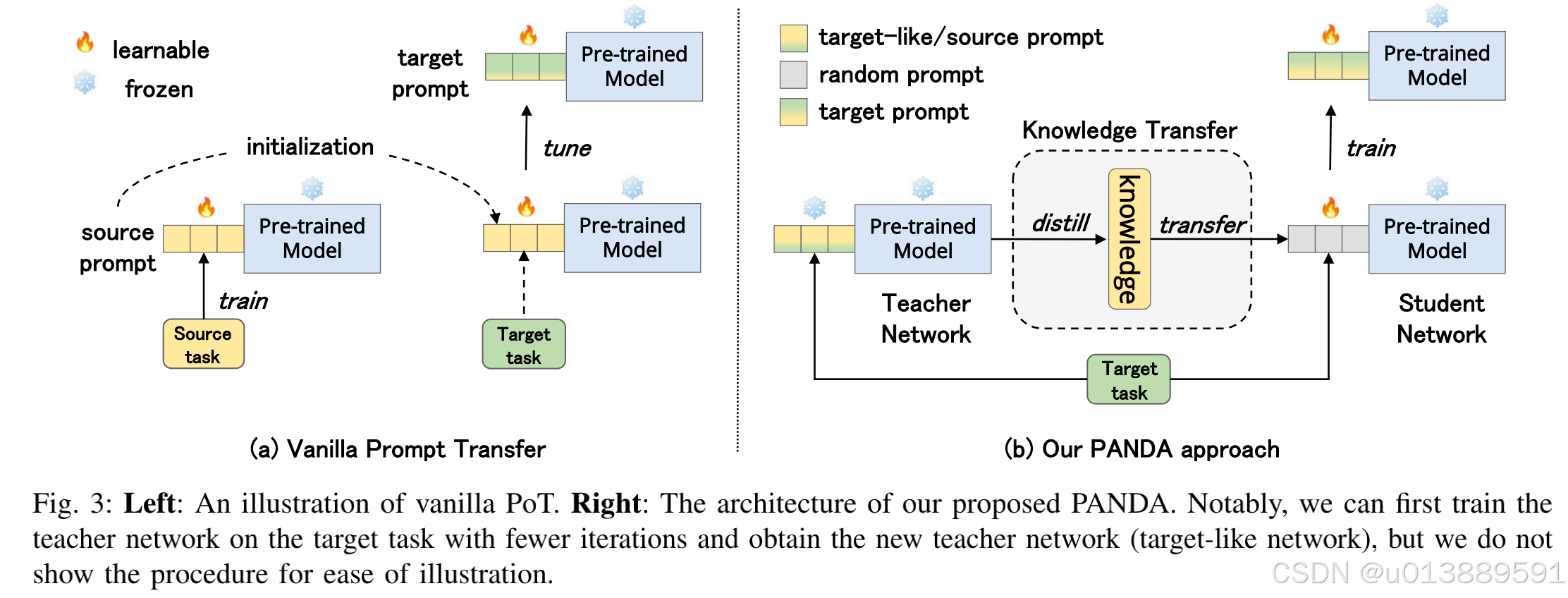

为了提高提示迁移(Prompt Transfer, PoT)的效果,本文提出了一种新的方法,称为PANDA(Prompt trAnsfer via kNowledge DistillAtion),并引入了一种新的提示迁移度量标准。如下图所示,具体方法如下:

- 新的提示迁移度量标准:

- 与之前简单使用提示参数相似性作为提示迁移度量不同,本文首先将源任务和目标任务映射到一个共享的语义空间,通过源/目标提示得到任务嵌入,然后通过对应任务嵌入的相似性来衡量提示迁移度量。

- 知识蒸馏技术:

- PANDA引入了知识蒸馏技术,将源提示中的知识以一种细微的方式转移到目标提示中,有效缓解了先前知识遗忘的问题。

- 自适应知识转移控制:

- 为了自适应控制知识转移,PANDA方法使用预测的提示相似性作为在每个源-目标对之间平衡两个监督信号的调节因子。

核心贡献:

- 为了自适应控制知识转移,PANDA方法使用预测的提示相似性作为在每个源-目标对之间平衡两个监督信号的调节因子。

- 重新设计了普通PoT,引入了PANDA这一新颖的提示迁移方法,通过知识蒸馏缓解了知识遗忘问题。

- 提出了一种新的提示迁移度量标准,以更智能地选择对目标任务更有帮助的源任务。

- 在189对源-目标任务组合和5种规模的预训练语言模型上的广泛实验,证明了所提方法的有效性。

本文进行了大规模的研究,使用了21个源数据集和9个目标数据集的189个组合,跨越了5种规模的预训练语言模型(PLMs)。PANDA在所有任务和模型规模上都显著优于普通的PoT方法,某些场景下的平均分数提升高达24.1%。

在全数据场景中,PANDA使提示微调的性能不仅具备竞争力,甚至超越了模型微调的效果。

3. 总结和讨论

提示微调(Prompt-tuning)和提示迁移(Prompt Transfer, PoT)已经成为提高预训练语言模型(PLM)在各种自然语言处理(NLP)任务中性能的重要方法。本文提出了PANDA(Prompt trAnsfer via kNowledge DistillAtion),通过引入新的提示迁移度量标准和知识蒸馏技术,有效地解决了提示迁移过程中知识遗忘的问题,显著提升了提示微调的性能。大量实验证明,PANDA在各种任务和模型规模上都优于传统的提示迁移方法,并在全数据场景中甚至超越了模型微调的效果。

尽管PANDA在提示微调和提示迁移领域取得了显著的进展,但仍有许多值得探索的方向:

- 进一步优化提示迁移度量标准:

- 开发更精确和鲁棒的度量标准,以更好地评估源任务和目标任务之间的相似性,从而提高提示迁移的效果。

- 多任务学习与提示迁移的结合:

- 探索如何将多任务学习与提示迁移结合,使模型在多个任务间共享和迁移知识,进一步提升模型的泛化能力和性能。

- 自适应提示生成与优化:

- 研究自适应提示生成技术,自动生成和优化提示,以减少人工干预,提高提示设计的效率和效果。

- 跨领域提示迁移:

- 探索跨不同领域的提示迁移方法,使模型能够在不同领域的任务中高效迁移和应用知识,增强模型的跨领域适应能力。

- 知识蒸馏技术的改进:

- 进一步改进知识蒸馏技术,使知识转移更加高效和细致,减少知识遗忘的风险,提高提示迁移的效果。

- 实时提示调整与动态微调:

- 研究如何在实时应用中动态调整提示和微调模型,以适应不断变化的任务需求和输入数据,提高模型的灵活性和实时性。

- 提示学习与其他技术的结合:

- 探讨将提示学习与其他前沿技术(如强化学习、元学习等)结合,开发出更为强大和智能的NLP模型。

参考文献:

[1] Zhong Q, Ding L, Liu J, et al. Panda: Prompt transfer meets knowledge distillation for efficient model adaptation[J]. IEEE Transactions on Knowledge and Data Engineering, 2024.